机器学习中的线性相关性:特征选择与降维的最新趋势

发布时间: 2024-07-09 01:13:36 阅读量: 82 订阅数: 25

# 1. 机器学习中的线性相关性**

线性相关性是机器学习中衡量两个或多个变量之间线性关系强度的重要概念。理解线性相关性对于构建准确和鲁棒的机器学习模型至关重要。

在机器学习中,线性相关性通常使用相关系数或方差膨胀因子(VIF)来度量。相关系数表示两个变量之间的线性相关程度,范围从-1到1。方差膨胀因子衡量一个变量对其他变量的线性依赖性,值越大表示相关性越强。

高线性相关性会对机器学习模型产生负面影响。它会导致模型过拟合,降低泛化能力。因此,在构建机器学习模型之前,识别和处理线性相关性非常重要。

# 2. 特征选择与降维的理论基础

### 2.1 线性相关性的度量

#### 2.1.1 相关系数

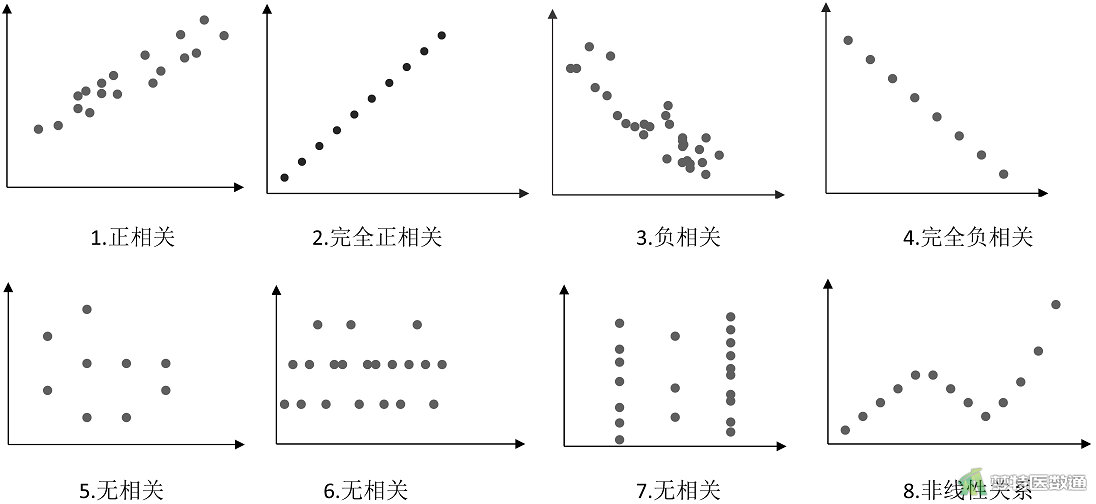

相关系数是衡量两个变量之间线性相关性的统计量。它表示两个变量之间的协方差与它们各自标准差的乘积之比。相关系数的取值范围为[-1, 1]:

- 1 表示完全正相关,即两个变量随同变化。

- -1 表示完全负相关,即一个变量增加时,另一个变量减少。

- 0 表示不相关,即两个变量的变化没有关联。

相关系数的计算公式为:

```python

corr(X, Y) = cov(X, Y) / (std(X) * std(Y))

```

其中:

- `X` 和 `Y` 是两个变量。

- `cov(X, Y)` 是协方差。

- `std(X)` 和 `std(Y)` 是标准差。

#### 2.1.2 方差膨胀因子

方差膨胀因子 (VIF) 是衡量一个变量对其他变量线性相关性的指标。它表示一个变量的方差被其他变量解释的程度。VIF 的计算公式为:

```python

VIF(X) = 1 / (1 - R^2(X, X_other))

```

其中:

- `X` 是待评估的变量。

- `X_other` 是其他所有变量。

- `R^2(X, X_other)` 是 `X` 和 `X_other` 之间的决定系数。

VIF 的取值范围为[1, ∞]:

- VIF = 1 表示 `X` 与其他变量不相关。

- VIF > 1 表示 `X` 与其他变量存在线性相关性。

- VIF 值越大,表示 `X` 与其他变量的线性相关性越强。

### 2.2 特征选择方法

特征选择是选择与目标变量最相关的特征的过程。它可以提高模型的性能,减少过拟合,并提高可解释性。

#### 2.2.1 过滤式方法

过滤式方法根据特征的统计特性对特征进行评分。它们计算每个特征的度量,例如相关系数或信息增益,然后选择得分最高的特征。

##### 2.2.1.1 方差选择

方差选择是一种过滤式方法,它选择具有最高方差的特征。方差衡量一个特征的值的分布程度。具有高方差的特征更有可能包含有用的信息。

##### 2.2.1.2 信息增益

信息增益是一种过滤式方法,它选择对目标变量信息增益最大的特征。信息增益衡量一个特征在给定目标变量的情况下减少不确定性的程度。

#### 2.2.2 包装式方法

包装式方法将特征选择视为一个优化问题。它们使用机器学习模型来评估特征子集的性能,然后选择性能最佳的特征子集。

##### 2.2.2.1 向前选择

向前选择是一种包装式方法,它从一个空的特征子集开始,并逐步添加性能最佳的特征。

##### 2.2.2.2 向后选择

向后选择是一种包装式方法,它从包含所有特征的特征子集开始,并逐步删除性能最差的特征。

### 2.3 降维方法

降维是将高维数据投影到低维空间的过程。它可以减少计算成本,提高模型的性能,并提高可解释性。

#### 2.3.1 主成分分析

主成分分析 (PCA) 是一种降维方法,它将数据投影到方差最大的方向上。PCA 的目的是找到一组正交基,这些基可以最大化数据的方差。

#### 2.3.2 奇异值分解

奇异值分解 (SVD) 是一种降维方法,它将数据分解为三个矩阵的乘积:U、S 和 V。U 和 V 是正交矩阵,S 是对角矩阵。S 的对角线元素称为奇异值,它们表示数据的方差。

# 3. 特征选择与降维的实践应用

### 3.1 特征选择在文本分类中的应用

文本分类是自然语言处理中的一项基本任务,其目的是将文本文档分配到预定义的类别中。特征选择在文本分类中至关重要,因为它可以帮助识别与分类任务最相关的文本特征,从而提高分类模型的性能。

#### 3.1.1 文本

0

0