机器学习中的线性相关性:特征选择与降维的常见问题解答

发布时间: 2024-07-09 01:07:26 阅读量: 103 订阅数: 24

# 1. 线性相关性的基本概念**

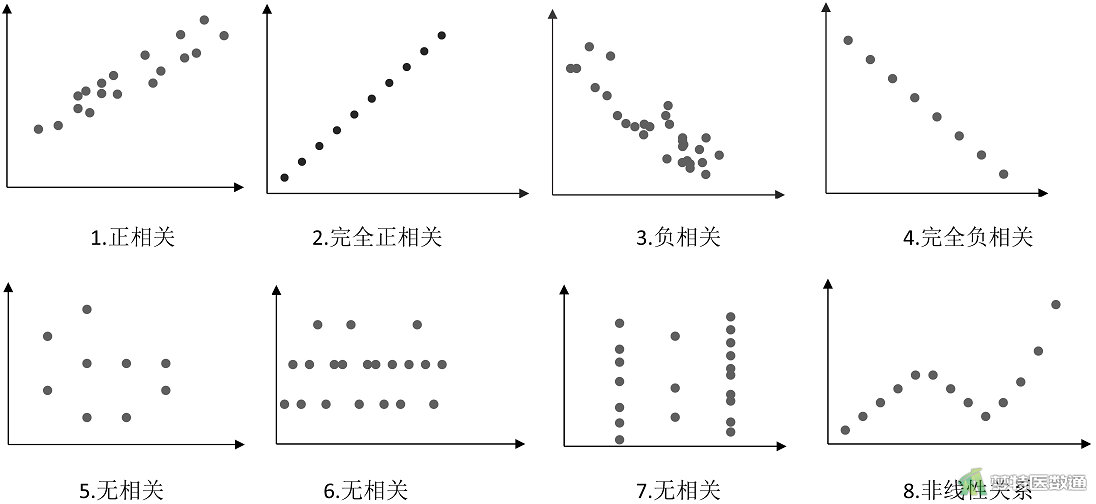

线性相关性衡量两个或多个变量之间线性关系的强度。在机器学习中,了解线性相关性对于特征选择和降维至关重要。

线性相关性通常使用相关系数来度量,例如皮尔逊相关系数或斯皮尔曼等级相关系数。这些系数的值在 -1 到 1 之间,其中 -1 表示完全负相关,0 表示无相关性,1 表示完全正相关。

线性相关性可以帮助识别具有冗余信息的特征,从而可以进行特征选择以提高模型性能。它还可以指导降维技术,例如主成分分析 (PCA),这些技术通过消除线性相关性来减少数据维度。

# 2. 特征选择中的线性相关性

### 2.1 相关性度量

在特征选择中,相关性度量用于评估特征与目标变量之间的相关程度。常见的相关性度量包括:

#### 2.1.1 皮尔逊相关系数

皮尔逊相关系数是一种广泛使用的相关性度量,用于衡量两个连续变量之间的线性相关性。其计算公式为:

```python

ρ(X, Y) = cov(X, Y) / (σX * σY)

```

其中:

* ρ(X, Y) 是皮尔逊相关系数

* cov(X, Y) 是 X 和 Y 的协方差

* σX 和 σY 分别是 X 和 Y 的标准差

皮尔逊相关系数的值介于 -1 和 1 之间:

* -1 表示完全负相关

* 0 表示不相关

* 1 表示完全正相关

#### 2.1.2 斯皮尔曼等级相关系数

斯皮尔曼等级相关系数是一种非参数相关性度量,用于衡量两个序数变量之间的单调相关性。其计算公式为:

```python

ρs(X, Y) = 1 - (6 * Σd^2) / (n * (n^2 - 1))

```

其中:

* ρs(X, Y) 是斯皮尔曼等级相关系数

* d 是 X 和 Y 的差值

* n 是样本量

斯皮尔曼等级相关系数的值介于 -1 和 1 之间,其解释与皮尔逊相关系数类似。

### 2.2 特征选择方法

特征选择方法根据其与目标变量相关性的程度来选择特征。常见的特征选择方法包括:

#### 2.2.1 过滤式方法

过滤式方法根据特征的固有属性(如相关性)对特征进行评分,然后根据评分阈值选择特征。常见的过滤式方法包括:

* **相关性阈值法:**选择相关性高于阈值的特征。

* **信息增益:**选择对目标变量信息增益最大的特征。

* **卡方检验:**选择与目标变量具有显著卡方相关性的特征。

#### 2.2.2 包裹式方法

包裹式方法将特征选择过程与机器学习模型的训练相结合,通过迭代地评估不同特征组合的模型性能来选择特征。常见的包裹式方法包括:

* **向前选择:**从空特征集开始,逐步添加与目标变量最相关的特征。

* **向后选择:**从包含所有特征的特征集开始,逐步删除与目标变量最不相关的特征。

* **递归特征消除:**使用机器学习模型对特征进行评分,然后迭代地删除评分最低的特征。

#### 2.2.3 嵌入式方法

嵌入式方法将特征选择过程嵌入到机器学习模型的训练过程中,通过对模型参数进行正则化或惩罚来间接实现特征选择。常见的嵌入式方法包括:

* **L1 正则化(LASSO):**对模型权重施加 L1 范数惩罚,从而导致不重要的特征的权重变为 0。

* **L2 正则化(岭回归):**对模型权重施加 L2 范数惩罚,从而使不重要的特征的权重变小。

* **树形模型:**决策树和随机森林等树形模型通过分裂和剪枝过程自动执行特征选择。

# 3. 降维中的线性相关性**

### 3.1 降维技术

降维是一种将高维数据转换为低维表示的技术,它可以减少数据的复杂性,同时保留其重要特征。在机器学习中,降维通常用于提高模型的性能和可解释性。

#### 3.1.1 主成分分析 (PCA)

PCA是一种线性降维技术,它通过寻找数据中方差最大的方向来创建新的正交特征。这些新特征称为主成分,它们包含了数据的大部分信息。

**代码块:**

```python

import numpy as np

from sklearn.decomposition import PCA

# 创建数据

data = np.array([[1, 2, 3], [4, 5, 6], [7, 8, 9]])

# 创建 PCA 对象

pca = PCA(n_components=2)

# 拟合数据

pca.fit(data)

# 转换数据

transformed_data = pca.transform(data)

# 打印转换后的数据

print(transformed_data)

```

**逻辑分析:**

* `n_components` 参数指定要保留的主成分数。

* `fit()` 方法拟合数据,计算主成分。

* `transform()` 方法将数据转换为主成分空间。

#### 3.1.2 奇异值分解 (SVD)

SVD是一种更通用的降维技术,它可以用于线性或非线性数据。SVD将数据分解为三个矩阵

0

0