【MapReduce性能优化篇】:内存中间数据存储减少技巧大公开

发布时间: 2024-11-01 00:39:19 阅读量: 28 订阅数: 29

大数据处理优化:Spark与Hadoop的深度应用与性能调优

# 1. MapReduce性能优化的理论基础

MapReduce作为大数据处理领域的重要工具,其性能优化是实现高效数据处理的关键。优化工作首先需要建立在对理论基础的深入理解之上。

## 1.1 MapReduce工作原理简述

MapReduce框架的核心在于将复杂的数据处理任务分解为两个阶段:Map阶段和Reduce阶段。Map阶段处理原始输入数据,生成中间键值对;Reduce阶段则对这些中间数据进行汇总处理,输出最终结果。理解这两个阶段如何交互,是后续进行性能优化的基础。

## 1.2 性能优化的考量因素

性能优化涉及多个方面,包括但不限于算法效率、任务并行度、资源分配、数据倾斜问题以及I/O操作的优化等。深入分析这些因素如何影响MapReduce作业的执行效率,能够帮助我们有针对性地采取措施提高性能。

## 1.3 从理论到实践的映射

理论知识是实践的先导。本章将通过详尽的案例分析和实际操作指导,将理论基础与实际应用相结合,逐步引导读者掌握MapReduce性能优化的全过程。

# 2. MapReduce的内存管理机制

## 2.1 内存管理原理分析

### 2.1.1 JVM内存模型简介

Java虚拟机(JVM)提供了一个抽象的内存模型,它允许Java程序在不同的硬件和操作系统平台上运行。JVM内存模型主要分为以下几个部分:堆(Heap)、栈(Stack)、方法区(Method Area)、程序计数器(Program Counter)和本地方法栈(Native Method Stack)。

- **堆**是JVM所管理的内存中最大的一块,主要用于存放对象实例,几乎所有的对象实例都在这里分配内存。

- **栈**是运行时数据区,用于支持线程运行,存放局部变量和方法调用的现场。

- **方法区**用于存储已被虚拟机加载的类信息、常量、静态变量等数据。

- **程序计数器**是一个较小的内存空间,可以看作是当前线程所执行的字节码的行号指示器。

- **本地方法栈**用于支持Native方法的执行,存储了每个native方法调用的状态。

在MapReduce中,理解JVM内存模型尤为重要,因为它影响到Map和Reduce任务的执行性能。例如,如果对堆内存分配不足,将导致频繁的垃圾回收(GC),进而影响处理速度。

### 2.1.2 MapReduce内存消耗概览

MapReduce作业在执行时会在JVM中消耗内存,其内存消耗主要可以分为以下几个部分:

- **用户代码**:这是用户编写的Map和Reduce函数所占内存。

- **框架开销**:这是MapReduce框架在运行任务时所需的内存,包括各种内部数据结构和对象。

- **缓存数据**:中间处理结果或者Map输出,可能被缓存在内存中以提高性能。

- **JVM开销**:JVM本身为了管理内存和执行Java代码所必须的内存。

对于内存管理,MapReduce主要关注的是如何合理分配和利用这些内存,确保作业高效稳定地运行。

## 2.2 内存溢写策略

### 2.2.1 堆内内存与堆外内存

JVM堆内存是指由JVM所管理的内存空间,通常被称为“Young Generation”和“Old Generation”。堆内存是垃圾回收器主要管理的区域,而堆外内存则是直接向操作系统申请的内存区域,它不由JVM直接管理。

在MapReduce中,如果内存使用不当,尤其是在处理大数据集时,很容易触发频繁的垃圾回收,导致作业性能下降。合理使用堆内和堆外内存,可以有效避免这个问题。

### 2.2.2 内存溢写时机选择

MapReduce中,当内存不足以存储所有数据时,就会触发内存溢写(Spill)到磁盘。选择合适的溢写时机是优化性能的关键。

- **溢写大小**:内存中的数据达到一定大小时触发溢写,这个大小可以配置。

- **溢写频率**:溢写操作过多过少都不好,过多导致频繁的磁盘I/O,过少可能导致内存中数据过多,容易触发GC。

通过调整这些参数,可以优化内存的使用效率,减少磁盘I/O操作,提高整体的处理速度。

### 2.2.3 自定义内存溢写策略

MapReduce框架允许开发者自定义内存溢写策略。通过重写相关的方法,可以控制何时以及如何将内存中的数据溢写到磁盘。自定义内存溢写策略通常包含以下两个关键点:

- **溢写条件**:开发者可以基于特定条件触发溢写,比如内存使用量达到设定阈值。

- **数据处理**:在溢写到磁盘之前,可以对内存中的数据进行处理,比如排序、合并等。

以下是一个简单的自定义溢写策略的代码示例:

```java

public class CustomSpillPolicy extends SpillableMemoryManager {

// 自定义溢写条件,例如达到某个内存使用百分比

@Override

protected boolean shouldSpill(double fractionUsed) {

return fractionUsed > .75; // 当内存使用超过75%时溢写

}

// 自定义溢写数据处理逻辑

@Override

protected void spill(SortedMap<?, ?> map) throws IOException {

// 在这里可以对map进行处理,比如合并、排序等

// 然后调用super spill()方法进行溢写

super.spill(map);

}

}

```

通过自定义溢写策略,可以根据具体的应用场景和数据特性,优化内存管理,提高MapReduce作业的性能。

## 2.3 内存优化工具使用

### 2.3.1 YARN资源管理简介

YARN(Yet Another Resource Negotiator)是Hadoop 2.0引入的资源管理框架,它负责集群中资源的分配和任务调度。

YARN的核心组件包括资源管理器(ResourceManager)、节点管理器(NodeManager)和应用程序历史服务器(ApplicationHistoryServer)。ResourceManager负责整个系统的资源分配和任务调度,NodeManager负责管理所在节点的资源使用,ApplicationHistoryServer负责记录应用程序的历史信息。

通过YARN,MapReduce作业可以动态地请求和释放资源,这使得资源的使用更加灵活和高效。YARN同时也提供了内存使用的优化接口,允许对作业的内存需求进行细粒度的控制。

### 2.3.2 如何配置YARN资源参数

在YARN中,MapReduce作业的内存管理主要是通过配置YARN的资源参数来实现的。以下是一些关键参数及其用途:

- `yarn.nodemanager.resource.memory-mb`: 设置节点上可用于YARN容器的总内存量。

- `yarn.scheduler.maximum-allocation-mb`: 设置YARN容器可以请求的最大内存量。

- `mapreduce.map.java.opts` 和 `mapreduce.reduce.java.opts`: 分别设置Map和Reduce任务的JVM内存参数。

配置这些参数时,需要考虑集群的硬件资源和作业的需求。以下是一个简单的配置示例:

```xml

<configuration>

<property>

<name>yarn.nodemanager.resource.memory-mb</name>

<value>40960</value> <!-- 40GB -->

</property>

<property>

<name>yarn.scheduler.maximum-allocation-mb</name>

<value>8192</value> <!-- 8GB -->

</property>

<property>

<name>mapreduce.map.java.opts</name>

<value>-Xmx6144m</value> <!-- Map任务最大可用6GB堆内存 -->

</property>

<property>

<name>mapreduce.reduce.java.opts</name>

<value>-Xmx6144m</value> <!-- Reduce任务最大可用6GB堆内存 -->

</property>

</configuration>

```

正确配置这些参数,能够确保MapReduce作业获得适量的内存资源,从而提高执行效率。

### 2.3.3 利用YARN进行内存优化实践

在实际使用YARN进行内存优化时,需要注意以下几个实践技巧:

- **监控资源使用情况**:通过YARN的Web界面监控资源使用情况,了解内存的使用和空闲情况。

- **分析作业的内存需求**:根据作业的特性和历史性能数据,分析其内存需求,合理分配内存。

- **定期评估优化效果**:对优化后的作业进行性能评估,确认是否达到了预期的效果。

下面是一个利用YARN进行内存优化的实践流程:

1. 分析作业的内存使用情况,确定是否存在内存溢出或者使用不足的情况。

2. 根据分析结果调整YARN的内存参数,如上文配置参数所示。

3. 重新运行作业并监控内存使用情况,注意观察作业的性能变化。

4. 如果性能提升,则继续微调参数;如果性能下降,则恢复到先前的参数设置,并重新评估。

通过这一流程,可以逐步优化MapReduce作业的内存使用,提高作业执行效率。

# 3. MapReduce中间数据存储的实践技巧

MapReduce作为一种分布式计算框架,在处理大数据时,不可避免地会产生大量的中间数据。中间数据的有效存储和管理,对整个作业的性能有着直接的影响。本章节将深入探讨MapReduce中间数据存储架构、缓存技术应用,以及数据压缩与序列化的实践技巧。

## 3.1 中间数据存储架构解析

### 3.1.1 HDFS在MapReduce中的角色

Hadoop分布式文件系统(HDFS)是MapReduce作业中中间数据存储的主要载体。在Map阶段,输入数据被读取并分割为多个小数据块,这些数据块会分发到集群中的不同节点上。Map任务处理后输出的中间结果被写入到本地磁盘,然后通过Combiner(如果配置)进行局部合并,以减少数据的大小。之后,这些中间数据会被写入HDFS中,为Reduce阶段提供数据输入。

HDFS的角色不仅仅限于数据存储,它还在保证数据高可用性和容错性方面发挥着关键作用。当Map任务完成后,中间数据需要被复制三份,以保证数据的安全性。最终,只有被写入HDFS的数据才能被Reduce任务读取,这使得MapReduce作业具有高度的鲁棒性。

### 3.1.2 中间数据存储流程详解

MapReduce作业中间数据的存储流程可以概括为以下几个步骤:

1. **数据分割**:输入数据被分割为数据块,并在Map任务执行前分配到相应的节点上。

2. **Map任务处理**:Map任务读取数据块,执行用户定义的Map函数,处理数据并输出键值对。

3. **中间数据写入**:Map任务将键值对写入本地磁盘,这一步骤可以减少对网络带宽的需求。

4. **Combiner合并**:可选步骤,如果启用了Combiner,它会对Map任务输出的中间数据进行局部合并,减少传输到Reducer的数据量。

5. **数据写入HDFS**:合并后的中间数据被写入HDFS,此时数据被复制三份,分散存储在不同的DataNode上。

6. **Shuffle过程**:Reduce任务从HDFS读取中间数据,通过Shuffle过程,将需要处理的数据拉取到本地执行Reduce函数。

这个流程涉及到的中间数据存储架构,对于MapReduce作业的性能至关重要。合理配置存储参数和优化存储流程,可以显著提高MapReduce作业的处理速度和效率。

## 3.2 缓存技术的应用

### 3.2.1 缓存机制的基本原理

在MapReduce中间数据存储过程中,缓存技术的应用可以显著提升数据处理的速度。缓存机制的基本原理是在内存中保留常用数据的副本,当后续需要这些数据时,直接从内存中读取,避免了从磁盘读取的开销。对于MapReduce而言,这意味着可以在Map任务和Shuffle阶段更快地访问到中间数据。

### 3.2.2 缓存优化的策略和案例

实现缓存优化的策略包括:

- **本地缓存**:在Map任务节点的内存中缓存中间数据,减少对磁盘的访问。

- **全局缓存**:在多个作业之间共享缓存数据,如使用Hadoop的分布式缓存功能,可以将数据集分发到各个节点的内存中。

在实际案例中,缓存技术的应用可以极大提升作业性能。比如,在处理大规模的键值对数据时,将常见的键缓存起来,能够显著减少Map任务的执行时间。又如,在一些具有数据重用特性的作业中,如机器学习算法训练,缓存输入数据可以加速每次迭代的计算。

## 3.3 数据压缩与序列化

### 3.3.1 数据压缩的必要性与方法

中间数据通常包含大量重复的信息,因此数据压缩对于减少存储空间和提高数据传输效率非常必要。数据压缩分为无损压缩和有损压缩,MapReduce中多使用无损压缩方法,以确保数据的完整性和准确性。

常见的无损压缩方法包括:

- **Gzip**:一种广泛使用的压缩方法,通过.deflate()方法压缩数据。

- **Bzip2**:提供更高的压缩比,但压缩速度相对较慢。

- **Snappy**:Google开发的压缩算法,旨在提供更快的压缩和解压速度。

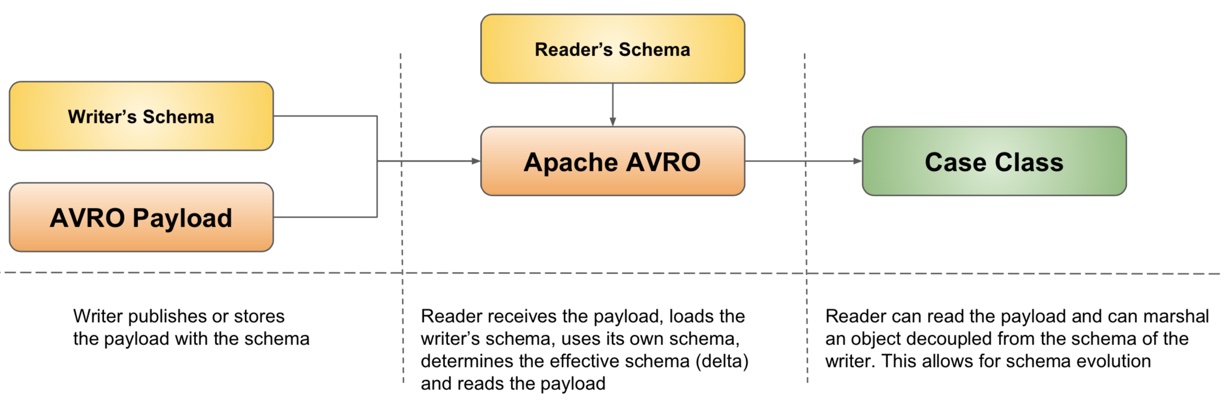

### 3.3.2 序列化框架的选择与优化

在MapReduce中,序列化是将对象转换成一种格式,以便存储或通过网络传输。选择合适的序列化框架对于优化中间数据的存储和处理同样重要。

目前,MapReduce支持的序列化框架有:

- **Java原生序列化**:简单易用,但效率不高,且序列化后的数据体积较大。

- **Avro**:适用于大数据量的快速序列化和反序列化操作。

- **Thrift**:支持多种编程语言,适合复杂的数据结构和服务开发。

- **Protocol Buffers**:由Google开发,用于结构化数据序列化的轻量级框架。

在选择序列化框架时,应考虑数据结构复杂度、开发语言兼容性、性能和压缩效率等因素。在优化序列化框架时,通常需要调整序列化和反序列化的参数,以及考虑采用自定义序列化器以提高性能。

接下来,本章将通过Mermaid流程图和代码块对中间数据的Shuffle过程进行详细解析,提供更直观的理解。

# 4. MapReduce性能监控与调优实践

MapReduce作为大数据处理领域的核心技术,其性能调优对于处理大规模数据集至关重要。性能监控与调优是一个持续的过程,它要求开发者对系统有深刻的理解。本章将深入探讨性能监控工具的使用、性能瓶颈分析方法以及真实世界中的优化案例。

## 4.1 性能监控工具介绍

有效的性能监控是调优的第一步,它可以帮助开发者了解系统当前的状态和性能瓶颈所在。下面将介绍两种广泛使用的性能监控工具:Ganglia和Nagios。

### 4.1.1 Ganglia和Nagios简介

**Ganglia** 是一个高性能、可扩展的分布式监控系统,主要用于监控大型集群中成千上万的节点。Ganglia的核心是gmond守护进程,它在每个节点上运行,收集和汇总数据。gmetad守护进程则负责将gmond的数据聚合起来,以供Web界面展示或供其他应用查询。Ganglia对各种资源(CPU、内存、磁盘、网络等)的监控非常全面。

**Nagios** 则是一个企业级监控系统,它可以监控网络服务、主机资源以及应用程序。Nagios以事件驱动的方式来检测和报告服务状态。它不仅能够发现服务中断,还能预测并报告潜在的服务故障,这对于性能调优至关重要。

### 4.1.2 集成监控工具到MapReduce

为了监控MapReduce作业,我们可以将Ganglia和Nagios集成到Hadoop集群中。首先,需要在所有节点上安装gmond,并配置好相应的参数,如集群名称、更新频率等。然后,在中心节点安装gmetad,并通过Web界面或Nagios来访问监控数据。

通过集成监控工具,开发者可以获得实时的系统状态信息,如节点的CPU使用率、内存消耗、磁盘I/O以及网络流量等。此外,还可以监控到MapReduce作业的状态、各个阶段的执行时间和资源消耗情况。

## 4.2 性能瓶颈分析

准确地识别性能瓶颈是进行有效调优的基础。MapReduce作业中常见的瓶颈通常出现在Map阶段、Shuffle阶段和Reduce阶段。

### 4.2.1 Map和Reduce阶段的性能瓶颈

**Map阶段瓶颈:**

- **资源限制:** Map任务可能会受限于CPU、内存或磁盘I/O。例如,如果Map任务的内存消耗过多,可能导致频繁的垃圾回收(GC),从而影响性能。

- **数据倾斜:** 当数据分布不均时,某些Map任务可能需要处理的数据远多于其他任务,导致Map阶段整体耗时。

**Reduce阶段瓶颈:**

- **数据量:** Reduce任务需要处理的数据量大小直接影响执行时间。如果Map阶段输出的数据量过大,会造成网络传输的瓶颈。

- **内存管理:** Reduce任务中内存的不当使用同样会导致性能问题。

### 4.2.2 解决方案与调优技巧

针对上述瓶颈,可以采取如下调优策略:

- **增加资源:** 调整YARN资源参数,给Map和Reduce任务分配更多的内存和CPU资源。

- **优化数据倾斜:** 尽量在Map阶段就处理好数据倾斜问题,比如通过合理设置分区函数。

- **压缩Map输出:** 通过Map输出压缩减少网络传输量,使用高效的序列化框架。

- **并行度调整:** 适当增加或减少Map和Reduce任务的并行度,以平衡负载。

## 4.3 优化案例分析

了解理论知识之后,通过实际案例来理解性能监控与调优的实践过程是非常有帮助的。接下来,我们将分享一些知名公司进行MapReduce优化的案例,并分析其中的关键点。

### 4.3.1 大数据公司的MapReduce优化案例

某知名电商公司通过监控工具发现其MapReduce作业在Reduce阶段耗时过长。通过调优,他们采取了以下措施:

- **任务并行度优化:** 调整了Reduce任务的数量,解决了数据倾斜问题。

- **内存管理优化:** 对YARN的资源参数进行了调优,避免了频繁的GC导致的性能下降。

### 4.3.2 案例中的经验总结与分享

从上述案例中我们可以总结出以下经验:

- **持续监控:** 性能监控是一个持续的过程,需要定期检查集群状态。

- **瓶颈定位:** 找到性能瓶颈所在是调优的关键。可以使用日志分析、性能分析工具等多种手段辅助定位。

- **调优实践:** 对于发现的问题,需要制定相应的优化策略,并在实际操作中不断尝试和验证。

- **知识共享:** 性能优化的知识和经验需要在团队内部进行分享,以提高整个团队的技术水平。

通过以上章节的深入探讨,我们已经详细了解了性能监控工具的使用方法、性能瓶颈的分析方法,以及真实世界中的优化案例。下一章,我们将一起探索MapReduce在分布式计算领域的创新技术,并展望其未来的发展趋势。

# 5. MapReduce分布式计算的创新技术

MapReduce作为一种分布式计算框架,拥有处理大规模数据集的强大能力,但其优化空间和应用场景随着技术发展而不断演变。本章节将探讨一些创新技术,它们旨在改进MapReduce的性能、拓展其应用场景,并与新兴技术进行融合实践。

## 5.1 分区与聚合优化

### 5.1.1 自定义分区策略

分区是MapReduce中影响数据分布和最终计算性能的重要因素。默认的分区方法可能无法满足特定应用的需求,因此自定义分区策略显得尤为关键。

```java

public class CustomPartitioner extends Partitioner<Text, IntWritable> {

@Override

public int getPartition(Text key, IntWritable value, int numPartitions) {

// 重写分区逻辑,例如,使用哈希方法来决定分区

return (key.hashCode() & Integer.MAX_VALUE) % numPartitions;

}

}

```

在上述代码示例中,我们通过重写`getPartition`方法来实现自定义分区逻辑。通过哈希函数确保每个分区均匀地接收到数据,从而优化了数据分布。

### 5.1.2 聚合操作的优化方法

聚合操作通常在MapReduce的Reduce阶段执行,是数据处理过程中的关键步骤。优化聚合操作可以显著提升整体性能。

```java

public class CustomGroupingComparator extends WritableComparator {

protected CustomGroupingComparator() {

super(Text.class, true);

}

@Override

public int compare(byte[] b1, int s1, int l1, byte[] b2, int s2, int l2) {

// 重写分组比较逻辑,实现更高效的聚合

***pare(b1, s1, l1, b2, s2, l2);

}

}

```

在这段代码中,我们定义了`CustomGroupingComparator`,通过调整分组比较逻辑来控制数据如何被聚合。合理的聚合策略能够减少网络传输量并降低排序成本。

## 5.2 MapReduce与云计算

### 5.2.1 云计算环境下的MapReduce架构

云计算环境下,MapReduce架构需要适应灵活的资源分配和弹性计算需求。云服务提供商通常会提供集成的MapReduce服务,并对底层架构进行优化。

### 5.2.2 MapReduce在云平台上的性能调优

在云平台上运行MapReduce作业时,可以通过动态调整资源(如CPU、内存和存储)来优化性能。

```yaml

# 示例YAML配置文件片段,用于YARN资源管理配置

yarn:

scheduler:

type: "capacity-scheduler"

capacity:

"mycluster":

maxApplications: 100

queues:

"high-priority":

maxApplications: 20

capacity: 80

queueType: fair

"default":

maxApplications: 80

capacity: 20

queueType: fair

```

通过上述配置,可以更合理地分配资源给不同的作业,提高计算资源利用率。

## 5.3 新兴技术融合实践

### 5.3.1 MapReduce与Spark的比较与融合

随着Spark等内存计算框架的兴起,MapReduce在某些场景下显得相对缓慢。然而,两者可以互补,将Spark作为MapReduce的前端处理加速器。

### 5.3.2 深度学习框架与MapReduce的集成

将深度学习框架与MapReduce结合,可以实现大规模数据上的分布式深度学习。例如,借助Hadoop的存储能力和TensorFlow的计算能力。

```python

# 示例代码:使用Hadoop文件系统读取数据作为TensorFlow输入

import tensorflow as tf

import hadoopfs_input

# 使用HadoopFSInput读取HDFS文件系统中的数据

input_data = hadoopfs_input.HadoopFSInput("/user/input/data", hdfs_site_config="/etc/hadoop/conf")

# 在TensorFlow计算图中使用这些数据进行训练

with tf.Session() as sess:

# ... 定义模型和训练过程 ...

sess.run(training_op)

```

这种集成方式实现了数据存储和深度学习计算的分离,同时利用了MapReduce处理大数据的优势。

通过本章节的介绍,我们看到了MapReduce在分区与聚合优化、云环境适应性以及与新兴技术的融合方面的创新进展。这些技术不仅提升了MapReduce的性能,还扩展了其应用范围,使其能够在新兴的大数据应用中继续保持其重要地位。

# 6. MapReduce优化技巧的未来展望

随着大数据技术的不断发展,MapReduce优化技巧也在不断地演进。未来的技术趋势、社区动态以及学习资源的丰富性都将对优化技巧的发展产生深远的影响。

## 6.1 新兴技术趋势

### 6.1.1 机器学习在MapReduce优化中的应用

在大数据处理领域,机器学习已逐步成为解决复杂问题的有效手段。MapReduce的性能优化同样可以利用机器学习算法进行自动化和智能化处理。例如,通过机器学习模型预测出数据的分布和运行时负载情况,帮助设计更有效的数据分区策略或者调整Map和Reduce任务的数量。

```python

# 伪代码示例:使用机器学习模型预测MapReduce任务负载

# 假设有一个训练好的模型ML_model,用于预测每个Map任务的负载

import machine_learning_model

def predict_task_loads(data):

# 使用模型预测每个任务的负载

loads = ML_model.predict(data)

return loads

# 示例数据

sample_data = {'data_distribution': [10, 25, 15, 50], 'historical_loads': [20, 30, 25, 45]}

task_loads = predict_task_loads(sample_data)

print(task_loads)

```

### 6.1.2 容器化技术与MapReduce的结合

容器化技术,如Docker,允许用户在隔离的环境中部署应用,这为MapReduce任务提供了新的部署和优化手段。通过容器化技术,可以实现资源的快速调度和弹性伸缩,提高MapReduce任务的执行效率。

```yaml

# Docker配置文件示例:配置MapReduce任务的容器环境

version: '3.7'

services:

mapreduce_task:

image: mapreduce_image:latest

deploy:

replicas: 1

resources:

limits:

cpus: '1'

memory: 1G

reservations:

cpus: '0.5'

memory: 500M

ports:

- "8000:8000"

```

## 6.2 社区动态与技术前沿

### 6.2.1 国际开源社区的最新动态

开源社区是推动MapReduce优化技术发展的主要力量。在国际开源社区,如Apache基金会,众多开发者和组织分享他们的研究成果和实践经验。通过跟踪开源社区的动态,可以发现最新的优化方法和技术趋势。

### 6.2.2 行业领导者的技术发展路线图

行业领导者,如Google、Facebook和阿里巴巴,不断在其技术发展路线图中探索新的优化方向。他们发布的白皮书、技术博客和研究成果,对MapReduce优化领域有着深远的影响。

## 6.3 学习资源与未来挑战

### 6.3.1 推荐的进阶学习资源

为了更好地掌握MapReduce优化技巧,推荐以下学习资源:

- Apache官方文档:详细介绍了MapReduce的配置和使用方法。

- 在线教育平台:如Coursera、edX提供的大数据相关课程。

- 技术博客和论坛:如Medium、Reddit中的大数据专区。

### 6.3.2 面临的挑战与职业规划建议

未来,MapReduce优化将面临数据量的爆炸性增长、多样化计算模型的冲击以及实时数据处理的需求等挑战。为了适应这些变化,建议IT从业者在以下几个方向进行职业规划:

- 持续学习新技术,如Flink和Spark等实时计算框架。

- 增强数据分析和处理能力,学习如何应用机器学习优化大数据处理。

- 关注云计算和容器化技术的发展,了解如何将这些技术应用于大数据处理。

通过不断学习和实践,MapReduce优化领域的从业者将能够抓住未来发展的机遇。

0

0