【深入MapReduce作业内部】:内存与磁盘间数据流转动态分析

发布时间: 2024-11-01 00:52:33 阅读量: 23 订阅数: 31

基于MapReduce+Pandas的电影排名与推荐以及数据分析与可视化展示

# 1. MapReduce概念框架与数据流概述

MapReduce是一种分布式数据处理模型,由Google提出,后成为Hadoop项目的核心组件。它通过分而治之的思想,简化了大规模数据集的并行运算。

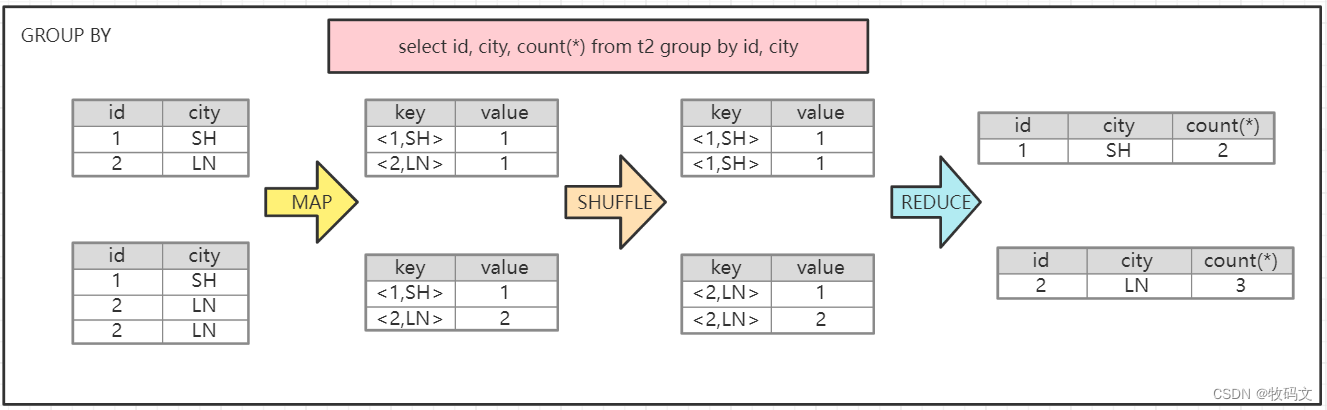

MapReduce模型包括Map(映射)和Reduce(归约)两个关键操作。Map阶段处理输入数据,将其转换为一系列中间键值对。而Reduce阶段则将这些中间键值对进行合并,生成最终结果。

MapReduce处理的数据流遵循从输入到Map,再到Reduce,最后输出到存储的路径。其执行流程涉及数据的读取、处理、分组、规约和输出,形成了一个高效的大数据处理流水线。这个模型特别适合处理大量无结构或半结构的数据,如日志文件或文档集合等。

# 2. MapReduce的数据处理机制

### 2.1 Map阶段的数据处理

MapReduce框架的设计思想是以Map和Reduce两个阶段为核心来处理大规模数据集。Map阶段是数据处理的起点,负责将输入数据转换为键值对形式,这些键值对随后会被传递到Reduce阶段进行处理。

#### 2.1.1 输入数据的读取与解析

在MapReduce框架中,输入数据通常是以文件的形式存储在分布式文件系统HDFS上。Map任务读取输入文件块并将其分割成固定大小的InputSplit,每一个InputSplit由一个Map任务处理。

接下来,Map任务开始读取InputSplit中的数据,并根据用户定义的InputFormat进行解析。InputFormat负责指定如何读取输入数据以及如何将输入数据切割成可由Map处理的记录。例如,在Hadoop中,通常使用TextInputFormat作为默认的InputFormat,它会将每行文本作为一条记录。

#### 2.1.2 Map任务的执行与数据映射

Map任务的执行由用户定义的Map函数来完成。Map函数处理输入的每一条记录(即每一行),并返回键值对。键值对的键通常表示某种分类标识,而值则是相关信息。

例如,在一个词频统计的场景中,Map函数可能将每一行文本转换成形如(word, 1)的键值对,其中word表示单词,1表示该单词在记录中出现一次。这样的键值对可以用于后续的排序和合并操作。

下面是一个简单的Map函数实现示例:

```java

public static class TokenizerMapper

extends Mapper<Object, Text, Text, IntWritable>{

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context

) throws IOException, InterruptedException {

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

word.set(itr.nextToken());

context.write(word, one);

}

}

}

```

上述代码中的`TokenizerMapper`类继承自Hadoop的Mapper类,覆盖了`map`方法,以将每行文本拆分为单词,并输出键值对。

#### 2.1.3 中间数据的分区与排序

Map阶段的输出是中间键值对集合,这个集合需要被发送到Reduce阶段进行处理。在发送之前,这些中间数据需要经过分区和排序。

分区是为了将中间数据分割成若干个区域,确保具有相同键的数据会被发送到同一个Reduce任务中进行处理。默认情况下,Hadoop使用哈希分区函数`HashPartitioner`。

排序是针对每个分区内的数据进行的,排序过程是为了将键值对按键排序,使得相同的键聚集在一起,为下一步的合并和规约操作做好准备。在Hadoop中,排序过程通常在内存中进行,当内存不足以容纳全部数据时,会采用外部排序算法。

### 2.2 Reduce阶段的数据处理

#### 2.2.1 中间数据的合并与分组

在Reduce阶段开始之前,所有Map任务产生的中间键值对通过Shuffle和Sort过程被传输到对应的Reduce任务中。Shuffle过程将数据从Map任务传输到Reduce任务,并对数据进行排序,使得具有相同键的数据聚集在一起。

Reduce任务接收到分组后的中间数据后,它会遍历这些键值对,将具有相同键的所有值组合到一起。这个过程就是数据的合并。例如,对于词频统计任务,它将合并所有相同单词的频率,准备进行计数。

#### 2.2.2 Reduce任务的执行与数据规约

Reduce阶段的任务由用户定义的Reduce函数来完成。Reduce函数接收分组后的键值对列表,然后对这些值进行合并操作。合并操作可以是简单的求和,也可以是更复杂的数据处理逻辑。

在词频统计的案例中,Reduce函数会对每一个单词出现的次数进行累加,生成形如(word, total)的输出,这里的total表示该单词在所有输入数据中的总出现次数。

下面是一个简单的Reduce函数实现示例:

```java

public static class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context

) throws IOException, InterruptedException {

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

context.write(key, result);

}

}

```

上述代码中的`IntSumReducer`类继承自Hadoop的Reducer类,覆盖了`reduce`方法,以将同一单词出现的次数进行求和。

#### 2.2.3 最终结果的输出

Reduce任务处理完毕后,会将最终的键值对集合写入输出文件。输出文件同样存储在HDFS上,由于输出文件通常是经过规约后的数据,所以它们通常比中间数据小得多。输出文件是Hadoop作业的最终结果,可以在其他程序中进一步使用。

### 2.3 MapReduce的容错机制与优化

#### 2.3.1 作业调度与资源管理

MapReduce框架利用一个主节点上的JobTracker组件来进行作业调度,该组件负责分配Map和Reduce任务到各个从节点的TaskTracker上执行。JobTracker还负责监控任务执行情况,并重新调度失败或被杀死的任务。Hadoop 2.x引入了YARN作为资源管理平台,YARN在MapReduce中提供了更有效的资源调度和作业管理。

资源管理涉及对CPU、内存和磁盘I/O的合理分配。在MapReduce的运行过程中,需要保证每个任务都有足够的资源运行,并且资源分配要高效,避免资源浪费。

#### 2.3.2 性能优化策略

MapReduce的性能优化是一个多方面的任务,涉及对M

0

0