依存句法分析:Python自然语言处理高级应用

发布时间: 2024-10-04 19:35:44 阅读量: 52 订阅数: 46

自然语言处理 中英文句法分析与依存句法分析——文本和代码

# 1. 依存句法分析概述

## 1.1 什么是依存句法分析

依存句法分析是一种通过分析句子中词汇之间的依赖关系来确定句子结构的方法。在依存句法中,句中的词汇被分为核心词和依赖词,每个词汇都通过依存关系与另一个词汇相连,形成一个依存树。

## 1.2 依存句法分析的重要性

依存句法分析对理解句子结构和语义具有重要意义。通过分析句子中的依存关系,可以揭示句子的语义结构,为诸如信息检索、文本生成、问答系统等NLP任务提供支持。

## 1.3 依存句法分析的应用

依存句法分析广泛应用于自然语言处理的各个领域,如机器翻译、文本摘要、情感分析等。通过对句子的深入分析,依存句法分析能够提供更丰富、更准确的语言信息。

# 2. Python自然语言处理基础

自然语言处理(NLP)是计算机科学和人工智能中的一个关键领域,它涉及到让计算机理解和解释人类语言的技术。Python作为一种高级编程语言,因其简洁的语法和强大的库支持,在自然语言处理领域得到了广泛的应用。本章将详细介绍自然语言处理的理论基础,Python在NLP中的作用,以及文本预处理和特征提取的相关技术。

### 2.1 自然语言处理的理论基础

#### 2.1.1 自然语言处理的定义与发展

自然语言处理是人工智能的一个分支,它关注于计算机与人类语言之间的交互。NLP的目标是使计算机能够理解、解释、生成和操纵人类语言内容。这包括了语言的语音、语义、结构和情感等多个方面。

自然语言处理的发展历程可以追溯到20世纪50年代,当时的研究主要集中在用机器模拟语言的理解。早期的工作依赖于规则和启发式方法,但随着时间的推移,统计学和机器学习方法逐渐成为主流。近年来,深度学习的兴起带来了NLP技术的革命,使得模型能够更精准地处理复杂的语言任务。

#### 2.1.2 语言模型与语料库

语言模型是NLP中的核心概念,它是一个统计模型,用于评估一个句子或一个词序列的可能性。语料库则是大量语言数据的集合,它提供了模型训练和评估的基础。著名的语言模型包括n-gram模型、隐马尔可夫模型和最近的神经网络语言模型。

### 2.2 Python在自然语言处理中的角色

#### 2.2.1 Python与NLP的库与框架

Python有许多专为NLP设计的库和框架,其中最著名的有NLTK(Natural Language Toolkit)、SpaCy、TextBlob和gensim等。这些库提供了一系列工具,用于文本分析、分词、命名实体识别(NER)、依存句法分析、情感分析等任务。

- **NLTK** 是一个开源的NLP工具包,它提供了简单易用的接口来处理语言数据。NLTK集成了大量的语料库和词汇资源,适合于教学和研究。

- **SpaCy** 是一个相对较新的库,专注于性能和效率,提供了工业级的NLP解决方案。

- **TextBlob** 为处理文本数据提供了简洁的API,它基于NLTK和Pattern。

- **gensim** 是一个专门用来处理语料库并从中提取主题和语义相似度的库。

#### 2.2.2 环境搭建与常用工具介绍

为了在Python中使用NLP库,首先需要安装Python解释器。然后,可以通过pip包管理器安装所需的NLP库。例如,安装NLTK可以通过以下命令:

```bash

pip install nltk

```

安装完NLTK后,可以通过Python交互式环境导入和使用它:

```python

import nltk

```

在实际的NLP项目中,还需要构建开发环境,安装IDE(如PyCharm或Jupyter Notebook),并根据项目需求下载额外的数据包和模型。

### 2.3 文本预处理与特征提取

#### 2.3.1 文本清洗与分词

文本预处理是NLP中的一个关键步骤,它涉及到多个子步骤,其中包括文本清洗、分词、去除停用词等。文本清洗的目的是去除文本中的噪声,例如HTML标签、特殊字符等。

分词是将连续的文本拆分为有意义的单位(通常是单词或词组)。在英文中,分词相对简单,因为单词之间有明确的空格分隔。在中文中,分词则复杂得多,因为汉语是一种表意文字,词与词之间没有明显的分隔符。分词可以使用现成的分词工具或库来完成。例如,使用NLTK进行英文分词的示例代码如下:

```python

import nltk

nltk.download('punkt') # 下载分词模型

text = "The Natural Language Toolkit is a Python library designed to help humans work with human language data."

tokens = nltk.word_tokenize(text)

print(tokens)

```

#### 2.3.2 词性标注与命名实体识别

词性标注(POS Tagging)是指为文本中每个单词赋予一个词性标签,例如名词、动词、形容词等。命名实体识别(NER)则关注于从文本中识别出具有特定意义的实体,例如人名、地名、组织名等。

NLTK提供了丰富的POS标记集,并有专门的标注器来处理这一任务。下面的示例展示了如何使用NLTK进行词性标注:

```python

from nltk import pos_tag, word_tokenize

text = "Natural Language Processing is fun!"

tokens = word_tokenize(text)

tagged_tokens = pos_tag(tokens)

print(tagged_tokens)

```

NER可以通过训练序列标注模型来实现,也可以使用现成的工具,如SpaCy。以下是使用SpaCy进行命名实体识别的代码示例:

```python

import spacy

# 加载英文模型

nlp = spacy.load("en_core_web_sm")

# 分析文本

text = "Apple is looking at buying U.K. startup for $1 billion"

doc = nlp(text)

for ent in doc.ents:

print(ent.text, ent.start_char, ent.end_char, ent.label_)

```

在上述代码中,`doc.ents` 是一个包含文档中所有命名实体的容器,每个实体都有其文本内容、起始和结束位置以及实体类型。

这些NLP的预处理和特征提取步骤为后续的深入分析打下了基础,为机器学习模型提供了必要的输入特征。通过这些基础知识点,我们可以更进一步地探索NLP的高级分析和应用。

# 3. 依存句法分析的理论与实践

## 3.1 依存句法分析的理论框架

### 3.1.1 句法分析的基本概念

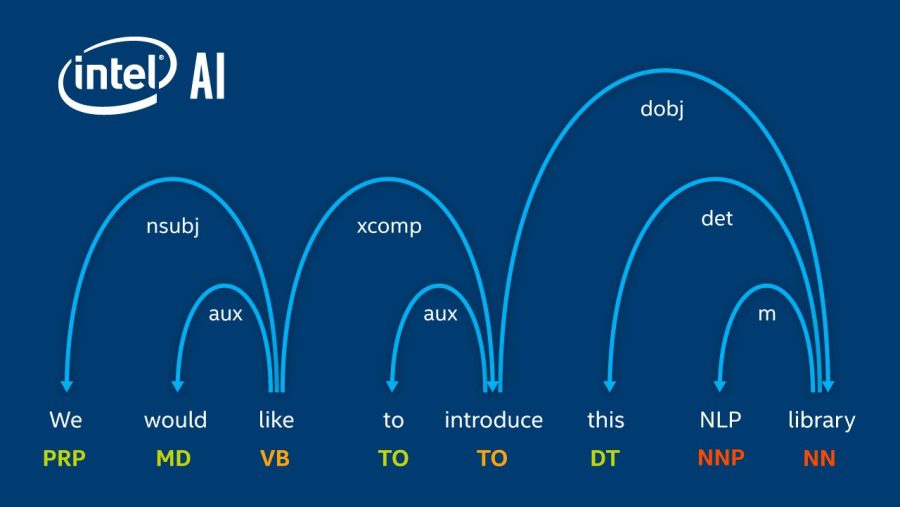

依存句法分析是自然语言处理(NLP)中一个重要的分支,它关注的是句子中单词之间的依存关系。每个词都与另一个词(头词)有直接的依存关系,这形成了一个依存树,树的每个节点代表一个词,边表示词之间的依存关系。在依存句法分析中,词汇是句子的基本单位,分析的目标是确定每个词的语法功能以及词与词之间的相互关系。

依存关系通常分为几种类型,比如主谓关系、动宾关系、定中关系等。每种依存关系反映了句子成分之间的不同语法功能。例如,在“小明喜欢足球”这个句子中,“喜欢”是谓语,“小明”和“足球”分别是其主语和宾语,它们之间形成了一个依存关系。

在依存句法分析中,通常需要识别句子中的核心成分(如主语、谓语),并确定其他成分(如宾语、定语、状语)是如何依存于这些核心成分的。依存关系的类型和规则对于构建依存树至关重要,不同的语言可能有不同的依存关系和规则。

### 3.1.2 依存关系与依存树的构建

依存树的构建是一个将句子中的词组织成层级关系的过程。在依存树中,有一个根节点,它是整个句子的中心,通常选择谓语作为根节点。然后,根据词与词之间的依存关系,将其他词连接到根节点或树中已存在的节点上。

构建依存树的过程通常包含以下几个步骤:

1. 确定句子的谓语,通常是动词。

2. 识别谓语的直接依存词,如主语和宾语。

3. 对于句子中的每一个词,确定它是否是另一个词的直接依存词。

4. 使用依存规则将词连接起来,形成依存关系。

5. 检查并修复任何潜在的依存冲突,如环状结构或多重依存。

6. 最终形成一个完整的依存树。

依存树的构建有多种算法,其中一些算法特别关注局部依存关系,如在句子中找到一个主谓宾结构;而其他算法可能考虑到更全局的结构,比如整个句子的语义组织。在NLP任务中,如信息检索、文本生成和问答系统中,依存树提供了一个强大的工具来理解句子的结构和语义。

## 3.2 依存句法分析的算法实现

### 3.2.1 常见算法与对比分析

在依存句法分析的实践中,研究者和工程师们开发出了多种算法来构建依存树。这些算法可以

0

0