文本挖掘技巧:TextBlob提取大量文本中的洞见

发布时间: 2024-10-04 20:08:31 阅读量: 34 订阅数: 46

R-text-data:用于R中的文本挖掘的文本数据源列表

# 1. 文本挖掘与TextBlob概述

文本挖掘(Text Mining),又称文本数据挖掘,是指从非结构化的文本数据中提取有用信息和知识的过程。它涉及到自然语言处理(Natural Language Processing, NLP)、统计学、机器学习等多种技术,其目的是将大规模的文本数据集转化为有意义的结构化信息。

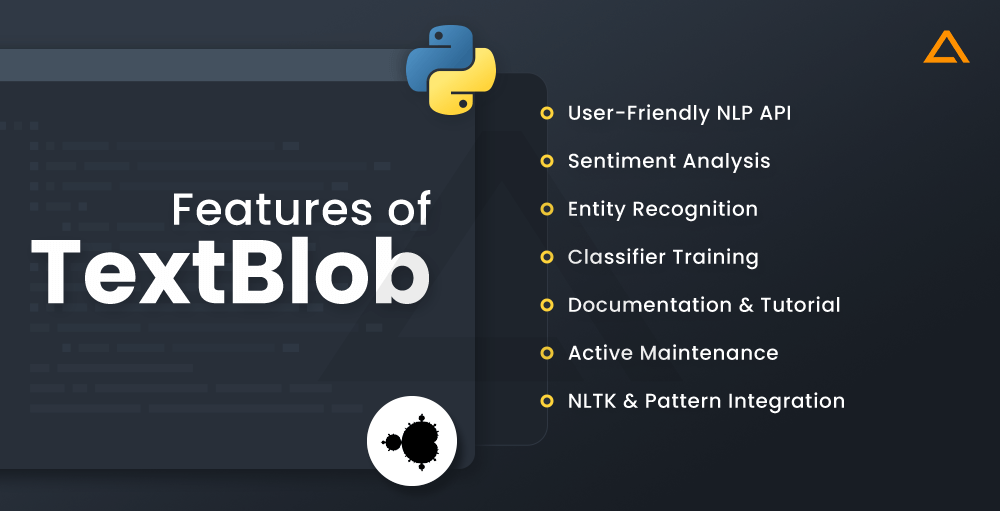

TextBlob是一个简单易用的文本处理库,它构建在NLTK库之上,用于执行常见的自然语言处理任务。TextBlob的API设计直观且简洁,使得开发者能够轻松地执行诸如词性标注、名词短语提取、情感分析、翻译等任务,而无需深入了解底层的算法和模型。

对于IT专业人士和数据分析师来说,TextBlob是一个强大的工具,它使得在进行数据分析项目时,能够更加专注于结果和业务逻辑,而不必花费大量时间学习复杂的NLP技术细节。随着文本挖掘在社交媒体分析、客户反馈处理、市场研究等领域的广泛应用,掌握TextBlob成为提高工作效率的关键技能之一。

# 2. TextBlob基础及其在文本预处理中的应用

## 2.1 TextBlob安装与初步使用

### 2.1.1 安装TextBlob库

在Python的环境中,安装TextBlob库通常可以使用pip包管理器来完成。首先,打开命令行工具,输入以下命令来安装TextBlob:

```bash

pip install textblob

```

这条命令会将TextBlob及其依赖库安装到当前Python环境中。安装完成后,我们可以使用Python交互式界面或者脚本来验证安装是否成功,通过导入TextBlob库并检查版本信息。

```python

import textblob

print(textblob.__version__)

```

上述代码块中,首先导入textblob库,然后通过打印出库的版本信息来验证安装。如果安装成功,将会显示TextBlob的版本号。

### 2.1.2 TextBlob基础功能介绍

TextBlob库为文本处理提供了一系列的方便的接口,涵盖了诸多文本分析的基本功能。它的核心是一个简单的API用于常见的自然语言处理(NLP)任务。以下是一些TextBlob的主要功能:

- 文本的情感分析

- 词性标注

- 拼写校正

- 词形还原

- 文本分类

- 分词(Tokenization)

- 命名实体识别

- 词干提取

- 语言翻译

每个功能都可以通过TextBlob提供的接口进行访问。例如,如果我们想对一段文本进行情感分析,可以使用如下代码:

```python

from textblob import TextBlob

text = "I love writing code. It's so much fun!"

blob = TextBlob(text)

print(blob.sentiment)

```

这段代码创建了一个TextBlob对象,并对一段简单文本进行了情感分析。输出的sentiment属性将包含两个部分:polarity(极性)和subjectivity(主观性),极性通常在-1到1之间,表示情感的积极程度;主观性在0到1之间,表示文本的主观或客观程度。

## 2.2 文本预处理技巧

### 2.2.1 分词和词形还原

在进行文本分析之前,通常需要进行文本的预处理,其中一个关键步骤就是分词。分词是将连续的文本序列分割为单独的有意义的单词或标记(tokens)的过程。

TextBlob中的分词功能非常简单,可以通过调用TextBlob对象的`words`属性来实现:

```python

from textblob import TextBlob

text = "TextBlob is amazing."

blob = TextBlob(text)

print(blob.words)

```

执行上述代码后,`blob.words`将返回一个列表,其中包含了分词后的单词。

词形还原(Lemmatization)是文本预处理的另一个关键步骤,它的目的是将单词还原为基本形式。在TextBlob中,可以使用`lemmatize`方法来实现词形还原:

```python

print(blob.words.lemmatize())

```

通过`lemmatize`方法,可以将文本中的单词转化为它们词典形式的单词,也就是词元(lemma)。这对于处理文本,尤其是在文本挖掘和NLP任务中非常有用。

### 2.2.2 停用词去除与文本标准化

停用词是指那些在文本中频繁出现但对表达文本含义贡献不大的词,如“the”、“is”和“at”等。在文本分析中,通常需要将这些词去除以简化分析的复杂度。TextBlob同样提供了一种简单的方法来进行停用词的去除。

```python

from textblob import TextBlob

from textblob import Word

blob = TextBlob("TextBlob is a library for processing textual data.")

stop_words = set(Word.list()) # 获取预定义的停用词列表

words = [word for word in blob.words if not word in stop_words]

print(words)

```

在上面的代码中,我们首先导入TextBlob模块和Word类,然后通过`Word.list()`方法获取到预定义的停用词列表。接着,我们使用列表推导式过滤掉了文本中的停用词,并打印结果。

文本标准化包括将文本转换为统一的格式,通常涉及将文本转换为小写,去除标点符号,以及将单词转化为其词根形式等。TextBlob也提供了这样的标准化处理方法:

```python

blob = TextBlob("TextBlob is amAZing! They're very powerful.")

print(blob.words.lower()) # 转换为小写

print(blob.words.remove_punc()) # 去除标点符号

```

在上述代码中,`lower()`方法将所有单词转换为小写,而`remove_punc()`方法则去除文本中的标点符号。

## 2.3 分词与文本分析

### 2.3.1 分词原理及其在TextBlob中的应用

分词是文本处理的基础,尤其是在处理像中文、日语这类不是以空格分隔词汇的语言时,分词成为了分析文本的前提。分词过程可以理解为将连续的文本序列分割为可操作的词语序列的过程。

TextBlob使用了一个简单而强大的词库来执行分词,尤其适用于英语等使用空格分隔单词的语言。尽管TextBlob不是专为处理非英语语言设计的,但其分词功能对于英语文本分析来说是足够有效的。

```python

blob = TextBlob("TextBlob is a Python library for processing textual data.")

print(blob.words)

```

在执行上述代码后,`blob.words`将输出一个单词列表,代表对输入文本进行分词的结果。

### 2.3.2 标签化和命名实体识别

标签化(Tagging)是指为文本中的每个单词分配一个词性标签的过程,它有助于我们理解每个单词在句子中的语法角色。TextBlob通过内置的词性标注器(POS tagger)进行标签化,能够识别大多数英语单词的词性。

```python

blob = TextBlob("TextBlob is a Python library for processing textual data.")

print(blob.tags)

```

执行以上代码后,`blob.tags`会输出每个单词及其对应的词性标签(如名词、动词等),例如:“('TextBlob', 'NNP')”,其中“NNP”表示专有名词。

命名实体识别(Named Entity Recognition, NER)是另一个重要的文本分析步骤,它涉及识别文本中的命名实体,如人名、地名、组织机构名等。TextBlob的命名实体识别功能可以通过`nltk`包实现:

```python

blob = TextBlob("Google LLC is a multinational technology company.")

print(blob.noun_phrases)

```

在上述代码中,`noun_phrases`属性将输出文本中的命名实体短语,这对于提取关键信息特别有用。

总结来看,TextBlob在文本预处理方面的功能非常全面,它为文本分析提供了一个易用的界面,能够满足日常文本挖掘的多数需求。通过TextBlob的分词、词形还原、停用词去除、标签化和命名实体识别等基础功能,我们可以快速准备好数据,进行后续的深入分析和处理。

# 3. TextBlob进行情感分析和主题建模

## 3.1 情感分析实践

### 3.1.1 情感分析理论基础

情感分析是文本挖掘领域的一个重要分支,它的目的是识别和提取文本数据中的主观信息。这可以帮助企业了解客户对产品或服务的看法,预测市场趋势,或在社交媒体上进行品牌声誉管理。情感分析通常涉及确定文本是正面的、负面的还是中性的。

情感分析的关键在于情感词典和机器学习模型的应用

0

0