基于TextBlob的语料库构建:数据准备与预处理秘籍

发布时间: 2024-10-04 19:22:25 阅读量: 44 订阅数: 46

微博文本情感分析语料库

# 1. TextBlob介绍与语料库构建基础

## TextBlob简介

TextBlob是一个用于处理文本数据的Python库,它简化了自然语言处理(NLP)任务,提供易于使用的接口,用于常见的文本处理需求,如词性标注、情感分析、名词短语提取等。TextBlob的背后是NLTK和Pattern库,但其优势在于用户无需深入了解底层NLP工具包即可快速开始工作。

## 语料库构建的重要性

语料库是NLP研究和开发中的基石,它是大量语言材料的集合,被用来训练语言模型、进行语言分析、验证语言理论等。一个构建良好的语料库应当具有高质量的文本样本,覆盖广泛的语言用法,且更新及时,以适应语言的不断变化。

## 使用TextBlob构建基础语料库

构建基础语料库时,TextBlob可以快速帮助我们进行文本的分词、词性标注、解析等任务。举个例子,以下是一个简单的分词和词性标注的代码示例:

```python

from textblob import TextBlob

blob = TextBlob("TextBlob is amazingly simple to use.")

print(blob.words) # 输出分词结果:['TextBlob', 'is', 'amazingly', 'simple', 'to', 'use', '.']

print(blob.tags) # 输出词性标注结果:[('TextBlob', 'NNP'), ('is', 'VBZ'), ('amazingly', 'RB'), ('simple', 'JJ'), ('to', 'TO'), ('use', 'VB'), ('.', '.')]

```

通过这段代码,我们可以快速得到文本的分词和词性标注结果,这对于初步建立语料库的结构化非常有帮助。在后续的章节中,我们将详细介绍如何使用TextBlob进行更深入的文本预处理和语料库构建。

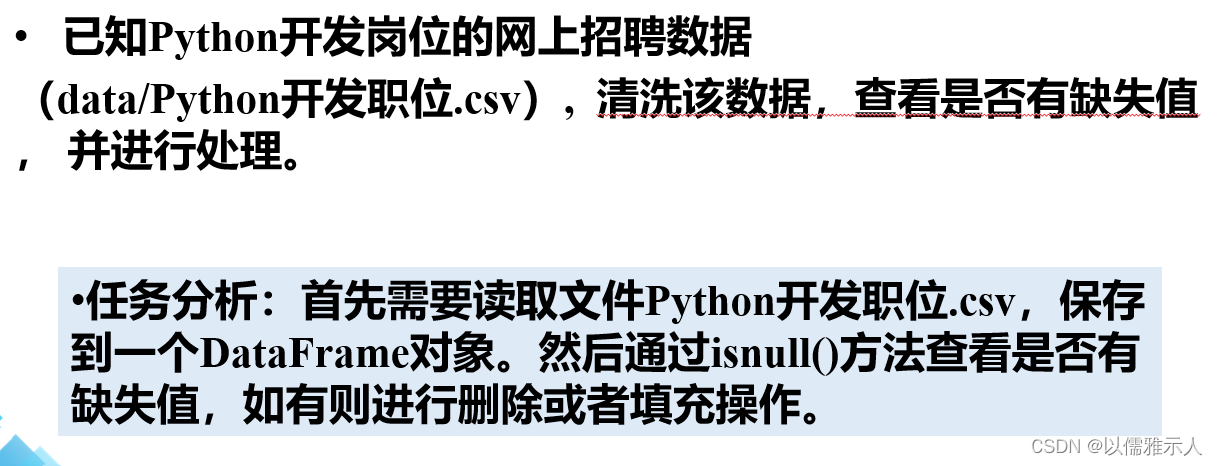

# 2. 数据收集与清洗技术

## 2.1 数据收集方法

### 2.1.1 网络爬虫技术简介

网络爬虫是自动化获取网页内容的程序,是数据收集中的关键工具。其工作原理包括发送请求、接收响应、解析内容、提取数据和存储结果。现代网络爬虫通常使用Python语言,通过库如Requests获取网页,BeautifulSoup或lxml解析内容,Scrapy框架则提供了一个完整的爬虫解决方案。

```python

import requests

from bs4 import BeautifulSoup

# 示例:使用Requests和BeautifulSoup爬取网页标题

url = "***"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

title = soup.find('title').text

print(title)

```

上述代码使用了Requests库发送HTTP请求,并将响应内容传递给BeautifulSoup进行解析,最后提取出网页的标题。网络爬虫在爬取时需要遵守Robots协议,尊重目标网站的爬取规则。

### 2.1.2 公开数据集的获取途径

除了自行爬取数据,公开数据集是数据收集的重要来源。许多组织和研究机构都会提供用于教育和研究的公开数据集。例如,Kaggle、UCI Machine Learning Repository、以及政府公开数据集等平台,都是获取高质量数据集的好地方。

```python

import pandas as pd

# 示例:使用pandas加载UCI机器学习库中的鸢尾花数据集

iris_data = pd.read_csv("***", header=None)

print(iris_data.head())

```

在上述代码中,我们使用了pandas库的`read_csv`方法,从UCI机器学习库中直接加载了一个公开数据集。这类数据集通常已经清洗过,可以直接用于分析和训练模型。

## 2.2 数据清洗过程

### 2.2.1 缺失数据的处理策略

数据集中可能存在缺失数据,处理策略有删除含有缺失值的记录、填充缺失值以及估算缺失值。对于连续变量,常用均值、中位数或众数来填充;对于分类变量,可以使用众数填充。在某些情况下,需要根据数据的分布和业务场景来决定缺失值处理方法。

```python

import numpy as np

# 示例:填充缺失值

data = pd.DataFrame([[1, np.nan, 3], [4, 5, 6], [7, 8, np.nan]])

data_filled = data.fillna(data.mean())

print(data_filled)

```

### 2.2.2 异常值和噪声的识别与处理

异常值指的是那些显著偏离其他观测值的点。检测异常值可以使用箱形图、标准差、Z分数等方法。处理异常值的方式包括删除、填充、或转换。噪声则是数据集中随机误差的体现,可以通过平滑技术、滤波器或转换数据来减少噪声的影响。

```python

# 示例:使用标准差识别异常值

from scipy import stats

data = pd.DataFrame({'A': [1, 2, 3, 100]})

z_scores = np.abs(stats.zscore(data))

print(z_scores)

```

### 2.2.3 数据格式化与统一标准

数据集中的时间戳、数值、文本等格式需要统一,以确保数据一致性。例如,日期格式需标准化、数值需统一小数点位置、字符串要统一大小写或编码。这能有效避免后续数据处理时出现的问题。

```python

# 示例:时间戳标准化

data['timestamp'] = pd.to_datetime(data['timestamp'], format='%Y-%m-%d %H:%M:%S')

print(data['timestamp'])

```

在本章节中,我们介绍了数据收集的方法,包括网络爬虫技术简介以及公开数据集的获取途径,并且探讨了数据清洗过程中的主要策略,如缺失数据的处理、异常值和噪声的识别与处理,以及数据格式化与统一标准的必要性。这些步骤是构建高质量语料库不可或缺的一部分,它们确保了数据的准确性和可用性,为后续的文本处理和自然语言处理应用打下坚实基础。

# 3. TextBlob在文本预处理中的应用

TextBlob是一个强大的Python库,它提供了简单直观的API来处理和分析文本数据。它基于NLTK(自然语言处理工具包)构建,适用于常见的自然语言处理任务,尤其是文本预处理。在本章节中,我们将深入探讨TextBlob在文本预处理方面的实际应用,包括文本的分词与标注、文本清洗与标准化、以及特征提取与向量化。

## 3.1 文本的分词与标注

### 3.1.1 分词技术的基本原理

分词是自然语言处理的第一步,它将文本序列切分为更小的单元,通常是词汇。在不同的语言中,分词的方法也有所不同。例如,英文中通常以空格为分隔符,而中文则需要更复杂的算法来识别词汇边界。

在TextBlob中,分词过程是自动进行的。TextBlob利用了NLTK中的分词算法,通过预训练的语言模型来识别词汇边界。这种分词方法适用于多语言环境,用户无需为每种语言编写特定的分词代码。

### 3.1.2 使用TextBlob进行词性标注

词性标注(Part-of-Speech Tagging, POS Tagging)是将词汇分类为名词、动词、形容词等的自然语言处理任务。TextBlob在NLTK的基础上提供了POS标注功能,能够快速识别出文本中的词性。

TextBlob中的`pos_tag()`函数接收一个字符串或分词后的文本列表,返回一个包含词性和词汇的元组列表。例如:

```python

from textblob import TextBlob

blob = TextBlob("She sat on the bank of the river.")

print(blob.tags)

```

输出将会是一个包含每个词及其POS标记的列表,如下:

```plaintext

[('She', 'PRP'), ('sat', 'VBD'), ('on', 'IN'), ('the', 'DT'), ('bank', 'NN'), ('of', 'IN'), ('the', 'DT'), ('river', 'NN'), ('.', '.')]

```

在上述代码中,`PRP`代表代词,`VBD`是过去式动词,`NN`是单数普通名词,`IN`是介词,而`.`表示标点符号。

## 3.2 文本清洗与标准化

### 3.2.1 常见文本清洗技术

文本清洗是指去除文本中的无用信息,如HTML标签、特殊符号、停用词等。TextBlob提供了许多内置的清洗方法,使得清洗工作变得简单。例如,去除HTML标签可以使用`clean_html()`方法,而去除标点符号则可以使用`str.replace()`方法。

```python

from textblob import TextBlob

blob = TextBlob("<div>Hello, world!</div>")

print(blob.clean_html())

```

以上代码将输出:

```plaintext

Hello, world!

```

### 3.2.2 文本标准化的方法与实践

文本标准化是指将文本转换为统一格式的过程,包括小写转换、词形还原(lemmatization)等。TextBlob中的`normalize()`方法可以将文本转换为小写形式,而词形还原功能则需要结合NLTK的`WordNetLemmatizer`。

```python

from textblob import TextBlob

from textblob.nltk import WordNetLemmatizer

b

```

0

0