情感分析一步到位:TextBlob在Python中的应用与实例

发布时间: 2024-10-04 19:12:26 阅读量: 137 订阅数: 25

# 1. TextBlob入门与安装

## TextBlob简介

TextBlob是一个用于处理文本数据的Python库,它简化了常见的自然语言处理(NLP)任务,如分词、词性标注、情感分析等。它构建于NLTK之上,为开发者提供了一个易于使用的接口。

## 安装TextBlob

在Python环境中安装TextBlob非常简单。您只需要打开终端或命令提示符并输入以下命令:

```bash

pip install textblob

```

安装完成后,您可以通过Python代码导入TextBlob库并检查其版本来验证安装是否成功:

```python

from textblob import TextBlob

print(TextBlob.__version__)

```

## 使用TextBlob

TextBlob的核心是一个`TextBlob`对象,它包含了多个用于文本分析的方法。例如,要进行基本的文本分析,如分词,您可以这样使用:

```python

from textblob import TextBlob

# 创建TextBlob对象

text = "TextBlob is amazingly simple to use. What great fun!"

blob = TextBlob(text)

# 分词

words = blob.words

print(words)

```

这将输出文本中的单词列表:`['TextBlob', 'is', 'amazingly', 'simple', 'to', 'use', 'What', 'great', 'fun']`。这只是TextBlob强大功能的冰山一角,接下来我们将深入了解如何进行更复杂的文本分析和处理。

# 2. TextBlob基本文本处理

在当今的数据驱动时代,文本数据无处不在。无论是社交媒体上的评论,还是新闻报道,亦或是消费者反馈,文本数据都包含着丰富的信息和洞见。然而,原始文本数据通常杂乱无章,需要经过一系列的处理才能变得有用。TextBlob是一个强大的Python库,专为文本处理和自然语言处理(NLP)任务设计。本章我们将深入探讨TextBlob的基本文本处理功能,包括文本清洗与预处理、文本分析工具使用以及基础文本分析的实际案例。

## 2.1 文本清洗与预处理

### 2.1.1 分词(Tokenization)

在开始任何文本分析之前,第一步总是文本清洗与预处理。TextBlob提供了简单且直接的方法来进行这项任务。分词(Tokenization)是指将文本分割成单词、短语或其他有意义的片段(称为tokens)的过程。

```python

from textblob import TextBlob

# 示例文本

text = "TextBlob is amazingly simple to use."

# 创建TextBlob对象

blob = TextBlob(text)

# 分词输出

print(blob.words)

```

TextBlob的分词功能会自动处理标点符号,将其视为分隔符,从而将句子分割成单词列表。在上述代码中,`blob.words` 将输出 `['TextBlob', 'is', 'amazingly', 'simple', 'to', 'use']`。

### 2.1.2 去除停用词(Stop Words Removal)

停用词是指在文本处理中经常被去除的一些常见词汇,如“and”, “the”, “is”, “in”等。这些词通常对文本分析任务的贡献不大,而且频繁出现可能会影响分析结果。

```python

# 去除停用词

filtered_words = [word for word in blob.words if word not in blob.DefaultAnalyzer().stopwords]

print(filtered_words)

```

上述代码使用列表推导式结合了TextBlob的停用词列表,将停用词从分词结果中过滤掉。`filtered_words` 将输出 `['TextBlob', 'amazingly', 'simple', 'use']`,注意"to"和"is"被移除了。

## 2.2 文本分析工具使用

### 2.2.1 词性标注(Part-of-Speech Tagging)

词性标注是指自动识别文本中每个单词的词性(名词、动词、形容词等),这项任务对于深入理解文本内容至关重要。

```python

# 词性标注输出

print(blob.tags)

```

输出结果将是一个包含单词和相应词性标签元组的列表,如 `[('TextBlob', 'NNP'), ('is', 'VBZ'), ('amazingly', 'RB'), ('simple', 'JJ'), ('to', 'TO'), ('use', 'VB')]`,其中'NNP'代表专有名词,'VBZ'是第三人称单数动词,'RB'是副词,'JJ'是形容词,'TO'是不定式标记,'VB'是动词基本形式。

### 2.2.2 句法树分析(Parsing and Sentence Structure)

句法树分析用于分析句子的句法结构,它通过创建一棵树来表示句子中单词之间的句法关系。

```python

# 句法树分析

print(blob.parse())

```

该代码将输出一个句法树,它将句子分解为多个成分,每个成分下面可能会有子成分,直到达到单词(术语为叶节点)。

## 2.3 实际案例:基础文本分析

### 2.3.1 分析简单文本数据集

为了理解如何在实际数据集上使用TextBlob进行基础文本分析,让我们考虑一个简单的文本数据集。以下是一个包含几个句子的列表。

```python

texts = [

"TextBlob is great for processing textual data.",

"It's user-friendly and makes NLP tasks simple.",

"TextBlob's API is well-documented and easy to use."

]

# 对每个文本进行分词和词性标注

for text in texts:

blob = TextBlob(text)

print(f"\nOriginal text: {text}")

print(f"Tokens: {blob.words}")

print(f"Part-of-speech tags: {blob.tags}")

```

通过运行这段代码,我们可以得到每个文本的分词和词性标注结果,这为深入分析文本提供了基础。

### 2.3.2 结果可视化展示

虽然TextBlob专注于文本处理和分析,但我们可以将结果输出到如Matplotlib这样的库中进行可视化,以便更好地理解数据。

```python

import matplotlib.pyplot as plt

# 统计每种词性的出现次数

pos_tags = [tag for text in texts for word, tag in TextBlob(text).tags]

tag_counts = {}

for tag in pos_tags:

tag_counts[tag] = tag_counts.get(tag, 0) + 1

# 绘制词性分布图

plt.bar(tag_counts.keys(), tag_counts.values())

plt.xlabel('Part-of-Speech Tags')

plt.ylabel('Frequency')

plt.title('Frequency of Part-of-Speech Tags')

plt.show()

```

这段代码首先统计了数据集中每个词性的出现频率,然后使用Matplotlib绘制了一个条形图来可视化这些频率。

通过本章节的介绍,我们了解了TextBlob在基本文本处理方面的强大功能,包括分词、去除停用词、词性标注和句法树分析。我们还探讨了如何处理实际数据集,并将分析结果可视化展示。通过这些步骤,我们为理解更复杂的NLP任务打下了坚实的基础。

在下一章中,我们将深入了解TextBlob的情感分析功能,探索如何利用它来分析文本的情感色彩。

# 3. ```markdown

# 第三章:TextBlob情感分析基础

## 3.1 情感分析理论基础

### 3.1.1 情感分析概述

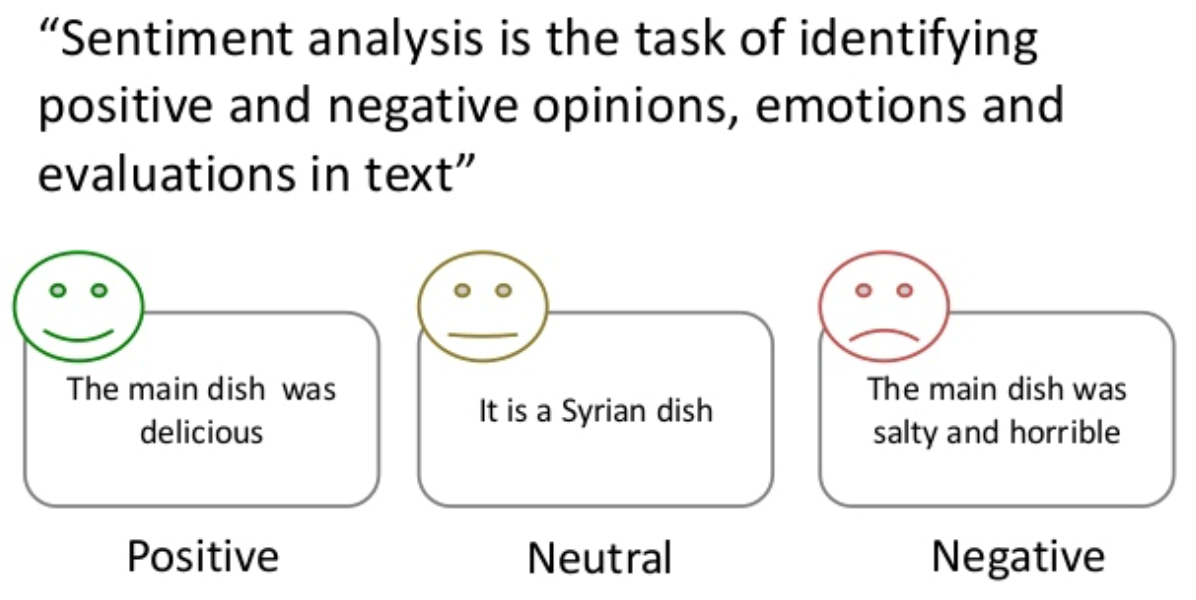

情感分析(Sentiment Analysis)

```

0

0