R语言处理不平衡数据集:tree包高级应用策略详解

发布时间: 2024-11-02 02:54:38 阅读量: 20 订阅数: 22

# 1. 不平衡数据集的挑战与tree包概述

在机器学习与数据挖掘领域,不平衡数据集的处理是一个常见的挑战。不平衡数据集指的是数据集中各类样本分布极不均衡,通常表现为某一类或几类样本数量远多于其他类。这种数据分布的不平衡会对学习算法产生偏差,导致模型对少数类的预测性能不佳。

为了应对这一挑战,学术界和工业界提出了多种处理不平衡数据的技术和方法。在R语言中,`tree`包提供了一种基于树模型的方法来处理不平衡数据,它通过特定的决策树构建技术,改善了对少数类的识别能力。`tree`包的简易性和灵活性,使得它成为处理不平衡数据集时的有力工具。

在本章中,我们首先介绍不平衡数据集对机器学习模型的影响,然后概述`tree`包的基本功能和在处理不平衡数据集时的优势,为读者理解后续章节的内容打下基础。接下来的章节将深入探讨如何应用`tree`包进行不平衡数据集的处理,包括参数调整、与其他技术的混合策略以及在实际案例中的应用和评估。

# 2. 不平衡数据处理的理论基础

在了解不平衡数据处理的理论基础之前,我们需要先理解什么是不平衡数据,以及它对模型的影响。然后,我们将探讨处理不平衡数据的常用方法,以及tree包在处理这些数据时的优势。

### 2.1 不平衡数据的产生与影响

#### 2.1.1 数据不平衡的定义

数据不平衡是指在分类问题中,类别间的样本数量不平等。通常在数据集中,一个类别的样本数量远远超过另一个或多个类别。比如在欺诈检测中,非欺诈的交易远远多于欺诈交易。这种不平等的比例可能会对机器学习模型产生显著影响。

#### 2.1.2 数据不平衡对模型的影响

不平衡数据会导致机器学习模型在预测时倾向于预测多数类。这可能会导致模型对少数类的识别效果非常差,因为模型的学习过程受多数类的影响较大。在某些极端情况下,即使所有的样本都预测为多数类,模型也能得到很高的准确度,但这对于实际应用并没有意义。

### 2.2 处理不平衡数据的常用方法

为了处理不平衡数据,研究人员和从业者们开发了多种技术,下面将介绍三种常用的方法。

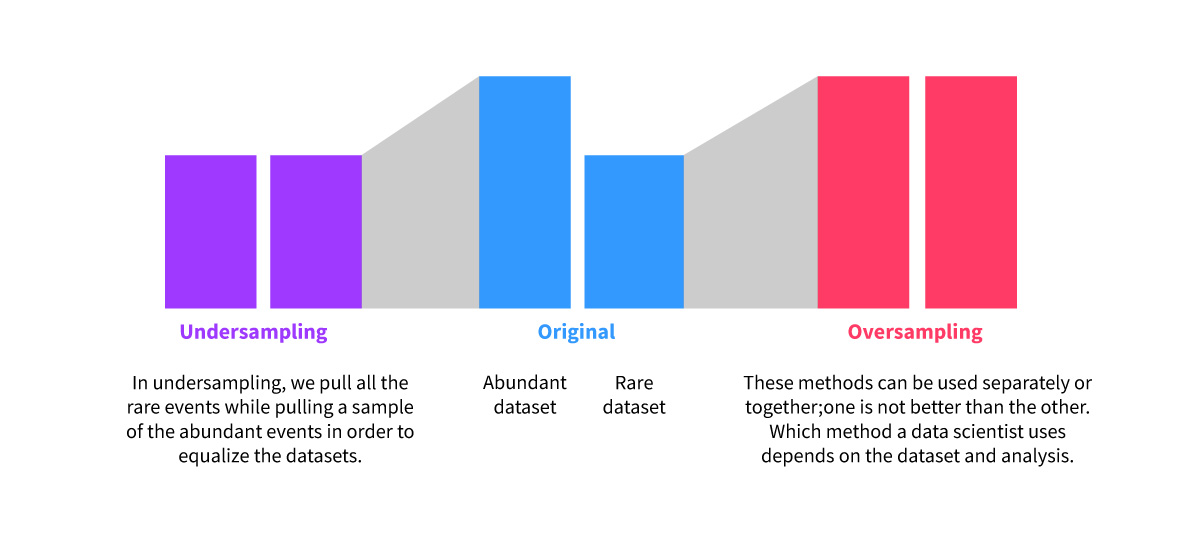

#### 2.2.1 重采样技术

重采样技术包括过采样和欠采样。过采样是增加少数类的样本数量,而欠采样是减少多数类的样本数量。这样做的目的是为了使每个类别拥有大致相等的样本量,以期望模型能更好地学习。

#### 2.2.2 集成学习方法

集成学习方法,如随机森林和Adaboost,可以集成多个模型来提高预测性能。在不平衡数据处理中,集成学习方法通过构建多个模型来关注不同的数据子集,或者在训练过程中动态调整错误分类样本的权重。

#### 2.2.3 成本敏感学习

成本敏感学习是通过修改学习算法,使之对不同类别的错误分类赋予不同的权重。在训练模型时,给少数类更高的错误分类成本,这样模型在学习时会更倾向于准确预测少数类。

### 2.3 tree包与不平衡数据处理

tree包是R语言中的一个广泛使用的分类与回归树(CART)实现。它在处理不平衡数据方面有其独特的优势。

#### 2.3.1 tree包的介绍

tree包能够构建简单的分类树和回归树,并提供了灵活的参数设置以适应不同的数据集和应用场景。它的实现简洁,对用户友好,是许多数据科学家在处理分类问题时的首选工具。

#### 2.3.2 tree包处理不平衡数据的优势

tree包在处理不平衡数据时,有天然的优势,因为它允许自定义权重,这可以帮助模型在训练过程中对少数类给予更多的关注。同时,tree包的交叉验证和剪枝功能也有助于避免过拟合和提升模型的泛化能力。

通过下一章将深入了解如何调整tree包的参数以及它在实际数据集中的应用,我们会进一步探讨如何利用tree包优化不平衡数据的处理。

# 3. tree包的高级应用策略

## 3.1 tree包的参数调整与优化

### 3.1.1 控制树的深度与分支

在使用tree包进行决策树模型训练时,控制树的深度和分支是防止过拟合的关键步骤。在R语言中,我们可以通过设置`control`参数来达成这一目的。例如,我们可以使用`tree.control`函数来设定树的最大深度(`nmax`)、分支所需的最小样本数(`mindev`)以及节点停止分割的最小偏差(`mincut`)等参数。

以下是`tree.control`函数使用的一个示例:

```r

# 设定树的控制参数

my.control <- tree.control(nobs = length(y), mindev = 0.001, minsize = 20)

# 使用调整后的参数拟合决策树模型

tree_model <- tree(response ~ ., data = training_data, control = my.control)

```

在上述代码块中,`mindev`被设定为0.001,意味着一个节点的不纯度如果降低不到0.001,则不会再进行分割。`minsize`参数设为20,说明每个叶节点至少需要20个样本。这些参数的调整可以帮助我们构建一个既不过于复杂也不过于简单的模型,确保模型具有良好的泛化能力。

### 3.1.2 权重与惩罚项的调整

在处理不平衡数据时,给予少数类别更高的权重是一个有效的策略,这可以通过在模型拟合时调整`weights`参数来实现。在tree包中,可以为不同类别的数据指定不同的权重,这样模型在进行分割时会更加关注少数类别的错误分类成本。

```r

# 假设data中包含类别变量class,少数类别为1

# 定义类别权重

class_weights <- ifelse(data$class == 1, 3, 1) # 少数类别权重为3

# 使用权重拟合决策树模型

tree_model_weighted <- tree(response ~ ., data = data, weights = class_weights)

```

在这个示例中,我们赋予了少数类别3倍的权重,这意味着在分割节点时,减少少数类别的错误分类对于成本函数的贡献更大,从而有助于改善模型对少数类别的识别能力。

## 3.2 非标准tree方法的实现

### 3.2.1 多重树模型的构建

在某些情况下,单个决策树可能无法满足需求,特别是在处理高度不平衡的数据集时。此时,构建多个树并整合它们的预测结果,可以提升模型的性能。多重树模型(如随机森林、梯度提升树等)通过结合多个树的预测来提高准确性和稳定性。

下面是一个多重树模型的示例代码,使用了`randomForest`包来构建随机森林模型:

```r

# 加载randomForest包

library(randomForest)

# 构建随机森林模型

rf_model <- randomForest(response ~ ., data = training_

```

0

0