聚类分析中的自组织映射(SOM):数据分组的利器

发布时间: 2024-08-21 06:55:12 阅读量: 45 订阅数: 50

自组织映射网络 ——python实现SOM(用于聚类)

# 1. 自组织映射(SOM)的理论基础

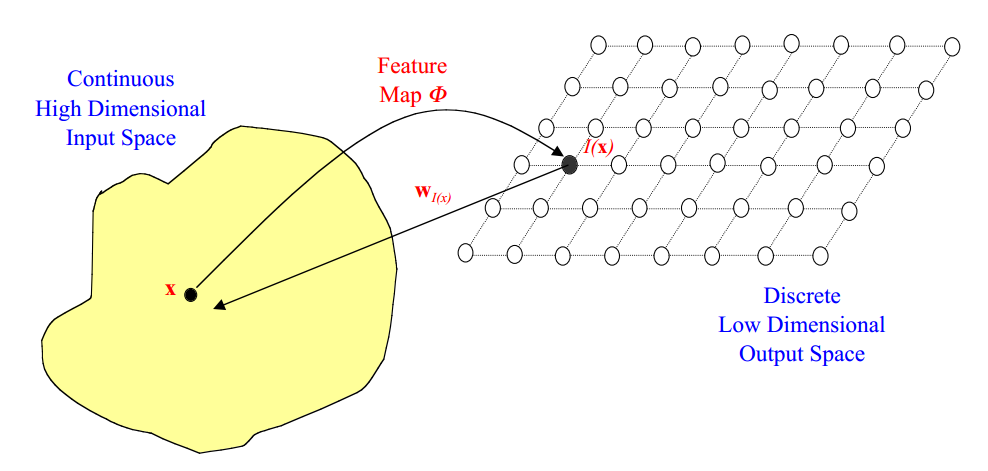

自组织映射(SOM)是一种非监督学习算法,旨在将高维数据映射到低维空间中,同时保留数据之间的拓扑关系。它由芬兰教授 Teuvo Kohonen 于 1982 年提出,也被称为科洪网络。

SOM 的理论基础基于竞争学习和拓扑保持。竞争学习是指神经元之间竞争以激活,只有最接近输入数据的那个神经元才能激活。拓扑保持是指神经元之间的拓扑关系在映射过程中被保留,即相邻神经元在高维空间中也相邻。

# 2. SOM算法的实现和优化

### 2.1 SOM算法的原理和步骤

自组织映射算法(SOM)是一种无监督学习算法,其灵感源自人脑皮层中神经元的自组织特性。SOM算法的基本原理是将高维输入数据映射到一个低维(通常为二维)的网格结构中,称为自组织映射。

SOM算法的步骤如下:

1. **初始化:**初始化一个网格结构,每个网格单元由一个权重向量表示。权重向量的大小与输入数据的维度相同。

2. **输入:**向SOM网络输入一个数据样本。

3. **竞争:**计算每个网格单元与输入样本之间的距离。选择距离最小的网格单元作为获胜单元。

4. **合作:**更新获胜单元及其周围网格单元的权重向量,使其更接近输入样本。

5. **重复:**重复步骤2-4,直到算法收敛或达到预定的迭代次数。

### 2.2 SOM算法的实现方法

SOM算法有多种实现方法,常用的方法包括:

- **批处理SOM:**一次性处理所有训练数据,然后更新权重向量。

- **在线SOM:**逐个处理训练数据,并立即更新权重向量。

- **迷你批处理SOM:**将训练数据分成小批次,然后逐批处理,更新权重向量。

### 2.3 SOM算法的优化策略

为了提高SOM算法的性能,可以采用以下优化策略:

- **学习率:**学习率控制权重向量的更新幅度。较高的学习率可以加速收敛,但可能导致不稳定。较低的学习率可以提高稳定性,但会减慢收敛速度。

- **邻域半径:**邻域半径控制受获胜单元影响的网格单元的数量。较大的邻域半径可以产生更平滑的映射,但可能会降低局部细节。较小的邻域半径可以提高局部细节,但可能会导致映射不连续。

- **学习率衰减:**学习率衰减策略随着时间的推移降低学习率。这有助于算法在训练初期快速收敛,然后逐渐细化映射。

- **邻域半径衰减:**邻域半径衰减策略随着时间的推移减小邻域半径。这有助于算法在训练初期捕获全局特征,然后逐渐关注局部细节。

**代码块:**

```python

import numpy as np

class SOM:

def __init__(self, input_dim, map_size, learning_rate=0.1, neighbor_radius=1):

self.input_dim = input_dim

self.map_size = map_size

self.learning_rate = learning_rate

self.neighbor_radius = neighbor_radius

self.weights = np.random.rand(map_size[0], map_size[1], input_dim

```

0

0