TensorFlow与PyTorch深度对比:反向传播算法在框架中的实现分析

发布时间: 2024-09-04 04:12:12 阅读量: 153 订阅数: 51

深度学习框架pytorch入门与实践源代码.rar

# 1. 深度学习框架概述与反向传播基础

## 1.1 深度学习框架的发展背景

深度学习框架的发展源自于对机器学习任务中复杂运算和模型构建的简化需求。随着计算能力的提升和数据量的增加,传统的编程方法已不足以高效地实现和测试复杂的神经网络。因此,出现了TensorFlow、PyTorch等深度学习框架,它们提供了抽象层来处理张量运算,并通过自动微分简化了模型训练过程。

## 1.2 反向传播算法的重要性

在深度学习中,反向传播算法是一种核心算法,用于优化神经网络的权重。通过计算损失函数相对于权重的梯度,反向传播算法使得网络能够利用梯度下降等优化方法自动调整权重,从而最小化模型的预测误差。理解反向传播是掌握深度学习技术的关键一环。

## 1.3 反向传播的数学基础

反向传播算法的核心是链式法则,它在数学上定义了复合函数导数的计算方式。在神经网络的上下文中,链式法则用于计算损失函数关于每个权重的梯度。这个过程涉及前向传播的输出以及通过激活函数的计算。理解这些数学原理对于深度学习的从业者来说至关重要,因为它们是框架内部机制和算法优化的基础。

# 2. TensorFlow实现反向传播算法

## 2.1 TensorFlow基础回顾

### 2.1.1 TensorFlow的安装和配置

为了开始使用TensorFlow,我们首先需要在我们的系统上安装它。TensorFlow提供了一系列的安装选项来满足不同用户的需求。对于大多数用户来说,推荐使用Python的包管理工具`pip`进行安装,因为它简化了安装过程并且支持多种操作系统。

安装TensorFlow可以通过多种方式,但最简单的是使用Python的包管理器pip。打开终端或命令提示符,然后使用以下命令之一进行安装,具体取决于你的CPU或GPU硬件配置:

对于仅使用CPU的版本:

```bash

pip install tensorflow

```

对于需要GPU支持的版本(假设你已经有了CUDA Toolkit和cuDNN库):

```bash

pip install tensorflow-gpu

```

安装完成后,你可以通过运行Python并尝试导入`tensorflow`模块来验证安装是否成功:

```python

import tensorflow as tf

print(tf.__version__)

```

如果以上命令没有抛出错误,并且打印出了版本号,则表示TensorFlow已经成功安装。

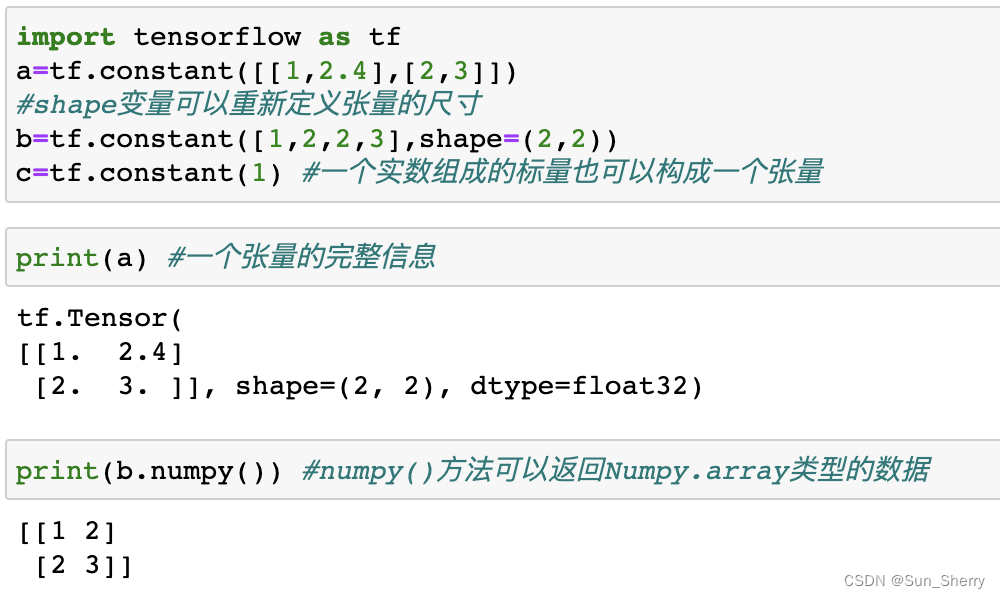

### 2.1.2 TensorFlow的数据结构和计算图

TensorFlow使用称为张量的数据结构来存储数据。张量可以被看作是多维数组,其中最基本的数据类型是`tf.float32`。数据在TensorFlow程序中是在计算图中流转的,计算图是一个有向图,其中节点代表操作(如加法、乘法、卷积等),边代表在节点间流动的数据(即张量)。

一个计算图通常包括以下几个部分:

- 张量(Tensor):基础数据单元。

- 操作(Operation):计算图中的节点,执行数据处理。

- 变量(Variable):在多次运行图时可以保持状态和值的特殊操作。

- 占位符(Placeholder):用于输入外部数据的操作。

以下是一个简单的示例,展示了如何创建一个计算图,并运行它:

```python

import tensorflow as tf

# 创建常量张量

a = tf.constant(2.0)

b = tf.constant(3.0)

# 创建一个操作,计算两个常量张量的和

c = a + b

# 创建一个会话来运行计算图

sess = ***pat.v1.Session()

# 启动图并运行操作c

print(sess.run(c))

# 关闭会话以释放资源

sess.close()

```

由于从TensorFlow 2.x版本开始,默认启用即时执行(Eager Execution),所以你可以直接使用Python运算,不需要显式地创建会话。上述代码可以简化为:

```python

import tensorflow as tf

# 创建常量张量

a = tf.constant(2.0)

b = tf.constant(3.0)

# 使用Python运算符直接计算两个常量张量的和

c = a + b

# 由于启用了即时执行,可以直接打印结果

print(c.numpy())

```

启用即时执行模式可以简化代码的编写,使得代码更加直观和易于调试。

# 3. PyTorch实现反向传播算法

## 3.1 PyTorch基础回顾

### 3.1.1 PyTorch的安装和配置

在开始使用PyTorch之前,首先需要完成框架的安装和配置。PyTorch可以通过Python的包管理工具pip进行安装,也可以通过conda来安装,后者特别适用于包含CUDA支持的版本,以加速在GPU上的运算。

通过pip安装PyTorch的命令如下:

```bash

pip3 install torch torchvision torchaudio

```

如果需要安装特定版本的PyTorch,可以访问PyTorch官方网站获取详细的安装命令。对于想要利用GPU计算能力的用户,可以通过conda安装带有CUDA支持的PyTorch版本:

```bash

conda install pytorch torchvision torchaudio cudatoolkit=YOUR_CUDA_VERSION -c pytorch

```

确保替换`YOUR_CUDA_VERSION`为你的CUDA版本号。

### 3.1.2 PyTorch的数据结构和动态计算图

PyTorch的核心优势之一是其提供的动态计算图(也称为即时执行模式),这与TensorFlow等框架中的静态图(定义后执行)形成了鲜明对比。动态计算图允许开发者在Python代码中以流程化的方式构建模型,每个操作都即时执行,使代码更直观和易于调试。

PyTorch中的基础数据结构是张量(`torch.Tensor`),类似于NumPy中的ndarray,但可以进行GPU加速计算。在PyTorch中,几乎所有的操作都会返回一个新的张量对象,通过链式法则来构建复杂的计算流程。

示例代码:

```python

import torch

# 创建一个张量

a = torch.tensor([1., 2., 3.])

b = torch.tensor([4., 5., 6.])

# 对张量进行操作

c = a + b

print(c) # 输出: tensor([5., 7., 9.])

```

## 3.2 PyTorch中反向传播的原理与实践

### 3.2.1 反向传播算法的理论基础

反向传播算法是深度学习中训练神经网络的核心技术,其核心思想是通过链式法则计算损失函数关于网络参数的梯度。在PyTorch中,这一过程被自动处理,开发者只需要定义损失函数和优化器。

### 3.2.2 PyTorch的自动微分与梯度计算

PyTorch内部实现了自动微分机制,即`torch.autograd`模块,它能够在计算图中自动计算梯度。当定义好一个计算图后,通过调用`.backward()`方法,PyTorch能够自动地计算出所有的梯度,从而更新网络的权重。

```python

# 定义一个简单的线性模型

w = torch.randn(1, requires_grad=True)

b = torch.randn(1, requires_grad=True)

# 输入数据和标签

x = torch.randn(5, 1)

y = 2 * x + 1 + torch.randn(5, 1)

# 定义损失函数和优化器

def loss_fn(y_pred, y):

return ((y_pred - y) ** 2).mean()

optimizer = torch.optim.SGD([w, b], lr=0.1)

# 训练过程

for epoch in range(100):

# 前向传播

y_pred = w * x + b

# 计算损失

l = loss_fn(y_pred, y)

# 反向传播

l.backward()

# 更新参数

optimizer.step()

# 清零梯度

optimizer.zero_grad()

print(f"Epoch {epoch+1}, Loss: {l.item()}")

```

### 3.2.3 实例:用PyTorch构建简单的神经网络

在下面的示例中,我们将使用PyTorch构建一个简单的全连接神经网络,并训练它来学习 XOR 函数,这是一个经典的非线性问题。

```python

import torch

import torch.nn as nn

import torch.optim a

```

0

0