正向与反向传播算法大比拼:深度解析其差异与联系

发布时间: 2024-09-04 03:53:03 阅读量: 38 订阅数: 41

# 1. 神经网络与反向传播基础

在人工智能领域中,神经网络是构建和训练模型的重要技术。理解其基本原理对于设计和优化复杂的机器学习模型至关重要。本章将介绍神经网络的基本概念,以及它们如何通过反向传播算法来学习和优化自身。

## 什么是神经网络?

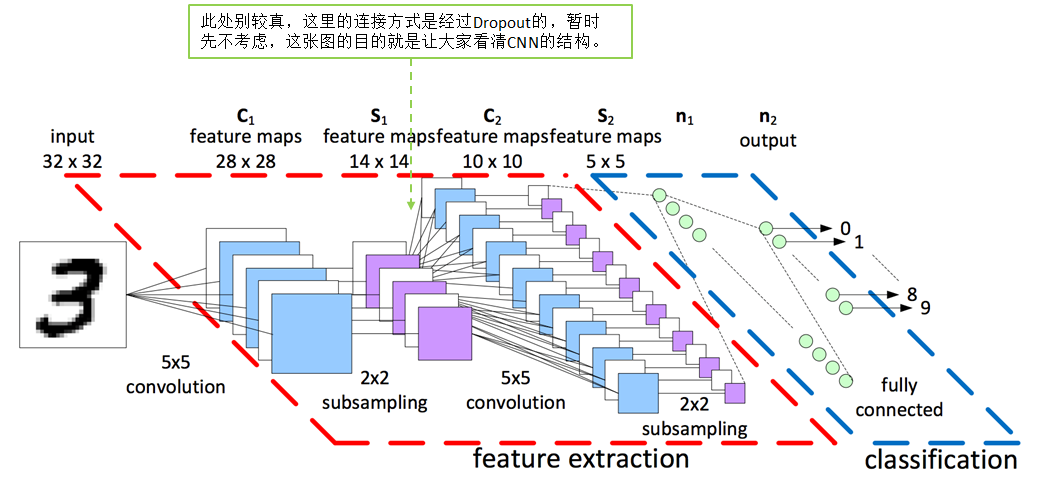

神经网络是一种受人类大脑启发的计算模型,由大量相互连接的节点组成,即“神经元”。这些神经元被组织成多个层次,包括输入层、隐藏层和输出层。通过学习数据中的模式,神经网络能够进行分类、预测和特征提取等任务。

## 反向传播算法的作用

反向传播是训练神经网络的核心算法,它利用链式法则计算损失函数关于网络参数的梯度。通过这个过程,算法能够调整网络权重,使得模型的预测误差逐步减小。简而言之,它使神经网络能够学习数据中的复杂模式,并逐步提升性能。

# 2. 正向传播的原理与实践

## 2.1 正向传播在神经网络中的作用

正向传播是神经网络中数据流动的基本方式,它从输入层开始,逐层传递至输出层。这种机制对理解数据在神经网络中的流向至关重要。

### 2.1.1 输入层到隐藏层的信号传递

在神经网络中,输入层作为接收外部数据的起始点,其节点数通常对应于问题的特征数量。隐藏层则负责处理和传递输入层数据,通过加权和以及激活函数的处理,数据被转换成新的形式,并传递到下一层。

信号传递的过程可以用以下伪代码表示:

```python

# 假设输入数据input_data是一个长度为N的向量

for each neuron in hidden_layer:

weighted_sum = 0

for each input in input_data:

weighted_sum += input * weight связанные с input

output = activation_function(weighted_sum)

# ...继续传递到下一层或输出层

```

激活函数的选择(如Sigmoid, ReLU等)会影响数据的非线性变换结果,进一步增强网络模型的表示能力。

### 2.1.2 激活函数的类型及应用

激活函数是正向传播中的关键组成部分,负责引入非线性因素。Sigmoid、Tanh和ReLU是最常见的激活函数。选择正确的激活函数对于模型的性能至关重要。

以ReLU激活函数为例,其表达式可以写为:

```python

def relu(x):

return max(0, x)

```

ReLU函数在正区域是线性的,而在负区域则是非激活的。这种简单的非线性特性使得ReLU在某些场合下相比于Sigmoid和Tanh具有优势,例如在深度网络中加速收敛。

## 2.2 正向传播算法详解

### 2.2.1 神经网络前向计算步骤

前向计算是神经网络完成一次预测或分类任务的过程,可以分解为以下几个步骤:

1. 初始化输入层数据。

2. 计算输入层至隐藏层的加权和。

3. 应用激活函数得到隐藏层输出。

4. 重复上述过程,直至达到输出层。

5. 计算输出层的最终结果。

### 2.2.2 正向传播中的权重更新

在正向传播中,权重更新不是主要目的,但它是确保模型能够学习的基础。权重的更新通常在反向传播之后进行,但了解权重是如何在正向传播中被使用的对于理解神经网络的完整学习过程是必要的。

权重更新的伪代码示例如下:

```python

# 假设input_data和target是训练样本的数据和标签

output = forward_propagation(input_data)

error = calculate_error(output, target)

new_weights = update_weights(error)

```

## 2.3 正向传播的优化策略

### 2.3.1 损失函数的选择与影响

损失函数衡量模型预测值与真实值之间的差异。常见的损失函数包括均方误差(MSE)、交叉熵损失等。正确的损失函数可以指导模型优化,提升预测准确度。

以均方误差为例,其计算公式为:

```python

def mse_loss(output, target):

return ((output - target)**2).mean()

```

### 2.3.2 优化算法:SGD与Adam

在正向传播后,优化算法(例如随机梯度下降SGD、Adam)负责根据损失函数的梯度更新权重。SGD是最早的优化算法之一,而Adam算法则是一种较为先进的自适应学习率优化算法。

优化算法的更新步骤伪代码如下:

```python

for each epoch:

for each sample:

output = forward_propagation(sample)

error = calculate_error(output, sample.target)

gradients = compute_gradients(error)

new_weights = optimizer.update(weights, gradients)

```

Adam优化器结合了RMSprop和Momentum两种优化算法的优点,同时考虑了梯度的一阶矩估计(即均值)和二阶矩估计(即未中心化的方差)。

以上就是正向传播的原理与实践的详细介绍。通过对正向传播更深入的理解,我们可以更好地为反向传播打下坚实的基础。在下一章节中,我们将深入探讨反向传播的机制与应用。

# 3. 反向传播的机制与应用

## 3.1 反向传播的核心概念

### 3.1.1 错误信号的反向传播机制

在神经网络训练过程中,反向传播算法起着至关重要的作用。它的核心目标是通过网络误差反向传播,从而调整网络中每

0

0