大数据下的反向传播算法挑战:大规模数据集的算法表现

发布时间: 2024-09-04 04:07:41 阅读量: 153 订阅数: 45

大数据视角下的鲜花数据集分析

# 1. 反向传播算法简介

## 1.1 反向传播算法的起源与发展

反向传播算法是深度学习领域中的一项关键技术,它使得神经网络能够有效地从数据中学习。此算法最早出现在20世纪80年代,是梯度下降法的一种扩展,特别适用于多层网络。通过从输出层向输入层逐层反向传播误差,并更新网络权重,以达到降低整体误差的目的。

## 1.2 算法核心原理与步骤

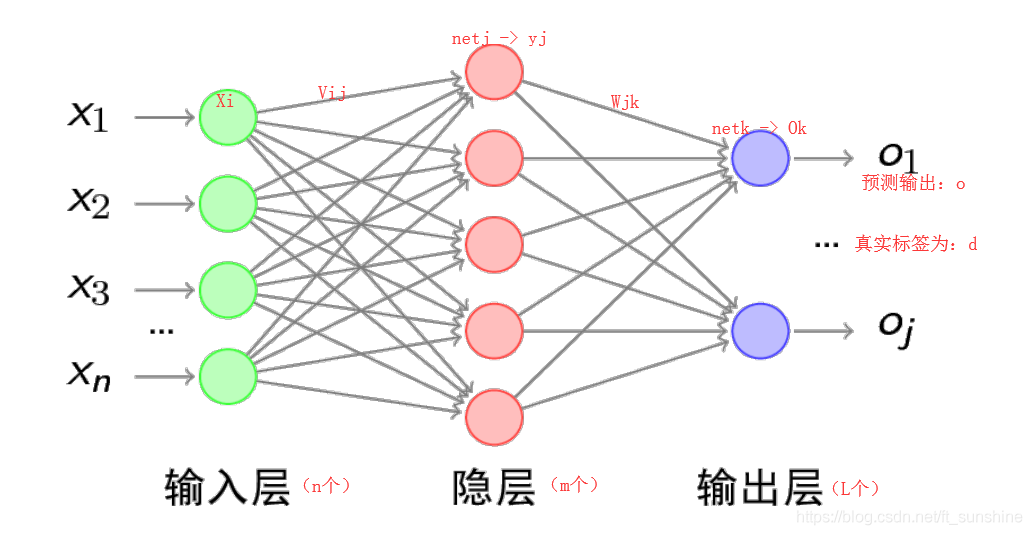

反向传播算法的核心在于链式法则,用于计算误差对各层权重的偏导数,即梯度。整个过程分为两个阶段:前向传播与误差反向传播。在前向传播阶段,输入数据经过各层神经元的加权求和与激活函数处理,直到最后一层产生输出。在误差反向传播阶段,通过计算输出误差,逐层递归计算误差对每层权重的影响,并据此更新权重,以最小化误差。

## 1.3 在现代AI中的地位

随着时间的推移,反向传播算法已经演变成多种变体,如随机梯度下降(SGD)和批量归一化等,这些改进使得算法更加稳定和高效。目前,它不仅是构建深度学习模型不可或缺的组成部分,也是推动人工智能快速发展的基石。

# 2. 大规模数据集的挑战

大规模数据集的处理在机器学习领域中一直是一个核心问题,尤其是对于深度学习和反向传播算法。数据集的规模直接关系到算法的学习能力和模型的泛化能力。但随着数据量的增加,也带来了诸多挑战,其中包括内存限制、计算资源需求、以及如何优化算法来适应大数据环境等问题。

### 2.1 数据集规模对算法性能的影响

#### 2.1.1 内存限制

在处理大规模数据集时,内存限制是一个不容忽视的问题。神经网络在训练过程中需要存储大量的参数和激活值,这很容易超出单个机器的内存限制。当数据集规模增长到一定程度时,可能会出现内存溢出(Out of Memory, OOM)错误,导致训练无法继续进行。

为了避免内存溢出,可以采取以下策略:

- 使用数据加载器(data loader),以小批量(minibatch)的形式加载数据,而不是一次性加载整个数据集。

- 减小批次大小(batch size),尽管这可能会增加收敛时间。

- 使用模型剪枝和权重共享技术,减少模型需要的内存。

- 利用半精度浮点数(例如,FP16)代替标准的单精度浮点数(FP32)来存储模型参数。

在Python中,可以使用`torch`库来处理大数据集,并通过设置`dtype`为`torch.float16`来减少内存消耗:

```python

import torch

# 假设我们有一个大型数据集

data_loader = torch.utils.data.DataLoader(

# ... 数据集配置

batch_size=64,

dtype=torch.float16 # 使用半精度浮点数

)

```

#### 2.1.2 计算资源需求

大规模数据集意味着需要更多的计算资源来进行模型训练。计算资源的需求主要体现在两个方面:CPU和GPU。大规模数据集的训练往往需要大量的并行计算能力,而GPU因其高度并行化的架构,成为了深度学习训练的理想选择。

在实践中,可以采取以下优化措施:

- 使用分布式训练框架,例如NVIDIA的NCCL(NVIDIA Collective Communications Library),以提高多GPU训练的效率。

- 实现数据并行性,即在多个GPU上复制模型,每个GPU处理数据的一个子集,并定期同步更新模型参数。

- 实现模型并行性,即将模型分布在多个GPU上,每个GPU负责模型的一部分。

### 2.2 算法优化的基本理论

#### 2.2.1 梯度下降策略

梯度下降是神经网络训练的核心算法,其基本思想是沿着损失函数的负梯度方向更新参数。当处理大规模数据集时,传统的梯度下降算法可能会变得低效,尤其是在内存和计算资源受限的情况下。为此,我们需要采用一些优化策略,例如小批量梯度下降(Mini-batch Gradient Descent),它可以平衡内存使用和计算效率。

小批量梯度下降的关键参数为:

- 批量大小(batch size):决定每次更新参数时所使用的样本数量。

- 学习率(learning rate):决定参数更新的步长。

```python

# 示例:使用PyTorch进行小批量梯度下降

model = ... # 初始化模型

optimizer = torch.optim.SGD(model.parameters(), lr=0.01) # 定义优化器

for epoch in range(num_epochs):

for data, target in data_loader:

optimizer.zero_grad() # 清零梯度

output = model(data) # 前向传播

loss = loss_function(output, target) # 计算损失

loss.backward() # 反向传播

optimizer.step() # 更新参数

```

#### 2.2.2 权重更新和正则化

在大规模数据集上,权重更新需要更加谨慎以防止过拟合。常用的技术包括权重衰减(L2正则化)和dropout。权重衰减通过在损失函数中加入权重的平方项来限制权重的大小,而dropout则通过在训练过程中随机丢弃一些神经元来减少模型对特定训练样本的依赖。

### 2.3 算法并行化的原理

#### 2.3.1 数据并行性

数据并行性是一种将数据集分割成更小的部分,并在多个计算单元上并行处理的方法。每个计算单元都有模型的一个副本,并独立地对数据子集进行前向和反向传播,然后将计算得到的梯度汇总并同步到主模型中。

数据并行性能够显著提高大规模数据集的训练效率,但是同步更新可能会引入通信开销。为了优化这一点,研究人员和工程师们开发了一些技术,如梯度累积(gradient accumulation)和异步更新(asynchronous update),来减少通信频率。

#### 2.3.2 模型并行性

模型并行性指的是将模型的不同部分分配到不同的计算单元上进行训练。当模型过于复杂,无法完全加载到单个计算单元的内存中时,模型并行性变得十分必要。

模型并行性的一个重要挑战是保证各部分之间的协调一致,尤其是对于需要全局同步的层(例如,全连接层或RNN)。对于这样的层,必须设计特殊的通信机制来确保数据可以正确地在不同计算单元之间传输。

通过本章节的介绍,我们将深入探讨大规模数据集带来的挑战,并提供了一系列理论和技术以应对这些挑战。在接下来的章节中,我们将进一步了解如何在实践中处理大规模数据集,以及如何优化算法以提升其在大规模数据上的性能。

# 3. 实践中的大规模数据处理

## 3.1 分布式计算框架

### 3.1.1 MapReduce模型

MapReduce是一种编程模型,用于大规模数据集的并行运算。在MapReduce模型中,任务被分解为两个阶段:Map和Reduce。在Map阶段,输入数据被处理成一系列中间键值对。在Reduce阶段,这些键值对根据键进行聚合,从而生成最终结果。

MapReduce模型特别适合于需要大量数据并行处理的场景,比如大规模数据集的排序、搜索和统计等。它的优势在于能够将计算任务有效地分布在多台机器上执行,从而大幅度提高处理速度和系统的可扩展性。

### 3.1.2 Spark与Hadoop的对比分析

尽管Hadoop是广为人知的分布式计算框架,但它并非没有局限。特别是在处理需要大量迭代计算的任务时(例如机器学习算法),Hadoop MapReduce的磁盘I/O操作成为瓶颈,导致性能下降。

Spark的出现,旨在解决这一问题。Spark在内存中处理数据,减少了磁盘I/O操作,使得数据处理速度大大提升,尤其在大数据量的迭代计算中表现优异。此外,Spark还提供了更丰富的数据处理操作和高级API

0

0