循环学习率优化策略:解决深度学习训练瓶颈的权威指南

发布时间: 2024-08-21 07:25:39 阅读量: 30 订阅数: 28

MATLAB深度学习工具箱:构建、训练和部署模型的全面指南

# 1. 循环学习率优化策略简介

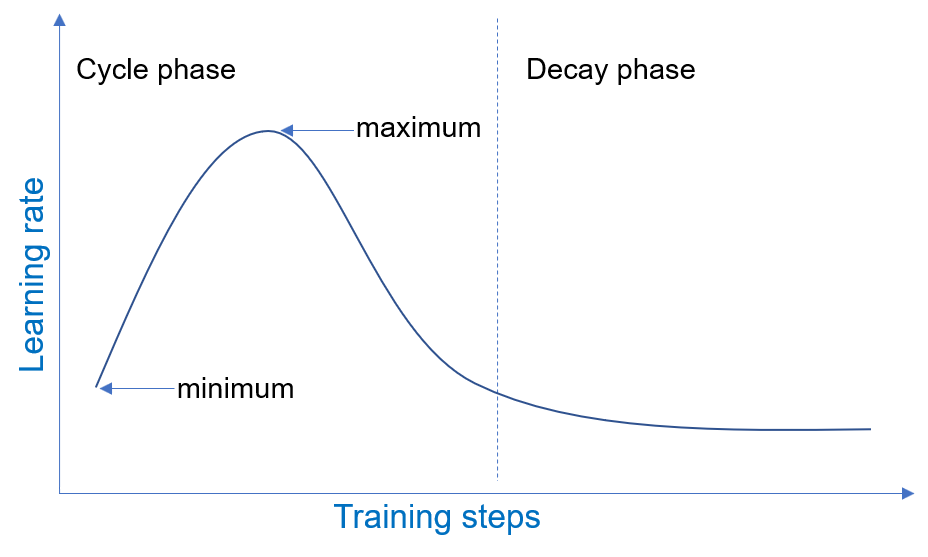

循环学习率优化策略是一种用于训练深度学习模型的优化策略。它通过周期性地调整学习率来提高训练效率和模型性能。与传统的单调递减学习率策略不同,循环学习率策略在训练过程中多次增加和减少学习率,从而避免陷入局部最优解并促进模型收敛。

循环学习率优化策略的优势包括:

- **更快的收敛速度:**通过周期性地增加学习率,循环学习率策略可以加快模型的收敛速度,从而缩短训练时间。

- **更好的泛化能力:**通过周期性地降低学习率,循环学习率策略可以防止模型过拟合,从而提高其泛化能力。

- **更鲁棒的训练:**循环学习率策略对超参数设置不那么敏感,这使得它在各种模型和数据集上都具有鲁棒性。

# 2. 循环学习率优化策略的理论基础**

## 2.1 循环学习率的原理和优势

循环学习率(CLR)是一种优化策略,它通过周期性地调整学习率来提高深度学习模型的训练性能。CLR的原理是基于这样一个假设:在训练过程中,学习率应该在较大的值和较小的值之间交替变化。

较大的学习率有助于模型快速收敛到一个局部最优值,而较小的学习率则有助于模型在局部最优值附近进行精细调整。通过周期性地调整学习率,CLR可以帮助模型避免陷入局部最优值,并最终找到全局最优值。

CLR的优势包括:

* **更快的收敛速度:**与传统的固定学习率优化器相比,CLR可以帮助模型更快地收敛到最优值。

* **更好的泛化能力:**CLR可以帮助模型获得更好的泛化能力,从而在未见过的测试数据上表现得更好。

* **更鲁棒的训练过程:**CLR可以使训练过程更加鲁棒,从而减少对超参数设置的敏感性。

## 2.2 不同循环学习率策略的比较

有几种不同的CLR策略,每种策略都有其独特的优点和缺点。最常见的CLR策略包括:

* **三角形CLR:**学习率在训练过程中呈三角形变化,从较大的值逐渐减小到较小的值,然后再逐渐增加到较大的值。

* **正弦CLR:**学习率在训练过程中呈正弦波变化,从较大的值逐渐减小到较小的值,然后再逐渐增加到较大的值。

* **余弦退火CLR:**学习率在训练过程中呈余弦函数变化,从较大的值逐渐减小到较小的值,但不再增加到较大的值。

* **分段CLR:**学习率在训练过程中被分成几个阶段,每个阶段都有不同的学习率。

选择最合适的CLR策略取决于模型和数据集的具体情况。一般来说,三角形CLR和正弦CLR适用于大多数情况,而余弦退火CLR和分段CLR则适用于更复杂的情况。

**代码块:**

```python

import numpy as np

import matplotlib.pyplot as plt

# 定义三角形CLR策略

def triangular_clr(num_iterations, max_lr, min_lr):

lr_range = max_lr - min_lr

lrs = [min_lr + (lr_range * i / num_iterations) for i in range(num_iterations)]

lrs.extend([max_lr - (lr_range * i / num_iterations) for i in range(num_iterations)])

return lrs

# 定义正弦CLR策略

def sinusoidal_clr(num_iterations, max_lr, min_lr):

lr_range = max_lr - min_lr

lrs = [min_lr + (lr_range * (np.sin(np.pi * i / num_iterations) + 1) / 2) for i in range(num_iterations)]

return lrs

# 绘制CLR策略

num_iterations = 100

max_lr = 0.1

min_lr = 0.001

triangular_lrs = triangular_clr(num_iterations, max_lr, min_lr)

sinusoidal_lrs = sinusoidal_clr(num_iterations, max_lr, min_lr)

plt.plot(triangul

```

0

0