循环学习率优化策略:掌握深度学习训练的艺术

发布时间: 2024-08-21 07:45:32 阅读量: 21 订阅数: 28

基于深度学习设计与实现的产品设计系统项目源码(毕业设计)

# 1. 循环学习率优化策略概述**

循环学习率优化策略是一种迭代学习率优化技术,它在训练深度学习模型时动态调整学习率。该策略通过周期性地增加和降低学习率,帮助模型逃离局部最优解并找到更优的解。循环学习率优化策略已被证明可以提高模型的收敛速度和泛化能力。

# 2. 循环学习率优化策略的理论基础

### 2.1 梯度下降与学习率

在机器学习中,梯度下降是一种广泛使用的优化算法,用于最小化损失函数。它通过迭代更新模型参数来实现,每次更新都沿着负梯度方向移动一定步长,即学习率。

学习率是一个超参数,它控制着模型参数更新的幅度。较高的学习率可能导致模型快速收敛,但也有可能导致不稳定或发散。较低的学习率则可能导致模型收敛速度慢,甚至陷入局部最优。

### 2.2 循环学习率优化策略的原理

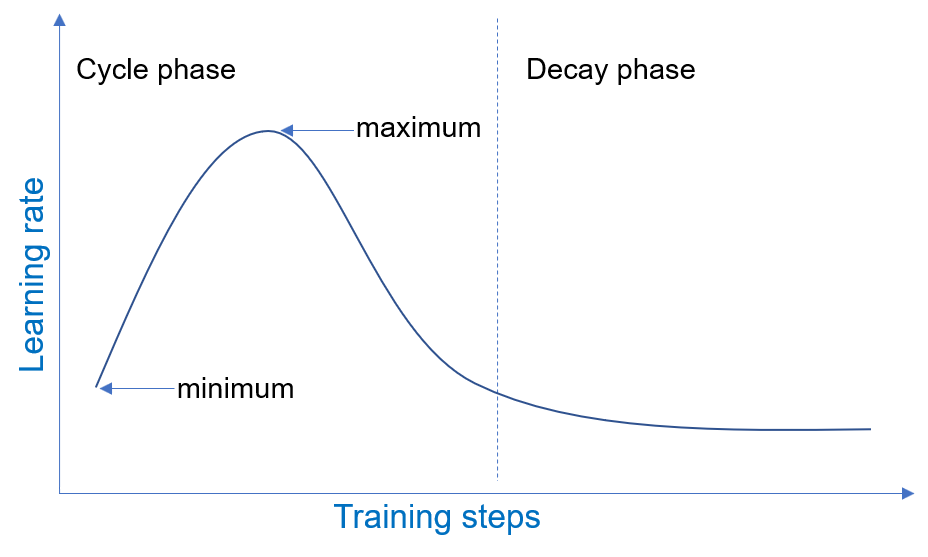

循环学习率优化策略(CLR)是一种改进的梯度下降算法,它通过周期性地调整学习率来提高模型性能。CLR的基本原理是:

- **热身阶段:**从一个较小的学习率开始,逐渐增加到一个较大的值。这有助于模型从初始状态中脱离,避免陷入局部最优。

- **循环阶段:**在达到最大学习率后,开始周期性地降低和增加学习率。这模拟了自然界中的退火过程,有助于模型探索不同的参数空间区域。

- **冷却阶段:**当达到预定的循环次数后,逐渐降低学习率,直至达到一个较小的值。这有助于模型在收敛时进行微调,提高精度。

**代码块:**

```python

import torch

import torch.optim as optim

from torch.optim.lr_scheduler import CyclicLR

# 定义模型和损失函数

model = torch.nn.Linear(10, 1)

loss_fn = torch.nn.MSELoss()

# 定义优化器和学习率调度器

optimizer = optim.SGD(model.parameters(), lr=0.01)

scheduler = CyclicLR(optimizer, base_lr=0.001, max_lr=0.1, step_size_up=2000, step_size_down=2000)

# 训练模型

for epoch in range(10):

# 训练模型

# ...

# 更新学习率

scheduler.step()

```

**逻辑分析:**

- `CyclicLR`调度器接受优化器、基本学习率、最大学习率、上升步长和下降步长作为参数。

- 上升步长和下降步长控制热身阶段和循环阶段的持续时间。

- 训练过程中,调度器会周期性地更新优化器的学习率,按照热身、循环和冷却阶段的顺序进行。

**参数说明:**

- `base_lr`:热身阶段的初始学习率。

- `max_lr`:循环阶段的最大学

0

0