循环学习率优化策略:提升深度学习模型性能的秘密

发布时间: 2024-08-21 07:56:43 阅读量: 22 订阅数: 28

深度学习实践-模型部署优化实践

# 1. 循环学习率优化策略概述**

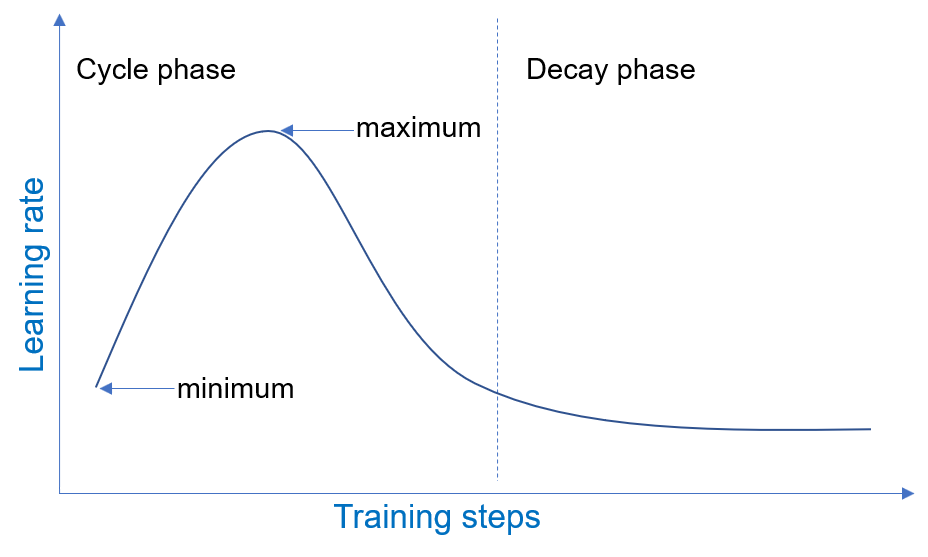

循环学习率优化策略是一种先进的优化算法,旨在提高深度学习模型的训练效率和性能。它通过周期性地调整学习率来克服传统梯度下降算法的局限性,从而实现更快的收敛速度和更好的泛化能力。

循环学习率策略的主要思想是,在训练过程中,学习率不是恒定的,而是根据预定义的模式进行变化。这种变化可以是正弦波、三角波或其他自定义模式。通过周期性地增加和降低学习率,循环学习率策略可以帮助模型逃离局部极小值,并探索更广泛的解决方案空间。

# 2. 循环学习率优化策略的理论基础

### 2.1 梯度下降算法的局限性

梯度下降算法是深度学习中广泛使用的优化算法,其目标是通过迭代地更新模型参数,使损失函数最小化。然而,梯度下降算法存在以下局限性:

- **局部最优:**梯度下降算法容易陷入局部最优,即找到一个局部最小值,而不是全局最小值。

- **学习率敏感性:**梯度下降算法对学习率非常敏感。学习率过大会导致不稳定或发散,而学习率过小会导致收敛速度慢。

- **震荡:**当学习率过大时,梯度下降算法可能会出现震荡,即在局部最优附近来回跳动。

### 2.2 循环学习率的原理和优势

循环学习率优化策略通过周期性地改变学习率来克服梯度下降算法的局限性。其原理如下:

- **初始高学习率:**循环开始时,学习率设置为一个较高的值,以快速探索搜索空间。

- **逐渐降低学习率:**随着循环的进行,学习率逐渐降低,以精细搜索局部最优。

- **周期性重启:**完成一个循环后,学习率重置为初始高值,并重新开始另一个循环。

循环学习率优化策略具有以下优势:

- **避免局部最优:**通过周期性地改变学习率,循环学习率策略可以跳出局部最优,并探索更广阔的搜索空间。

- **提高收敛速度:**较高的初始学习率可以加速收敛,而逐渐降低的学习率可以精细调整参数。

- **减少震荡:**周期性地重启学习率可以防止震荡,并稳定收敛过程。

```python

import numpy as np

def cyclic_learning_rate(num_epochs, initial_lr, end_lr):

"""

生成循环学习率列表。

参数:

num_epochs:训练的总轮数。

initial_lr:初始学习率。

end_lr:最终学习率。

返回:

学习率列表。

"""

lr_list = []

for epoch in range(num_epochs):

lr = initial_lr + (end_lr - initial_lr) * (epoch / num_epochs)

lr_list.append(lr)

return lr_list

```

**代码逻辑分析:**

该代码段实现了循环学习率的生成。它创建一个学习率列表,其中每个元素代表一个训练轮数的学习率。学习率从初始值逐渐增加到最终值,然后在完成一个循环后重置为初始值。

*

0

0