深度学习训练的秘密武器:循环学习率优化策略

发布时间: 2024-08-21 07:28:00 阅读量: 24 订阅数: 29

ssm-vue-校园代购服务订单管理系统-源码工程-32页从零开始全套图文详解-34页参考论文-27页参考答辩-全套开发环境工具、文档模板、电子教程、视频教学资源.zip

# 1. 深度学习训练基础

深度学习训练是一个复杂的过程,涉及到优化一个包含大量参数的模型。训练过程通常使用梯度下降算法,该算法通过迭代更新模型参数来最小化损失函数。

梯度下降算法的局限性之一是它可能会陷入局部最小值,从而导致模型性能不佳。循环学习率优化策略通过周期性地改变学习率来解决这个问题,从而帮助模型跳出局部最小值并找到更好的解。

# 2. 循环学习率优化策略

### 2.1 循环学习率的原理和优势

#### 2.1.1 梯度下降算法的局限性

梯度下降算法是深度学习中常用的优化算法,它通过迭代更新模型参数来最小化损失函数。然而,梯度下降算法存在以下局限性:

- **局部最优解:**梯度下降算法可能收敛到局部最优解,而不是全局最优解。

- **学习率选择困难:**学习率是梯度下降算法的一个关键超参数,选择过大或过小的学习率都会影响算法的收敛速度和准确性。

- **训练时间长:**梯度下降算法通常需要大量的迭代才能收敛,这可能导致训练时间较长。

#### 2.1.2 循环学习率如何解决梯度下降问题

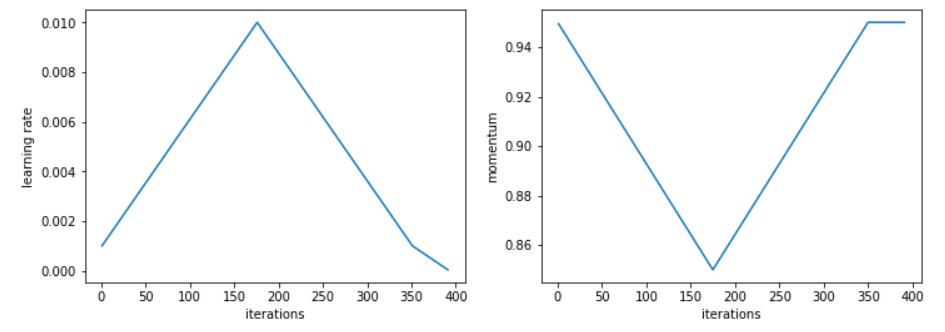

循环学习率(CLR)是一种优化策略,它通过周期性地改变学习率来解决梯度下降算法的局限性。CLR 的工作原理如下:

- **探索阶段:**在探索阶段,学习率从一个较小的值逐渐增加到一个较大的值。这有助于模型探索参数空间并找到潜在的局部最优解。

- **利用阶段:**在利用阶段,学习率从较大的值逐渐减小到较小的值。这有助于模型利用探索阶段找到的局部最优解并进一步优化它们。

- **重复循环:**CLR 重复探索和利用阶段的循环,直到达到预定的停止条件。

### 2.2 循环学习率的超参数设置

CLR 的超参数设置对于其性能至关重要。以下是一些关键超参数:

#### 2.2.1 学习率的初始值和最大值

学习率的初始值和最大值决定了探索和利用阶段的范围。较小的初始值有助于模型在探索阶段找到局部最优解,而较大的最大值有助于模型在利用阶段优化这些局部最优解。

#### 2.2.2 周期的数量和长度

周期的数量和长度决定了 CLR 的训练时间和性能。较多的周期可以提高模型的泛化能力,但也会增加训练时间。较长的周期可以帮助模型更深入地探索参数空间,但也会增加局部最优解的风险。

#### 2.2.3 学习率衰减策略

学习率衰减策略决定了学习率在探索和利用阶段如何变化。常见的策略包括线性衰减、指数衰减和余弦衰减。不同的衰减策略会影响模型的收敛速度和准确性。

### 2.3 循环学习率的变体

除了标准的 CLR,还有几

0

0