循环学习率优化策略:揭秘深度学习训练的魔法

发布时间: 2024-08-21 07:59:40 阅读量: 18 订阅数: 22

# 1. 循环学习率优化策略概述

循环学习率优化策略是一种通过周期性地调整学习率来提高深度学习模型训练性能的技术。它通过在训练过程中模拟学习率的自然衰减,有效地平衡了探索和利用,从而提升模型的泛化能力。

循环学习率优化策略的优势包括:

* 提高模型的泛化能力和鲁棒性

* 减少对超参数调整的敏感性

* 适用于各种深度学习模型和任务

# 2. 循环学习率优化策略的理论基础

### 2.1 学习率的本质和重要性

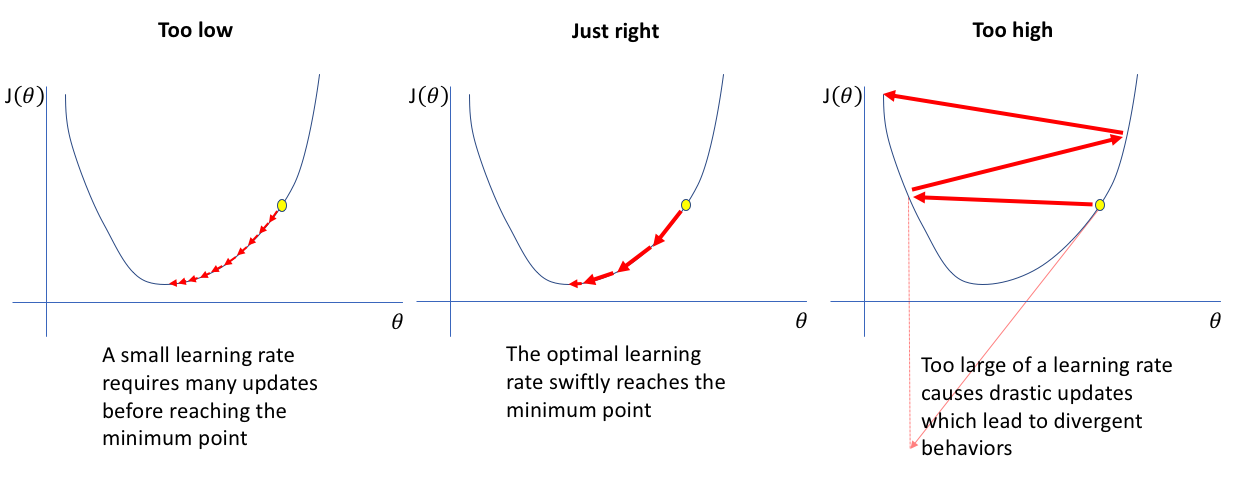

在机器学习中,学习率是一个超参数,它控制着模型在训练过程中更新权重的大小。学习率对于模型的训练效果至关重要,它决定了模型收敛的速度和最终的性能。

* **学习率过大:**会导致模型在训练过程中出现不稳定,甚至发散,无法收敛到最优解。

* **学习率过小:**会导致模型训练速度缓慢,甚至陷入局部最优解,无法达到最佳性能。

因此,选择一个合适的学习率对于模型的训练至关重要。

### 2.2 循环学习率优化策略的原理

循环学习率优化策略(CLR)是一种自适应学习率优化策略,它通过周期性地调整学习率来提高模型的训练效果。CLR 的原理如下:

* **学习率的周期性变化:**CLR 将学习率的调整过程分为多个周期,每个周期内学习率按照预先设定的规则变化。

* **学习率的递增和递减:**在每个周期内,学习率先从一个较小的值逐渐递增,达到一个峰值后,再逐渐递减。

* **周期性的重启:**在完成一个周期后,CLR 会将学习率重置为较小的值,然后重新开始下一个周期。

### 2.3 循环学习率优化策略的优势和局限性

**优势:**

* **提高训练速度:**CLR 通过周期性地调整学习率,可以帮助模型更快地收敛到最优解。

* **防止过拟合:**CLR 的递增学习率可以帮助模型探索更大的参数空间,从而防止过拟合。

* **提高泛化能力:**CLR 的递减学习率可以帮助模型在训练后期进行微调,提高模型的泛化能力。

**局限性:**

* **调参困难:**CLR 有多个超参数需要调参,包括周期长度、学习率范围等,调参过程比较困难。

* **可能不适用于所有模型:**CLR 并不是对所有模型都适用,对于一些模型,它可能会导致训练不稳定或性能下降。

**代码块:**

```python

import tensorflow as tf

# 定义循环学习率优化器

clr_optimizer = tf.keras.optimizers.schedules.CyclicLearningRate(

initial_learning_rate=0.001,

maximal_learning_rate=0.01,

step_size=2000,

mode='triangular'

)

# 编译模型

model.compile(optimizer=clr_optimizer, loss='mse')

```

**逻辑分析:**

这段代码定义了一个循环学习率优化器,其初始学习率为 0.001,最大学习率为 0.01,周期长度为 2000 步,模式为三角形。三角形模式表示学习率先从 0.001 逐渐递增到 0.01,达到峰值后,再逐渐递减回 0.001。

**参数说明:**

* `initial_learning_rate`:初始学习率

* `maximal_learning_rate`:最大学习率

* `step_size`:周期长度

* `mode`:学习率变化模式,可以是 'triangular'(三角形)、'square'(方形)或 'exponential'(指数)

# 3.1 循环学习率优化策略的调参技巧

**1. 学习率范围的确定**

学习率范围是循环学习率优化策略中最重要的超参数之一。它决定了学习率在循环中的变化幅度。学习率范围太小,可能导致学习过程收敛缓慢;学习率范围太大,可能导致模型不稳定或发散。

确定学习率范围的常见方法是使用学习率热身策略。学习率热身策略在训练开始时使用较小的学习率,然后逐渐增加学习率。这有助于模型在训练初期稳定下来,避免发散。

**2. 循环长度的确定**

循环长度是循环学

0

0