循环学习率优化策略:深度学习训练的变革性力量

发布时间: 2024-08-21 08:06:03 阅读量: 20 订阅数: 22

# 1. 循环学习率优化策略简介**

循环学习率优化策略是一种用于训练深度学习模型的优化算法。它通过周期性地改变学习率来提高模型的训练效率和泛化能力。与传统的学习率衰减策略不同,循环学习率优化策略在训练过程中多次增加和降低学习率,形成一个循环模式。

这种循环模式可以帮助模型逃逸局部最优解,探索更广阔的超参数空间。此外,它还可以防止模型过拟合,提高模型在不同数据集上的泛化能力。

# 2. 循环学习率优化策略的理论基础

### 2.1 循环学习率的原理和优势

循环学习率(CLR)是一种优化策略,它通过周期性地改变学习率来提高深度学习模型的性能。与传统的学习率衰减策略不同,CLR 采用一种基于余弦函数的学习率调度算法,在训练过程中多次增加和降低学习率。

CLR 的原理基于以下观察:

- **学习率的动态变化:**深度学习模型在训练过程中需要不同的学习率。在训练初期,需要较高的学习率以快速探索搜索空间。随着训练的进行,需要较低的学习率以微调模型参数。

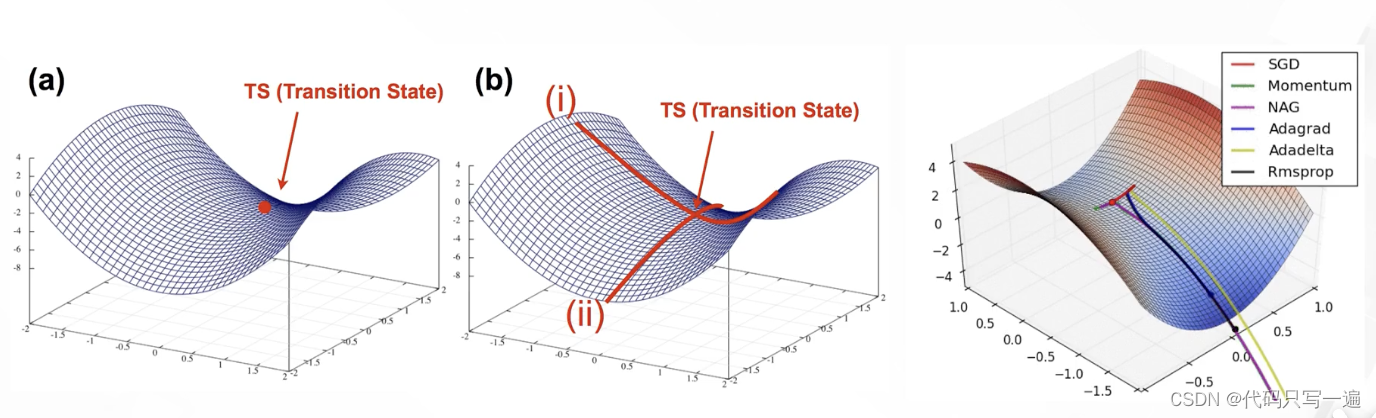

- **局部极小值:**传统的学习率衰减策略可能会导致模型陷入局部极小值。CLR 通过周期性地增加学习率,可以帮助模型跳出局部极小值并找到更好的解。

CLR 的主要优势包括:

- **更快的收敛速度:**CLR 可以加快模型的收敛速度,因为它允许模型在训练早期探索更大的搜索空间。

- **更高的准确性:**CLR 可以提高模型的准确性,因为它可以帮助模型找到更好的局部极小值。

- **更强的泛化能力:**CLR 可以提高模型的泛化能力,因为它可以减少过拟合。

### 2.2 循环学习率调度算法

CLR 使用基于余弦函数的学习率调度算法。该算法如下所示:

```python

def cosine_annealing_schedule(t, T, lr_max, lr_min):

"""

基于余弦函数的学习率调度算法

参数:

t: 当前训练步数

T: 总训练步数

lr_max: 最大学习率

lr_min: 最小学习率

返回:

当前学习率

"""

lr = lr_min + 0.5 * (lr_max - lr_min) * (1 + np.cos(np.pi * t / T))

return lr

```

该算法的逻辑分析如下:

- `t` 表示当前训练步数,`T` 表示总训练步数。

- `lr_max` 和 `lr_min` 分别表示最大学习率和最小学习率。

- 学习率 `lr` 根据余弦函数计算,余弦函数的周期为 `T` 步。

- 在训练的开始和结束时,学习率分别为 `lr_max` 和 `lr_min`。

- 在训练的中期,学习率在 `lr_max` 和 `lr_min` 之间周期性地变化。

该调度算法的优点是它可以平滑地改变学习率,避免了传统学习率衰减策略的突然变化。此外,余弦函数的周期性可以帮助模型探索不同的学习率范围。

# 3. 循环学习率优化策略的实践应用**

### 3.1 循环学习率在图像分类中的应用

循环学习率在图像分类任务中取得了显著的成功。其基本思想是将学习率在多个周期内循环变化,每个周期包括一个上升阶段和一个下降阶段。

#### 3.1.1 循环学习率的优点

在图像分类中使用循环学习率具有以下优点:

- **更快的收敛速度:**循环学习率可以加快模型的收敛速度,从而缩短训练时间。

- **更好的泛化能力:**循环学习率有助于模型学习图像的特征,同时避免过拟合,从而提高泛化能力。

- **鲁棒性更强:**循环学习率对超参数不那么敏感,使其在各种数据集和模型上都能很好地工作。

#### 3.1.2 循环学习率的超参数

在图像分类中使用循环学习率时,需要考虑以下超参数:

- **初始学习率:**循环开始时的学习率。

- **最大学习率:*

0

0