深度学习训练的突破:循环学习率优化策略

发布时间: 2024-08-21 07:23:31 阅读量: 36 订阅数: 29

《深度学习:算法到实战》全套论文.zip

# 1. 深度学习训练概述

深度学习训练是一个复杂且耗时的过程,涉及到大量参数的优化。传统上,学习率是一个固定值,但在实践中,它可能会导致训练陷入局部最优或过拟合。循环学习率优化策略通过动态调整学习率来解决这些问题,从而提高训练效率和模型性能。

# 2. 循环学习率优化策略的理论基础

### 2.1 循环学习率的原理和优势

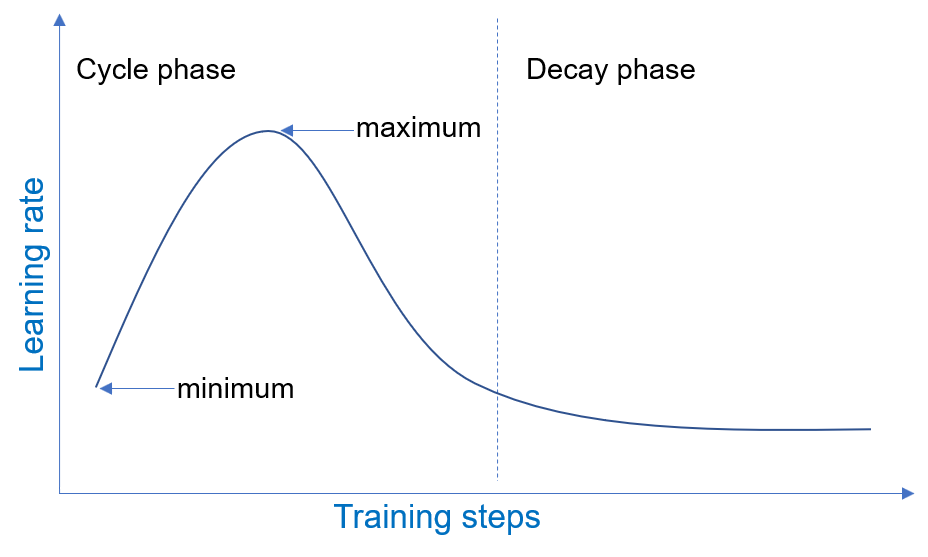

循环学习率(CLR)是一种优化策略,它通过周期性地改变学习率来提高深度学习模型的训练效率和性能。与传统的单调递减学习率策略不同,CLR 在训练过程中多次增加和降低学习率,形成一个循环模式。

CLR 的原理基于以下假设:

* **局部最优解:**深度学习模型经常陷入局部最优解,这些解距离全局最优解很近,但不是最优解。

* **学习率的动态调整:**通过动态调整学习率,模型可以跳出局部最优解,探索更大的参数空间。

* **学习率的周期性变化:**学习率的周期性变化可以防止模型过早收敛,并促进模型在训练过程中持续学习。

CLR 的优势包括:

* **更快的收敛速度:**CLR 可以帮助模型更快地达到最优解,从而缩短训练时间。

* **更好的泛化能力:**CLR 训练的模型通常具有更好的泛化能力,这意味着它们在未见数据上的性能更好。

* **更鲁棒的训练过程:**CLR 可以使训练过程更鲁棒,减少对超参数设置的敏感性。

### 2.2 不同循环学习率策略的比较

有几种不同的 CLR 策略,每种策略都有其独特的优点和缺点。最常见的策略包括:

| 策略 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 三角形学习率 | 学习率在三角形模式中变化,从低值增加到高值,然后又降低到低值。 | 简单易用,收敛速度快。 | 可能需要较长的训练时间。 |

| 三角形2学习率 | 与三角形学习率类似,但具有更平缓的增加和下降阶段。 | 收敛速度较慢,但泛化能力更好。 | 可能需要更长的训练时间。 |

| 正余弦学习率 | 学习率以正余弦函数的形式变化,从低值增加到高值,然后又降低到低值。 | 收敛速度快,泛化能力好。 | 可能需要调整超参数以获得最佳性能。 |

| 1周期学习率 | 学习率在单个周期内从低值增加到高值,然后立即下降到低值。 | 收敛速度最快,泛化能力好。 | 可能需要调整超参数以获得最佳性能。 |

选择最佳的 CLR 策略取决于模型、数据集和训练目标。

# 3. 循环学习率优化策略的实践应用

### 3.1 循环学习率策略的实现方法

#### 3.1.1 框架支持

主流深度学习框架,如 TensorFlow、PyTorch 和 Keras,都提供了对循环学习率优化策略的原生支持。以下是一些实现示例:

```python

# TensorFlow

optimizer = tf.keras.optimizers.SGD(learning_rate=tf.keras.optimizers.schedules.CyclicLearningRate(initial_learning_rate=0.001,

max_learning_rate=0.01,

step_size=2000,

mode='triangular'))

# PyTorch

optimizer = torch.optim.

```

0

0