集成学习技巧:让随机森林回归模型更强大,提升预测精度

发布时间: 2024-07-21 18:05:18 阅读量: 58 订阅数: 83

机器学习中的随机森林回归预测模型: 原理、构建与评估指标

# 1. 集成学习概述

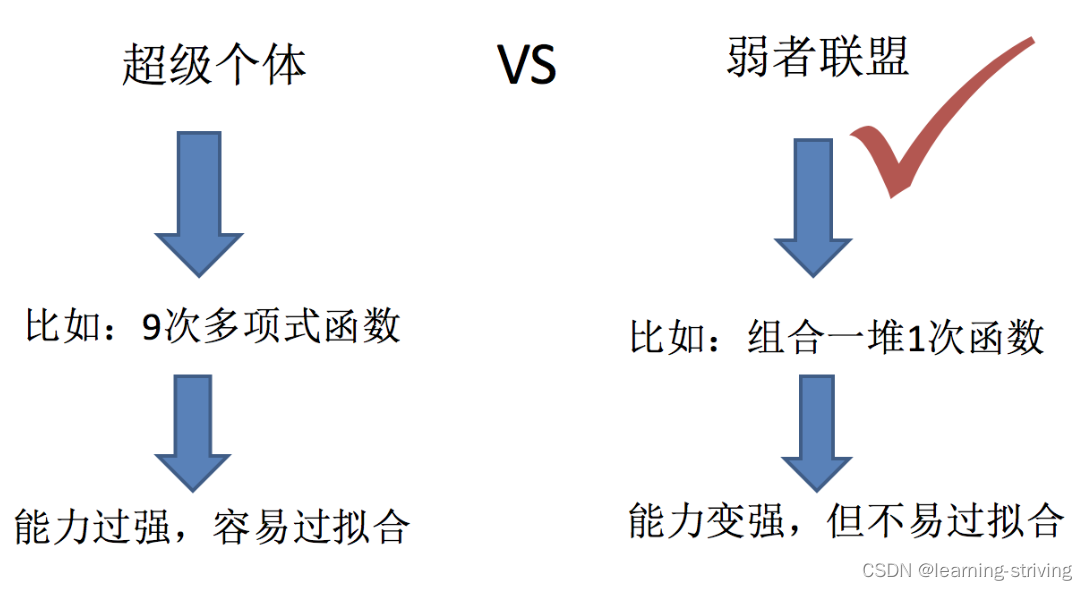

集成学习是一种机器学习技术,它通过组合多个较弱的学习模型来创建一个更强大的模型。集成学习的思想是,通过将多个模型的预测结果进行组合,可以获得比单个模型更好的预测性能。集成学习的常见方法包括:

- **Bagging:** Bagging(Bootstrap Aggregating)是一种集成学习方法,它通过对训练集进行多次有放回的采样,生成多个训练集,然后基于这些训练集训练多个模型,最后将这些模型的预测结果进行平均。

- **Boosting:** Boosting是一种集成学习方法,它通过对训练集进行多次加权采样,生成多个训练集,然后基于这些训练集训练多个模型,每个模型的权重根据前一个模型的预测结果进行调整,最后将这些模型的预测结果进行加权平均。

# 2. 随机森林回归模型

### 2.1 随机森林回归模型的原理

随机森林回归模型是一种集成学习算法,它通过构建多个决策树来预测连续值目标变量。其原理如下:

1. **数据集采样:**从训练集中有放回地抽取多个子集,每个子集的大小与原始训练集相同。

2. **决策树构建:**对于每个子集,使用不同的特征子集构建决策树。特征子集是通过随机选择原始特征集合中的部分特征获得的。

3. **预测:**对于每个输入样本,将样本输入到所有决策树中,并计算每个决策树的预测值。

4. **结果聚合:**将所有决策树的预测值取平均值(回归问题)或多数表决(分类问题)作为最终预测结果。

### 2.2 随机森林回归模型的超参数优化

随机森林回归模型的性能受多种超参数的影响,包括:

| 超参数 | 描述 |

|---|---|

| `n_estimators` | 决策树的数量 |

| `max_depth` | 决策树的最大深度 |

| `min_samples_split` | 决策树节点分裂所需的最小样本数 |

| `min_samples_leaf` | 决策树叶节点所需的最小样本数 |

| `max_features` | 每个决策树中使用的最大特征数 |

**代码块:**

```python

from sklearn.ensemble import RandomForestRegressor

# 创建随机森林回归模型

model = RandomForestRegressor(n_estimators=100, max_depth=5, min_samples_split=2, min_samples_leaf=1, max_features="auto")

# 训练模型

model.fit(X_train, y_train)

```

**逻辑分析:**

* `n_estimators=100` 指定构建 100 棵决策树。

* `max_depth=5` 限制决策树的最大深度为 5。

* `min_samples_split=2` 表示一个节点至少需要 2 个样本才能分裂。

* `min_samples_leaf=1` 表示叶节点至少需要 1 个样本。

* `max_features="auto"` 使用平方根特征数作为每个决策树中使用的特征数。

**参数说明:**

* `n_estimators`:决策树的数量。较大的值通常会导致更好的性能,但也会增加计算时间。

* `max_depth`:决策树的最大深度。较深的树可以捕获更复杂的模式,但也有过拟合的风险。

* `min_samples_split`:决策树节点分裂所需的最小样本数。较高的值可以防止过拟合,但也会导致欠拟合。

* `min_samples_leaf`:决策树叶节点所需的最小样本数。较高的值可以防止过拟合,但也会导致欠拟合。

* `max_features`:每个决策树中使用的最大特征数。较高的值可以捕获更多的信息,但也会增加过拟合的风险。

# 3. 集成学习技巧

### 3.1 集成学习的基本概念

集成学习是一种机器学习技术,它通过结合多个基学习器来提高模型的性能。基学习器可以是任何类型的机器学习模型,例如决策树、神经网络或支持向量机。集成学习的基本思想是,通过结合多个基学习器的预测,可以得到比单个基学习器更好的预测结果。

集成学习的优势在于:

- **减少方差:**集成学习可以减少模型的方差,因为不同的基学习器往往对不同的数据子集做出不同的预测。通过结合这些预测,可以得到一个更稳定的预测结果。

- **提高鲁棒性:**集成学习可以提高模型的鲁棒性,因为不同的基学习器往往对噪声和异常值不那么敏感。通过结合这些预测,可以得到一

0

0