探索随机森林回归模型在分类中的应用:拓展预测领域,挖掘数据价值

发布时间: 2024-07-21 17:58:33 阅读量: 36 订阅数: 42

# 1. 随机森林回归模型概述

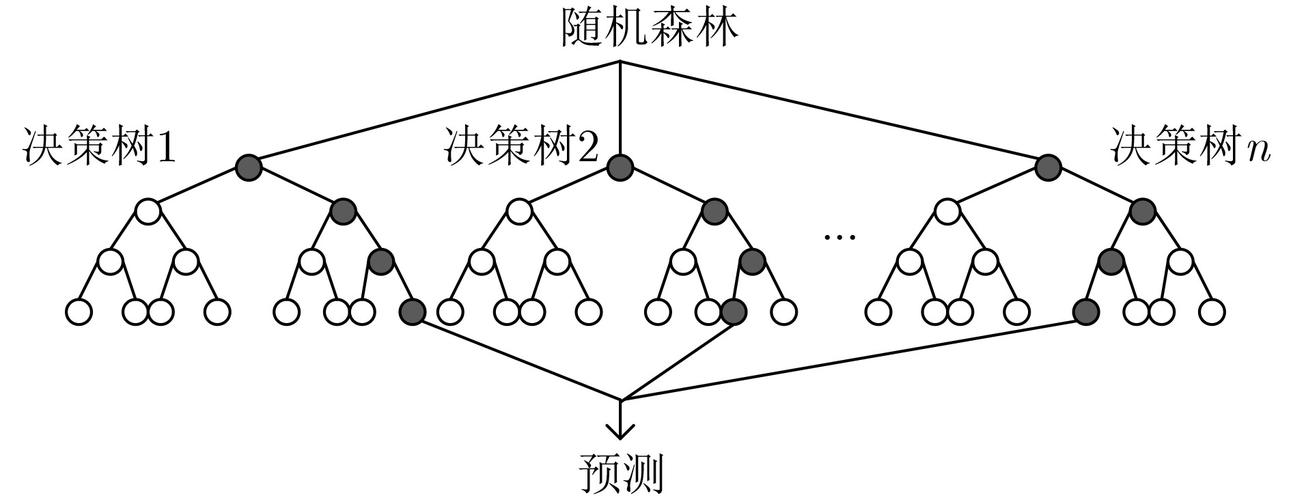

随机森林回归模型是一种强大的机器学习算法,用于预测连续值的目标变量。它通过构建多个决策树的集合来工作,每个决策树都是使用不同的训练数据子集和特征子集构建的。这些决策树的预测结果被平均或加权,以产生最终预测。

随机森林回归模型因其准确性、鲁棒性和处理高维数据的出色能力而受到欢迎。它还能够处理缺失值和异常值,并且可以提供对模型预测的特征重要性见解。

# 2. 随机森林回归模型在分类中的应用理论

### 2.1 随机森林回归模型的原理

随机森林回归模型是一种集成学习算法,它通过构建多个决策树并结合它们的预测结果来提高预测精度。具体来说,随机森林回归模型的工作原理如下:

1. **数据采样:** 从训练数据集中有放回地抽取多个子集,每个子集包含大约 2/3 的原始数据。

2. **决策树构建:** 在每个子集上,使用随机选择的特征子集构建一棵决策树。

3. **随机特征选择:** 在构建每棵决策树时,随机选择一组特征子集作为候选分裂节点。这有助于减少过拟合并提高模型的泛化能力。

4. **多棵决策树构建:** 重复步骤 1-3,构建多棵决策树(通常为数百或数千棵)。

5. **预测:** 对于新的输入数据,将数据传递给所有决策树,并计算每棵决策树的预测值。

6. **结果集成:** 将所有决策树的预测值进行平均(回归任务)或投票(分类任务)得到最终的预测结果。

### 2.2 随机森林回归模型在分类中的优势和局限

**优势:**

* **预测精度高:** 通过集成多个决策树,随机森林回归模型可以减少方差并提高预测精度。

* **鲁棒性强:** 随机森林回归模型对异常值和噪声不敏感,因为它使用多个决策树进行预测。

* **特征重要性评估:** 随机森林回归模型可以提供特征重要性分数,帮助识别对预测结果影响最大的特征。

* **可解释性:** 与其他机器学习算法相比,随机森林回归模型相对易于解释,因为它基于决策树的结构。

**局限:**

* **计算成本高:** 构建和训练随机森林回归模型需要大量计算资源,尤其是当数据集较大时。

* **过拟合风险:** 如果决策树数量过多或特征选择过于随机,随机森林回归模型可能会过拟合训练数据。

* **不适用于线性可分数据:** 随机森林回归模型在处理线性可分数据时可能效果不佳,因为决策树无法有效地将数据分割成不同的类。

# 3.1 数据预处理和特征工程

### 数据预处理

在应用随机森林回归模型进行分类之前,需要对数据进行预处理,以确保数据的质量和模型的性能。数据预处理主要包括以下步骤:

- **数据清洗:**移除缺失值、异常值和重复数据。缺失值可以通过插补或删除处理,异常值可以通过设定阈值或使用异常值检测算法识别并处理。

- **数据标准化:**将不同特征的数据缩放至同一数量级,以避免某些特征对模型的影响过大。常用的标准化方法包括均值归一化和标准差归一化。

- **数据编码:**将类别型特征转换为数值型特征,以供模型处理。常用的编码方法包括独热编码和标签编码。

### 特征工程

特征工程是数据预处理的重要组成部分,旨在通过创建新特征或转换现有特征来提高模型的性能。对于随机森林回归模型,常用的特征工程技术包括:

- **特征选择:**选择对分类任务最相关的特征,以减少模型的复杂性和提高其可解释性。常用的特征选择方法包括过滤式方法(如卡方检验)和包装式方法(如递归特征消除)。

- **特征转换:**将现有特征转换为更适合分类任务的形式。常用的特征转换方法包括二值化、对数变换和离散化。

- **特征组合:**创建新特征,它是现有特征的组合或相互作用。特征组合可以捕获特征之间的非线性关系,从而提高模

0

0