性能优化秘籍:数组与链表的深入比较及数据结构选择策略

发布时间: 2024-09-10 17:57:50 阅读量: 190 订阅数: 39

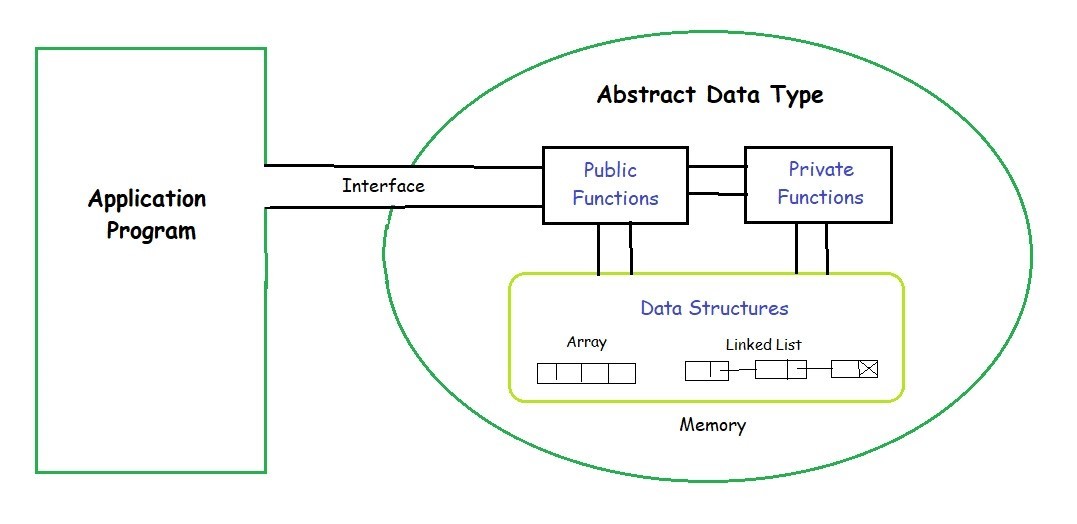

# 1. 数据结构基础概述

在软件开发的世界里,数据结构是构建高效算法与软件的基础。这一章将深入探讨数据结构的基本概念、分类以及它们在现代计算机科学中的重要性。数据结构不仅仅是存储数据的一种方式,它们还是组织和管理数据的方法,以确保数据的访问、处理和更新效率最大化。

数据结构可以分为两大类:线性结构和非线性结构。线性结构如数组和链表,它们中的元素通常以一对一的方式顺序排列。非线性结构则包括树形结构、图结构等,这些结构更复杂,元素之间可能存在一对多的关系。理解不同数据结构的特性和适用场景对于解决实际问题至关重要。本章节的目标是为读者打下坚实的数据结构基础,为后续章节中的深入分析和性能优化策略的讨论做好铺垫。

# 2. 数组与链表的理论分析

## 2.1 数组的特点与应用场景

### 2.1.1 数组的内部结构和寻址方式

数组是计算机科学中一种基础而重要的数据结构。从内部结构上看,数组是一组有序的数据元素的集合,所有元素类型相同,且在内存中连续存放。这种连续性带来了数组元素的快速寻址能力。

假设我们有一个整型数组 `int arr[10];`,数组中的每个元素都可以通过索引快速访问。如果数组的起始地址是 `base_address`,那么第 `i` 个元素的地址可以通过以下公式计算得出:

```

Element_address = base_address + i * sizeof(data_type)

```

其中,`sizeof(data_type)` 表示数据类型所占用的字节数。这个计算方式是数组寻址的核心,它保证了通过索引访问元素时,我们可以实现对内存的快速定位。

### 2.1.2 数组的时间复杂度分析

数组的性能主要体现在其时间复杂度上。对于访问操作,由于数组在内存中的连续性,我们可以实现常数时间复杂度 O(1) 来访问任意元素。例如:

```c

int value = arr[i];

```

然而,对于插入和删除操作,情况则大为不同。由于数组的连续性,这些操作可能需要移动大量元素来保证内存中的连续性,时间复杂度因此提高至 O(n)。例如,删除第一个元素时:

```c

for (int j = i; j < 10; ++j) {

arr[j-1] = arr[j];

}

```

上述代码中,我们需要从被删除元素之后的所有元素向前移动一位,总共移动的元素数量为 `n-i`,其中 `n` 是数组的大小,`i` 是被删除元素的索引。

## 2.2 链表的结构与性能特性

### 2.2.1 单链表、双链表与循环链表的区别

链表是另一种常见的数据结构,它由一系列节点组成,每个节点包含数据和指向下一个节点的指针。链表的类型主要有单链表、双链表和循环链表。

单链表每个节点只有一个指针指向下一个节点,因此它只能单向遍历。而双链表的每个节点除了有指向下一个节点的指针外,还有一个指向前一个节点的指针,使其能够双向遍历。循环链表的最后一个节点指向头节点,形成了一个环。

这些结构的选择取决于具体的应用需求。单链表在插入和删除操作中效率较高,因为它仅需要修改相邻节点的指针。双链表适合需要双向遍历的场景,如双向队列。循环链表适合模拟环状结构,如约瑟夫环问题。

### 2.2.2 链表的时间复杂度分析

链表最显著的特点是其元素在内存中可以非连续存放。这一特性使得链表在插入和删除操作上具有优势,时间复杂度为 O(1),前提是已知具体节点位置。例如,在双链表中删除一个节点 `p`:

```c

p->prev->next = p->next;

p->next->prev = p->prev;

```

不过,链表访问元素时必须从头节点开始,按顺序查找,因此访问任意节点的时间复杂度为 O(n)。

## 2.3 数组与链表的比较

### 2.3.1 存储连续性对比

数组和链表在存储方式上最主要的区别是其连续性。数组的存储连续性使得它能够利用CPU缓存预取机制,更高效地读取数据,因此在缓存利用率方面表现更优。

然而,连续性也使得数组难以动态调整大小,而链表能够通过增加节点轻松地进行动态扩展。

### 2.3.2 访问速度对比

在访问速度方面,数组通过索引能够实现常数时间访问,而链表必须从头节点开始遍历,直到找到目标节点,因此其访问速度通常慢于数组。

### 2.3.3 插入与删除操作的效率对比

在插入和删除操作的效率方面,链表更胜一筹,尤其是当涉及到大量插入和删除操作时。数组的插入和删除需要移动元素以保持连续性,这可能引起较大的性能开销。

# 3. 数据结构选择的实践原则

## 3.1 内存管理的角度

### 3.1.1 内存分配与回收机制

内存管理是数据结构选择中的一个重要考量因素。不同的数据结构对内存的需求以及其管理方式有所不同。数组作为一种内存连续分配的数据结构,它的内存分配是在创建时一次性完成的,这使得访问效率很高,但也意味着它的空间利用率受限于最开始的预估大小。数组的内存分配通常由操作系统底层的内存管理模块负责,涉及到内存块的分配和释放。

```c

int array[100]; // 静态分配固定大小的数组

int* dynamicArray = (int*)malloc(100 * sizeof(int)); // 动态分配数组

```

数组的内存回收通常是在程序的运行时进行,当数组不再使用时,通过`free`函数释放内存。然而,数组的大小是固定的,一旦分配,就无法动态调整。

与数组相比,链表作为一种非连续内存分配的数据结构,它的内存分配和回收则更为灵活。链表的每个节点可以在需要时动态分配,使用完毕后随时回收,这在某些情况下可以更好地利用内存。

```c

struct Node {

int data;

struct Node* next;

};

struct Node* node = (struct Node*)malloc(sizeof(struct Node)); // 动态分配链表节点

free(node); // 回收内存

```

内存分配与回收机制直接影响数据结构的性能表现,特别是在内存受限的环境中,选择合适的数据结构显得尤为重要。

### 3.1.2 空间利用效率分析

在内存利用效率方面,数组和链表表现出显著差异。数组由于其连续内存的特性,可以非常紧凑地存储数据,但是它对内存空间的利用率受到限制,因为数组一旦创建,其大小就固定不变。如果数组未完全使用,那么未使用的空间实际上是被浪费的。

```plaintext

数组空间利用率 = 实际使用空间 / 总分配空间

```

链表虽然提供了更大的灵活性,但其节点之间需要额外的空间来存储指针,这使得链表的空间利用率通常低于数组。每个节点需要额外的空间来存储指向下一个节点的指针,这在大型数据结构中可能是一个不可忽视的开销。

```plaintext

链表空间利用率 = 实际使用空间 / (总分配空间 + 指针空间)

```

为了提高链表的空间利用率,可以采用压缩存储的技巧,例如在节点内嵌入数据,减少每个节点的指针数量,或者使用更复杂的数据结构如跳表来优化性能。

## 3.2 算法效率的考量

### 3.2.1 算法的时间复杂度

在选择数据结构时,我们通常会考虑算法操作的时间复杂度,这包括最坏情况、平均情况和最好情况下的时间复杂度。对于不同的应用场景,这些复杂度的考量优先级可能会有所不同。例如,在需要频繁查找的场景下,具有较低平均查找时间复杂度的数据结构可能更受青睐。

例如,对于链表而言,其时间复杂度如下:

- 查找:平均情况下 O(n),最好情况下 O(1)(从头节点开始),最坏情况 O(n)(从非头节点开始)

- 插入:平均和最好情况下 O(1)(在链表头部),最坏情况 O(n)(在链表尾部或中间某处)

- 删除:平均和最好情况下 O(1)(删除头部节点),最坏情况 O(n)(删除尾部节点或中间某处的节点)

而对于数组,其时间复杂度通常更为稳定:

- 查找:平均和最坏情况下 O(n)(除非使用二分查找,但这需要数组有序且数组大小变化较小)

- 插入:平均和最坏情况下 O(n)(需要移动后续元素)

- 删除:平均和最坏情况下 O(n)(同样需要移动后续元素)

### 3.2.2 空间复杂度与时间复杂度的权衡

在数据结构的选择上,我们往往需要在空间复杂度和时间复杂度之间做出权衡。一些数据结构如散列表可能具有较低的时间复杂度(平均情况下 O(1)),但同时却要求较高的空间复杂度。例如,为了减少哈希冲突,需要预留更多的空间。

权衡的一个重要方面是考虑数据结构的预期使用频率和操作类型。对于经常进行查找操作的数据集合,使用如二叉搜索树这样的数据结构可能是更好的选择,因为它在平均情况下提供了对数时间复杂度的查找效率。

```plaintext

时间复杂度 = f(n) = O(g(n))

空间复杂度 = s(n) = O(h(n))

```

在实际应用中,如果数据操作非常频繁,尤其是插入和删除操作,可能需要选择更优的数据结构以减少时间复杂度,哪怕这会导致空间复杂度的增加。而如果数据操作相对较少,空间可能成为更加重要的考量因素。

## 3.3 实际应用案例分析

### 3.3.1 数据库索引的选择

在数据库系统中,索引的选择是提高查询性能的关键。例如,B树和B+树在数据库索引中被广泛使用。B树的每个节点可以包含多个键值和子树引用,这使得B树在处理大量数据时能够减少磁盘I/O操作次数。B+树是B树的一种变体,其所有数据都存储在叶子节点,这使得叶子节点之间形成了链表,方便范围查询。

B树的平衡特性使得即使在数据集非常大时,也能保持较高的查询效率。相比链表,B树在磁盘存储系统中优势更为明显,因为磁盘I/O操作的开销远大于内存中指针的访问。

### 3.3.2 缓存机制中的数据结构应用

在缓存机制中,选择合适的数据结构同样至关重要。常用的缓存数据结构包括LRU(最近最少使用)缓存、LFU(最不经常使用)缓存等。这些数据结构通常需要快速定位缓存项以及有效地更新和删除项。

例如,LRU缓存通常可以使用双向链表和哈希表的组合来实现,使得插入、删除和查找操作都保持在接近O(1)的时间复杂度。

```mermaid

graph LR

A[最近使用的节点] --> B[次近使用的节点]

B --> C[...]

C --> D[最久未使用的节点]

```

在实际应用中,LRU算法维护了一个双向链表,其中每个节点表示一个缓存项。当访问某个节点时,这个节点被移动到链表的头部,最久未使用的节点则位于尾部。当缓存满了时,移除尾部的节点并更新哈希表。

在缓存设计中,数据结构的选择直接影响到缓存的性能。合理的数据结构设计能够在保证快速访问的同时,最大限度地减少资源消耗,优化整体的系统性能。

以上详细介绍了数据结构选择实践原则的各个方面,深入分析了内存管理、算法效率的考量以及实际应用案例。在下一章节中,我们将探讨高级数据结构及其在性能优化中的应用策略。

# 4. 高级数据结构与性能优化策略

## 4.1 哈希表的原理与优化

### 4.1.1 哈希冲突解决策略

哈希表是一种以键-值(key-value)存储数据的结构,它使用哈希函数将索引映射到表内的位置,以此快速访问数据。在实际应用中,由于哈希函数的输出范围有限,不同的键可能会映射到同一个索引上,这种现象称为哈希冲突。解决冲突的常见策略有:

- **开放寻址法(Open Addressing)**:当发生冲突时,顺序检查哈希表中的下一个单元,直到找到空单元。线性探测法、二次探测法和双散列法是其常见的实现方式。

```mermaid

flowchart LR

A[开始] --> B[计算哈希值]

B --> C{是否有冲突}

C -- 是 --> D[线性/二次/双散列探测]

C -- 否 --> E[存储元素]

D --> E

E --> F[结束]

```

- **链表法(Separate Chaining)**:在每个索引的位置创建一个链表,当冲突发生时,将元素插入到对应的链表中。

```mermaid

flowchart LR

A[开始] --> B[计算哈希值]

B --> C{是否有冲突}

C -- 是 --> D[链表中插入元素]

C -- 否 --> E[存储元素]

D --> F[结束]

E --> F

```

在选择冲突解决策略时,需要考虑哈希表的负载因子(即表中元素与哈希桶数量的比例),以及期望的查找效率。开放寻址法在负载因子较低时效果好,链表法则对高负载因子有更好的表现。

### 4.1.2 动态扩容机制对性能的影响

哈希表在设计时,通常采用动态扩容机制来保持良好的性能。当哈希表中的元素数量超过一定阈值时(负载因子过高),表的大小会扩大(如翻倍),并重新计算所有元素的位置。

```python

# 示例:动态扩容的哈希表实现(伪代码)

class HashTable:

def __init__(self, initial_capacity):

self.capacity = initial_capacity

self.size = 0

self.buckets = [[] for _ in range(self.capacity)]

def insert(self, key, value):

index = hash(key) % self.capacity

# 检查冲突并解决

if key in self.buckets[index]:

# 更新值或采取其他操作

pass

else:

# 添加新的键值对

self.buckets[index].append((key, value))

self.size += 1

# 检查是否需要扩容

if self.size / self.capacity > 0.7:

self.resize()

def resize(self):

new_capacity = self.capacity * 2

new_buckets = [[] for _ in range(new_capacity)]

for bucket in self.buckets:

for key, value in bucket:

new_index = hash(key) % new_capacity

new_buckets[new_index].append((key, value))

self.capacity = new_capacity

self.buckets = new_buckets

```

动态扩容虽然会消耗额外的内存和时间来重新哈希现有元素,但它能够减少冲突,保持操作的平均时间复杂度为O(1)。当负载因子较低时,哈希表的性能最优化。在实现时,合理地选择扩容阈值和新的容量大小,对性能有着至关重要的影响。

## 4.2 树形结构的选择与应用

### 4.2.1 二叉搜索树与平衡树

二叉搜索树(BST)是一种特殊类型的树,在二叉搜索树中,左子树的所有键值都小于根节点的键值,右子树的所有键值都大于根节点的键值。这种结构在进行查找、插入和删除操作时效率较高,时间复杂度为O(log n)。

然而,在某些极端情况下(如连续插入已排序的键),二叉搜索树可能退化成链表,其性能会退化至O(n)。为了避免这种情况,引入了平衡树的概念,其中AVL树和红黑树是最常见的平衡二叉树。

AVL树是一种高度平衡的二叉搜索树,任意节点的两个子树的高度最大差别为1。它通过旋转操作来维护树的平衡,保证了所有基本操作的时间复杂度均为O(log n)。

红黑树是一种自平衡的二叉搜索树,它通过红黑颜色标记以及一系列旋转和重新着色来保证树的平衡性。与AVL树相比,红黑树在插入和删除操作上更加高效,因为它维护平衡的条件比AVL树宽松。

```python

# 示例:红黑树的基本性质和插入操作(伪代码)

class RedBlackTree:

def __init__(self):

self.NIL = Node('NIL') # 定义NIL节点,代表红色节点的“空”节点

self.root = self.NIL

# ...其他初始化操作

# 插入操作,维护红黑树性质

def insert(self, key):

# ...插入代码逻辑

# 维护红黑树性质的辅助函数,如左旋、右旋、重新着色等

def left_rotate(self, x):

# ...左旋转逻辑

def right_rotate(self, y):

# ...右旋转逻辑

# ...其他维护红黑树性质的函数

```

### 4.2.2 B树与B+树在数据库中的应用

B树和B+树主要用于数据库和文件系统中,以优化磁盘I/O操作。这两种树是多路平衡查找树,它们允许树的分支因子很大,这样可以减少访问磁盘的次数。

B树的每个节点可以包含多个键值和指向子节点的指针。节点内的键值用于确定数据在哪个子节点。B树在插入和删除节点时会尽可能保持树的平衡。

B+树是B树的变种,在B+树中,所有的数据记录都出现在叶子节点,并且叶子节点之间通过指针连接。这样的结构非常适合范围查询,因为一旦到达范围内的一个值,就可以顺序遍历后续的值。

```mermaid

flowchart TD

root["根节点"] -->|磁盘读取| children["子节点"]

children -->|磁盘读取| leafs["叶子节点"]

leafs -->|磁盘读取| data["数据记录"]

leafs --- leafs2["相邻叶子节点"]

data -.-> leafs2

```

在数据库应用中,B+树相比B树有以下优势:

- 由于所有数据都在叶子节点,范围查询时的磁盘访问更少。

- 叶子节点间通过指针连接,使得顺序访问数据变得高效。

- B+树通常拥有更高的分支因子,对于相同的数据量,B+树比B树的高度更低,因此磁盘I/O次数更少。

在实现B树和B+树时,应考虑如何优化节点分裂、合并、平衡调整等操作,以确保树的平衡性和数据的持久化存储。

## 4.3 图结构与算法优化

### 4.3.1 图的表示方法与应用场景

图由节点(顶点)和边组成,边可以是有向的也可以是无向的,并且可以有权重。在计算机科学中,图是表达复杂数据关系的重要结构。图的表示方法主要有两种:邻接矩阵和邻接表。

- **邻接矩阵**:用二维数组表示图,如果顶点i和顶点j之间有边,则矩阵元素matrix[i][j]为1(或边的权重),否则为0。

```python

# 示例:邻接矩阵表示图(伪代码)

class GraphMatrix:

def __init__(self, vertices):

self.matrix = [[0] * vertices for _ in range(vertices)]

def add_edge(self, i, j, weight=1):

self.matrix[i][j] = weight

# 对于无向图,还需添加下面这行

# self.matrix[j][i] = weight

```

- **邻接表**:使用字典或链表来存储邻接信息,每个顶点对应一个列表,列表中包含所有与该顶点相邻的顶点及其相关信息。

```python

# 示例:邻接表表示图(伪代码)

class GraphList:

def __init__(self, vertices):

self.adj_list = {i: [] for i in range(vertices)}

def add_edge(self, i, j, weight=1):

self.adj_list[i].append((j, weight))

# 对于无向图,还需添加下面这行

# self.adj_list[j].append((i, weight))

```

邻接矩阵适合表示稠密图,即顶点之间的连接较多时,查询两个顶点是否相连的时间复杂度为O(1)。但邻接矩阵的空间复杂度较高,特别是当顶点数非常多时。邻接表适合表示稀疏图,它节省空间,但在稠密图中,访问两个顶点是否相连的时间复杂度为O(V)。

### 4.3.2 图算法的时间复杂度分析及优化

图的算法是计算机科学中的一个核心部分,涉及遍历、搜索、最短路径和网络流等领域。遍历算法如深度优先搜索(DFS)和广度优先搜索(BFS)的时间复杂度通常是O(V + E),V是顶点数,E是边数。

对于最短路径问题,Dijkstra算法和Bellman-Ford算法是两种常用的解决方案。Dijkstra算法适合没有负权边的图,其时间复杂度为O(V^2),通过优先队列优化后可以达到O((V+E)logV)。Bellman-Ford算法能够处理包含负权边的图,时间复杂度为O(VE)。

```python

# 示例:Dijkstra算法实现(伪代码)

import heapq

def dijkstra(graph, start):

distances = {vertex: float('infinity') for vertex in graph}

distances[start] = 0

priority_queue = [(0, start)]

while priority_queue:

current_distance, current_vertex = heapq.heappop(priority_queue)

if current_distance > distances[current_vertex]:

continue

for neighbor, weight in graph[current_vertex].items():

distance = current_distance + weight

if distance < distances[neighbor]:

distances[neighbor] = distance

heapq.heappush(priority_queue, (distance, neighbor))

return distances

```

在实际应用中,图的优化通常需要根据特定场景进行。例如,在有向无环图(DAG)中,可以使用拓扑排序和动态规划来解决一些优化问题。在大型网络中,由于节点和边的数量巨大,可以采用分布式系统来并行计算图算法,从而提升效率。

优化图算法的过程中,选择合适的数据结构和存储方式是关键。例如,优先队列在Dijkstra算法中是提升效率的关键数据结构,它的优化(如使用二叉堆)直接影响算法的运行速度。另外,针对实际应用场景和图的特性进行定制化算法优化,可以在特定问题上取得更好的性能。

# 5. 性能优化案例研究

随着系统架构的复杂化,性能优化在软件开发中的重要性愈发突出。这一章将深入探讨如何通过选择合适的数据结构来提升系统的搜索性能,分析缓存策略与数据结构设计的关系,并探讨系统级优化的实际案例。

## 5.1 选择合适的数据结构提升搜索性能

在处理大量数据时,数据结构的选择直接关系到搜索效率的高低。传统的线性搜索和更高级的二分搜索是两种截然不同的策略,它们在不同场景下有着各自的优势。

### 5.1.1 线性搜索与二分搜索的对比

线性搜索是最基础的搜索方法,它逐个比较数据直到找到目标值或者检查完所有元素。线性搜索的时间复杂度为O(n),其中n是数据的个数。这种方法简单直观,但在大数据集上效率低下。

```python

def linear_search(data_list, target):

for index, value in enumerate(data_list):

if value == target:

return index

return -1

# 示例数据

data = [1, 3, 5, 7, 9]

target = 7

print("Target found at index:", linear_search(data, target))

```

相比之下,二分搜索利用了数据的有序性,每次搜索都将搜索范围减半,大大提高了搜索效率。二分搜索适用于有序数组,其时间复杂度为O(log n)。

```python

def binary_search(data_list, target):

left, right = 0, len(data_list) - 1

while left <= right:

mid = left + (right - left) // 2

if data_list[mid] == target:

return mid

elif data_list[mid] < target:

left = mid + 1

else:

right = mid - 1

return -1

# 示例数据

sorted_data = sorted(data)

print("Target found at index:", binary_search(sorted_data, target))

```

### 5.1.2 索引结构对数据库查询性能的提升

在数据库系统中,索引是一种重要的数据结构,它能够显著提升查询速度。数据库索引通常使用B树或其变体B+树实现,因为这些结构在插入、删除、查找操作中都表现出了良好的平衡性和对磁盘I/O的优化。

索引的创建和维护虽然需要额外的存储空间和更新时间,但其带来的查询性能提升是巨大的。例如,对于含有数百万条记录的表,在使用索引之前可能需要数分钟才能完成的查询,在创建合适的索引后可能只需要几毫秒。

## 5.2 缓存策略与数据结构

缓存是提高系统性能的常用手段,它可以减少对后端存储系统的访问次数,从而降低延迟和提高吞吐量。

### 5.2.1 LRU、LFU等缓存淘汰策略

缓存淘汰策略决定了当缓存超出容量时哪些数据将被移除。最常用的策略有最近最少使用(LRU)和最少频率使用(LFU)。

在LRU中,最近最少使用的缓存项会被淘汰。LRU通常通过链表来实现,链表头部存储最近访问的数据,尾部存储最久未访问的数据。

```python

class LRUCache:

def __init__(self, capacity):

self.cache = {}

self.capacity = capacity

self.keys = []

def get(self, key):

if key not in self.cache:

return -1

else:

self.keys.remove(key)

self.keys.append(key)

return self.cache[key]

def put(self, key, value):

if key in self.cache:

self.keys.remove(key)

elif len(self.cache) >= self.capacity:

oldest_key = self.keys.pop(0)

del self.cache[oldest_key]

self.cache[key] = value

self.keys.append(key)

# 示例使用

lru_cache = LRUCache(2)

lru_cache.put(1, 1)

lru_cache.put(2, 2)

print(lru_cache.get(1)) # 返回 1

lru_cache.put(3, 3) # 该操作会使得键 2 作废

print(lru_cache.get(2)) # 返回 -1 (未找到)

```

LFU则跟踪每个缓存项的访问频率,并淘汰访问频率最低的数据。实现LFU一般需要用到哈希表和最小堆。

### 5.2.2 缓存数据结构设计与性能测试

为了达到最佳的缓存效果,缓存数据结构的设计至关重要。例如,Redis使用了SDS(简单动态字符串)作为基本数据结构,提供了快速的键值存取功能。设计时,需要考虑数据结构的读写效率、内存占用以及更新策略等因素。

性能测试可以帮助我们评估缓存设计是否满足预期,这包括测试缓存的命中率、响应时间和吞吐量等关键性能指标。在实际应用中,缓存的性能测试通常需要通过压力测试工具进行,比如JMeter和Locust。

## 5.3 系统级优化实例

系统级优化关注的是整个系统架构的性能,这不仅包括单个数据结构的选择,还包括多个组件如何协同工作。

### 5.3.1 分布式系统中的数据结构选择

在分布式系统中,数据结构的选择变得更加复杂。由于数据分布在不同的物理节点上,需要考虑数据一致性和网络延迟等问题。

例如,分布式数据库中的键值存储系统可能会选择一致性哈希算法来分配键到不同的节点,以平衡负载并提供高可用性。一致性哈希减少了节点增减时需要移动的数据量。

### 5.3.2 大数据环境下的性能优化策略

大数据环境对性能优化提出了更高的要求。面对海量数据,数据结构的选择和优化需要结合具体的数据处理框架和算法。

如在Hadoop或Spark这样的分布式计算框架中,数据通常以键值对的形式存储,使用分布式哈希表(DHT)等高级数据结构可以有效地管理和处理大规模数据。这些数据结构通过分散负载和优化数据分布,来提高处理速度和吞吐量。

在实际应用中,性能优化是一个持续的过程,需要根据系统运行的实际数据进行调整和再优化。通过对数据结构和算法的持续监控和分析,可以识别瓶颈所在,并据此选择或设计更适合的结构和策略。

通过本章的学习,我们可以了解到,性能优化不仅是对单一数据结构的选择,更涉及到系统设计、数据管理以及多种策略的综合运用。在不同场景下,应当根据实际需求和限制条件,灵活运用各种技术手段来实现最优的系统性能。

0

0