【TensorFlow初体验】:构建你的第一个深度学习程序

发布时间: 2024-09-30 08:21:59 阅读量: 28 订阅数: 22

深度学习框架(TensorFlow)基础教程——第1章:人工智能简介

# 1. TensorFlow概述和安装

## TensorFlow起源与发展

TensorFlow,由Google大脑团队开发的一个开源机器学习框架,自2015年发布以来,已成为业界标准之一。它支持多种语言和平台,能够处理从单个移动设备到大规模分布式系统等多种硬件配置。随着版本的更新,TensorFlow不断地引入新功能和优化,以适应不断发展的AI领域需求。

## 安装TensorFlow

安装TensorFlow的第一步是确保系统满足其依赖要求。通常,可以使用Python的包管理器pip来安装TensorFlow。以下是基于不同操作系统安装TensorFlow的常用命令:

```bash

# 对于使用CPU的安装:

pip install tensorflow

# 对于使用GPU的安装,需要先安装CUDA和cuDNN:

pip install tensorflow-gpu

```

安装完成后,可以通过运行一些基础的TensorFlow代码来验证安装是否成功。以下是验证安装的简单Python代码:

```python

import tensorflow as tf

hello = tf.constant('Hello, TensorFlow!')

print(hello.numpy())

```

如果代码执行没有错误,并且输出了"Hello, TensorFlow!",则表示TensorFlow已成功安装。

# 2. TensorFlow基础

在第一章中,我们对TensorFlow有了一个初步的了解,并且学习了如何安装TensorFlow。接下来,我们将深入探讨TensorFlow的基础,这是构建任何复杂模型的前提。

## 2.1 TensorFlow中的数据流图和计算

数据流图是TensorFlow执行计算、跟踪和操作数据的主要方式。理解如何构建和操作这些数据流图对于使用TensorFlow进行深度学习至关重要。

### 2.1.1 数据流图的概念与构建

数据流图由节点(Nodes)和边(Edges)组成,它以图形的形式展示了数据在计算中的流动路径。在TensorFlow中,每个节点表示一个操作(op),而边表示操作之间的数据流向。

#### 构建数据流图的步骤:

1. 创建计算图(Graph)实例。

2. 使用该实例创建操作节点。

3. 将操作节点以数据依赖的方式连接起来。

4. 构建完成后,通过会话(Session)运行计算图。

下面是一个简单的数据流图构建示例:

```python

import tensorflow as tf

# 创建一个默认的计算图

graph = tf.Graph()

# 在计算图中定义两个常量节点

with graph.as_default():

a = tf.constant(2, name='a')

b = tf.constant(3, name='b')

# 创建一个加法操作节点,并指定输出的名称为 'addition'

add = tf.add(a, b, name='addition')

# 通过会话运行计算图

with tf.Session(graph=graph) as sess:

print(sess.run(add))

```

### 2.1.2 计算单元和变量的创建与使用

变量在TensorFlow中是存储和更新参数的主要机制。创建一个变量需要指定初始值,并且该变量可以在多个操作中使用。

#### 创建和使用变量的步骤:

1. 使用`tf.Variable`创建一个变量。

2. 使用`tf.global_variables_initializer()`初始化所有变量。

3. 在需要的地方引用并使用变量。

下面是如何创建和使用变量的示例:

```python

import tensorflow as tf

# 创建一个新的计算图

graph = tf.Graph()

with graph.as_default():

# 创建变量并指定初始值

W = tf.Variable([.3], dtype=tf.float32, name="weight")

b = tf.Variable([-.3], dtype=tf.float32, name="bias")

# 定义一个简单的线性模型

x = tf.placeholder(tf.float32, name="input")

linear_model = W * x + b

# 初始化所有全局变量

init = tf.global_variables_initializer()

# 创建一个会话,并初始化变量

with tf.Session(graph=graph) as sess:

sess.run(init)

# 使用模型进行预测

print(sess.run(linear_model, {x: [1, 2, 3]}))

```

在上述示例中,我们定义了一个变量`W`和`b`,并且定义了一个简单的线性模型。通过传入不同的输入`x`,我们可以使用该模型进行预测。

## 2.2 TensorFlow的数据表示与操作

TensorFlow中的基本数据单位是张量(Tensor),它可以表示多维数组。TensorFlow提供了丰富的方法对张量进行操作和变换。

### 2.2.1 张量的基础操作

张量的操作包括但不限于形状变换、类型转换、数学运算等。张量的形状和数据类型在定义后是不可更改的。

#### 张量操作示例:

```python

import tensorflow as tf

# 创建一个张量

tensor = tf.constant([[1, 2], [3, 4]], dtype=tf.int32)

# 获取张量的形状

print("Tensor shape:", tensor.shape)

# 转换张量的数据类型

tensor_float = tf.cast(tensor, tf.float32)

# 对张量进行矩阵运算

tensor_product = tf.matmul(tensor_float, tensor_float, transpose_b=True)

# 在会话中执行运算

with tf.Session() as sess:

print("Matrix product:", sess.run(tensor_product))

```

### 2.2.2 常用的数据操作函数

TensorFlow提供了大量的函数用于对张量执行复杂的数据操作。这些函数涵盖了从数组分割、合并到数据类型转换等多个方面。

#### 张量数据操作函数示例:

```python

import tensorflow as tf

# 创建一个随机张量

random_tensor = tf.random_uniform((2, 3), minval=0, maxval=1)

# 将张量分割为两部分

split = tf.split(random_tensor, 2, axis=0)

# 合并张量分割后的结果

merged_tensor = tf.concat(split, axis=1)

# 在会话中执行张量操作

with tf.Session() as sess:

print("Original tensor:\n", sess.run(random_tensor))

print("Merged tensor:\n", sess.run(merged_tensor))

```

在上述代码中,我们首先创建了一个随机张量,并将其分割成两部分,然后又将这两部分合并成一个新的张量。这些操作在数据预处理和模型结构设计中非常有用。

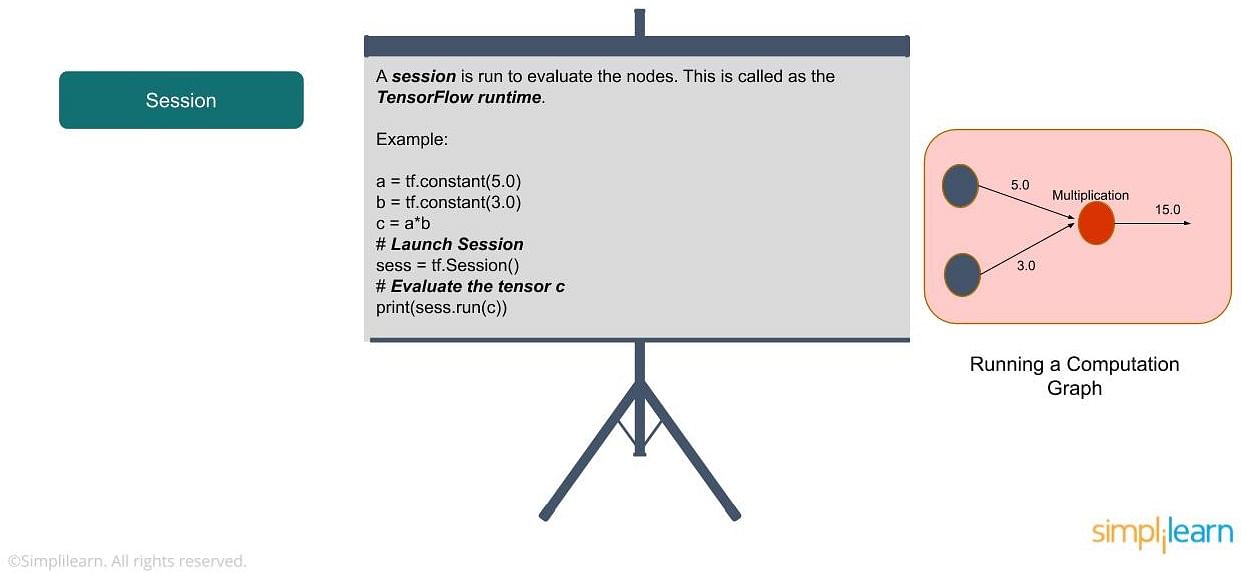

## 2.3 TensorFlow的会话和运行环境

会话(Session)是TensorFlow中执行计算的运行环境。在会话中可以运行计算图的节点,并获取节点的输出值。

### 2.3.1 会话的创建与管理

创建会话是执行TensorFlow计算的第一步。会话可以执行计算图中的操作,并将操作的结果返回。

#### 创建会话并管理的步骤:

1. 使用`tf.Session()`创建会话实例。

2. 使用`Session.run()`方法执行操作并获取结果。

3. 关闭会话以释放资源。

下面是一个会话管理的示例:

```python

import tensorflow as tf

# 创建计算图

graph = tf.Graph()

with graph.as_default():

# 定义操作节点

a = tf.constant(5.0)

b = tf.constant(6.0)

c = a * b

# 创建会话

session = tf.Session(graph=graph)

# 运行操作并获取结果

with session as sess:

result = sess.run(c)

print(result)

# 关闭会话

session.close()

```

### 2.3.2 配置与使用运行环境

TensorFlow允许用户配置会话的运行环境,例如设置日志级别、启用设备功能等。

#### 配置会话的步骤:

1. 使用`tf.ConfigProto()`创建一个配置对象。

2. 修改配置对象的属性以满足需求。

3. 使用配置对象初始化会话。

下面是一个配置会话运行环境的示例:

```python

import tensorflow as tf

# 创建计算图

graph = tf.Graph()

with graph.as_default():

# 定义操作节点

a = tf.constant(5.0)

b = tf.constant(6.0)

c = a * b

# 创建配置对象并设置日志级别

config = tf.ConfigProto(log_device_placement=True)

# 创建会话并使用配置

session = tf.Session(graph=graph, config=config)

# 运行操作并获取结果

with session as sess:

result = sess.run(c)

print(result)

# 关闭会话

session.close()

```

在上述代码中,通过配置对象的`log_device_placement`参数,我们可以监控操作是否在CPU或GPU上执行。这对于调试和优化模型非常有帮助。

# 3. 构建第一个深度学习模型

## 3.1 理解神经网络基础

### 3.1.1 神经网络的构成要素

深度学习是机器学习的一个子领域,而神经网络是实现深度学习的核心技术。神经网络由多个层次构成,每一层由许多神经元组成。这些神经元相互连接,并通过加权输入和激活函数进行计算,以产生输出。

神经网络的基本构成要素可以概括如下:

- **输入层**:接收原始数据的层,每个神经元代表一个特征。

- **隐藏层**:中间层,用于提取输入数据的特征。

- **输出层**:产生最终结果的层,其输出依赖于隐藏层的处理结果。

- **神经元**:网络的基本计算单元,相当于人脑中的神经细胞。

- **权重**:连接不同神经元之间的数值,表示连接的强度。

- **偏置项**:调整神经元输出的阈值,用于平衡激活函数的输出。

理解这些基本构成要素是构建高效神经网络的关键。

### 3.1.2 激活函数与损失函数

**激活函数**在神经网络中起着至关重要的作用,它们为神经元引入非线性因素,从而允许网络学习和执行更加复杂的任务。常见的激活函数包括:

- **Sigmoid函数**:输出范围为0到1,适用于二分类问题。

- **Tanh函数**:输出范围为-1到1,与Sigmoid类似但以0为中心。

- **ReLU函数**:线性整流函数,输出为输入的最大值0,适用于深层网络,因为计算简单且梯度传播效果好。

- **Leaky ReLU**:ReLU的一个变种,允许一个很小的梯度当输入为负时,避免了ReLU的"死亡"问题。

在神经网络中,**损失函数**衡量的是模型的预测值与实际值之间的差异,它的目的是提供一个可优化的目标,以便在训练过程中调整模型的参数。常见的损失函数有:

- **均方误差(MSE)**:用于回归问题。

- **交叉熵**:用于分类问题,是多类别分类和二分类问题中常用的损失函数。

正确选择激活函数和损失函数是保证神经网络性能的关键步骤。

## 3.2 实现简单的神经网络

### 3.2.1 前馈神经网络的构建步骤

构建一个简单的前馈神经网络通常涉及以下步骤:

1. **初始化网络结构**:定义网络层数,每层的神经元数量,以及每层之间的连接方式。

2. **选择激活函数**:根据任务类型选择合适的激活函数。

3. **权重和偏置的初始化**:随机初始化或使用特定方法初始化权重和偏置。

4. **前向传播**:输入数据在网络中从前向后传递,每一层都会应用激活函数。

5. **计算损失**:根据损失函数计算预测值和真实值之间的差异。

6. **反向传播**:基于损失值,通过链式法则计算梯度,并更新网络中的权重和偏置。

7. **迭代优化**:重复执行前向传播和反向传播过程,直至模型收敛。

通过逐步实现这些步骤,构建一个功能完整的神经网络是完全可行的。

### 3.2.2 网络参数的初始化和优化

**参数初始化**和**优化算法**的选择对于训练过程和最终模型性能至关重要。

**参数初始化**策略包括:

- 随机初始化:权重随机分配,常用于简单的网络。

- Xavier初始化:也称为Glorot初始化,是一种自适应初始化方法,有助于在训练过程中保持梯度的稳定性。

- He初始化:是Xavier初始化的变种,专门用于ReLU激活函数。

**优化算法**包括:

- **梯度下降**:是最基本的优化方法,通过迭代更新参数来最小化损失函数。

- **动量法(Momentum)**:通过考虑之前的梯度,加速学习并减少震荡。

- **Adagrad**:自适应学习率,为每个参数维护一个学习率,适用于稀疏数据。

- **Adam**:结合了动量和Adagrad的特点,适用于多种问题。

正确地初始化网络参数,并选择合适的优化算法,是构建和训练高效神经网络不可或缺的部分。

## 3.3 模型的训练与评估

### 3.3.1 训练过程中的关键概念

在深度学习模型的训练过程中,几个关键概念是必须要掌握的:

- **批处理(Batch)**:每次更新模型时,使用的一部分数据样本。

- **迭代(Iteration)**:通过整个训练集的一次过程。

- **周期(Epoch)**:一个周期意味着数据集的全部样本都被用来训练网络一次。

- **过拟合和欠拟合**:过拟合是模型在训练数据上表现很好,但在未知数据上表现差的现象;而欠拟合则是模型连训练数据的表现也不好。

- **正则化**:一种技术,通过加入额外的约束来防止过拟合,常见的方法包括L1和L2正则化。

- **早停(Early Stopping)**:一种防止过拟合的策略,通过在验证集上的性能不再提升时停止训练来实现。

理解这些概念,有助于更有效地训练模型,并提高其泛化能力。

### 3.3.2 模型的保存、加载和评估方法

训练好的模型需要被保存和加载,以便在不同的环境和应用中使用。同时,模型的评估也是至关重要的,以确保模型在未见数据上的性能。

**模型保存**通常涉及以下步骤:

- 使用TensorFlow的`save`方法保存整个模型或模型的参数。

- 将模型或参数保存为文件,可以是HDF5格式或TensorFlow的Checkpoint格式。

**模型加载**可以使用:

- TensorFlow的`load_model`方法加载保存的模型。

- 使用`restore`方法恢复模型的参数。

**模型评估**则是通过以下方法进行:

- 在验证集或测试集上运行模型,计算损失函数和评价指标,如准确率。

- 使用混淆矩阵来评估分类模型的性能。

- 考虑模型的其他性能指标,如精确率、召回率和F1分数。

保存、加载和评估模型,是将训练完成的神经网络应用于实际问题的关键步骤。

以上内容展示了构建第一个深度学习模型的基础和关键步骤,为读者提供了从理论到实践的详细指导,帮助他们理解和实现深度学习的基本概念和操作。

# 4. 深入TensorFlow高级特性

## 4.1 卷积神经网络(CNN)

### 4.1.1 CNN的理论基础和应用实例

卷积神经网络(CNN)是一种深度学习架构,特别适合处理具有网格结构的数据,例如时间序列数据(一维网格)和图像数据(二维网格)。CNN的核心思想是利用局部感受野、权重共享和下采样来提取特征。

在图像处理领域,CNN可以自动并有效地学习空间层次结构。它从最基础的特征(如边缘和角点)开始,逐渐构建到更复杂的特征(如物体的部分和整体)。CNN的关键组成部分包括卷积层、激活函数、池化层、全连接层和输出层。

**卷积层**:使用一组可学习的滤波器(卷积核)在输入数据上滑动,计算滤波器和局部输入数据的点积,从而提取局部特征。

**激活函数**:如ReLU(Rectified Linear Unit)函数,引入非线性因素,让网络能够学习和执行更复杂的任务。

**池化层**:减小数据的空间尺寸,降低参数数量和计算量,同时保持特征的不变性。

**全连接层**:在特征提取完成后,网络需要对特征进行组合,以执行分类等任务。

应用实例:

在图像识别任务中,CNN已经成为主导方法。例如,使用TensorFlow实现的CNN可以识别不同的手写数字(MNIST数据集)或不同的物体类别(如ImageNet数据集)。图像中的每个像素都与一个或多个神经元相连接,通过多个卷积层和池化层的叠加,模型可以学习到从简单的局部特征到复杂的整体结构。

### 4.1.2 构建图像识别模型

构建一个图像识别模型涉及多个步骤,包括数据准备、模型设计、训练以及评估。以下是使用TensorFlow构建一个简单的图像识别模型的基本步骤:

1. **数据准备**:加载数据集,并进行预处理,如归一化、打乱顺序、定义批处理大小等。

2. **模型设计**:使用TensorFlow构建CNN模型,通常涉及定义多个卷积层、激活函数和池化层。

3. **模型训练**:通过前向传播和反向传播训练模型权重,并使用优化器如Adam或SGD更新参数。

4. **模型评估**:在验证集上评估模型性能,使用准确率等指标作为衡量标准。

下面是一个构建图像识别CNN模型的简单代码示例:

```python

import tensorflow as tf

# 定义模型参数

num_classes = 10

input_shape = (28, 28, 1) # 例如MNIST数据集的尺寸和颜色通道数

# 定义模型结构

model = tf.keras.models.Sequential([

# 卷积层1

tf.keras.layers.Conv2D(32, kernel_size=(3, 3), activation='relu', input_shape=input_shape),

# 池化层1

tf.keras.layers.MaxPooling2D(pool_size=(2, 2)),

# 卷积层2

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

# 池化层2

tf.keras.layers.MaxPooling2D(pool_size=(2, 2)),

# 展平层,将2D数据转换为1D数据

tf.keras.layers.Flatten(),

# 全连接层

tf.keras.layers.Dense(128, activation='relu'),

# 输出层

tf.keras.layers.Dense(num_classes, activation='softmax')

])

# 编译模型

***pile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 模型摘要

model.summary()

# 拟合模型

# model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

# 评估模型

# loss, accuracy = model.evaluate(x_test, y_test)

```

### 4.2 循环神经网络(RNN)

#### 4.2.1 RNN的工作原理和变体

循环神经网络(RNN)是一种专门用于处理序列数据的神经网络。与CNN的局部连接不同,RNN设计了具有自连接的神经网络层,允许信息在序列的时间步之间流动,这样的连接使得RNN可以保留和使用之前的信息。

**RNN的工作原理**:

- 在每个时间步,RNN接收当前输入和上一个时间步的状态(隐藏状态)。

- 使用当前输入和隐藏状态来计算输出和下一个隐藏状态。

- 隐藏状态可以被视为序列的信息记忆。

**RNN的变体**:

- 长短期记忆网络(LSTM)和门控循环单元(GRU)是RNN的两个重要变体,它们通过门控机制解决了传统RNN难以捕捉长期依赖的问题。

#### 4.2.2 实现序列数据处理模型

构建序列数据处理的RNN模型同样遵循数据准备、模型设计、训练和评估的流程。下面是一个使用LSTM来处理序列数据的简单示例:

```python

import tensorflow as tf

# 定义模型参数

num_classes = 1

max_sequence_length = 100

input_dim = 10 # 假设每个时间步的输入有10个特征

# 定义模型结构

model = tf.keras.models.Sequential([

# 嵌入层将输入的索引转换为密集的向量表示

tf.keras.layers.Embedding(input_dim=input_dim, output_dim=50),

# LSTM层

tf.keras.layers.LSTM(64),

# 输出层

tf.keras.layers.Dense(num_classes, activation='sigmoid')

])

# 编译模型

***pile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 模型摘要

model.summary()

# 拟合模型

# model.fit(x_train, y_train, epochs=10, validation_data=(x_val, y_val))

# 评估模型

# loss, accuracy = model.evaluate(x_test, y_test)

```

### 4.3 张量处理单元(TPU)与分布式训练

#### 4.3.1 TPU的工作机制及其优势

张量处理单元(TPU)是Google专门为机器学习计算优化设计的硬件加速器。TPU相比于传统的CPU和GPU,在执行矩阵运算方面具有更高的性能和能效比,这在深度学习训练和推理中尤为重要。

**TPU的工作机制**:

- TPU的设计专门为TensorFlow框架优化,可以快速执行矩阵运算和卷积运算。

- TPU提供了高带宽的内存,减少数据传输时间,加快了计算过程。

- 通过集群管理,多个TPU可以被组合成一个大的计算资源池,以满足大规模深度学习任务的需要。

**TPU的优势**:

- 提供比GPU更快的训练速度。

- 能效比更高,运行成本更低。

- 为大规模机器学习工作负载提供可扩展的计算解决方案。

#### 4.3.2 分布式训练的概念与实践

分布式训练涉及在多个计算节点上并行化模型训练过程,每个节点负责模型的一个子集,这样可以显著减少训练时间,特别是在处理大数据集和复杂模型时。

**分布式训练的基本概念**:

- 数据并行:不同的计算节点使用相同模型结构,但输入不同的数据子集进行训练。

- 模型并行:将模型的不同部分分配给不同的计算节点进行训练。

- 同步和异步训练:同步训练中,所有节点定期同步权重;异步训练中,节点独立更新权重,无需等待其他节点。

**实践中的分布式训练**:

在TensorFlow中,可以通过设置`tf.distribute.Strategy`来实现分布式训练。例如,使用`tf.distribute.MirroredStrategy`可以实现数据并行训练。

```python

import tensorflow as tf

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

model = tf.keras.Sequential([

# ... 定义模型结构 ...

])

***pile(loss='sparse_categorical_crossentropy', optimizer='adam')

# 使用MirroredStrategy的API进行数据输入、模型训练和评估

```

分布式训练可以使模型在更短的时间内完成训练,特别是针对大型模型和大规模数据集。然而,它也引入了额外的复杂性,如数据一致性问题、资源分配和网络通信开销。

# 5. TensorFlow在实际问题中的应用

在本章中,我们将探索TensorFlow如何应用于不同类型的实际问题。我们从图像识别和处理开始,然后深入了解自然语言处理(NLP)的应用,最后探讨强化学习和游戏AI。

## 5.1 图像识别和处理

TensorFlow在图像识别和处理方面的应用非常广泛,从简单的图像分类任务到复杂的图像风格迁移都得到了广泛的应用。

### 5.1.1 使用TensorFlow进行图像分类

在图像分类任务中,卷积神经网络(CNN)是主要的模型选择。下面是一个使用TensorFlow实现图像分类的示例。

```python

import tensorflow as tf

# 加载数据集

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 归一化数据

x_train, x_test = x_train / 255.0, x_test / 255.0

# 构建模型

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

***pile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=5)

# 评估模型

model.evaluate(x_test, y_test, verbose=2)

```

在上述代码中,我们首先加载了MNIST数据集,并对数据进行归一化处理。然后构建了一个简单的全连接神经网络模型,接着进行了模型编译、训练和评估。

### 5.1.2 图像分割与风格迁移

图像分割和风格迁移是图像处理的高级应用。图像分割将图像划分为不同的区域,而风格迁移则是一种将一种图像的风格应用到另一种图像上的技术。

图像分割通常使用深度卷积神经网络来实现,例如U-Net结构。风格迁移则涉及到对抗网络,例如使用生成对抗网络(GANs)进行风格迁移。

## 5.2 自然语言处理

TensorFlow同样在自然语言处理领域有着广泛的应用,从文本分类到机器翻译,再到问答系统。

### 5.2.1 TensorFlow在NLP中的应用案例

文本分类是一个常见的NLP任务,比如情感分析或主题分类。以下是一个简单的情感分析模型的构建过程。

```python

# 假设已经有了预处理后的文本数据

texts = [...] # 文本列表

labels = [...] # 对应的情感标签

# 构建模型

model = tf.keras.Sequential([

tf.keras.layers.Embedding(input_dim=vocab_size, output_dim=embedding_dim, input_length=max_length),

tf.keras.layers.GlobalAveragePooling1D(),

tf.keras.layers.Dense(24, activation='relu'),

tf.keras.layers.Dense(1, activation='sigmoid')

])

# 编译模型

***pile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(padded, training_labels, epochs=10, validation_data=(testing_padded, testing_labels))

```

在上面的代码中,我们构建了一个基于嵌入层和全连接层的简单神经网络模型来处理文本分类任务。

### 5.2.2 构建文本生成模型

文本生成任务中,循环神经网络(RNN)和长短期记忆网络(LSTM)等时序模型表现优异。最近,变换器(Transformer)模型的出现使得NLP任务取得了显著的进展。

以下是使用TensorFlow构建LSTM文本生成模型的简单示例。

```python

from tensorflow.keras.layers import LSTM, Dense, Embedding

from tensorflow.keras.models import Sequential

# 构建模型

model = Sequential()

model.add(Embedding(input_dim=vocab_size, output_dim=embedding_dim, input_length=max_length))

model.add(LSTM(units=128))

model.add(Dense(vocab_size, activation='softmax'))

# 编译模型

***pile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 训练模型

model.fit(input_sequences, one_hot_labels, epochs=100, verbose=1)

```

在构建文本生成模型时,我们通常需要处理输入序列数据,并将其转换为one-hot编码形式。

## 5.3 强化学习与游戏AI

强化学习是机器学习的一个分支,它关注如何让机器自主地做出决策以在特定环境中实现目标最大化。

### 5.3.1 强化学习的基本原理

在强化学习中,智能体通过与环境交互来学习。它通过尝试不同的行为并观察其结果来优化其策略。

强化学习包括了以下四个基本要素:

- 智能体(Agent):自主决策的实体。

- 环境(Environment):智能体存在的场所,它会反馈给智能体。

- 行为(Action):智能体在环境中的操作。

- 奖励(Reward):智能体收到的反馈,用于评估行为的好坏。

### 5.3.2 使用TensorFlow构建游戏AI

TensorFlow允许我们构建和训练智能体来玩各种游戏,比如Atari、Go和围棋。

构建游戏AI通常涉及到构建一个深度强化学习模型,例如深度Q网络(DQN)。以下是一个简单的DQN模型的代码结构示例。

```python

# 这里只是一个结构示例,非完整代码

class DQNAgent:

def __init__(self, state_size, action_size):

self.state_size = state_size

self.action_size = action_size

# 初始化其他变量...

def act(self, state):

# 根据当前状态选择动作

pass

def replay(self, experiences):

# 使用经验回放更新模型

pass

def learn(self, experiences, gamma):

# 学习过程

pass

# 初始化智能体

agent = DQNAgent(state_size, action_size)

for episode in range(num_episodes):

# 游戏逻辑...

# 学习过程...

```

在此代码结构中,DQNAgent类负责处理智能体的行为选择、经验回放以及学习过程。这个模型可以在训练过程中不断优化,最终实现智能决策。

在本章中,我们介绍了TensorFlow在图像识别和处理、自然语言处理以及强化学习和游戏AI中的应用。通过具体的代码示例和模型构建过程,我们展示了TensorFlow是如何在不同领域解决实际问题的。

0

0