【Keras与TensorFlow融合】:简化模型定义与训练的终极指南

发布时间: 2024-09-30 09:13:26 阅读量: 64 订阅数: 22

一个基于Qt Creator(qt,C++)实现中国象棋人机对战

# 1. Keras与TensorFlow的融合概述

在深度学习领域,Keras和TensorFlow已经成为了众多开发者和研究者的核心工具。Keras以其简洁明了的API和易于使用的特性,受到广泛的欢迎,而TensorFlow强大的计算能力和灵活性则在复杂模型和大规模部署上表现卓越。近年来,Keras与TensorFlow的融合,不仅简化了模型的构建和训练流程,还增强了开发的灵活性和模型的可部署性。

## 1.1 TensorFlow与Keras的集成方式

TensorFlow通过内置Keras API作为其高级API,实现了与Keras的无缝集成。这种集成方式允许开发者使用Keras简洁的接口来构建和训练模型,同时又能享受TensorFlow强大的计算图优化和设备兼容性优势。简单来说,TensorFlow的底层能力被Keras模型直接利用,无需额外的适配工作,从而实现了快速部署和高效率的执行。

## 1.2 融合的优势

这种融合带来的好处是显著的。首先,Keras与TensorFlow的结合让模型的构建更加直观,尤其是对于初学者和希望快速原型设计的开发者而言。其次,它还为生产环境提供了高度的可扩展性和性能优化。最终,这一组合为深度学习社区提供了一个强大而灵活的工具集,既满足了易用性需求,也保证了在实际应用中的高效率和可靠性。

# 2. Keras与TensorFlow融合的理论基础

## 2.1 TensorFlow与Keras的关系及优势

### 2.1.1 TensorFlow的架构和功能

TensorFlow是一个开源的机器学习和深度学习框架,最初由Google Brain Team开发,并于2015年开源。它的设计考虑了灵活性和可扩展性,使其能够应用于从研究到产品开发的各种任务中。TensorFlow的主要架构包括以下几个关键组成部分:

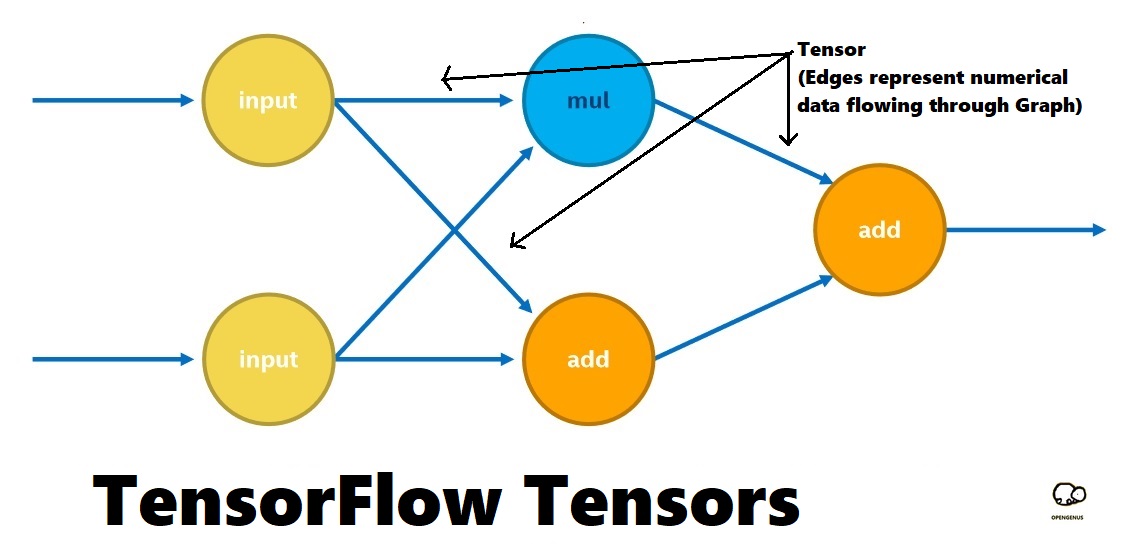

- **计算图(Graph)**:计算图定义了TensorFlow中的数据流动和计算过程。它由节点(操作/算子)和边(张量)构成,用于表示计算的逻辑结构。

- **会话(Session)**:会话用于执行图内的计算。在TensorFlow 1.x中,通常在会话中运行整个计算图,而在TensorFlow 2.x中,通过急切执行(eager execution)模式,可以更容易地进行交互式实验。

- **张量(Tensor)**:Tensor是TensorFlow中的多维数组,用于表示所有的数据。它们在计算图中流动,代表了一系列的操作结果。

TensorFlow还提供了一系列高级API,例如tf.data API用于构建灵活的数据管道,tf.keras用于构建和训练模型,以及tf.distribute用于支持分布式训练等。

#### 代码示例

以下是一个简单的TensorFlow会话运行的例子:

```python

import tensorflow as tf

# 定义一个常量张量

a = tf.constant(2.0)

b = tf.constant(3.0)

# 定义一个简单的加法操作

c = tf.add(a, b)

# 创建一个会话,并在会话中运行计算

***pat.v1.Session() as sess:

print(sess.run(c)) # 输出: 5.0

```

这段代码定义了两个常量张量,并执行了一个加法操作。`***pat.v1.Session()`用于创建一个会话实例,并在会话中运行计算。

### 2.1.2 Keras的设计哲学和适用场景

Keras最初由François Chollet于2015年发布,旨在提供一种更高级别的、用户友好的接口,使得深度学习模型的设计和实验更加迅速和简单。Keras的设计哲学强调快速实验、模块化、易用性和易扩展性。

Keras提供了以下主要特性:

- **模块化**:Keras构建模块化,可以通过组合简单的层构建复杂的模型。

- **易用性**:Keras的设计使得用户可以快速开始项目,不需要深入了解底层实现。

- **可扩展性**:Keras模型可以用作项目起点,同时也支持自定义层、模型和功能。

Keras特别适用于以下场景:

- **原型设计**:快速原型设计对于研究新的模型架构至关重要。

- **教育目的**:Keras的简洁性使其成为学习深度学习和神经网络概念的理想选择。

- **多后端支持**:Keras不仅支持TensorFlow,还支持Theano和CNTK后端,尽管现在Theano和CNTK的维护已经停止,但该功能依然有其历史价值。

#### 代码示例

这里是一个使用Keras定义一个简单的序列模型的例子:

```python

from keras.models import Sequential

from keras.layers import Dense

# 创建一个序贯模型

model = Sequential()

# 添加层

model.add(Dense(units=64, activation='relu', input_shape=(100,)))

model.add(Dense(units=10, activation='softmax'))

# 编译模型

***pile(loss='categorical_crossentropy',

optimizer='rmsprop',

metrics=['accuracy'])

# 模型摘要打印

model.summary()

```

在这个例子中,我们创建了一个序贯模型,添加了两个全连接层,并使用ReLU和Softmax激活函数。然后编译模型,并打印模型结构摘要。

## 2.2 深入理解Keras在TensorFlow中的集成方式

### 2.2.1 高层API与低层API的区别

在TensorFlow 2.x中,Keras已成为其官方高级API。这种集成带来了一系列的好处,包括:

- **高层API**:使用户可以快速构建和训练模型,非常适合快速原型设计和简单应用。

- **低层API**:提供了更大的灵活性和控制权,适合复杂模型的构建和优化。

Keras API的设计目标是通过高层抽象来简化深度学习模型的实现,同时隐藏复杂的底层细节。它为常见的操作提供便捷的封装,如激活函数、损失函数、优化器等。低层API提供了更多灵活性,允许用户自定义操作,并进行更精细的性能调优。

#### 高层API示例代码

```python

from tensorflow.keras.layers import Input, Dense

from tensorflow.keras.models import Model

# 定义输入层

inputs = Input(shape=(100,))

# 添加两个全连接层

x = Dense(64, activation='relu')(inputs)

output = Dense(10, activation='softmax')(x)

# 创建模型

model = Model(inputs=inputs, outputs=output)

```

这段代码展示了如何使用Keras的高层API定义一个简单的多层感知器(MLP)模型。

#### 低层API示例代码

```python

import tensorflow as tf

# 定义变量

W = tf.Variable(tf.random.normal([10, 1]), name='weight')

b = tf.Variable(tf.zeros([1]), name='bias')

# 构建模型的前向传播

def forward(x):

return tf.matmul(x, W) + b

x = tf.placeholder(tf.float32, shape=[None, 10])

y = forward(x)

```

在这个例子中,我们使用低层API定义了一个简单的线性模型,并手动实现了前向传播函数。

### 2.2.2 Keras后端机制详解

Keras后端机制允许用户指定Keras操作运行的后端引擎。默认情况下,Keras集成到TensorFlow后使用TensorFlow作为其后端。后端API为Keras提供了底层的数值计算功能,同时允许用户更改底层实现而不必重写整个模型。

Keras后端定义了一些关键函数,例如:

- `backend.zeros(shape, dtype=None)`:创建一个具有给定形状和类型的新张量,所有元素都设置为零。

- `backend.variable(value, dtype=None, name=None)`:将一个NumPy数组转换为一个可训练的变量。

- `backend.function(inputs, outputs, updates=None)`:将给定的输入和输出转换为TensorFlow函数。

#### 表格展示Keras后端API与TensorFlow核心API的对比

| Keras后端函数 | TensorFlow核心API对应函数 | 说明 |

| -------------- | ------------------------- | ---- |

| `backend.constant(value, dtype=None, shape=None, name=None)` | `tf.constant(value, dtype, shape, name)` | 创建一个常量张量 |

| `backend.variable(value, dtype=None, name=None)` | `tf.Variable(value, dtype, name)` | 创建一个可训练的变量 |

| `backend.dot(x, y)` | `tf.matmul(x, y)` | 矩阵乘法 |

| `backend.eval()` | `tf.Session().run()` | 在会话中运行计算 |

### 2.2.3 在TensorFlow中使用Keras的原理

Keras模型在TensorFlow中的执行原理基于图的概念。当使用Keras的高层API构建模型时,它在内部构建了一个计算图,用于定义模型的计算流程。Keras模型在编译时,会将这个图转换成TensorFlow图的一部分。然后,在训练和预测时,TensorFlow会执行这个计算图。

以下是一个内部原理的高级概述:

1. **构建模型**:在高层API中定义模型时,Keras构建了一个内部的计算图,这个图由层和操作组成。

2. **编译模型**:在编译阶段,Keras将这个内部图转换为TensorFlow图,并准备优化器、损失函数和指标。

3. **训练模型**:在训练时,通过调用`model.fit()`,Keras会在TensorFlow图中添加训练相关的操作,如梯度计算、权重更新等,然后运行整个计算图。

4. **预测和评估**:使用`model.predict()`和`model.evaluate()`时,也是基于TensorFlow的会话来执行整个计算图。

通过这种集成方式,Keras模型可以充分利用TensorFlow提供的分布式计算、设备集成(CPU/GPU/TPU)和其他低级优化功能。同时,Keras的高层抽象使得深度学习模型的构建更加简单和高效。

# 3. 简化模型定义

模型定义是机器学习和深度学习工作的核心步骤之一,它不仅需要精确表达模型的结构,而且还要足够灵活,以便根据不同的问题进行调整。Keras的设计哲学之一就是提供一种简单且强大的方式来构建神经网络。随着Keras与TensorFlow的深度融合,这一过程变得更加简便和高效。在本章中,我们将深入探讨如何使用Keras简化模型定义,包括使用其组件、自定义层和模型,以及权重初始化和正则化技术。

## 3.1 Keras的模型组件及其用法

### 3.1.1 序列模型(Sequential)与函数式API(Functional API)对比

在Keras中,定义模型主要有两种方式:序列模型(Sequential)和函数式API(Functional API)。序列模型是Keras中最简单的模型类型,特别适合快速搭建简单的层叠式网络结构。而函数式API则提供了更大的灵活性,允许构建任意复杂的模型,包括具有多个分支的网络。

#### 序列模型

序列模型可以看作是一个层的线性堆叠,每层都与前一层相连。这种方式简单直观,适合处理大多数简单的神经网络问题,例如:

```python

from keras.models import Sequential

from keras.layers import Dense, Dropout, Activation

model = Sequential([

Dense(64, input_shape=(100,)),

Activation('relu'),

Dropout(0.5),

Dense(1),

Activation('sigmoid')

])

```

在这个例子中,我们创建了一个简单的全连接神经网络,它包括一个输入层、两个隐藏层和一个输出层。

#### 函数式API

函数式API在处理复杂网络结构时更为强大,例如具有多个输入或输出的网络,或者有共享层的网络。使用函数式API,可以更容易地定义如下网络结构:

```python

from keras.layers import Input, Dense

from keras.models import Model

input_tensor = Input(shape=(100,))

x = Dense(64, activation='relu')(input_tensor)

x = Dense(64, activation='relu')(x)

output_tensor = Dense(1, activation='sigmoid')(x)

model = Model(inputs=input_tensor, outputs=output_tensor)

```

在这个例子中,我们定义了一个自定义网络,其中包含了三个全连接层。

### 3.1.2 层(Layer)和模型(Model)的基本操作

#### 层(Layer)

在Keras中,层是构建模型的基石。它们负责数据的前向传播,并且大多数层还负责后向传播和权重更新。Keras提供了丰富的层类型,包括全连接层、卷积层、循环层等。

每层都有其特定的参数,例如全连接层需要指定单元数,卷积层需要指定过滤器数量和大小等。在定义层时,还需注意其激活函数,它会应用到层的输出上,以增加模型的非线性。

#### 模型(Model)

模型是层的容器,它提供了训练、评估和预测的接口。模型的构建依赖于层的组合,而模型与层之间有紧密的联系。在Keras中,可以通过组合层来构建模型,并利用模型提供的方法进行训练和预测。

模型还负责管理数据输入和输出的流程,包括通过fit()方法训练模型、通过evaluate()方法评估模型,以及通过predict()方法进行模型预测。

```***

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10, batch_size=32)

```

在上面的代码中,我们首先编译模型,选择优化器、损失函数和评估指标,然后使用fit()方法训练模型。

## 3.2 自定义层和模型

### 3.2.1 构建自定义层的方法和应用实例

在某些情况下,标准的Keras层可能无法满足特定的需求,这时就需要构建自定义层。自定义层可以是全连接层、激活层、甚至卷积层的变种。构建自定义层需要继承`keras.layers.Layer`类,并实现以下方法:

- `build(input_shape)`: 定义层的权重。

- `call(x)`: 定义层的前向传播逻辑。

- `get_config()`: 返回层的配置信息。

下面是一个自定义层的简单例子:

```python

import keras.backend as K

from keras.layers import Layer

from keras.initializers import RandomNormal

class MyDense(Layer):

def __init__(self, units=32, activation='relu', **kwargs):

super(MyDense, self).__init__(**kwargs)

self.units = units

self.activation = keras.activations.get(activation)

def

```

0

0