【模型评估艺术】:TensorFlow中评价指标的深入分析

发布时间: 2024-09-30 09:43:56 阅读量: 34 订阅数: 36

人工智能实践:Tensorflow个人学习笔记

# 1. 模型评估的重要性与基本原则

## 1.1 模型评估的必要性

在机器学习和深度学习的领域中,模型评估是核心环节,它决定了模型的性能和泛化能力。一个经过严格评估的模型能够确保在新的、未知的数据上有着稳定和可靠的表现。只有通过评价,我们才能了解模型在解决实际问题时的真实效率,从而指导我们进行模型的优化和选择。

## 1.2 原则一:多角度评价

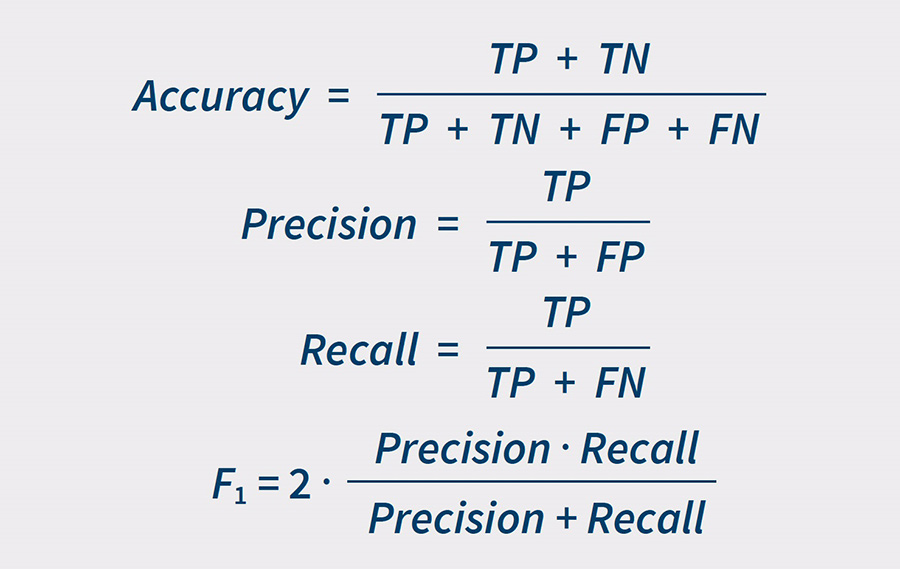

模型评价不仅仅是单一指标的比较,而是需要从多个角度综合考虑。例如,在分类问题中,仅凭准确率(Accuracy)无法全面反映模型在不同类别上的表现,还需要结合精确度(Precision)、召回率(Recall)和F1分数等指标进行评估。

## 1.3 原则二:对比基准模型

进行模型评估时,应该使用基准模型(Baseline Model)作为参考,以便能够更清楚地了解新模型与现有技术的对比性能。基准模型可以是一个简单的模型,也可以是领域内的标准模型,通过对比可以更加客观地衡量模型的有效性。

## 1.4 原则三:交叉验证与数据集划分

为了防止模型过度拟合特定的数据集,一般采用交叉验证(Cross-Validation)和将数据集划分为训练集、验证集和测试集的方法来评估模型。这种做法可以帮助我们理解模型在未见数据上的表现。

本章小结:

模型评估对于机器学习和深度学习项目至关重要。通过遵循多角度评价、使用基准模型对比以及采用交叉验证与数据集划分等原则,能够更全面、客观地衡量和优化模型性能。在后续的章节中,我们将详细探讨如何在TensorFlow中使用和实现这些评价指标,并进一步探讨评价指标的高级应用、不同领域的深入分析以及实践案例。

# 2. TensorFlow中的基本评价指标

在第二章中,我们将深入探讨TensorFlow框架中用于模型评估的基本评价指标。我们将从分类任务开始,逐步深入了解各种评价指标的定义、计算方法和应用场景。接下来,将分析回归任务中使用的指标,并对多标签分类和多类分类任务的评价指标进行探讨。

## 2.1 分类任务评价指标

在机器学习领域,分类任务是最常见的问题之一,因此评价分类模型的性能至关重要。我们将从准确度开始,逐步探讨其他常用的评价指标。

### 2.1.1 准确度(Accuracy)

准确度是衡量分类器性能最基本的指标,它反映了分类器预测正确的样本数占总样本数的比例。

```python

# 计算准确度的代码示例

from sklearn.metrics import accuracy_score

# 假设 y_true 是真实的标签列表,y_pred 是模型预测的标签列表

y_true = [0, 1, 1, 0, 1]

y_pred = [0, 1, 0, 0, 1]

# 计算准确度

accuracy = accuracy_score(y_true, y_pred)

print(f"Accuracy: {accuracy}")

```

在上述代码中,我们使用了`accuracy_score`函数来计算准确度。该函数接受两个参数:`y_true`是真实的标签列表,而`y_pred`是模型预测的标签列表。函数返回的是一个浮点数,表示准确度。

### 2.1.2 精确度(Precision)和召回率(Recall)

精确度和召回率是衡量分类模型性能的两个重要指标,尤其适用于二分类问题。

```python

from sklearn.metrics import precision_score, recall_score

# 计算精确度和召回率

precision = precision_score(y_true, y_pred)

recall = recall_score(y_true, y_pred)

print(f"Precision: {precision}")

print(f"Recall: {recall}")

```

在这段代码中,我们使用了`precision_score`和`recall_score`函数分别计算精确度和召回率。这些函数同样需要真实的标签和预测的标签作为参数,并返回相应的分数。

### 2.1.3 F1分数和混淆矩阵(Confusion Matrix)

F1分数是精确度和召回率的调和平均,它综合考虑了两者,尤其适用于标签分布不平衡的情况。混淆矩阵则是可视化评价分类模型性能的有力工具。

```python

from sklearn.metrics import f1_score, confusion_matrix

# 计算F1分数

f1 = f1_score(y_true, y_pred)

# 生成混淆矩阵

conf_matrix = confusion_matrix(y_true, y_pred)

print(f"F1 Score: {f1}")

print(f"Confusion Matrix:\n{conf_matrix}")

```

在这段代码中,我们使用了`f1_score`函数来计算F1分数,并用`confusion_matrix`函数生成混淆矩阵。F1分数会返回一个浮点数,而混淆矩阵则是一个二维数组,可以帮助我们理解模型在不同类别上的表现。

#### 表格:混淆矩阵解析

混淆矩阵对于理解模型的预测情况非常有帮助。让我们通过一个简化的表格来分析其构成:

| 真实\预测 | 预测为正 | 预测为负 |

|-----------|----------|----------|

| 真实为正 | TP | FN |

| 真实为负 | FP | TN |

其中:

- TP (True Positive):模型正确预测为正类的数量。

- FP (False Positive):模型错误预测为正类的数量。

- FN (False Negative):模型错误预测为负类的数量。

- TN (True Negative):模型正确预测为负类的数量。

通过混淆矩阵,我们可以直接计算出精确度和召回率,以及其他一些评价指标,如特异度(Specificity)。

通过本章的介绍,我们了解了TensorFlow中用于分类任务的基本评价指标。在接下来的章节中,我们将继续探讨回归任务和多类分类任务中的评价指标,以及如何在实际项目中应用这些指标。

# 3. TensorFlow评价指标高级应用

## 3.1 自定义评价指标

### 3.1.1 自定义指标的必要性

在深度学习领域,尤其是在复杂的业务场景中,内置的评价指标可能无法完全满足我们的需求。某些特定的问题可能需要更为复杂和精细的评价指标。在这些情况下,自定义评价指标显得尤为重要。自定义指标能够帮助我们更加准确地测量模型性能,以及更好地解决特定问题。

例如,在金融领域,模型对异常值的预测能力可能比一般的准确度更为重要。在医疗领域,模型对特定疾病的检测准确度可能会比整体的预测准确度更有价值。这些场合就需要我们根据问题的实际需求来自定义评价指标。

### 3.1.2 创建和实现自定义指标

在TensorFlow中,我们可以通过继承`tf.keras.metrics.Metric`类来创建一个自定义的评价指标。自定义指标的实现需要定义状态变量、更新操作和最终的计算结果。

下面是一个自定义评价指标的例子——`CustomF1Score`,它根据`precision`和`recall`计算F1分数:

```python

import tensorflow as tf

class CustomF1Score(tf.keras.metrics.Metric):

def __init__(self, name='custom_f1_score', **kwargs):

super(CustomF1Score, self).__init__(name=name, **kwargs)

self.precision = self.add_weight(name='precision', initializer='zeros')

self.recall = self.add_weight(name='recall', initializer='zeros')

self.total = self.add_weight(name='total', initializer='zeros')

def update_state(self, y_true, y_pred, sample_weight=None):

# ...实现逻辑,根据真实值和预测值更新precision和recall...

pass

def result(self):

# ...计算F1分数...

return self.total > 0 and 2 * self.precision * self.recall / (self.precision + self.recall)

def reset_states(self):

# ...重置状态...

pass

```

0

0