【GPU加速深度学习】:TensorFlow性能优化技巧

发布时间: 2024-09-30 09:04:15 阅读量: 33 订阅数: 36

EffectiveTensorflow:TensorFlow教程和最佳实践

# 1. 深度学习与GPU加速基础

## 深度学习的基本概念和模型

深度学习是一类特殊的机器学习技术,它模仿人脑对数据进行处理的机制,通过构建深层的神经网络模型来学习数据的层次结构特征。这些模型通常由多层的神经元组成,每层可以处理输入数据的不同级别特征。在视觉、语音识别、自然语言处理等领域,深度学习模型如卷积神经网络(CNN)、循环神经网络(RNN)和最近热门的Transformer模型,都取得了卓越的成就。

## GPU加速的重要性与工作原理

GPU加速在深度学习中扮演着至关重要的角色,因为它能够显著提升计算速度,使得复杂模型的训练和推理过程得以在合理的时间内完成。GPU,或者说图形处理单元,是由成千上万个核心组成的处理器,这些核心设计用来并行处理图形渲染任务,因此它们在处理大规模矩阵和向量运算时也表现出色。在深度学习中,这些运算大量存在于前向传播和反向传播过程中。

## 深度学习框架简介及其在GPU上的支持

为了简化模型的构建、训练和部署过程,深度学习框架如TensorFlow、PyTorch等应运而生。这些框架支持自动求导、多设备计算和高效的模型存储,极大地降低了深度学习的应用门槛。它们通常都提供了对GPU加速的良好支持,这意味着模型可以在GPU上运行,从而利用GPU强大的并行计算能力显著提升计算效率。开发者只需要在框架中指定使用GPU设备,框架就会自动处理模型和数据的迁移,使得GPU加速变得十分简便。

# 2. TensorFlow架构和核心组件

### TensorFlow的计算图和会话概念

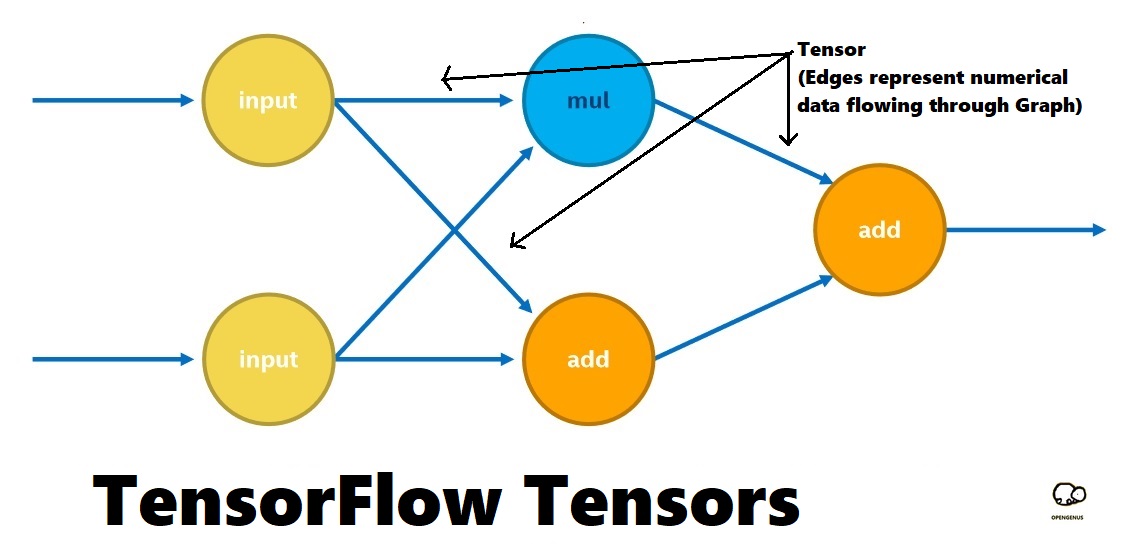

TensorFlow的计算图是其核心概念之一,它是一种有向无环图(DAG),表示计算过程中操作和数据流之间的依赖关系。每个节点代表一个数学操作,而边则表示节点之间的多维数据数组,即张量(Tensor)。计算图定义了一个模型的结构,但它不会立即执行计算。实际的计算发生在创建会话(Session)之后,会话负责运行计算图并处理数据。

```python

import tensorflow as tf

# 定义一个简单的计算图

a = tf.constant(2.0)

b = tf.constant(3.0)

c = a * b

# 创建会话来执行计算图

with tf.Session() as sess:

print(sess.run(c)) # 输出结果:6.0

```

在上述代码中,我们首先定义了两个常量`a`和`b`,然后定义了一个乘法操作`c`。通过会话`sess`运行计算图后,我们得到了`c`的值。

### TensorFlow的数据流模型

TensorFlow中的数据流模型是一种实现高效计算的有效方式。它将计算任务分解为一系列小任务,并将它们分配到不同的设备(如CPU或GPU)上执行。这种模型特别适合于深度学习,因为深度学习模型通常包含大量并行计算。

数据流模型通过将数据传输和操作绑定在一起,能够实现高效的数据重用。当一个节点需要数据时,它会请求上游节点,直到数据被产生。一旦数据被计算出来,它会被缓存起来,以便下游节点可以直接使用,而无需重新计算。

```python

# 使用数据流模型进行矩阵乘法

matrix1 = tf.random_normal([10, 10])

matrix2 = tf.random_normal([10, 10])

product = tf.matmul(matrix1, matrix2)

# 在会话中运行并打印结果

with tf.Session() as sess:

result = sess.run(product)

print(result)

```

在该示例中,`tf.matmul`函数定义了一个矩阵乘法操作,它是一个计算密集型的操作。在TensorFlow中,这样的操作会被添加到数据流图中,并在会话中执行。由于数据流模型的特性,如果`matrix1`或`matrix2`在后续操作中被重复使用,它们的计算结果会被缓存,无需重新计算,从而提高了效率。

## TensorFlow性能评估指标

### 吞吐量和延迟

在衡量TensorFlow性能时,吞吐量和延迟是最为关键的两个指标。吞吐量通常指的是单位时间内完成的任务数量,而延迟则是完成单一任务所需的平均时间。

- **吞吐量(Throughput)**:通常用每秒处理的图片数量(images/sec)来衡量。高吞吐量意味着模型能更快地处理数据,适合于大规模数据处理或实时应用。

- **延迟(Latency)**:指的是从输入数据到输出结果的总时间。对于需要快速响应的应用(如在线推荐系统),低延迟是至关重要的。

```python

import time

# 创建一个简单的模型用于测试性能

input = tf.random_normal([1000, 1000])

weights = tf.random_normal([1000, 1000])

bias = tf.random_normal([1000])

@tf.function

def model(input, weights, bias):

return tf.matmul(input, weights) + bias

# 测试吞吐量

start_time = time.time()

for _ in range(100):

model(input, weights, bias)

end_time = time.time()

throughput = 100 / (end_time - start_time)

print("Throughput: {:.2f} images/sec".format(throughput))

# 测试延迟

input_data = tf.random.normal([1, 1000])

start_time = time.time()

result = model(input_data, weights, bias)

latency = time.time() - start_time

print("Latency: {:.2f} sec/image".format(latency))

```

### 内存使用和模型大小

内存使用是影响模型训练和推理性能的重要因素,特别是在有限的硬件资源环境下。TensorFlow会根据计算图中定义的操作和张量来分配内存。

- **内存使用(Memory Usage)**:指的是在执行模型时消耗的内存总量。在资源受限的情况下,减少内存使用可以提高训练的可扩展性。

- **模型大小(Model Size)**:表示模型文件的大小,这通常影响模型的加载时间和部署方便性。

```python

# 检查内存占用情况

g = tf.Graph()

with g.as_default():

input = tf.random_normal([1000, 1000])

weights = tf.random_normal([1000, 1000])

bias = tf.random_normal([1000])

model = model(input, weights, bias)

# 使用tf.Session来检查内存占用

***pat.v1.Session(graph=g) as sess:

print("Memory usage:", sess.run(***pat.v1.report_memory_usage()))

```

在上面的代码片段中,我们首先构建了一个模型并创建了一个TensorFlow会话。然后,我们使用`tf.report_memory_usage`函数来检查内存占用情况。这个信息可以帮助开发者优化模型,例如通过减少张量大小或重新设计模型结构来减少内存的使用。

## TensorFlow性能优化入门

### 硬件配置与资源分配

在构建深度学习模型时,合理配置硬件资源对性能有显著影响。特别是对于GPU加速,选择合适的GPU硬件配置至关重要。GPU的数量、核心频率、内存大小以及与CPU的互联带宽都是影响性能的关键因素。

- **GPU数量**:多GPU可以同时进行训练,缩短训练时间,但也会增加数据同步的复杂性。

- **内存大小**:足够的GPU内存可以处理更大的模型和批量数据,但这需要根据实际需求来平衡。

资源分配包括分配内存、处理单元以及如何在多个GPU之间分配工作负载。在TensorFlow中,可以通过设置环境变量`CUDA_VISIBLE_DEVICES`来控制GPU的使用,或者在代码中动态指定。

```python

import os

os.environ['CUDA_VISIBLE_DEVICES'] = "0,1" # 限制TensorFlow只使用编号为0和1的GPU

# 检查可用的GPU设备

from tensorflow.python.client import device_lib

def get_available_gpus():

local_device_protos = device_lib.list_local_devices()

return [x.name for x in local_device_protos if x.device_type == 'GPU']

print(get_available_gpus())

```

### 常见的性能瓶颈及解决方法

在使用TensorFlow时,性能瓶颈可能出现在多个层面。开发者需要识别并解决这些问题来提高性能。

- **数据瓶颈**:如果数据加载和预处理的速度跟不上模型的处理速度,那么模型的训练将会受到限制。

- **计算瓶颈**:模型中的某些操作(如复杂层或矩阵乘法)可能非常耗时。

解决方法可能包括:

- **数据预处理并行化**:使用多线程或异步IO来加快数据预处理速度。

- **使用高效的算子**:TensorFlow提供了许多高度优化的算子,合理使用它们可以提升性能。

- **模型剪枝和量化**:通过减少模型参数或使用低精度数据类型来减小模型大小。

```python

# 使用异步IO来加速数据输入

def input_fn():

dataset = tf.data.Dataset.from_tensor_slices((input_tensor, label_tensor))

data

```

0

0