【性能改进】:大数据排序过程中MapReduce Shuffle的优化方法(专家指南)

发布时间: 2024-10-30 15:28:32 阅读量: 4 订阅数: 10

# 1. 大数据排序与MapReduce Shuffle基础

大数据排序是处理大规模数据集时的一个关键过程,它在数据预处理、数据挖掘及分析等多个领域中扮演着重要角色。作为大数据处理的基石之一,MapReduce编程模型中的Shuffle机制对于数据排序来说至关重要。Shuffle是MapReduce中将Map任务的输出传递给Reduce任务的过程,是整个任务处理流程中最为复杂的阶段之一。

## 1.1 MapReduce Shuffle的作用

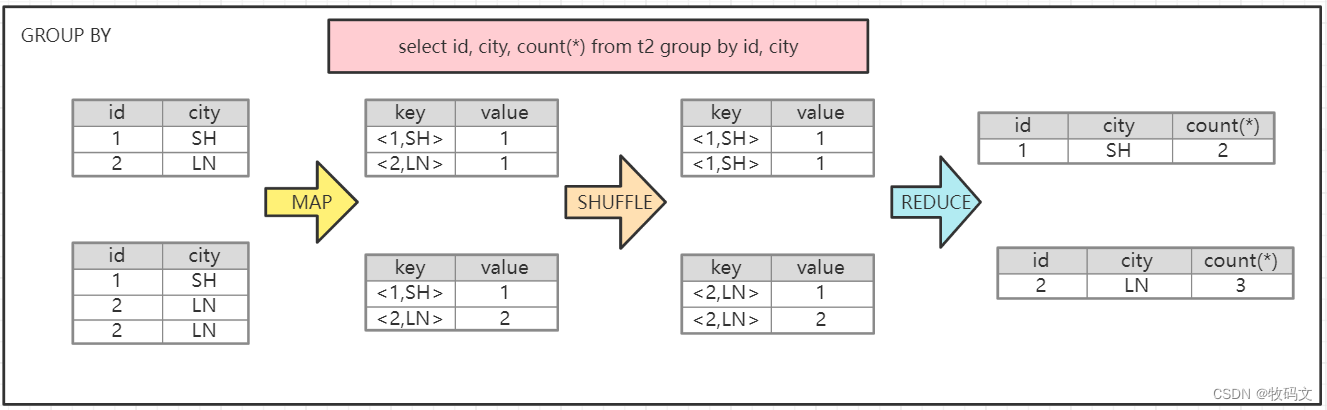

MapReduce Shuffle的作用是将Map端处理后的中间数据按照key值分区,并有序地传输到Reduce端。Shuffle过程不仅涉及数据的排序和合并,还负责网络传输、磁盘读写以及内存管理等资源的协调。这确保了Reduce任务可以高效地执行聚合、合并和最终的数据分析工作。

## 1.2 Shuffle的数据排序原理

在Shuffle过程中,数据排序通常发生在Map端和Reduce端,但它们的原理略有不同。Map端排序发生在内存中,它将数据组织为有序的键值对集合,这些集合被写入到磁盘之前通常会进行压缩。而Reduce端排序发生在磁盘上,它会读取来自Map端的数据文件,进行合并排序,并准备最终的数据处理。

理解Shuffle的过程及其关键作用,对于深入掌握大数据处理的原理和优化大数据排序性能至关重要。在接下来的章节中,我们将深入探讨Shuffle的理论基础和实践优化技巧。

# 2. MapReduce Shuffle的关键理论

在大规模数据处理领域,MapReduce编程模型为分布式计算提供了一个强有力的抽象,而Shuffle过程是该模型的核心,它负责在Map和Reduce阶段之间传输数据。了解Shuffle的内部工作机制对于优化大数据处理性能至关重要。本章将深入探讨MapReduce Shuffle的关键理论,包括数据流模型、性能瓶颈及其背后的原理。

## 2.1 Shuffle的数据流模型

数据流模型是理解Shuffle过程的起点。MapReduce的数据流模型可以被拆分为两个主要部分:Map端Shuffle和Reduce端Shuffle。二者通过网络传输数据,形成一个完整的大数据处理流程。

### 2.1.1 Map端Shuffle原理

在Map端,数据处理通常包括以下几个关键步骤:

1. **输入数据读取**:Map任务从分布式文件系统(如HDFS)读取输入数据块。

2. **Map处理**:用户定义的Map函数处理输入数据,生成键值对(key-value pairs)。

3. **中间数据排序和合并**:Map任务对输出的中间键值对进行排序和合并,确保相同键的数据被归并在一块,便于后续的Shuffle操作。

4. **写入磁盘**:排序合并后的中间数据被写入本地磁盘。

为了提高Map端的效率,需要着重考虑数据的序列化方式、压缩以及内存管理等问题。这些因素直接影响着Map端Shuffle的性能。

```mermaid

graph LR

A[读取输入数据] --> B[Map处理]

B --> C[排序合并]

C --> D[写入磁盘]

```

### 2.1.2 Reduce端Shuffle原理

Reduce端Shuffle主要包括以下几个步骤:

1. **数据拉取**:Reduce任务从各个Map任务的输出中拉取对应的数据。

2. **数据合并**:Reduce端读取并合并拉取的数据,这些数据已按照键排序,因此合并操作相对高效。

3. **用户定义的Reduce处理**:Reduce函数对合并后的数据进行处理,输出最终结果。

需要注意的是,Reduce端的网络I/O和磁盘I/O往往是性能瓶颈。因此,合理的资源分配和数据分区策略至关重要。

```mermaid

graph LR

A[数据拉取] --> B[数据合并]

B --> C[用户定义的Reduce处理]

```

## 2.2 Shuffle的性能瓶颈

Shuffle过程中的性能瓶颈主要与网络I/O、磁盘I/O以及CPU和内存资源的限制有关。

### 2.2.1 网络I/O的限制

在网络I/O方面,大量的小文件传输会消耗更多带宽资源,导致网络拥塞。优化网络I/O瓶颈通常需要进行数据倾斜处理和优化Map输出数据的压缩。

### 2.2.2 磁盘I/O的限制

磁盘I/O瓶颈通常由Map端或Reduce端的磁盘读写操作频繁引起。优化磁盘I/O的方式包括增加磁盘缓存大小、使用更快的磁盘类型(如SSD),以及减少磁盘I/O请求的次数。

### 2.2.3 CPU和内存资源的限制

对于CPU和内存资源的限制,可以通过分配更多的资源给Map和Reduce任务来缓解。此外,优化数据处理算法、压缩算法也能有效减少对CPU和内存的依赖。

通过对这些关键理论的深入理解,工程师们可以更好地把握MapReduce Shuffle的工作机制,从而在实际工作中进行有效的性能优化。在第三章,我们将进一步深入探讨MapReduce Shuffle实践优化的技巧,揭示如何在实际应用场景中提高大数据处理的效率。

# 3. MapReduce Shuffle实践优化技巧

## 3.1 Map端优化策略

### 3.1.1 合理设置Map任务的内存大小

Map任务在处理大数据集时对内存的需求较高,因此合理设置M

0

0