深入浅出MapReduce:掌握分区机制的六个关键点

发布时间: 2024-11-01 04:44:29 阅读量: 35 订阅数: 38

# 1. MapReduce编程模型概述

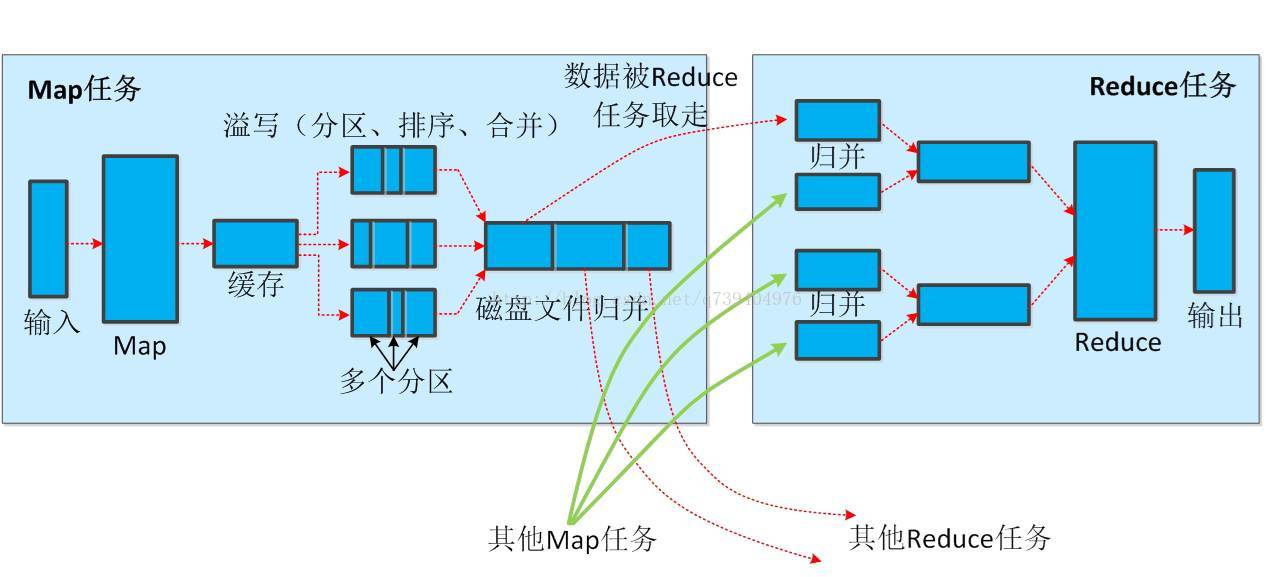

MapReduce是一种编程模型,用于处理和生成大数据集的分布式算法。它由Google提出,Hadoop框架以之为蓝本,MapReduce将计算任务分为两个阶段:Map阶段和Reduce阶段。在Map阶段,输入数据被处理成键值对,接着这些中间键值对会被传递给Reduce阶段,在这里,相同键的所有值会被合并处理,生成最终的结果输出。

在MapReduce模型中,开发者只需关注Map函数和Reduce函数的逻辑实现,而数据的分配、任务调度和容错处理则由底层的MapReduce框架负责。MapReduce提供了一个高度抽象的接口,它隐藏了分布式计算中的复杂性,同时使处理大数据变得更为高效。

MapReduce模型之所以强大,在于它的可扩展性和容错性。它能在廉价的硬件集群上扩展到成千上万个节点,且能够处理节点故障。这使得企业能够在成本可控的前提下处理海量数据,从而在数据分析、数据仓库等领域获得了广泛应用。随着大数据技术的不断演进,MapReduce依然是其中的核心技术之一。

# 2. MapReduce分区机制基础

MapReduce作为一种分布式计算框架,其数据处理能力在很大程度上取决于对数据的分区处理。合理利用MapReduce的分区机制,可以提高数据处理的效率,优化资源使用,并确保负载均衡。以下我们将深入探讨MapReduce分区机制的基础知识,包括其概念、作用、算法、以及与排序的关系。

### 2.1 分区机制的概念与作用

#### 2.1.1 分区在数据处理中的重要性

在MapReduce框架中,数据首先被切分为多个小块(分片),然后每个分片独立地进行Map操作。数据在Map阶段完成后,需要进行Shuffle过程,将数据根据键值对转移到Reduce阶段进行处理。分区机制就是在Shuffle过程中,决定数据如何被分配给各个Reduce任务的关键步骤。正确的分区策略可以确保数据被均匀地分配到各个Reducer,避免数据倾斜和热点问题,从而提升整体的数据处理效率。

分区的另一个重要作用是在分布式环境中保证数据处理的负载均衡。如果分区策略设计得当,那么每个Reducer任务处理的数据量将大致相等,使得集群中的计算资源得到充分利用。

#### 2.1.2 分区操作的基本流程

分区操作通常发生在Map任务输出之后,Shuffle之前。在Hadoop的MapReduce实现中,分区器根据用户定义的逻辑将Map输出的键值对分配给特定的Reducer。基本流程如下:

1. **Map输出键值对**:每个Map任务完成后,其输出结果为一系列键值对。

2. **分区过程**:MapReduce框架会调用分区器,将所有Map输出的键值对根据键的值分配到不同的分区中。

3. **Shuffle**:经过分区处理后的数据会通过网络传输到目标Reducer节点上。Shuffle过程保证了每个Reducer接收到自己负责处理的键值对。

4. **Reduce处理**:每个Reducer开始处理其分配到的数据,执行Reduce函数。

### 2.2 MapReduce分区算法

#### 2.2.1 默认分区器的工作原理

在Hadoop中,如果开发者没有指定自定义分区器,MapReduce会使用默认的分区器。默认分区器通常基于哈希函数将键值对分配给Reducer,其分配策略取决于Map任务的输出数量和Reduce任务的数量。具体来说,默认分区器会为每个键计算一个哈希值,然后对Reducer的数量取模,最后结果相同的键值对会被发送到同一个Reducer。

在大多数情况下,Hadoop的默认分区器能够正常工作,但当数据分布不均匀时,可能会引起某些Reducer任务过载,而其他Reducer则相对较空闲,造成资源的浪费和处理时间的延长。

#### 2.2.2 自定义分区器的设计要点

开发者可以实现自定义分区器来控制键值对如何分配给各个Reducer。设计自定义分区器时,有几个要点需要考虑:

- **分区键的选择**:选择合适的键值作为分区依据是设计自定义分区器的第一步,应该根据数据的特性来确定。

- **分区数量的确定**:分区数量不一定和Reducer数量一致。在某些情况下,增加分区数量可以改善负载均衡。

- **均匀性保障**:分区器的目标是尽可能确保每个Reducer获得相同数量的数据,避免数据倾斜。

- **可读性和维护性**:分区逻辑应清晰易懂,以便于未来的维护和优化。

### 2.3 分区器与排序的关系

#### 2.3.1 排序和分区的交互

在MapReduce中,分区和排序是紧密关联的。分区在排序之后进行,也就是说,在键值对被分配到特定的Reducer之前,首先要进行排序。排序通常是根据键值对的键进行的,对于同一个键值的所有数据,它们会被排序后一起发送到同一个Reducer。

排序过程确保了每个分区中的数据都是有序的,这为后续的合并操作打下了基础。对于一些需要进行排序处理的场景,分区器的逻辑也会影响到排序的效率,特别是在处理大量数据时。

#### 2.3.2 如何优化分区以改善排序效率

要优化分区以改善排序效率,可以从以下几个方面着手:

- **合理选择分区键**:选择一个合适的键作为分区依据是优化的第一步,应尽量减少排序所需的计算量。

- **调整分区数量**:适当增加分区数量,可以减少每个分区中的数据量,从而减少排序所需的时间。

- **分区与内存使用**:合理控制分区大小,保证分区数据能够尽可能地在内存中完成排序,避免大量的磁盘I/O操作,这可以通过调整JVM堆大小和合理配置MapReduce作业参数来实现。

在了解了MapReduce分区机制的概念、作用、算法和与排序的关系之后,接下来的章节将重点介绍分区实践中的策略和技巧,以及如何解决实际问题。

以上内容展示了MapReduce分区机制的基础,从概念到具体实现,再到其与排序的关系,涵盖了分区在数据处理中的重要性及如何优化分区以提高整体计算效率。接下来,我们将在第三章中深入讨论分区实践,并提供具体的案例分析和代码实现,帮助读者进一步理解并掌握MapReduce分区机制的应用。

# 3. MapReduce分区实践

在分布式数据处理领域,MapReduce框架凭借其出色的可伸缩性和容错机制,已经成为处理大数据的主流技术之一。分区实践在MapReduce中占据着举足轻重的地位,它不仅影响数据的分布,还直接关联到数据处理的效率。本章将深入探讨分区对数据分布的影响,分享分区策略的优化技巧,并通过实践案例展示如何实现自定义分区器。

## 3.1 理解分区对数据分布的影响

### 3.1.1 数据倾斜的问题及其影响

数据倾斜是MapReduce处理过程中经常遇到的问题,它是指在Map或者Reduce阶段,某些任务处理的数据量远远大于其他任务,导致资源分配不均和处理速度的下降。数据倾斜通常发生在键值分布极度不均匀的情况下,导致部分任务很快完成,而其他任务则因为数据量过大而成为瓶颈。

在实际应用中,数据倾斜会导致任务处理时间不一致,影响整体作业的执行效率。如果处理不当,倾斜现象甚至会造成某些任务节点的过载,引发系统不稳定。

### 3.1.2 如何诊断和处理数据倾斜

诊断数据倾斜的方法多种多样,其中最直接的是通过观察Map和Reduce任务的执行时间来分析。如果发现某些任务的执行时间异常长,那么很可能存在数据倾斜。

处理数据倾斜通常可以从以下几个方面入手:

- **重新设计键值**:重新设计数据的键值分布,使其更加均匀。

- **合并小文件**:减少输入数据的小文件数量,以减少Map任务的个数,提高数据处理效率。

- **增加自定义分区器**:通过自定义分区逻辑,确保数据均匀分布在各个Map和Reduce任务中。

- **过滤异常值**:对于异常的大量数据,可以通过过滤或预处理的方式将其分配到单独的任务中处理。

## 3.2 分区策略的优化技巧

### 3.2.1 常见的分区优化方法

为了优化分区策略,通常采用以下几种方法:

- **自定义分区器**:根据业务需求和数据特点,设计并实现自定义分区器,以更精细地控制数据流向。

- **数据预处理**:在MapReduce作业开始之前,对数据进行预处理,以减少倾斜现象的发生。

- **负载均衡**:通过监控和调整资源分配,确保所有任务处理均衡,避免资源浪费。

### 3.2.2 案例分析:特定场景下的分区优化

在电商网站的订单处理中,订单数据通常以用户ID作为键值。但是,某些热门用户的订单量可能远超其他

0

0