MapReduce分区机制揭秘:作业效率提升的关键所在

《MapReduce精粹:切片机制揭秘与实践指南》

1. MapReduce分区机制概述

MapReduce是大数据处理领域的一个核心概念,而分区机制作为其关键组成部分,对于数据处理效率和质量起着决定性作用。在本章中,我们将深入探讨MapReduce分区机制的工作原理以及它在数据处理流程中的基础作用,为后续章节中对分区策略分类、负载均衡、以及分区故障排查等内容的讨论打下坚实的基础。

MapReduce的分区操作是将Map任务的输出结果根据一定规则分发给不同的Reduce任务的过程。合理的分区策略可以确保数据均匀分布在各个Reduce任务中,从而减少数据倾斜的可能性,提高数据处理的整体效率。在了解分区机制后,可以更好地实施负载均衡策略,并在实际应用中优化MapReduce作业性能。

2. 分区机制的理论基础

2.1 MapReduce的核心概念

2.1.1 Map和Reduce任务的流程

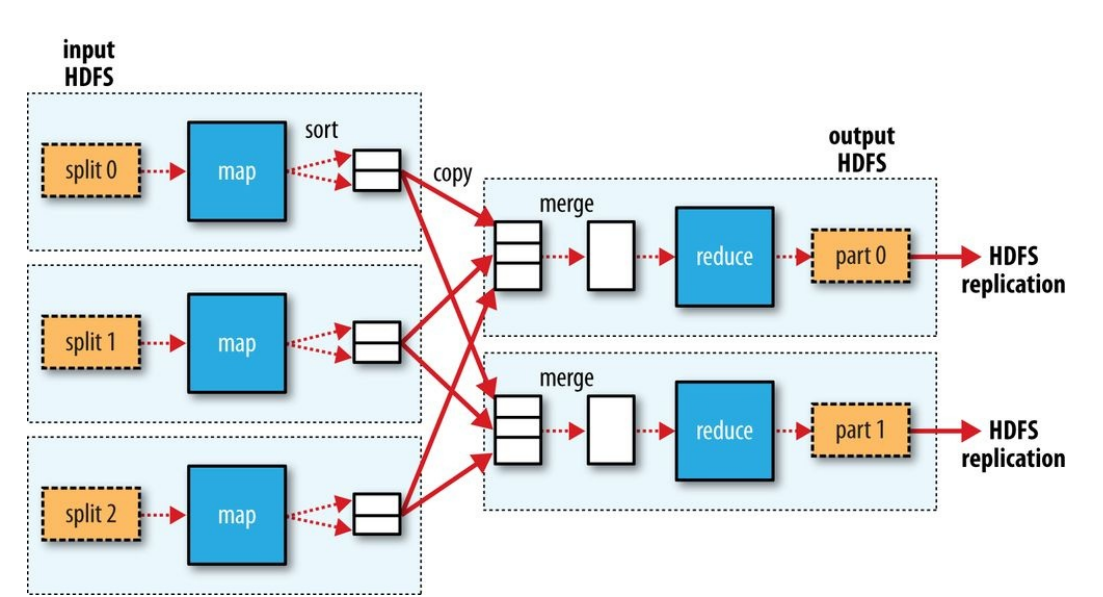

MapReduce是一种编程模型,用于处理大规模数据集的并行运算。一个MapReduce作业主要包含两个阶段:Map阶段和Reduce阶段。

在Map阶段,输入数据被分割成多个小数据块(通常称为分片),每个分片由一个Map任务处理。Map任务的输入是键值对(key-value pairs),Map函数处理这些输入并输出中间键值对。

- // Java中Map函数的一个简化示例

- public class WordCount {

- public static class MapClass extends MapReduceBase implements Mapper<LongWritable, Text, Text, IntWritable> {

- private final static IntWritable one = new IntWritable(1);

- private Text word = new Text();

- public void map(LongWritable key, Text value, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {

- String[] words = value.toString().split("\\s+");

- for (String str : words) {

- word.set(str);

- output.collect(word, one);

- }

- }

- }

- }

Map函数的输出会被排序,并且相同key的键值对会被分配到同一个Reduce任务。

在Reduce阶段,所有具有相同key的中间键值对会被聚合在一起,并传递给Reduce函数处理。Reduce函数再次输出键值对,最终结果会被写入到输出文件系统中。

- // Java中Reduce函数的一个简化示例

- public static class ReduceClass extends MapReduceBase implements Reducer<Text, IntWritable, Text, IntWritable> {

- public void reduce(Text key, Iterator<IntWritable> values, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {

- int sum = 0;

- while (values.hasNext()) {

- sum += values.next().get();

- }

- output.collect(key, new IntWritable(sum));

- }

- }

2.1.2 分区在网络数据处理中的作用

在MapReduce的上下文中,分区扮演着关键角色。它负责将Map阶段的输出按键值分配给Reduce任务,确保具有相同key的数据在同一个Reduce任务中进行处理。这种分配是通过分区函数来实现的,分区函数根据key计算出一个整数值,并决定这条记录将被发送到哪一个Reducer。

分区策略确保了数据处理的局部性,并允许跨集群节点的负载均衡。如果一个分区策略设计得当,它可以有效地减少网络传输开销,提高集群的吞吐量,并且对于最终结果的准确性是至关重要的。

2.2 分区策略的分类与原理

2.2.1 默认分区策略

默认分区策略(也称为哈希分区策略)是一种最常见和简单的分区策略。它是基于key的哈希值来将记录分配给reducers。具体来说,它将key的哈希值与可用reducers数量进行取模操作,以决定数据应该被送往哪个reducer。

默认分区策略具有以下特点:

- 实现简单,易于理解。

- 通常能保证数据在reducer之间的均匀分布。

然而,默认分区策略可能不会考虑数据的分布不均匀问题(如有的key出现频率远高于其他key),这可能会导致某些reducers比其他reducers处理更多的数据,从而形成"hot spot"。

- # Python中使用默认哈希分区的示例

- def hash_partition(key, num_reduce_tasks):

- return hash(key) % num_reduce_tasks

2.2.2 自定义分区策略的原理

自定义分区策略允许开发者根据实际需要设计更复杂的逻辑。例如,可以考虑key的范围或者特定业务场景下数据的分布特性来设计分区函数。自定义分区策略能够更精细地控制数据如何在网络中流动,特别是在数据倾斜的情况下,能够有效避免"hot spot"问题。

自定义分区策略需要开发者深入理解数据特性和业务逻辑,使得可以针对不同的应用场景设计出最适合的分区策略。例如,在处理具有明显数据分布不均匀性的场景时,可以采用范围分区或者散列分区的结合策略。

- // Java中自定义分区策略的一个示例

- public class CustomPartitioner extends Partitioner<Text, IntWritable> {

- @Override

- public int getPartition(Text key, IntWritable value, int numPartitions) {

- // 假设根据key的首字母进行分区

- char firstLetter = key.charAt(0);

- if (firstLetter >= 'a' && firstLetter < 'm') {

- return 0;

- } else if (firstLetter >= 'm' && firstLetter <= 'z') {

- return 1;

- }

- return numPartitions; // 如果不在指定范围内,分配到默认的最后一个partition

- }

- }

2.3 分区与负载均衡

2.3.1 负载均衡的定义和重要性

负载均衡指的是在多个处理节点之间分配任务,以确保所有节点的使用率大致相同,避免某些节点过载而其他节点空闲的情况。在MapReduce环境中,负载均衡意味着Map和Reduce任务在集群中的合理分布。

负载均衡对MapReduce作业的性能至关重要,因为它决定了集群资源的利用率。在理想情况下,负载均衡能够最大化作业的吞吐量并减少完成时间。

2.3.2 分区对负载均衡的影响

分区策略直接影响负载均衡的质量。如果分区策略设计得当,它可以减少数据倾斜,确保每个Reducer接收到的数据量大致相同,从而在节点间实现负载均衡。

数据倾斜指的是数据在网络中分配不均,导致某些节点处理的数据量远大于其他节点,这会导致作业执行时间延长和资源浪费。

为了优化负载均衡,开发者需要:

- 分析数据特征,了解数据分布情况。

- 调整分区函数,可能需要结合默认分区与自定义分区策略来实现最优分配。

- 监控MapReduce作业的执行情况,适时进行调整和优化。

graph LR

A[开始] --> B[理解数据特征和分布