PyTorch CNN组件深度解读:构建高效网络架构的秘诀

发布时间: 2024-12-11 13:23:20 阅读量: 1 订阅数: 11

pytorch-cnn-visualizations:卷积神经网络可视化技术的Pytorch实现

# 1. PyTorch CNN组件的基本概念和原理

## 1.1 CNN的起源与定义

卷积神经网络(Convolutional Neural Networks,简称CNN)是一种深度学习模型,主要用于处理具有类似网格结构的数据,如图像(二维网格结构)和视频(三维网格结构)。CNN通过模拟人类视觉系统的工作方式,可以自动并有效地从图像数据中学习特征,并用这些特征进行图像分类、目标检测等任务。它之所以能够高效地处理图像,是因为它能通过局部感受野、权值共享和下采样等机制显著减少模型参数。

## 1.2 CNN的工作流程

一个典型的CNN模型包括多个卷积层(Convolutional Layers)、池化层(Pooling Layers)和全连接层(Fully Connected Layers)。卷积层负责特征提取,池化层则减小数据的空间大小以减少参数数量和计算量,全连接层则负责将提取的特征映射到最终的输出结果。在PyTorch中,这些层可以通过简单的模块调用实现,并通过反向传播算法进行训练。

### 示例代码展示:

```python

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义一个简单的CNN网络

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(in_channels=1, out_channels=32, kernel_size=3, stride=1, padding=1)

self.pool = nn.MaxPool2d(kernel_size=2, stride=2, padding=0)

self.fc = nn.Linear(32 * 7 * 7, 10) # 假设输入图像是28x28

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = x.view(-1, 32 * 7 * 7) # 展平特征图以用于全连接层

x = self.fc(x)

return x

```

此代码块展示了如何使用PyTorch定义一个简单的CNN结构。其中包括一个卷积层和一个池化层,以及一个全连接层用于分类任务。通过这种方式,我们可以构建更加复杂的网络来处理实际问题。

# 2. PyTorch CNN组件的核心技术

## 2.1 卷积层的实现和优化

### 2.1.1 卷积层的工作原理

卷积层是卷积神经网络(CNN)中最为核心的组件之一。它的设计灵感来源于生物学中的感受野概念,是图像处理领域中一种有效的特征提取方法。在PyTorch中,卷积层可以通过`nn.Conv2d`模块实现。卷积层通过一系列可学习的卷积核在输入图像上滑动,对局部区域进行权重共享的线性运算,并通过非线性激活函数生成特征图(feature maps)。

卷积操作可以表述为:

\[ O(i, j) = \sum_m \sum_n I(i+m, j+n) * K(m, n) \]

其中,\(O\) 是输出特征图,\(I\) 是输入图像,\(K\) 是卷积核,\(m\) 和 \(n\) 是卷积核的偏移量。

### 2.1.2 卷积层的参数设置和优化策略

在PyTorch中,创建一个卷积层时需要设置多个参数,包括输入通道数、输出通道数、卷积核大小、步长、填充等。例如:

```python

import torch.nn as nn

conv_layer = nn.Conv2d(in_channels=3, out_channels=64, kernel_size=3, stride=1, padding=1)

```

在此代码块中,`in_channels=3`指定了输入图像的通道数,对于彩色图像而言通常是3(RGB)。`out_channels=64`表示输出特征图的通道数,即生成的特征图数量。`kernel_size=3`设置了卷积核的大小为3x3。`stride=1`指定了卷积核滑动的步长,而`padding=1`则用于在图像边缘进行填充以保持特征图尺寸。

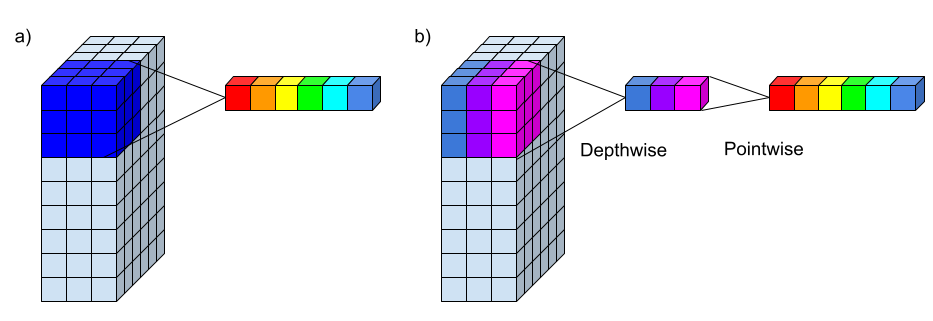

优化卷积层性能的关键策略包括调整卷积核大小和数量、选择合适的步长和填充、使用分组卷积等。此外,可以利用现代深度学习框架提供的各种优化技术,如权重初始化方法、批量归一化、分组卷积等。

## 2.2 池化层的作用和应用

### 2.2.1 池化层的类型和作用

池化层是CNN中用于降低特征维度、增加模型泛化能力的另一关键组件。池化操作可以减少特征图的空间大小,减少参数数量和计算量,从而加速网络运算。常见的池化类型包括最大池化(Max Pooling)和平均池化(Average Pooling)。

最大池化通过选择局部区域内的最大值作为池化区域的代表值,而平均池化则计算局部区域的平均值。以下是一个最大池化的实现示例:

```python

max_pool_layer = nn.MaxPool2d(kernel_size=2, stride=2)

```

在这个例子中,`kernel_size=2`和`stride=2`表明池化窗口的大小为2x2,并且每次滑动窗口跳过2个像素。

### 2.2.2 池化层的应用实例

池化层在图像识别和处理任务中应用广泛,下面将通过一个简单的例子展示最大池化层如何应用于图像降维:

假设有一个4x4的特征图,通过2x2的最大池化层后,输出的特征图大小将会是2x2。具体步骤如下:

```python

import torch

import torch.nn.functional as F

# 假设输入特征图大小为 4x4

input_feature_map = torch.tensor([[

[1, 2, 3, 4],

[5, 6, 7, 8],

[9, 10, 11, 12],

[13, 14, 15, 16]

]], dtype=torch.float32)

# 应用最大池化

pooled_feature_map = F.max_pool2d(input_feature_map, kernel_size=2, stride=2)

print(pooled_feature_map)

```

此代码输出的特征图大小会减少到2x2,区域内的最大值被选取作为代表值。应用池化层可以有效减少计算负担,并帮助模型捕捉图像中的主要特征。

## 2.3 全连接层的结构和功能

### 2.3.1 全连接层的设计原理

全连接层(Fully Connected Layer, FC)通常位于卷积神经网络的末端,用于将多维的特征图降维到样本标签的维度,从而进行分类或回归任务。全连接层的每个神经元与前一层的所有激活单元相连,每个连接都赋予一个权重。

在PyTorch中,全连接层可以使用`nn.Linear`模块实现。构建全连接层时,需要指明输入和输出的维度。例如:

```python

fc_layer = nn.Linear(in_features=64, out_features=10)

```

这段代码定义了一个输入特征数为64、输出特征数为10的全连接层。

### 2.3.2 全连接层在CNN中的应用

全连接层是将学习到的高层特征进行线性变换,以得到最终的输出,如分类结果。在图像分类任务中,全连接层将高维特征图转化为类别标签的得分向量。在全连接层之后,通常会跟一个Softmax函数,将得分转化为概率,并选取概率最高的类别作为预测结果。

```python

# 假设fc_layer是我们定义的全连接层,并且已通过前向传播得到输出output

output = fc_layer(input_feature_map.view(-1, 64))

# 应用Softmax函数进行分类

probabilities = F.softmax(output, dim=1)

```

在此例中,`input_feature_map.view(-1, 64)`将特征图转换成全连接层所需的输入格式,`F.softmax`函数则将线性层的输出转换为概率分布。

### 图表展示

为了更好地理解卷积层、池化层、全连接层在CNN中的作用,我们可以用一个流程图来形象化地展示它们的连接关系。

```mermaid

graph TD

A[输入图像] -->|卷积层| B(卷积层输出)

B -->|池化层| C(池化层输出)

C -->|卷积层| D(卷积层输出)

D -->|池化层| E(池化层输出)

E -->|全连接层| F(分类结果)

```

此流程图描绘了从输入图像开始,通过一系列卷积层和池化层处理,最后通过全连接层进行分类的过程。每一个卷积和池化层的组合都在提取和抽象输入图像的特征,而全连接层则负责根据这些抽象特征做出最终的决策。

# 3. PyTorch CNN组件的实践应用

在这一章中,我们将深入探讨如何将PyTorch CNN组件应用于实际的机器学习任务中。我们会通过逐步分析和代码示例,展示如何构建深度卷积神经网络模型来进行图像分类、目标检测和图像分割。

## 3.1 使用CNN进行图像分类

### 3.1.1 图像分类的基本流程

图像分类是将图像分配到一个或多个类别中的过程。在深度学习中,使用CNN进行图像分类已经成为主流技术。其基本流程大致可以分为以下步骤:

1. 数据预处理:包括图像的大小调整、归一化以及数据增强等,以提升模型的泛化能力。

2. 构建CNN模型:根据任务的复杂度,选择合适的CNN架构。

3. 模型训练:在训练集上进行前向传播和反向传播,不断优化模型参数。

4. 模型评估:在验证集或测试集上评估模型的性能。

5. 模型部署:将训练好的模型应用到实际场景中,进行图像分类。

下面是一个使用PyTorch构建简单的CNN模型进行图像分类的示例代码:

```python

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 数据预处理

transform = transforms.Compose([

transforms.Resize((224, 224)), # 调整图像大小

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])

])

# 加载数据集

train_dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

train_loader = DataLoader(dataset=train_dataset, batch_size=32, shuffle=True)

# 构建CNN模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size=3, padding=1)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(16, 32, kernel_size=3, padding=1)

self.fc = nn.Linear(32 * 28 * 28, 10) # CIFAR-10图像大小为32x32

def forward(self, x):

x = self.pool(torch.relu(self.conv1(x)))

x = self.pool(torch.relu(self.conv2(x)))

x = x.view(-1, 32 * 28 * 28) # 展平特征图以便于全连接层处理

x = self.fc(x)

return x

model = SimpleCNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 模型训练

for epoch in range(10):

running_loss = 0.0

for images, labels in train_loader:

optimizer.zero_grad()

outputs = model(images)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

print(f'Epoch {epoch+1}, Loss: {running_loss/len(train_loader)}')

# 模型评估(此处可以加载验证集或测试集进行评估)

```

在这个示例中,我们首先定义了数据预处理流程,然后加载了CIFAR-10数据集,并创建了一个简单的CNN模型。模型包含两个卷积层,以及一个全连接层,最后通过交叉熵损失函数和Adam优化器对模型进行训练。

### 3.1.2 实际案例分析

接下来,我们将展示一个实际的案例,使用PyTorch构建的CNN模型对CIFAR-10数据集进行分类,并评估模型性能。首先,我们定义了数据加载器:

```python

# 数据加载器

train_loader = DataLoader(dataset=train_dataset, batch_size=32, shuffle=True)

val_loader = DataLoader(dataset=val_dataset, batch_size=32, shuffle=False)

```

训练结束后,我们使用验证集对模型进行评估:

```python

model.eval() # 设置模型为评估模式

correct = 0

total = 0

with torch.no_grad():

for images, labels in val_loader:

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the validation images: {100 * correct / total}%')

```

通过对验证集的评估,我们可以得到模型的准确率,这有助于我们了解模型在未见过的数据上的泛化能力。

## 3.2 使用CNN进行目标检测

### 3.2.1 目标检测的基本概念和方法

目标检测是指在一个图像中识别并定位一个或多个对象。与图像分类不同,目标检测不仅要识别对象,还要确定对象在图像中的位置。近年来,基于深度学习的目标检测方法主要有R-CNN系列、YOLO系列和SSD等。

在本章节,我们将重点关注使用CNN进行目标检测的基础概念,并通过一个简化的例子展示如何使用PyTorch进行目标检测。

### 3.2.2 实际案例分析

假设我们使用PyTorch中的预训练YOLO模型来检测图像中的对象。以下是使用YOLO进行目标检测的基本步骤:

```python

import torch

import torchvision.transforms as transforms

from PIL import Image

from models import Darknet # 假设Darknet是YOLO模型的实现

import numpy as np

# 加载预训练模型

model = Darknet('yolov3.cfg')

model.load_weights('yolov3.weights')

# 图像预处理

transform = transforms.Compose([

transforms.ToTensor()

])

image = Image.open('test.jpg')

tensor_image = transform(image).unsqueeze(0)

# 目标检测

model.eval()

with torch.no_grad():

detections = model(tensor_image)

# 后处理与显示结果

# 此处省略了后处理的代码,包括边界框的非极大值抑制等步骤。

# 假设detections包含了检测结果

for detection in detections:

print(detection)

```

在这个案例中,我们首先加载了YOLO的预训练模型,并对测试图片进行了预处理。然后,我们将图像输入到模型中进行目标检测,并获得了检测结果。最后,需要对检测结果进行适当的后处理,如应用非极大值抑制(NMS)等步骤来过滤掉重复的边界框。

## 3.3 使用CNN进行图像分割

### 3.3.1 图像分割的基本原理

图像分割是指将图像划分为多个部分或区域的过程,目的是使得图像中的每个像素都属于一个特定的区域。在深度学习中,使用CNN进行图像分割最常用的方法是全卷积网络(FCN)。

图像分割通常分为语义分割和实例分割。语义分割关注图像中每个像素的分类,而实例分割则进一步区分图像中不同对象的实例。

接下来,我们将通过一个简化的例子来展示如何使用PyTorch构建一个FCN模型进行图像的语义分割。

### 3.3.2 实际案例分析

假设我们使用PyTorch实现一个简单的FCN来对图像进行语义分割。以下是构建FCN的基本步骤:

```python

import torch

import torch.nn as nn

from torchvision import models

# 构建FCN模型

class FCN(nn.Module):

def __init__(self, num_classes=21):

super(FCN, self).__init__()

# 加载预训练的VGG16模型

features = list(models.vgg16(pretrained=True).features.children())

self.features = nn.Sequential(*features)

# 分类层替换为卷积层以获得像素级分类

self.score = nn.Conv2d(512, num_classes, kernel_size=1)

def forward(self, x):

x = self.features(x)

x = self.score(x)

return x

# 创建模型实例

num_classes = 21 # 假设我们有21个类别,包含背景

model = FCN(num_classes)

# 数据预处理与数据加载器(类似于图像分类部分)

# 模型训练与评估(类似于图像分类部分)

# 模型预测

image = Image.open('path_to_image.jpg')

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

])

tensor_image = transform(image).unsqueeze(0)

model.eval()

with torch.no_grad():

output = model(tensor_image)

```

在此案例中,我们首先定义了一个继承自nn.Module的FCN类。在初始化方法中,我们使用预训练的VGG16模型的特征提取层作为基础,然后替换了分类层以获得像素级的输出。接着,我们加载了一个图像并对其进行预处理,最后将处理后的图像输入到模型中进行预测。

请注意,上述代码片段仅用作示例,实际应用中需要详细处理的步骤更多,比如模型的训练过程、损失函数的设计以及预测结果的可视化等。

至此,我们已经介绍了使用PyTorch CNN组件进行图像分类、目标检测和图像分割的实践应用。在下一章中,我们将探讨PyTorch CNN组件的高级应用,包括迁移学习、多任务学习和深度强化学习等。

# 4. PyTorch CNN组件的高级应用

随着深度学习技术的不断进步,CNN组件的应用也在不断拓展。在这一章节中,我们将深入探讨PyTorch框架下CNN组件的几种高级应用场景,如迁移学习、多任务学习和深度强化学习。这些高级应用不仅能够加深对CNN的理解,而且能够拓宽其在多个领域的应用范围,为解决复杂问题提供新的思路和工具。

## 4.1 CNN的迁移学习应用

迁移学习是机器学习领域中的一种技术,它通过迁移已有的知识到新的领域,能够在数据有限的情况下迅速提升模型性能。在CNN中应用迁移学习,可以帮助我们解决一些样本数量较少的问题,通过复用在大规模数据集上预训练的模型,来加速模型训练过程并提高模型的泛化能力。

### 4.1.1 迁移学习的原理和优势

迁移学习的核心原理是利用先前任务学习到的特征来帮助新的任务。通常情况下,这些预训练模型能够捕获到一些通用的特征表示,这些特征在多种任务中都是有用的。对于深度学习而言,这些特征往往是指在深度卷积网络中的低层和中层特征,比如边缘、纹理和形状等。

迁移学习的优势主要体现在以下几个方面:

- **减少训练时间**:不需要从零开始训练模型,节省了大量训练时间。

- **提升性能**:利用在大规模数据集上预训练得到的模型作为起点,可以避免过拟合,提升模型在目标任务上的表现。

- **资源高效**:对于数据和计算资源有限的情况,迁移学习可以减少对大量数据和长时间训练的需求。

### 4.1.2 迁移学习的实践步骤和案例

下面是迁移学习在PyTorch中的一些实践步骤,以及一个具体案例。

**实践步骤:**

1. **选择预训练模型**:根据任务的需要,选择适合的预训练模型,例如ResNet、VGG等。

2. **加载预训练模型**:使用PyTorch的`torchvision.models`模块加载预训练模型,并设置为评估模式。

3. **替换最后的全连接层**:根据目标任务的类别数修改最后的全连接层。

4. **冻结部分层的权重**:可以选择性地冻结卷积层的权重,只训练最后几层或者全连接层。

5. **训练模型**:对模型进行微调,使用目标任务的数据集进行训练。

6. **评估模型**:在验证集上评估模型的性能。

**案例:**

假设我们要使用PyTorch进行迁移学习以分类猫和狗的图片,以下是代码示例:

```python

import torch

import torchvision.models as models

import torchvision.transforms as transforms

from torchvision.datasets import ImageFolder

from torch.utils.data import DataLoader

from torchvision import transforms, models

# 加载预训练的ResNet模型

model = models.resnet18(pretrained=True)

# 替换最后的全连接层

model.fc = torch.nn.Linear(model.fc.in_features, 2)

# 冻结所有层的权重

for param in model.parameters():

param.requires_grad = False

# 只训练最后的全连接层

for param in model.fc.parameters():

param.requires_grad = True

# 设置训练设备为GPU或CPU

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model = model.to(device)

# 训练模型

criterion = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.fc.parameters(), lr=0.001)

# 代码省略了加载数据集、设置训练循环和评估模型的部分

```

通过迁移学习,我们可以使用预训练的ResNet模型,并在特定的猫和狗的图片分类任务上进行微调。通过适当地冻结和训练模型的特定部分,我们可以得到一个在新任务上表现良好的模型。

## 4.2 CNN的多任务学习应用

多任务学习是一种同时学习多个相关任务的学习范式,其主要思想是不同任务间共享知识,从而提升各个任务的学习效率和性能。在CNN中,多任务学习可以通过共享卷积层的特征表示来实现。

### 4.2.1 多任务学习的概念和优势

在多任务学习中,一个模型同时被训练来解决多个相关任务。共享表示是多任务学习的核心概念,即在不同任务之间共享学习到的特征表示,而不是为每个任务单独训练一个模型。这种共享可以导致更好的泛化能力,并且能够减少过拟合的风险。

多任务学习的优势包括:

- **提高效率**:利用相关任务间的共享特征,可以减少模型训练所需的计算资源。

- **增加泛化能力**:共享表示可以提高模型对数据的理解能力,从而增加模型的泛化能力。

- **改善性能**:同时学习多个任务,可以提升单个任务的性能,尤其是在任务之间存在一定的相关性时。

### 4.2.2 多任务学习的实践步骤和案例

在多任务学习中,PyTorch框架可以帮助我们设计和实现共享不同层次特征表示的网络结构。以下是一些实践步骤,以及一个简化的多任务学习案例。

**实践步骤:**

1. **设计共享层**:设计一个CNN结构,其中卷积层作为共享层。

2. **定义多个任务的输出层**:根据任务数量,为每个任务定义独立的输出层。

3. **损失函数组合**:为每个任务定义损失函数,并将它们按照一定方式组合起来,作为整体模型的损失函数。

4. **训练模型**:使用所有任务的数据集共同训练模型。

5. **评估模型**:对每个任务分别评估模型性能。

**案例:**

考虑一个同时进行图像分类和目标检测的多任务学习案例。我们使用PyTorch实现如下:

```python

import torch

import torch.nn as nn

import torch.optim as optim

class MultiTaskCNN(nn.Module):

def __init__(self):

super(MultiTaskCNN, self).__init__()

# 定义共享的卷积层

self.conv_layers = nn.Sequential(

nn.Conv2d(3, 64, kernel_size=3, padding=1),

nn.ReLU(),

nn.MaxPool2d(2),

# 更多层...

)

# 分别为分类和检测任务定义独立的全连接层

self.fc_class = nn.Linear(64, 10) # 假设有10个类别

self.fc_detect = nn.Linear(64, 4) # 假设检测任务需要4个输出

def forward(self, x):

x = self.conv_layers(x)

# 分别对不同任务输出结果

class_output = self.fc_class(x.view(x.size(0), -1))

detect_output = self.fc_detect(x.view(x.size(0), -1))

return class_output, detect_output

# 实例化模型和优化器

model = MultiTaskCNN()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练过程省略

```

在这个例子中,我们构建了一个简单的CNN模型,其中卷积层被两个任务共享。全连接层被分成两部分,分别对应分类任务和目标检测任务。通过共同训练,模型能够学习到更加鲁棒的特征表示。

## 4.3 CNN的深度强化学习应用

深度强化学习(Deep Reinforcement Learning, DRL)结合了深度学习和强化学习的优势,它利用深度神经网络作为函数逼近器来近似状态值函数或策略函数。DRL在诸如游戏、机器人控制等领域的成功,已经证明了其在决策过程中的巨大潜力。

### 4.3.1 深度强化学习的原理和优势

深度强化学习的核心思想是通过与环境交互来学习最优策略。在DRL中,智能体(Agent)通过试错的方式与环境进行交互,并不断更新策略以最大化期望回报。深度神经网络在这里起到了拟合复杂函数的作用,使得DRL算法能够处理高维的、连续的状态和动作空间。

深度强化学习的优势主要包括:

- **处理高维输入**:深度学习能够处理图像、声音等高维输入,使得DRL能够应用于复杂的环境中。

- **端到端学习**:从原始输入到决策输出,DRL提供了端到端的学习方式,减少了中间特征工程的需要。

- **可扩展性**:深度神经网络的可扩展性允许DRL模型能够处理更加复杂的问题。

### 4.3.2 深度强化学习的实践步骤和案例

深度强化学习模型的设计和训练通常包括以下几个步骤,以及一个简单的DRL案例。

**实践步骤:**

1. **定义环境**:选择或设计适合任务的环境,环境是智能体学习策略的场所。

2. **设计智能体**:构建一个深度神经网络作为智能体,通常是一个深度Q网络(DQN)或策略网络(如Actor-Critic模型)。

3. **交互学习**:智能体通过与环境交互,进行试错学习,利用强化学习算法更新策略。

4. **评估智能体性能**:在特定任务中评估智能体的性能。

**案例:**

考虑一个简单的DRL环境,其中智能体需要学习在迷宫中找到目标位置。以下是构建和训练一个简单的DQN模型的过程:

```python

import torch

import torch.nn as nn

import torch.optim as optim

from torch.distributions import Categorical

class DQN(nn.Module):

def __init__(self, state_size, action_size):

super(DQN, self).__init__()

self.fc1 = nn.Linear(state_size, 64)

self.fc2 = nn.Linear(64, action_size)

def forward(self, x):

x = torch.relu(self.fc1(x))

return self.fc2(x)

# 设定状态和动作空间大小

state_size = 25

action_size = 4

# 实例化模型、优化器和损失函数

model = DQN(state_size, action_size)

optimizer = optim.Adam(model.parameters(), lr=0.001)

loss_fn = nn.MSELoss()

# 模拟训练过程

for episode in range(1000):

# 获取环境状态

state = env.reset()

done = False

while not done:

# 选择动作

action_probs = torch.softmax(model(torch.tensor(state)), dim=0)

action_dist = Categorical(action_probs)

action = action_dist.sample()

# 执行动作,观察环境反馈

next_state, reward, done, _ = env.step(action.item())

# 存储经验

# ...

# 计算目标值

target = reward + gamma * torch.max(model(torch.tensor(next_state)))

# 计算损失并进行反向传播

current = model(torch.tensor(state))[action]

loss = loss_fn(current, target)

optimizer.zero_grad()

loss.backward()

optimizer.step()

state = next_state

```

在这个例子中,我们设计了一个简单的DQN网络来学习在迷宫中找到目标的策略。通过不断地与环境交互,智能体通过DQN学会了如何选择行动以最大化最终的奖励。

## 总结

在本章中,我们详细探讨了PyTorch CNN组件在高级应用方面的几个关键主题:迁移学习、多任务学习和深度强化学习。每个主题都从原理和优势开始,到具体的实践步骤和案例分析,逐步深入。通过实例,我们了解了如何将这些高级技术应用到实际的深度学习任务中,解决了多个实际问题,并进一步扩展了CNN的应用边界。这些高级应用不仅展示了PyTorch框架强大的灵活性和实用性,也体现了深度学习在解决实际问题中的强大能力。

# 5. PyTorch CNN组件的性能优化策略

## 5.1 CNN性能优化的重要性

在构建和训练CNN模型时,性能优化是一个重要环节。它能显著减少模型的训练时间,提高模型的预测速度和准确性。性能优化不仅可以提升用户体验,还能节省计算资源。优化的关键在于找到效率与准确性的平衡点。

## 5.2 硬件加速与模型并行化

为了提升性能,首先应考虑硬件加速。现代GPU与TPU为矩阵运算提供了极高的计算能力。模型并行化将模型的不同部分分散在不同的硬件资源上执行。这样可以在不牺牲模型规模的情况下,提升计算速度。

```python

import torch

import torch.nn as nn

import torch.nn.parallel

class MyCNN(nn.Module):

# ... (定义CNN结构)

pass

# 假设我们有一个多GPU环境

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

model = MyCNN().to(device)

# 将模型设置为数据并行

if torch.cuda.device_count() > 1:

print("Let's use", torch.cuda.device_count(), "GPUs!")

# 多GPU并行模型

model = nn.DataParallel(model)

# 使用模型进行前向传播

output = model(input_tensor)

```

## 5.3 算法优化策略

### 5.3.1 权重初始化

选择合适的权重初始化方法能帮助模型更快地收敛。例如,对于卷积层,He初始化和Xavier初始化被广泛应用于不同的激活函数。

### 5.3.2 批量归一化(Batch Normalization)

批量归一化通过规范化层的输入来减少内部协变量偏移问题。它可以允许更灵活的学习率,加快训练速度,并有助于正则化,减少过拟合。

### 5.3.3 使用高效的激活函数

在CNN中,ReLU及其实现形式(如Leaky ReLU或ELU)比传统的激活函数如sigmoid或tanh在计算上更加高效。

### 5.3.4 网络剪枝(Network Pruning)

网络剪枝是一种减少网络复杂度和参数数量的技术,通过去除冗余的神经元或连接,提高运行效率,而不显著影响性能。

### 5.3.5 使用更轻量级的网络架构

例如MobileNets, ShuffleNets等,专门设计为在移动和边缘设备上运行,大幅减少模型大小和计算需求。

## 5.4 软件优化策略

### 5.4.1 使用混合适用函数(Mixed Precision Training)

通过混合使用单精度(float32)和半精度(float16),可以加快计算速度,降低内存占用,而现代GPU支持高效的半精度计算。

### 5.4.2 异步计算(Async Computation)

利用异步计算可以在数据传输到GPU的同时进行计算,最大化硬件利用效率。

### 5.4.3 使用优化过的库和框架

利用如NVIDIA的cuDNN等高度优化过的深度学习库可以显著提升性能。

## 5.5 优化实例

通过下面的例子,我们将展示如何在PyTorch中实现部分性能优化策略。

```python

from torch.cuda.amp import autocast

from torch.nn.parallel import DataParallel

# 使用自动混合精度训练

class MixedPrecisionModel(nn.Module):

# ... (定义CNN结构)

pass

model = MixedPrecisionModel().to(device)

# 使用DataParallel包装模型以并行运行

model = DataParallel(model).cuda()

# 在训练循环中使用自动混合精度

for input, target in dataloader:

input = input.cuda().float()

target = target.cuda().float()

with autocast():

output = model(input)

loss = loss_fn(output, target)

optimizer.zero_grad()

# 使用scaler来缩放梯度,防止梯度消失

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

```

性能优化是一个持续的过程,需要对模型和硬件特性有深入的理解。经过细致的调整和优化,我们可以让我们的CNN模型在保证准确性的同时,变得更加高效。

0

0