训练技巧与多层感知器(MLP):收敛加速秘诀,缩短训练时间,提高效率

发布时间: 2024-07-14 12:21:24 阅读量: 191 订阅数: 225

# 1. 训练技巧与多层感知器(MLP)概述

### 1.1 多层感知器(MLP)简介

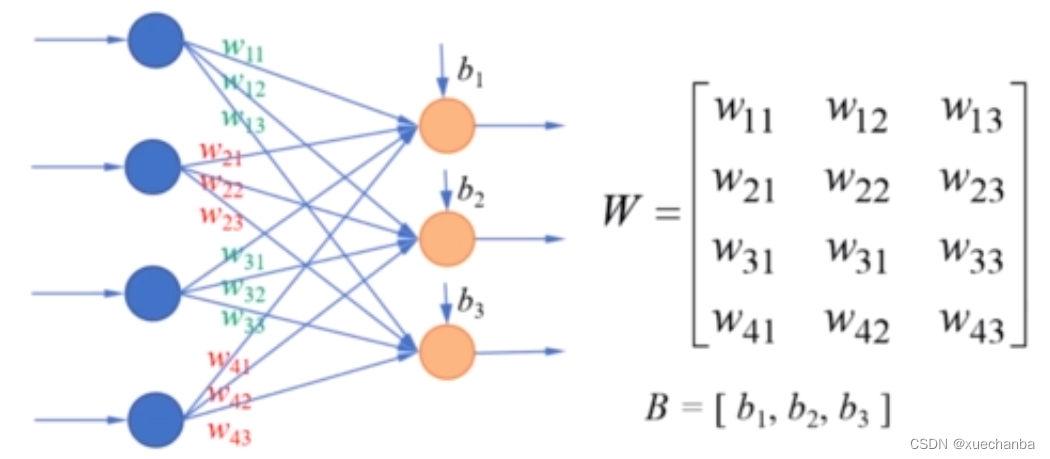

多层感知器(MLP)是一种前馈神经网络,具有输入层、一个或多个隐藏层和输出层。每个层由神经元组成,神经元接收来自前一层输出的加权输入,并通过激活函数产生输出。MLP广泛用于图像分类、自然语言处理和回归任务。

### 1.2 MLP训练的基本技巧

MLP训练涉及优化模型权重,以最小化损失函数。常用的训练技巧包括:

- **权重初始化:**选择适当的权重初始化方法,例如Xavier初始化或He初始化,可以帮助模型快速收敛。

- **激活函数:**使用非线性激活函数,例如ReLU或tanh,可以引入非线性并提高模型的表达能力。

- **正则化:**应用正则化技术,例如L1或L2正则化,可以防止模型过拟合并提高泛化能力。

# 2. MLP训练的收敛加速理论

### 2.1 动量法与RMSProp

#### 2.1.1 动量法的原理和应用

动量法是一种优化算法,它通过引入动量项来加速梯度下降。动量项是一个向量,它存储了梯度的历史移动平均值。在每次迭代中,动量项会与当前梯度相加,并用作更新权重的方向。

动量法的更新公式如下:

```python

v_t = β * v_{t-1} + (1 - β) * g_t

w_t = w_{t-1} - α * v_t

```

其中:

* `v_t` 是时刻 `t` 的动量项

* `β` 是动量系数,范围为 [0, 1]

* `g_t` 是时刻 `t` 的梯度

* `w_t` 是时刻 `t` 的权重

* `α` 是学习率

动量系数 `β` 控制了动量项的平滑程度。较大的 `β` 值会产生更平滑的动量项,从而导致更稳定的收敛。然而,较大的 `β` 值也可能减慢收敛速度。

#### 2.1.2 RMSProp的优势和局限性

RMSProp(Root Mean Square Propagation)是一种自适应学习率算法,它通过计算梯度的均方根(RMS)来调整每个权重的学习率。RMSProp 算法可以有效地防止梯度爆炸和梯度消失问题。

RMSProp 的更新公式如下:

```python

s_t = β * s_{t-1} + (1 - β) * g_t^2

w_t = w_{t-1} - α * g_t / sqrt(s_t + ε)

```

其中:

* `s_t` 是时刻 `t` 的均方根项

* `β` 是平滑系数,范围为 [0, 1]

* `g_t` 是时刻 `t` 的梯度

* `w_t` 是时刻 `t` 的权重

* `α` 是学习率

* `ε` 是一个小的正数,用于防止除零错误

RMSProp 的主要优势是它可以自动调整每个权重的学习率,从而避免梯度爆炸和梯度消失问题。然而,RMSProp 算法也可能导致收敛速度较慢,因为它使用了过去梯度的历史信息。

### 2.2 自适应学习率调整

#### 2.2.1 学习率衰减策略

学习率衰减是一种策略,它随着训练的进行逐渐减小学习率。学习率衰减可以帮助模型收敛到更优的解,并防止过拟合。

常见的学习率衰减策略包括:

* **指数衰减:**学习率在每次迭代中以指数方式衰减。

* **线性衰减:**学习率在每次迭代中以线性方式衰减。

* **分段衰减:**学习率在训练的不同阶段以不同的速率衰减。

#### 2.2.2 自适应学习率算法

自适应学习率算法是一种算法,它根据梯度的历史信息自动调整学习率。自适应学习率算法可以有效地防止梯度爆炸和梯度消失问题。

常见的自适应学习率算法包括:

* **AdaGrad:**自适应梯度算法,它根据梯度的历史平方和调整学习率。

* **AdaDelta:**AdaGrad 的扩展,它使用梯度的指数移动平均值来调整学习率。

* **Adam:**AdaGrad 和 RMSProp 的结合,它使用梯度的指数移动平均值和均方根来调整学习率。

# 3. MLP训练的收敛加速实践

### 3.1 数据预处理与特征工程

#### 3.1.1 数据归一化和标准化

数据归一化和标准化是数据预处理中的重要步骤,它们可以改善模型的训练和收敛速度。

**数据归一化**将数据映射到[0, 1]区间内,通过以下公式实现:

```python

x_normalized = (x - x_min) / (x_max -

```

0

0