多层感知器(MLP)超参数调优秘籍:优化模型性能,释放AI潜力

发布时间: 2024-07-14 12:15:23 阅读量: 553 订阅数: 94

# 1. 多层感知器(MLP)简介**

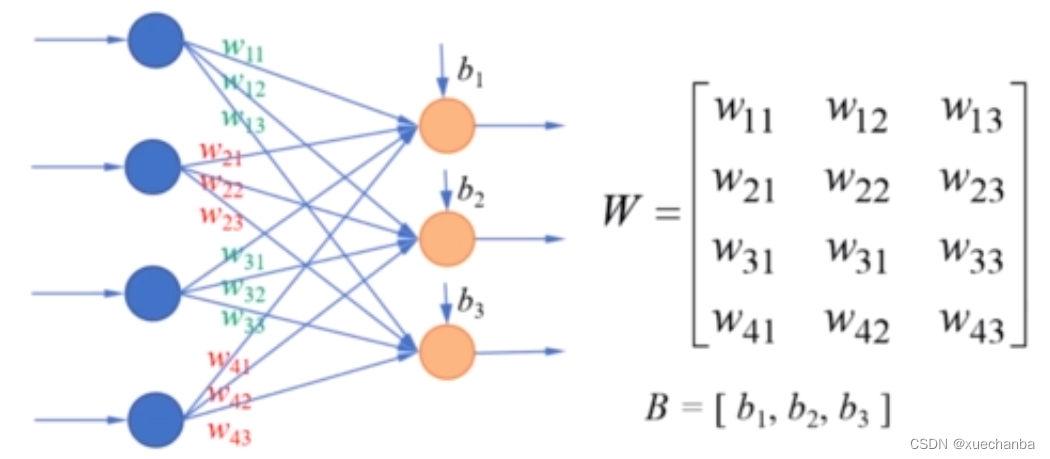

多层感知器(MLP)是一种前馈神经网络,由多个隐藏层组成,每个隐藏层都包含多个神经元。MLP的输入层接收特征数据,输出层产生预测结果。隐藏层在输入层和输出层之间进行非线性变换,学习数据的复杂模式。

MLP的优势在于其强大的非线性建模能力,可以处理各种复杂任务,如图像分类、自然语言处理和预测建模。其结构简单,易于理解和实现,并且可以通过超参数调优来优化性能。

# 2. MLP超参数调优的理论基础

### 2.1 学习率和优化器

**2.1.1 学习率的重要性**

学习率是优化器在每次迭代中更新权重时使用的步长。它控制着模型在优化过程中向最小值移动的速度。学习率过大,模型可能会越过最小值并导致不稳定;学习率过小,模型可能收敛速度慢或无法收敛。

**2.1.2 常见的优化器及其特点**

常见的优化器包括:

- **梯度下降(GD)**:最简单的优化器,沿梯度方向更新权重。

- **随机梯度下降(SGD)**:每次迭代仅使用一个样本的梯度来更新权重,可减少计算量。

- **动量梯度下降(MGD)**:在梯度方向上添加动量项,可加速收敛。

- **RMSprop**:自适应学习率优化器,根据梯度的历史变化自动调整学习率。

- **Adam**:结合了动量和RMSprop的优点,是目前最常用的优化器之一。

### 2.2 网络结构

**2.2.1 隐层数和神经元数**

隐层数和神经元数决定了MLP的复杂度和容量。隐层数越多,神经元数越多,模型的容量越大,但过大的模型可能导致过拟合。

**2.2.2 激活函数的选择**

激活函数是非线性函数,引入非线性以提高模型的表达能力。常用的激活函数包括:

- **Sigmoid**:将输入映射到0到1之间的值。

- **Tanh**:将输入映射到-1到1之间的值。

- **ReLU**:对于非负输入,输出为输入值;对于负输入,输出为0。

### 2.3 正则化技术

正则化技术通过惩罚模型的复杂度来防止过拟合。常用的正则化技术包括:

**2.3.1 L1正则化和L2正则化**

- **L1正则化**:向损失函数中添加权重绝对值的和,可稀疏化模型。

- **L2正则化**:向损失函数中添加权重平方和的和,可平滑模型。

**2.3.2 Dropout**

Dropout是一种随机正则化技术,在训练过程中随机丢弃一些神经元,迫使模型学习更鲁棒的特征。

# 3. MLP超参数调优的实践指南

### 3.1 数据预处理和特征工程

#### 3.1.1 数据归一化和标准化

数据归一化和标准化是数据预处理的重要步骤,可以消除数据量纲的影响,提高模型的训练效率和准确性。

**数据归一化**将数据映射到[0, 1]或[-1, 1]的范围内,公式如下:

```python

x_normalized = (x - min(x)) / (max(x) - min(x))

```

**数据标准化**将数据映射到均值为0,标准差为1的范围内,公式如下:

```python

x_standardized = (x - mean(x)) / std(x)

```

#### 3.1.2 特征选择和降维

特征选择和降维可以减少模型的复杂度,提高训练速度和泛化能力。

**特征选择**通过过滤或包装方法选择与目标变量最相关的特征。

**降维**通过主成分分析(PCA)或奇异值分解(SVD)等技术将高维数据投影到低维空间。

### 3.2 超参数搜索策略

#### 3.2.1 网格搜索

网格搜索是一种穷举搜索策略,它遍历所有可能的超参数组合,并选择性能最佳的组合。

**优点:**

* 找到最优超参数的概率较高。

**缺点:**

* 计算量大,尤其当超参数数量较多时。

#### 3.2.2 随机搜索

随机搜索是一种随机采样策略,它从超参数空间中随机采样,并选择性能最佳的组合。

**优点:**

* 计算量小,尤其当超参数数量较多时。

**缺点:**

* 找到最优超参数的概率较低。

### 3.3 模型评估和选择

#### 3.3.1 训练集和验证集的划分

为了避免过拟合,需要将数据集划分为训练集和验证集。训练集用于训练模型,验证集用于评估模型的泛化能力。

#### 3.3.2 评估指标的选择

根据任务的不同,需要选择合适的评估指标,例如:

* 分类任务:准确率、召回率、F1分数

* 回归任务:均方根误差(RMSE)、平均绝对误差(MAE)

# 4. MLP超参数调优的进阶技巧

### 4.1 迁移学习

#### 4.1.1 预训练模型的选择

迁移学习是一种利用已在其他任务上训练过的模型来提高新任务模型性能的技术。在MLP超参数调优中,我们可以使用预训练的MLP模型作为基础,然后对其进行微调以适应新的任务。

选择预训练模型时,需要考虑以下因素:

- **任务相关性:**预训练模型的任务

0

0