注意力机制与多层感知器(MLP):特征提取新视野,挖掘数据价值,提升模型理解力

发布时间: 2024-07-14 12:32:56 阅读量: 347 订阅数: 72

# 1. 注意力机制概述**

注意力机制是一种神经网络技术,它允许模型专注于输入数据的特定部分。通过分配权重,注意力机制可以突出重要特征,同时抑制不相关信息。

注意力机制的优点包括:

* 提高特征提取的精度和效率

* 增强模型对输入数据中相关性的理解

* 提高模型的可解释性,允许研究人员了解模型关注的区域

# 2. 注意力机制在特征提取中的应用

注意力机制是一种神经网络技术,它允许模型专注于输入数据中最重要的部分。在特征提取中,注意力机制可以帮助模型识别和提取数据中与特定任务相关的关键特征。

### 2.1 自注意力机制

自注意力机制是一种注意力机制,它允许模型关注输入序列中的不同部分。它通过计算每个元素与序列中其他所有元素之间的相似性来工作。相似性分数高的元素将被赋予更高的权重,而相似性分数低的元素将被赋予较低的权重。

**2.1.1 自注意力机制的原理**

自注意力机制的原理可以表示为以下公式:

```

Q = W_qX

K = W_kX

V = W_vX

A = softmax(Q^T K / sqrt(d_k))

Output = AV

```

其中:

* X 是输入序列

* Q、K、V 是查询、键和值矩阵

* W_q、W_k、W_v 是权重矩阵

* d_k 是键向量的维度

* A 是注意力权重矩阵

* Output 是加权和输出

**2.1.2 自注意力机制的应用场景**

自注意力机制已成功应用于各种特征提取任务,包括:

* 文本特征提取:自注意力机制可以识别文本序列中重要的单词和短语。

* 图像特征提取:自注意力机制可以识别图像中重要的区域和对象。

* 音频特征提取:自注意力机制可以识别音频序列中重要的音素和节奏。

### 2.2 异注意力机制

异注意力机制是一种注意力机制,它允许模型关注输入序列和另一个序列之间的关系。它通过计算输入序列中的每个元素与另一个序列中的每个元素之间的相似性来工作。相似性分数高的元素将被赋予更高的权重,而相似性分数低的元素将被赋予较低的权重。

**2.2.1 异注意力机制的原理**

异注意力机制的原理可以表示为以下公式:

```

Q = W_qX

K = W_kY

V = W_vY

A = softmax(Q^T K / sqrt(d_k))

Output = AV

```

其中:

* X 是输入序列

* Y 是另一个序列

* Q、K、V 是查询、键和值矩阵

* W_q、W_k、W_v 是权重矩阵

* d_k 是键向量的维度

* A 是注意力权重矩阵

* Output 是加权和输出

**2.2.2 异注意力机制的应用场景**

异注意力机制已成功应用于各种特征提取任务,包括:

* 机器翻译:异注意力机制可以帮助模型关注源语言序列和目标语言序列之间的关系。

* 图像字幕生成:异注意力机制可以帮助模型关注图像和文本描述之间的关系。

* 语音识别:异注意力机制可以帮助模型关注音频序列和文本转录之间的关系。

# 3. 多层感知器(MLP)概述

**3.1 MLP的架构**

多层感知器(MLP)是一种前馈神经网络,由多个全连接层堆叠而成。每个全连接层由一个线性变换和一个非线性激活函数组成。MLP的典型架构如下:

```

输入层 -> 隐藏层1 -> 隐藏层2 -> ... -> 输出层

```

其中,输入层接收输入数据,输出层产生最终预测。隐藏层负责从输入数据中提取特征并进行非线性变换。

**3.2 MLP的原理**

MLP的工作原理可以总结为以下步骤:

1. 输入数据通过输入层进入网络。

2. 每个隐藏层对输入数据进行线性变换,即计算加权和。

3. 线性变换后的结果通过非线性激活函数,引入非线性。

4. 非线性激活后的输出作为下一层的输入。

5. 重复步骤 2-4,直到达到输出层。

6. 输出层产生最终预测,通常是一个概率分布或连续值。

**3.3 MLP的激活函数**

MLP中常用的激活函数包括:

* **ReLU (Rectified Linear Unit)**:`max(0, x)`

* **Sigmoid**:`1 / (1 + exp(-x))`

* **Tanh**:`(exp(x) - exp(-x)) / (exp(x) + exp(-x))`

**3.4 MLP的优点**

MLP具有以下优点:

* **简单易用**:MLP的架构简单,易于理解和实现。

* **泛化能力强**:MLP能够从数据中学习复杂的关系,具有较强的泛化能力。

* **可扩展性好**:MLP可以根据需要添加或删除隐藏层,以适应不同的任务复杂度。

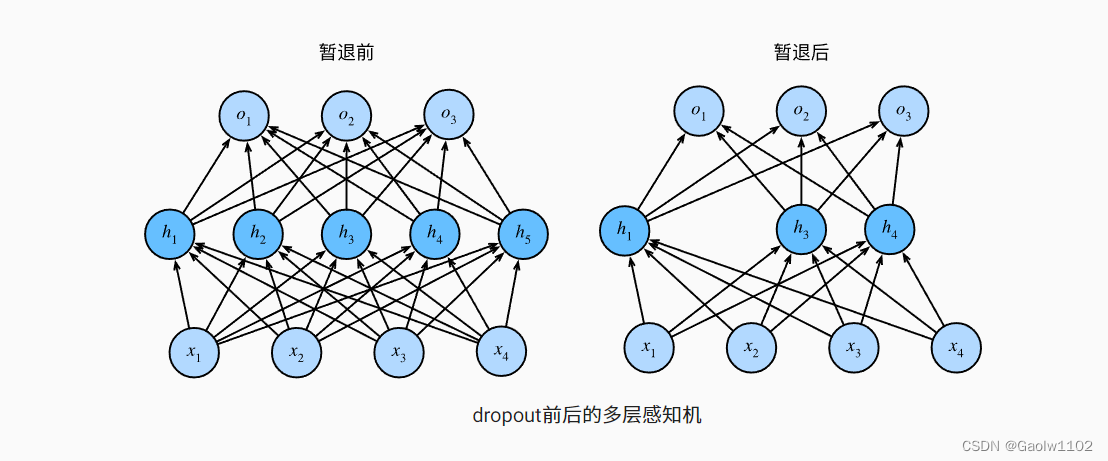

**3.5 MLP的局限性**

MLP也存在一些局限性:

* **计算量大**:MLP的计算量随着隐藏层数量和神经元数量的增加而增加。

* **容易过拟合**:MLP容易过拟合,需要仔细调整超参数和正则化技术。

* **缺乏空间信息**:MLP不能处理具有空间结构的数据,如图像和序列。

# 4. MLP与注意力机制的结合

注意力机制和多层感知器(MLP)的结合,为特征提取带来了新的视角。通过将注意力机制与MLP相结合,可以有效地提取特征,并提升模型的性能。

### 4.1 MLP与自注意力机制的结合

#### 4.1.1 自注意力MLP的架构

自注意力MLP将自注意力机制与MLP相结合,形成了一种新的神经网络架构。自注意力MLP的架构如下图所示:

```mermaid

graph LR

subgraph 自注意力层

A[Query] --> B[Key]

A[Query] --> C[Value]

B[Key] --> D[Softmax]

D[Softmax] --> E[Attention]

C[Value] --> F[Attention]

E[Attention] --> F[Attention]

end

subgraph MLP层

F[Attention] --> G[Linear]

G[Linear] --> H[ReLU]

H[ReLU] --> I[Linear]

end

```

自注意力层通过计算Query、Key和Value之间的注意力权重,来提取特征。MLP层则通过线性变换和激活函数,进一步处理自注意力层提取的特征。

#### 4.1.2 自注意力MLP的应用

自注意力MLP在自然语言处理、计算机视觉等领域有着广泛的应用。例如,在文本分类任务中,自注意力MLP可以有效地提取文本特征,并提升分类准确率。

### 4.2 MLP与异注意力机制的结合

#### 4.2.1 异注意力MLP的架构

异注意力MLP将异注意力机制与MLP相结合,形成了一种新的神经网络架构。异注意力MLP的架构如下图所示:

```mermaid

graph LR

subgraph 异注意力层

A[Query] --> B[Key]

C[Value] --> D[Key]

B[Key] --> E[Softmax]

E[Softmax] --> F[Attention]

D[Key] --> G[Softmax]

G[Softmax] --> H[Attention]

C[Value] --> I[Attention]

F[Attention] --> I[Attention]

end

subgraph MLP层

I[Attention] --> J[Linea

```

0

0