激活函数与多层感知器(MLP):性能优化指南,选择最优函数,提升模型效能

发布时间: 2024-07-14 12:17:10 阅读量: 164 订阅数: 225

# 1. 激活函数的基础知识

激活函数是神经网络中至关重要的组件,它将神经元的加权和映射到输出。其主要作用是引入非线性,允许神经网络学习复杂的关系。激活函数的选择对神经网络的性能有重大影响。

激活函数可以分为两类:线性激活函数和非线性激活函数。线性激活函数保持输入和输出之间的线性关系,而非线性激活函数引入非线性,使神经网络能够学习更复杂的关系。

# 2. 激活函数的类型和选择

激活函数是神经网络中至关重要的组件,它决定了神经元如何将输入信号转换为输出信号。在深度学习中,激活函数的选择对模型的性能有重大影响。

### 2.1 线性激活函数

线性激活函数以恒等激活函数和线性整流单元(ReLU)为代表。

#### 2.1.1 恒等激活函数

恒等激活函数是最简单的激活函数,它将输入信号直接输出。数学表达式为:

```

f(x) = x

```

恒等激活函数通常用于输入层和输出层,因为它不会改变输入信号的分布。

#### 2.1.2 线性整流单元(ReLU)

ReLU(Rectified Linear Unit)激活函数将输入信号的负值置零,而正值保持不变。数学表达式为:

```

f(x) = max(0, x)

```

ReLU激活函数具有以下优点:

- 计算简单,梯度恒为1或0

- 能够处理稀疏数据

- 避免梯度消失问题

### 2.2 非线性激活函数

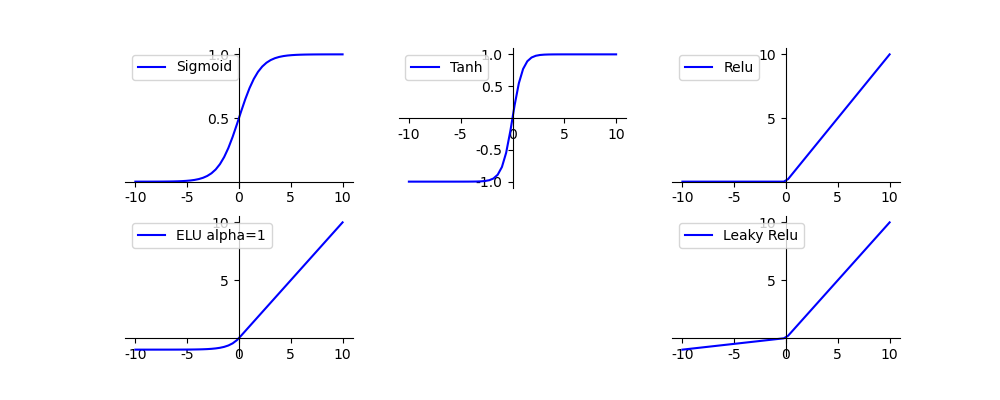

非线性激活函数能够引入非线性变换,增强神经网络的表达能力。常用的非线性激活函数包括Sigmoid、Tanh、ReLU和Leaky ReLU。

#### 2.2.1 Sigmoid激活函数

Sigmoid激活函数将输入信号映射到0到1之间的值。数学表达式为:

```

f(x) = 1 / (1 + exp(-x))

```

Sigmoid激活函数具有平滑的梯度,但存在梯度消失问题。

#### 2.2.2 Tanh激活函数

Tanh激活函数将输入信号映射到-1到1之间的值。数学表达式为:

```

f(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x))

```

Tanh激活函数具有中心对称性,梯度在原点处最大。

#### 2.2.3 ReLU激活函数

ReLU激活函数在正区间内为线性函数,在负区间内为0。数学表达式为:

```

f(x) = max(0, x)

```

ReLU激活函数计算简单,梯度恒为1或0,能够有效避免梯度消失问题。

#### 2.2.4 Leaky ReLU激活函数

Leaky ReLU激活函数是ReLU激活函数的改进,在负区间内引入了一个很小的斜率。数学表达式为:

```

f(x) = max(0.01x, x)

```

Leaky ReLU激活函数能够解决ReLU激活函数在负区间内梯度为0的问题,提高模型的鲁棒性。

### 激活函数的选择

激活函数的选

0

0