多层感知器(MLP)图像识别实战:从入门到精通,图像识别进阶之道

发布时间: 2024-07-14 12:10:52 阅读量: 150 订阅数: 101

python实现多层感知器MLP(基于双月数据集)

# 1. 多层感知器(MLP)基础**

多层感知器(MLP)是一种前馈神经网络,广泛应用于图像识别等领域。它由多个全连接层组成,每层的神经元与前一层的每个神经元相连。

MLP的学习算法通常采用反向传播算法。该算法通过计算误差梯度并更新权重来最小化损失函数。权重更新公式如下:

```

w_new = w_old - α * ∂L/∂w

```

其中:

* `w_new` 是更新后的权重

* `w_old` 是更新前的权重

* `α` 是学习率

* `∂L/∂w` 是损失函数关于权重的偏导数

# 2. MLP图像识别理论

### 2.1 MLP模型结构与原理

#### 2.1.1 MLP网络结构

多层感知器(MLP)是一种前馈神经网络,由多层节点(神经元)组成。这些节点按层排列,每一层都连接到上一层和下一层。MLP的结构可以表示为:

```

输入层 -> 隐藏层1 -> 隐藏层2 -> ... -> 输出层

```

输入层接收输入数据,输出层产生预测。隐藏层在输入和输出之间执行非线性变换,从而使MLP能够学习复杂模式。

#### 2.1.2 MLP学习算法

MLP使用反向传播算法进行训练。该算法通过以下步骤更新网络权重:

1. **前向传播:**输入数据通过网络,从输入层到输出层。

2. **计算误差:**输出层预测与真实标签之间的误差计算为损失函数。

3. **反向传播:**误差通过网络反向传播,计算每个权重的梯度。

4. **权重更新:**权重使用梯度下降算法更新,以最小化损失函数。

### 2.2 图像识别原理

#### 2.2.1 图像特征提取

图像识别涉及从图像中提取特征,这些特征可以用来对图像进行分类。MLP可以利用卷积神经网络(CNN)等技术提取图像特征。CNN使用滤波器在图像上滑动,提取边缘、纹理和形状等特征。

#### 2.2.2 图像分类

提取特征后,MLP使用分类器对图像进行分类。分类器通常是一个softmax函数,它将特征向量映射到概率分布,表示图像属于每个类别的概率。

```

softmax(x) = exp(x) / sum(exp(x))

```

其中,`x`是特征向量,`exp`是指数函数,`sum`是求和函数。

# 3. MLP图像识别实践

### 3.1 数据预处理

#### 3.1.1 图像数据获取与加载

**获取图像数据**

获取图像数据是图像识别任务的第一步。图像数据可以从各种来源获取,例如:

- 公共数据集(如 MNIST、CIFAR-10)

- 网络爬取

- 自行拍摄或收集

**加载图像数据**

获取图像数据后,需要将其加载到计算机中进行处理。常用的图像加载库有:

- OpenCV

- Pillow

- Matplotlib

**代码块:加载图像数据**

```python

import cv2

# 从文件中加载图像

image = cv2.imread('image.jpg')

# 将图像转换为 NumPy 数组

image_array = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

```

**逻辑分析:**

* `cv2.imread()` 函数从文件中读取图像并将其转换为 BGR(蓝色、绿色、红色)格式。

* `cv2.cvtColor()` 函数将图像从 BGR 格式转换为 RGB(红色、绿色、蓝色)格式,这是大多数深度学习框架使用的格式。

#### 3.1.2 图像预处理与增强

**图像预处理**

图像预处理是将图像转换为适合模型训练的格式的过程。常见的预处理步骤包括:

- 调整大小

- 归一化

- 数据增强

**图像增强**

图像增强可以提高模型的鲁棒性和泛化能力。常用的增强技术包括:

- 翻转

- 旋转

- 裁剪

- 添加噪声

**代码块:图像预处理与增强**

```python

import numpy as np

# 调整图像大小

image_resized = cv2.resize(image_array, (224, 224))

# 归一化图像

image_normalized = image_resized / 255.0

# 翻转图像

image_flipped = cv2.flip(image_normalized, 1)

# 旋转图像

image_rotated = cv2.rotate(image_normalized, cv2.ROTATE_90_CLOCKWISE)

```

**逻辑分析:**

* `cv2.resize()` 函数调整图像大小。

* `image_normalized` 将图像像素值归一化到 [0, 1] 范围内。

* `cv2.flip()` 函数水平翻转图像。

* `cv2.rotate()` 函数顺时针旋转图像 90 度。

### 3.2 模型训练与评估

#### 3.2.1 模型构建与参数设置

**模型构建**

MLP 图像识别模型的构建包括以下步骤:

1. 定义输入层(图像像素)

2. 定义隐藏层(多个全连接层)

3. 定义输出层(图像类别)

**参数设置**

MLP 模型的参数包括:

- 隐藏层数量

- 隐藏层神经元数量

- 激活函数

- 优化算法

- 学习率

**代码块:模型构建与参数设置**

```python

import tensorflow as tf

# 定义输入层

input_layer = tf.keras.layers.Input(shape=(224, 224, 3))

# 定义隐藏层

hidden_layer_1 = tf.keras.layers.Dense(512, activation='relu')(input_layer)

hidden_layer_2 = tf.keras.layers.Dense(256, activation='relu')(hidden_layer_1)

# 定义输出层

output_layer = tf.keras.layers.Dense(10, activation='softmax')(hidden_layer_2)

# 定义模型

model = tf.keras.Model(input_layer, output_layer)

# 编译模型

model.compile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

```

**逻辑分析:**

* `tf.keras.layers.Input()` 定义输入层,形状为 (224, 224, 3),表示输入图像的大小和通道数。

* `tf.keras.layers.Dense()` 定义隐藏层,第一个隐藏层有 512 个神经元,激活函数为 ReLU。第二个隐藏层有 256 个神经元,激活函数也为 ReLU。

* `tf.keras.layers.Dense()` 定义输出层,有 10 个神经元,激活函数为 softmax,用于多分类任务。

* `model.compile()` 编译模型,指定优化器、损失函数和评估指标。

#### 3.2.2 模型训练与超参数优化

**模型训练**

模型训练是使用训练数据更新模型参数的过程。训练过程包括:

1. 前向传播:将训练数据输入模型并计算预测值。

2. 计算损失:比较预测值和真实值之间的差异。

3. 反向传播:计算损失函数对模型参数的梯度。

4. 更新参数:使用优化算法更新模型参数。

**超参数优化**

超参数优化是调整模型超参数(如学习率、隐藏层数量)以提高模型性能的过程。常用的优化方法有:

- 网格搜索

- 随机搜索

- 贝叶斯优化

**代码块:模型训练与超参数优化**

```python

# 准备训练数据

train_data = ...

# 训练模型

model.fit(train_data, epochs=10)

# 超参数优化

from sklearn.model_selection import GridSearchCV

param_grid = {

'learning_rate': [0.001, 0.0001],

'hidden_layer_1': [128, 256],

'hidden_layer_2': [64, 128]

}

grid_search = GridSearchCV(model, param_grid, cv=5)

grid_search.fit(train_data, epochs=10)

```

**逻辑分析:**

* `model.fit()` 训练模型,指定训练数据和训练轮数。

* `GridSearchCV` 进行超参数优化,尝试不同的超参数组合并选择性能最佳的组合。

#### 3.2.3 模型评估与性能分析

**模型评估**

模型评估是使用验证数据或测试数据评估模型性能的过程。评估指标包括:

- 精度

- 召回率

- F1 分数

- 混淆矩阵

**性能分析**

性能分析是分析模型评估结果并确定模型优缺点的过程。性能分析可以帮助改进模型并提高其泛化能力。

**代码块:模型评估与性能分析**

```python

# 准备验证数据

validation_data = ...

# 评估模型

loss, accuracy = model.evaluate(validation_data)

# 绘制混淆矩阵

import seaborn as sns

sns.heatmap(confusion_matrix(y_true, y_pred), annot=True)

```

**逻辑分析:**

* `model.evaluate()` 评估模型,返回损失值和准确率。

* `confusion_matrix()` 计算混淆矩阵,显示模型在不同类别上的预测结果。

# 4. MLP图像识别进阶**

### 4.1 模型优化与改进

#### 4.1.1 激活函数与优化算法

**激活函数**

激活函数是非线性函数,它将神经网络的输入映射到输出。常用的激活函数包括:

- **Sigmoid 函数:** `f(x) = 1 / (1 + e^(-x))`

- **Tanh 函数:** `f(x) = (e^x - e^(-x)) / (e^x + e^(-x))`

- **ReLU 函数:** `f(x) = max(0, x)`

不同的激活函数具有不同的非线性特性,对模型的性能有较大影响。

**优化算法**

优化算法用于调整神经网络中的权重和偏差,以最小化损失函数。常用的优化算法包括:

- **梯度下降法:** `w = w - lr * ∇L(w)`

- **动量法:** `v = β * v + (1 - β) * ∇L(w)`

- **RMSprop:** `s = β * s + (1 - β) * (∇L(w))^2`

不同的优化算法具有不同的收敛速度和稳定性。

#### 4.1.2 正则化与过拟合处理

**正则化**

正则化是一种防止过拟合的技术,通过向损失函数添加惩罚项来限制模型的复杂度。常用的正则化方法包括:

- **L1 正则化:** `L1(w) = ∑|w|`

- **L2 正则化:** `L2(w) = ∑w^2`

**过拟合处理**

过拟合是指模型在训练集上表现良好,但在新数据上表现不佳。处理过拟合的方法包括:

- **数据增强:**通过旋转、裁剪、翻转等操作增加训练数据集的大小。

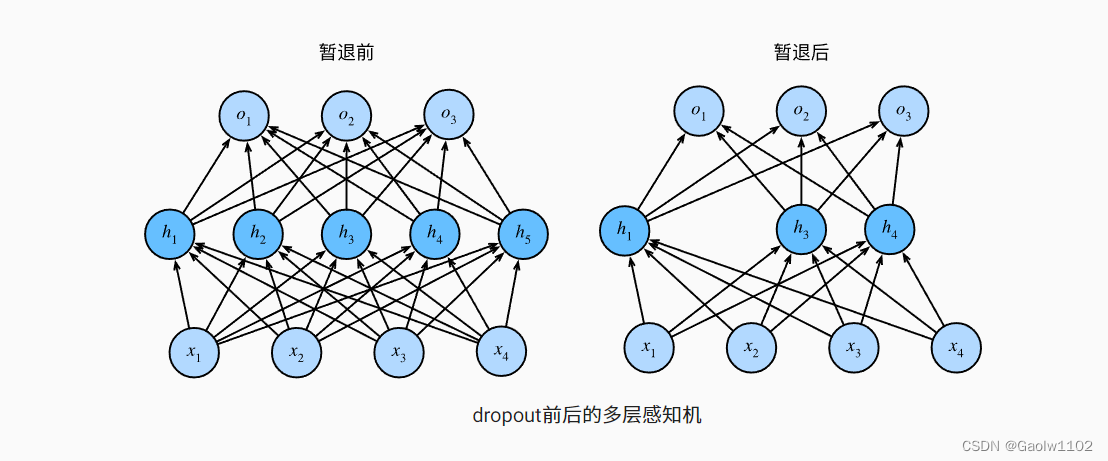

- **Dropout:**在训练过程中随机丢弃神经元,防止模型过分依赖特定特征。

- **提前停止:**当模型在验证集上的性能不再提高时停止训练。

### 4.2 应用场景与扩展

#### 4.2.1 目标检测与分割

MLP可以用于目标检测和分割任务。目标检测是指识别图像中的目标并定位其边界框。目标分割是指将图像中的目标从背景中分离出来。

#### 4.2.2 人脸识别与表情分析

MLP可以用于人脸识别和表情分析任务。人脸识别是指识别图像中的人脸并确定其身份。表情分析是指识别图像中人物的表情。

**代码示例:**

```python

import tensorflow as tf

# 构建 MLP 模型

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(128, activation='relu', input_shape=(784,)),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10)

# 评估模型

model.evaluate(x_test, y_test)

```

**代码逻辑分析:**

- `model.compile()` 方法编译模型,指定优化器、损失函数和评估指标。

- `model.fit()` 方法训练模型,指定训练数据和训练轮数。

- `model.evaluate()` 方法评估模型,指定测试数据和评估指标。

**参数说明:**

- `optimizer`:优化算法,如 'adam'。

- `loss`:损失函数,如 'sparse_categorical_crossentropy'。

- `metrics`:评估指标,如 'accuracy'。

- `epochs`:训练轮数。

# 5. MLP图像识别案例

### 5.1 手写数字识别

#### 5.1.1 数据集介绍与加载

手写数字识别是图像识别领域的一个经典任务。我们将使用 MNIST 数据集,这是一个包含 70,000 张手写数字图像的广泛使用的数据集。该数据集分为训练集和测试集,分别包含 60,000 张和 10,000 张图像。

**代码块:加载 MNIST 数据集**

```python

import tensorflow as tf

# 加载 MNIST 数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.mnist.load_data()

# 归一化图像像素值

x_train, x_test = x_train / 255.0, x_test / 255.0

# 将标签转换为 one-hot 编码

y_train = tf.keras.utils.to_categorical(y_train, 10)

y_test = tf.keras.utils.to_categorical(y_test, 10)

```

#### 5.1.2 模型构建与训练

我们将使用一个简单的 MLP 模型来执行手写数字识别任务。该模型将包含一个输入层、一个隐藏层和一个输出层。

**代码块:构建 MLP 模型**

```python

# 构建 MLP 模型

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

```

**代码块:编译和训练模型**

```python

# 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10)

```

#### 5.1.3 模型评估与结果分析

在训练模型后,我们将使用测试集评估其性能。

**代码块:评估模型**

```python

# 评估模型

loss, accuracy = model.evaluate(x_test, y_test)

# 打印评估结果

print('Test loss:', loss)

print('Test accuracy:', accuracy)

```

### 5.2 图像分类

#### 5.2.1 数据集介绍与加载

我们将使用 CIFAR-10 数据集,这是一个包含 60,000 张 32x32 彩色图像的图像分类数据集。该数据集分为训练集和测试集,分别包含 50,000 张和 10,000 张图像。

**代码块:加载 CIFAR-10 数据集**

```python

import tensorflow as tf

# 加载 CIFAR-10 数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.cifar10.load_data()

# 归一化图像像素值

x_train, x_test = x_train / 255.0, x_test / 255.0

# 将标签转换为 one-hot 编码

y_train = tf.keras.utils.to_categorical(y_train, 10)

y_test = tf.keras.utils.to_categorical(y_test, 10)

```

#### 5.2.2 模型构建与训练

我们将使用一个更复杂的 MLP 模型来执行图像分类任务。该模型将包含多个隐藏层和一个输出层。

**代码块:构建 MLP 模型**

```python

# 构建 MLP 模型

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(32, 32, 3)),

tf.keras.layers.Dense(512, activation='relu'),

tf.keras.layers.Dense(256, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

```

**代码块:编译和训练模型**

```python

# 编译模型

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10)

```

#### 5.2.3 模型评估与结果分析

在训练模型后,我们将使用测试集评估其性能。

**代码块:评估模型**

```python

# 评估模型

loss, accuracy = model.evaluate(x_test, y_test)

# 打印评估结果

print('Test loss:', loss)

print('Test accuracy:', accuracy)

```

# 6. MLP图像识别未来发展

### 6.1 深度学习与迁移学习

近年来,深度学习在图像识别领域取得了巨大的成功。深度学习模型,如卷积神经网络(CNN),能够自动学习图像中的复杂特征,从而实现更高的识别精度。

迁移学习是一种将预先训练好的模型应用于新任务的技术。通过迁移学习,我们可以利用预先训练好的模型中提取的特征,来训练新的MLP模型,从而提高模型的性能和训练效率。

### 6.2 计算机视觉与人工智能

图像识别是计算机视觉领域的重要分支。计算机视觉旨在让计算机理解和解释图像中的信息。随着人工智能(AI)技术的不断发展,图像识别技术也在不断进步。

AI技术可以赋予计算机识别和理解图像中复杂语义信息的能力。例如,AI驱动的图像识别系统可以识别图像中的对象、场景、情绪和动作。这些能力对于自动驾驶、人脸识别和医疗诊断等应用至关重要。

### 代码示例

以下代码展示了如何使用迁移学习来训练MLP图像识别模型:

```python

import tensorflow as tf

# 加载预先训练好的VGG16模型

vgg16 = tf.keras.applications.VGG16(include_top=False, weights='imagenet')

# 冻结VGG16模型的权重

vgg16.trainable = False

# 创建MLP模型

mlp = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(224, 224, 3)),

tf.keras.layers.Dense(512, activation='relu'),

tf.keras.layers.Dense(256, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 构建迁移学习模型

transfer_model = tf.keras.Sequential([

vgg16,

mlp

])

# 编译模型

transfer_model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

transfer_model.fit(train_data, train_labels, epochs=10)

```

### 总结

MLP图像识别技术在不断发展,深度学习、迁移学习和AI技术的应用将进一步推动其发展。未来,图像识别技术将继续在各个领域发挥重要作用,为人类生活带来更多便利和可能性。

0

0