迁移学习与多层感知器(MLP):预训练模型赋能,快速构建高性能模型,节省时间和资源

发布时间: 2024-07-14 12:37:26 阅读量: 91 订阅数: 225

# 1. 迁移学习与多层感知器的简介**

迁移学习是一种机器学习技术,它允许将知识从一个任务转移到另一个相关但不同的任务。它通过利用预先训练的模型来加速新任务的学习过程,从而节省时间和资源。

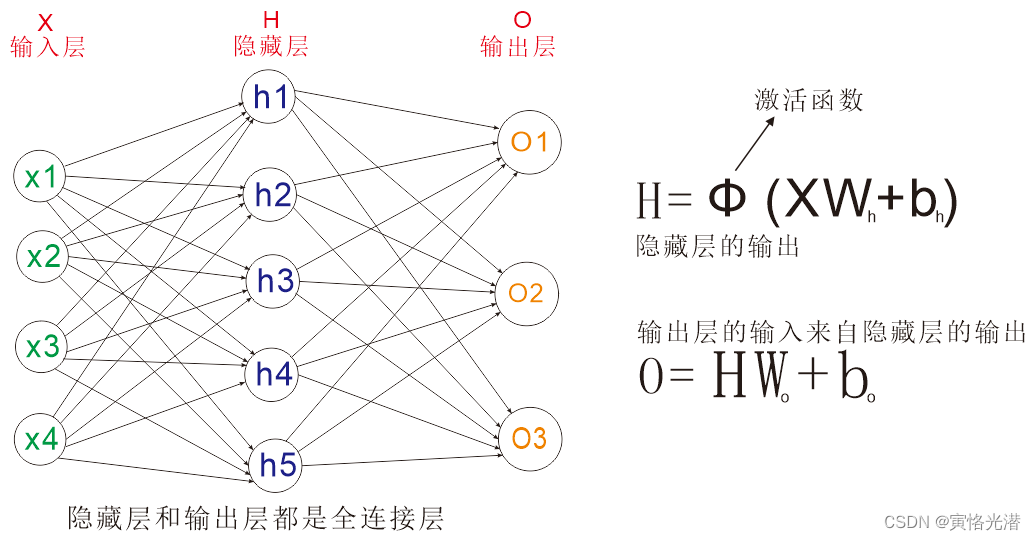

多层感知器 (MLP) 是一种前馈神经网络,具有多个隐藏层。它通常用于解决分类、回归和预测等各种机器学习任务。MLP 的结构包括输入层、多个隐藏层和输出层,每个层都由神经元组成,这些神经元通过权重和偏置连接。

# 2. 迁移学习在多层感知器中的应用

### 2.1 迁移学习的原理和优势

#### 2.1.1 知识迁移的机制

迁移学习的核心思想是将已在某个任务上训练好的模型(源模型)的参数或知识迁移到另一个相关但不同的任务(目标任务)中。这种知识迁移可以通过以下机制实现:

* **参数共享:**源模型和目标模型共享部分参数,这些参数包含了源任务中学习到的通用知识。

* **特征提取:**源模型的中间层可以提取出源任务中具有代表性的特征,这些特征也可以用于目标任务。

* **正则化:**源模型的知识可以作为正则化项,防止目标模型过拟合。

#### 2.1.2 迁移学习的适用场景

迁移学习在以下场景中特别适用:

* **目标任务数据较少:**当目标任务的数据量不足以训练一个从头开始的模型时,迁移学习可以利用源模型的知识来弥补数据不足的问题。

* **源任务和目标任务相关:**源任务和目标任务之间存在一定的相关性,这样源模型中学习到的知识才能有效地迁移到目标任务中。

* **源模型性能较好:**源模型在源任务上具有较好的性能,这样才能保证迁移后的知识对目标任务有帮助。

### 2.2 多层感知器的结构和工作原理

#### 2.2.1 MLP的层级结构

多层感知器(MLP)是一种前馈神经网络,由多个全连接层堆叠而成。每个全连接层包含多个神经元,每个神经元与上一层的所有神经元相连。

#### 2.2.2 MLP的前向和反向传播

**前向传播:**

输入数据通过输入层进入网络,依次经过各层神经元的计算,最终输出预测结果。每个神经元的计算公式为:

```python

y = f(Wx + b)

```

其中:

* `y` 是神经元的输出值

* `W` 是权重矩阵

* `x` 是输入向量

* `b` 是偏置向量

* `f` 是激活函数

**反向传播:**

当预测结果与真实值存在误差时,需要计算误差并反向传播到各层神经元,更新权重和偏置值,以减小误差。反向传播的公式为:

```python

dW = (y - t) * f'(Wx + b) * x

db = (y - t) * f'(Wx + b)

```

其中:

* `dW` 是权重矩阵的梯度

* `db` 是偏置向量的梯度

* `y` 是神经元的输出值

* `t` 是真实值

* `f` 是激活函数

### 2.3 迁移学习在MLP中的具体实现

#### 2.3.1 预训练模型的选择

选择合适的预训练模型是迁移学习的关键。预训练模型应满足以下条件:

* 与目标任务相关

* 性能较好

* 具有可移植性

#### 2.3.2 模型微调和fine-tuning

迁移学习中,通常不会直接使用预训练模型,而是需要对其进行微调。微调是指只更新部分参数,而不是全部参数。

```python

# 加载预训练模型

model = tf.keras.models.load_model('pre_trained_model.h5')

# 冻结预训练模型的部分层

for layer in model.layers[:10]:

layer.trainable = False

# 添加新的层并微调模型

model.add(tf.keras.layers.Dense(128, activation='relu'))

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

# 编译和训练模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10)

```

通过微调,可以使预训练模型的参数更适应目标任务,从而提高模型的性能。

# 3.1 图像分类中的迁移学习

#### 3.1.1 常见的图像分类数据集

在图像分类任务中,常用的数据集包括:

- **ImageNet:**包含超过 1400 万张图像,涵盖 1000 个类别,是图像分类领域最具挑战性的数据集之

0

0