LSTM 模型未来发展趋势与展望

发布时间: 2024-05-01 23:29:45 阅读量: 93 订阅数: 84

# 1. LSTM模型的基础与原理**

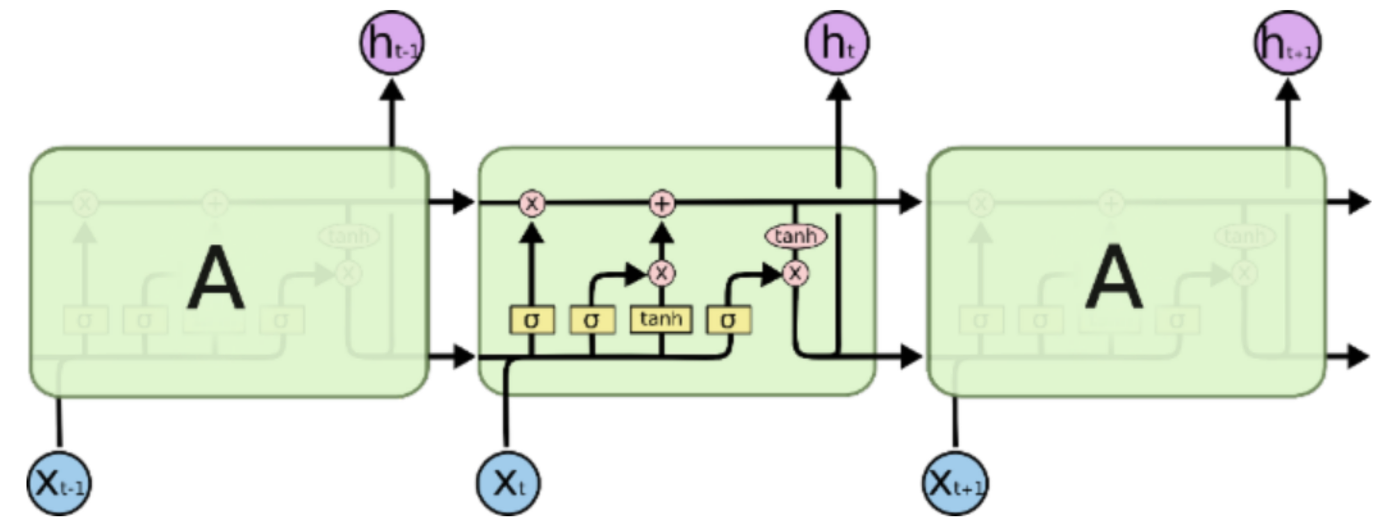

LSTM(长短期记忆网络)是一种强大的循环神经网络(RNN),专为解决长期依赖性问题而设计。它由三个门组成:输入门、遗忘门和输出门,每个门都控制着信息流。

输入门决定了哪些新信息将被添加到记忆单元中。遗忘门决定了哪些现有信息将被遗忘。输出门决定了哪些信息将从记忆单元中输出。

LSTM模型通过使用这些门来学习长期依赖性,从而克服了传统RNN模型的局限性。它可以记住相关信息,即使这些信息与当前输入相隔很远。

# 2. LSTM模型的实践应用

### 2.1 自然语言处理

#### 2.1.1 文本分类

**应用场景:**文本分类是将文本数据分为预定义类别(例如,情感分析、垃圾邮件检测)的任务。

**LSTM模型应用:**LSTM模型可以捕捉文本中的长期依赖关系,从而有效地进行文本分类。

**具体步骤:**

1. **数据预处理:**将文本数据转换为数字表示(例如,单词嵌入)。

2. **模型构建:**构建一个LSTM模型,其中输入层接收文本表示,输出层输出类别概率。

3. **模型训练:**使用分类损失函数(例如,交叉熵)训练LSTM模型。

4. **模型评估:**使用准确率、召回率和F1分数等指标评估模型性能。

#### 2.1.2 机器翻译

**应用场景:**机器翻译是将一种语言的文本翻译成另一种语言的任务。

**LSTM模型应用:**LSTM模型可以处理序列数据,因此非常适合机器翻译任务。

**具体步骤:**

1. **数据预处理:**将源语言和目标语言的文本数据并行对齐。

2. **模型构建:**构建一个编码器-解码器模型,其中编码器使用LSTM将源语言文本编码为固定长度的向量,解码器使用LSTM将编码向量解码为目标语言文本。

3. **模型训练:**使用序列到序列损失函数(例如,交叉熵)训练编码器-解码器模型。

4. **模型评估:**使用BLEU分数、ROUGE分数和人类评估等指标评估模型性能。

### 2.2 时序预测

#### 2.2.1 股票价格预测

**应用场景:**股票价格预测是预测未来股票价格的任务。

**LSTM模型应用:**LSTM模型可以捕捉时序数据中的趋势和模式,从而有效地进行股票价格预测。

**具体步骤:**

1. **数据预处理:**收集历史股票价格数据(例如,开盘价、收盘价、成交量)。

2. **模型构建:**构建一个LSTM模型,其中输入层接收历史股票价格数据,输出层输出预测的未来股票价格。

3. **模型训练:**使用均方误差损失函数(MSE)训练LSTM模型。

4. **模型评估:**使用均方根误差(RMSE)和平均绝对误差(MAE)等指标评估模型性能。

#### 2.2.2 异常检测

**应用场景:**异常检测是识别时序数据中与正常模式不同的异常事件的任务。

**LSTM模型应用:**LSTM模型可以学习时序数据的正常模式,并检测与这些模式不同的异常事件。

**具体步骤:**

1. **数据预处理:**收集时序数据(例如,传感器数据、网络流量)。

2. **模型构建:**构建一个LSTM模型,其中输入层接收时序数据,输出层输出异常概率。

3. **模型训练:**使用二元交叉熵损失函数训练LSTM模型。

4. **模型评估:**使用准确率、召回率和F1分数等指标评估模型性能。

# 3.1 参数优化

#### 3.1.1 超参数调优

超参数调优是指调整模型中未通过训练学习的参数,以优化模型的性能。对于 LSTM 模型,常用的超参数包括:

- **学习率:**控制模型更新权重的步长。较高的学习率可能导致模型不稳定,而较低的学习率可能导致收敛速度慢。

- **批次大小:**每次训练迭代中使用的样本数量。较大的批次大小可以提高计算效率,但可能导致模型过拟合。

- **隐藏层单元数:**LSTM 单元中隐藏状态的维度。较多的单元数可以提高模型的表达能力,但也会增加训练时间和计算成本。

- **层数:**LSTM 模型中 LSTM 层的数量。更多的层可以提取更深层次的特征,但也会增加模型的复杂性和训练时间。

- **正则化参数:**用于防止模型过拟合的参数,例如 L1 正则化和 L2 正则化。

超参数调优可以通过网格搜索、随机搜索或贝叶斯优化等方法进行。

#### 3.1.2 正则化技术

正则化技术通过惩罚模型的复杂性来防止过拟合。对于 LSTM 模型,常用的正则化技术包括:

- **L1 正则化:**对模型权重的绝对值求和,惩罚稀疏权重。

- **L2 正则化:**对模型权重的平方和求和,惩罚大的权重。

- **Dropout:**在训练过程中随机丢弃一些神经元,迫使模型学习更鲁棒的特征。

- **数据增强:**通过添加噪声、旋转或翻转等变换来增加训练数据的多样性,防止模型对特定数据分布过拟合。

正则化技术可以通过在损失函数中添加正则化项来实现。例如,对于 L2 正则化,损失函数可以表示为:

```python

loss = original_loss + lambda * tf.

```

0

0