LSTM 模型在时间序列预测中的滞后效应问题探讨

发布时间: 2024-05-01 23:13:46 阅读量: 208 订阅数: 84

# 1. 时间序列预测简介**

时间序列预测是指利用过去一段时间的数据来预测未来某个时间点的数据值。它广泛应用于金融、经济、气象、交通等领域。时间序列数据通常具有以下特征:

* **时序性:**数据点按时间顺序排列,相邻时间点的数据之间存在相关性。

* **趋势性:**数据值随着时间推移可能呈现出上升或下降的趋势。

* **季节性:**数据值在一年或一天中可能存在周期性的变化。

# 2. LSTM 模型的原理与应用**

**2.1 LSTM 模型的结构和原理**

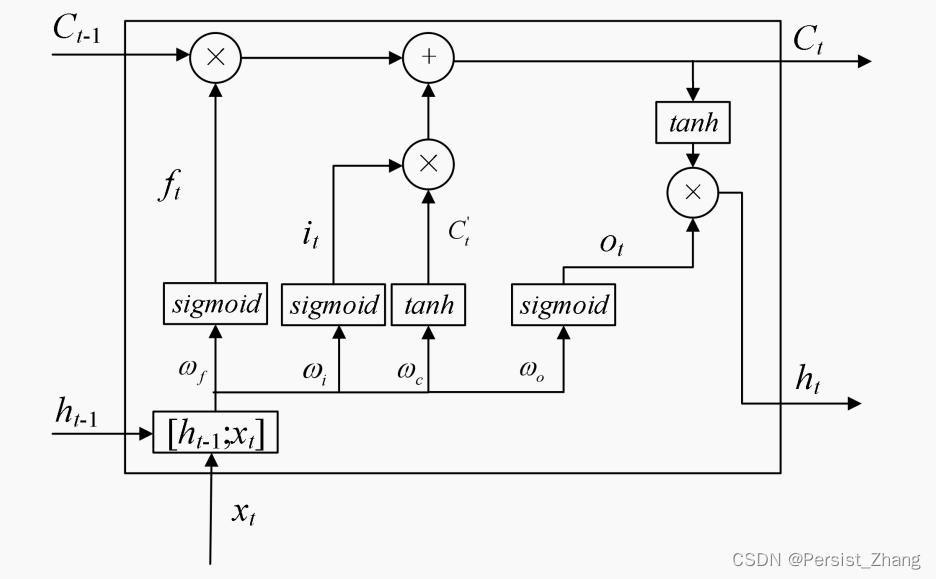

**2.1.1 LSTM 单元的组成和工作原理**

LSTM(Long Short-Term Memory)模型是一种循环神经网络(RNN),专门设计用于处理序列数据,具有长期记忆能力。LSTM 单元是 LSTM 模型的基本组成部分,它由一个记忆单元和三个门组成:输入门、遗忘门和输出门。

- **记忆单元**:存储长期信息,在时间步之间传递。

- **输入门**:控制新信息的流入,决定哪些信息将被添加到记忆单元中。

- **遗忘门**:控制旧信息的遗忘,决定哪些信息将从记忆单元中删除。

- **输出门**:控制记忆单元中信息的输出,决定哪些信息将作为当前时间步的输出。

LSTM 单元的运作过程如下:

1. **计算输入门**:`it = σ(Wi * xt + hi-1 * Ui + bi)`

2. **计算遗忘门**:`ft = σ(Wf * xt + hi-1 * Uf + bf)`

3. **更新记忆单元**:`ct = ft * ct-1 + it * tanh(Wc * xt + hi-1 * Uc + bc)`

4. **计算输出门**:`ot = σ(Wo * xt + hi-1 * Uo + bo)`

5. **计算输出**:`ht = ot * tanh(ct)`

其中,`xt` 为当前时间步的输入,`hi-1` 为前一时间步的隐藏状态,`σ` 为 sigmoid 函数,`tanh` 为 tanh 函数,`W`、`U` 和 `b` 为权重和偏置参数。

**2.1.2 LSTM 模型的训练和优化**

LSTM 模型的训练通常采用反向传播算法,通过最小化损失函数来更新模型参数。常用的损失函数包括均方误差(MSE)和交叉熵损失。

LSTM 模型的优化策略包括:

- **梯度裁剪**:防止梯度爆炸或消失,保持模型的稳定性。

- **学习率衰减**:随着训练的进行,逐渐减小学习率,提高模型的收敛性。

- **正则化**:防止模型过拟合,提高泛化能力,常用的正则化方法包括 L1 正则化和 L2 正则化。

**2.2 LSTM 模型在时间序列预测中的优势**

LSTM 模型在时间序列预测中具有以下优势:

- **长期记忆能力**:LSTM 单元的记忆单元可以存储长期信息,解决传统 RNN 模型容易遗忘长期依赖关系的问题。

- **梯度消失和爆炸问题缓解**:LSTM 单元的门结构可以缓解梯度消失和爆炸问题,使模型能够学习更深层次的时间依赖关系。

- **鲁棒性**:LSTM 模型对噪声和异常值具有较强的鲁棒性,能够从不规则的时间序列数据中提取有意义的模式。

**代码块:**

```python

import tensorflow as tf

# 定义 LSTM 单元

lstm_cell = tf.keras.laye

```

0

0