【PPO算法超参数调优秘籍:经验与教训大公开】

发布时间: 2024-08-22 01:22:08 阅读量: 51 订阅数: 31

基于PPO算法的智能汽车端到端深度强化学习控制研究

# 1. PPO算法简介**

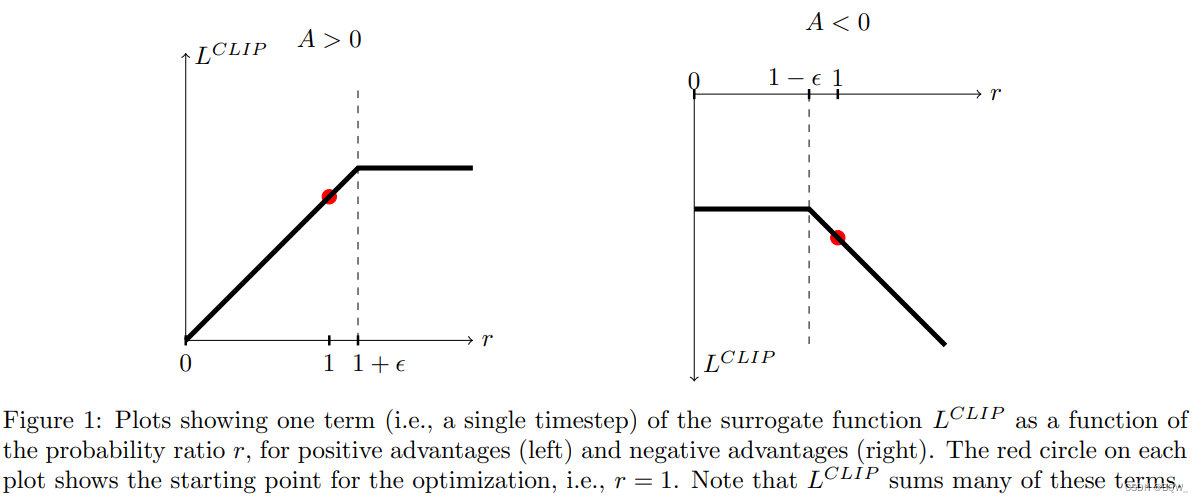

PPO(Proximal Policy Optimization)算法是一种基于策略梯度的强化学习算法,它通过优化策略函数来最大化奖励。与传统的策略梯度算法相比,PPO算法通过引入近端策略优化(PPO)更新规则,有效地解决了策略更新过程中的不稳定性问题。

PPO算法的核心思想是:在策略更新过程中,限制策略更新的步长,使其始终保持在策略分布的近端区域内。通过这种方式,PPO算法可以避免策略更新过大,导致性能下降的情况。此外,PPO算法还引入了价值函数,用于估计状态的价值,从而进一步提升了算法的稳定性和收敛速度。

# 2. PPO算法超参数调优理论

### 2.1 PPO算法的超参数

PPO算法的超参数主要分为三类:策略学习率、价值函数学习率和梯度裁剪。

**2.1.1 策略学习率**

策略学习率控制着策略网络更新的步长。较高的学习率可能导致策略更新过快,从而导致不稳定训练。较低的学习率可能导致策略更新过慢,从而降低训练效率。

**2.1.2 价值函数学习率**

价值函数学习率控制着价值网络更新的步长。与策略学习率类似,较高的学习率可能导致价值函数更新过快,从而导致不稳定训练。较低的学习率可能导致价值函数更新过慢,从而降低训练效率。

**2.1.3 梯度裁剪**

梯度裁剪是一种正则化技术,用于防止梯度爆炸。当梯度过大时,梯度裁剪会将其限制在一定范围内。这有助于稳定训练过程,防止模型发散。

### 2.2 超参数调优策略

超参数调优策略用于确定PPO算法超参数的最佳值。常见的超参数调优策略包括:

**2.2.1 网格搜索**

网格搜索是一种穷举法,它遍历超参数空间中预定义的网格。这种方法简单易用,但计算成本高,尤其是在超参数空间较大时。

**2.2.2 贝叶斯优化**

贝叶斯优化是一种基于贝叶斯定理的优化算法。它通过构建超参数空间的概率模型,并使用该模型指导超参数搜索,来有效地探索超参数空间。与网格搜索相比,贝叶斯优化计算成本更低,但需要更多的先验知识。

**2.2.3 强化学习**

强化学习是一种基于试错的优化算法。它使用代理来与超参数空间交互,并根据代理的奖励来调整超参数。强化学习可以有效地探索超参数空间,但需要大量的计算资源。

### 代码示例

以下Python代码示例演示了如何使用网格搜索来调优PPO算法的超参数:

```python

import numpy as np

from stable_baselines3 import PPO

# Define the hyperparameter space

hyperparameter_space = {

"learning_rate": np.logspace(-4, -2, 10),

"n_steps": [128, 256, 512],

"batch_size": [32, 64, 128],

"gamma": [0.9, 0.95, 0.99],

"gae_lambda": [0.9, 0.95, 0.99]

}

# Create the PPO model

model = PPO("MlpPolicy", "CartPole-v1")

# Perform grid search

best_hyperparams, best_score = model.tune_hyperparameters(

hyperparameter_space,

n_trials=10,

n_jobs=4,

verbose=1

)

# Print the best hyperparameters

print("Best hyperparameters:", best_hyperparams)

print("Best score:", best_score)

```

### 逻辑分析

该代码示例使用网格搜索来调优PPO算法的超参数。它首先定义超参数空间,然后使用`tune_hyperparameters`方法执行网格搜索。该方法将遍历超参数空间中的所有组合,并根据提供的评估指标(在本例中为平均奖励)选择最佳超参数。

### 参数说明

* `hyperparameter_space`:超参数空间,其中包含要调优的超参数及其值范围。

* `n_trials`:要执行的网格搜索试验次数。

* `n_jobs`:要使用的并行作业数。

* `verbose`:控制输出的详细程度。

# 3. PPO算法超参数调优实践

### 3.1 调优环境配置

#### 3.1.1 硬件和软件要求

**硬件要求:**

- GPU:推荐使用 NVIDIA GeForce RTX 2080 Ti 或更高版本

- CPU:推荐使用 Intel Core i7-8700K 或更高版本

- 内存:16GB 或更多

**软件要求:**

- 操作系统:Ubuntu 18.04 或更高版本

- Python:3.6 或更高版本

- PyTorch:1.5 或更高版本

- Gym:0.15 或更高版本

- Ray:1.0 或更高版本

#### 3.1.

0

0