PPO算法在强化学习中的工程实践:部署与优化

发布时间: 2024-08-22 01:29:07 阅读量: 32 订阅数: 22

# 1. 强化学习与PPO算法**

**1.1 强化学习概述**

强化学习是一种机器学习范式,它使代理能够通过与环境交互并获得奖励或惩罚来学习最佳行为。它涉及三个关键元素:代理、环境和奖励函数。代理根据其当前状态采取行动,环境根据该行动做出反应并提供奖励或惩罚,奖励函数衡量代理的行动的优劣。

**1.2 PPO算法原理**

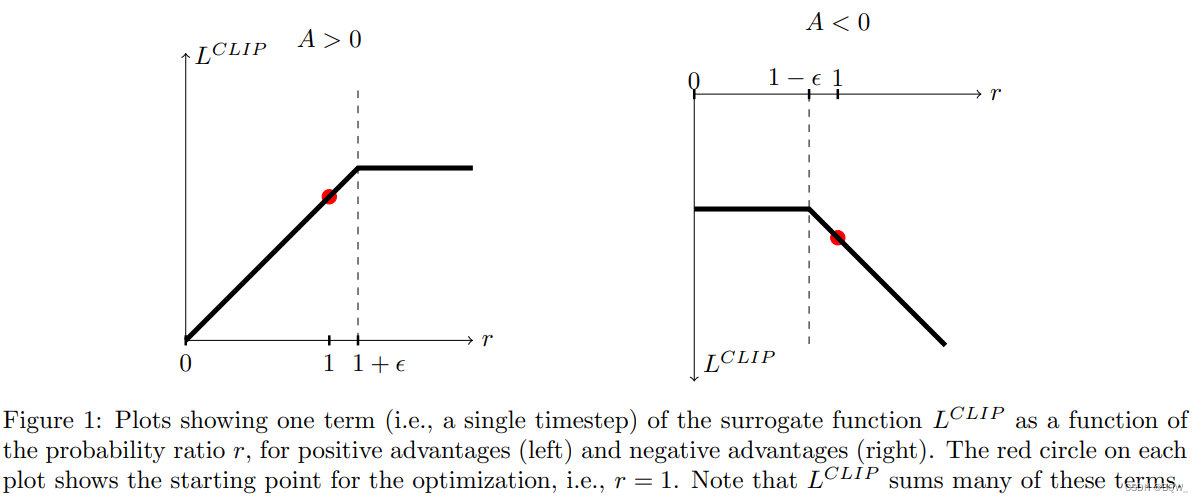

近端策略优化(PPO)算法是一种策略梯度算法,用于解决强化学习问题。它通过更新策略参数来优化策略,同时保持其与原始策略的相似性。PPO算法使用了一种称为剪辑的方法,该方法限制了策略更新的幅度,从而提高了算法的稳定性。

# 2. PPO算法工程实践

### 2.1 PPO算法部署环境搭建

#### 2.1.1 环境准备

PPO算法的部署环境搭建需要以下准备:

- **操作系统:** Linux或macOS

- **Python环境:** Python 3.6或更高版本

- **深度学习框架:** TensorFlow或PyTorch

- **强化学习库:** RLlib、Stable-Baselines3或其他支持PPO算法的库

#### 2.1.2 安装依赖项

使用以下命令安装必要的依赖项:

```

pip install tensorflow # 或 pip install pytorch

pip install rllib # 或 pip install stable-baselines3

```

#### 2.1.3 创建环境

创建一个用于训练PPO算法的环境。可以使用OpenAI Gym或自定义环境。

```python

import gym

# 创建一个CartPole环境

env = gym.make('CartPole-v1')

```

### 2.2 PPO算法超参数调优

#### 2.2.1 超参数选择

PPO算法的超参数包括:

- **学习率:** 控制模型更新速度

- **折扣因子:** 衡量未来奖励的权重

- **步长:** 每次更新模型时收集的经验数量

- **熵系数:** 鼓励模型探索

#### 2.2.2 超参数调优方法

超参数调优可以通过以下方法进行:

- **手动调优:** 手动调整超参数并观察模型性能

- **网格搜索:** 在超参数空间中系统地搜索最佳超参数

- **贝叶斯优化:** 使用贝叶斯优化算法高效地探索超参数空间

### 2.3 PPO算法性能评估

#### 2.3.1 评估指标

PPO算法的性能可以通过以下指标评估:

- **平均奖励:** 模型在环境中获得的平均奖励

- **成功率:** 模型成功完成任务的百分比

- **训练时间:** 模型训练所需的时间

#### 2.3.2 评估方法

可以使用以下方法评估PPO算法的性能:

- **训练集评估:** 在训练集上评估模型性能

- **测试集评估:** 在测试集上评估模型性能

- **在线评估:** 在实际环境中评估模型性能

# 3. PPO算法并行化优化

#### 并行化处理

PPO算法的并行化处理主要体现在并行采样和并行更新两个方面。

**并行采样:**

- 将环境并行化,同时运行多个环境,每个环境收集一个独立的轨迹。

- 将采样任务分配给不同的进程或线程,同时进行采样。

**并行更新:**

- 将更新任务分配给不同的进程或线程,同时更新不同的参数组。

- 使用分布式训练框架,如Horovod或PyTorch Distributed,实现并行更新。

#### 并行化优化策略

**使用多GPU:**

- 如果有可用的多GPU,可以将环境和采样任务分配到不同的GPU上。

- 使用PyTorch的DataParallel或Horovod的DistributedOptimizer进行并行更新。

**使用

0

0