【PPO算法在强化学习中的实战应用:从理论到实践】

发布时间: 2024-08-22 00:49:48 阅读量: 74 订阅数: 31

强化学习之PPO算法实战完整代码

# 1. PPO算法的理论基础

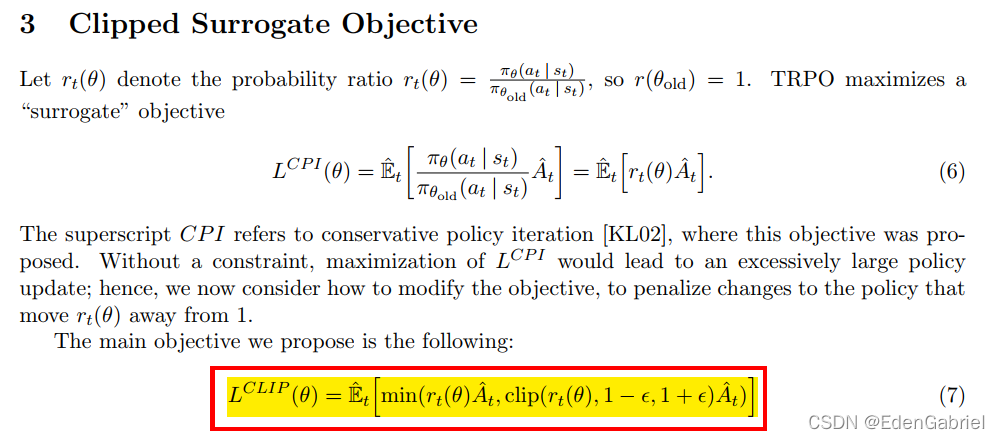

PPO(Proximal Policy Optimization)算法是一种策略梯度强化学习算法,它通过优化代理策略来最大化奖励。PPO算法的核心思想是使用代理当前策略和目标策略之间的剪辑函数来限制策略更新的幅度。这种剪辑函数有助于确保策略更新不会过于激进,从而导致不稳定的训练过程。

PPO算法的更新规则如下:

```python

new_policy = old_policy + alpha * (A * grad_log_prob)

```

其中:

* `new_policy`是更新后的策略

* `old_policy`是当前策略

* `alpha`是学习率

* `A`是优势函数

* `grad_log_prob`是策略梯度的对数概率

# 2. PPO算法的实践应用

### 2.1 PPO算法的实现步骤

#### 2.1.1 环境的建立

PPO算法的实践应用需要建立一个强化学习环境,该环境定义了代理与环境之间的交互规则。环境的建立通常涉及以下步骤:

- **定义状态空间和动作空间:**状态空间描述了代理在环境中可能遇到的所有可能状态,而动作空间描述了代理可以采取的所有可能动作。

- **定义奖励函数:**奖励函数定义了代理在采取特定动作后收到的奖励或惩罚。

- **实现环境逻辑:**环境逻辑定义了代理与环境之间的交互,包括状态转移、奖励计算和终止条件。

#### 2.1.2 模型的训练

PPO算法的训练过程包括以下步骤:

1. **收集数据:**代理在环境中采取动作并收集经验数据,包括状态、动作、奖励和下一个状态。

2. **更新策略:**使用收集的数据更新策略网络,以最大化目标函数。目标函数通常是策略梯度,它衡量策略在给定状态下采取特定动作的概率。

3. **更新价值函数:**使用收集的数据更新价值网络,以估计每个状态的价值。价值函数衡量代理从给定状态开始采取一系列动作所能获得的长期奖励。

4. **计算优势函数:**优势函数衡量每个动作相对于策略期望的价值。它用于更新策略网络。

#### 2.1.3 算法的评估

PPO算法的评估通常涉及以下步骤:

- **使用测试集:**将算法应用于一个未用于训练的测试集,以评估其泛化能力。

- **计算性能指标:**计算性能指标,如平均奖励、成功率或完成时间,以量化算法的性能。

- **分析结果:**分析评估结果,识别算法的优点和缺点,并确定改进的领域。

### 2.2 PPO算法的优化技巧

#### 2.2.1 超参数的调优

PPO算法的超参数包括学习率、折扣因子和熵正则化系数。超参数的调优至关重要,因为它可以显著影响算法的性能。超参数调优通常涉及以下步骤:

- **网格搜索:**在超参数空间中定义一个网格,并训练算法的不同超参数组合。

- **选择最佳超参数:**根据评估结果选择最优的超参数组合。

- **贝叶斯优化:**使用贝叶斯优化等高级技术优化超参数。

#### 2.2.2 策略的更新方式

PPO算法中策略的更新方式可以优化算法的性能。常见的策略更新方式包括:

- **同步更新:**在每个训练步骤后更新策略网络。

- **异步更新:**使用多个进程并行更新策略网络。

- **分层更新:**将策略网络划分为多个层,并逐层更新。

#### 2.2.3 经验回放的应用

经验回放是一种技术,它可以存储和重用训练数据。经验回放可以提高算法的性能,因为它允许算法从过去的经验中学习。经验回放通常涉及以下步骤:

- **存储经验:**将训练过程中收集的经验存储在经验回放池中。

-

0

0