PPO算法与其他策略梯度算法的对比:优缺点分析

发布时间: 2024-08-22 00:52:42 阅读量: 52 订阅数: 30

多种深度强化学习算法在雅达利游戏pong中的设计与实现

# 1. 强化学习中的策略梯度算法

策略梯度算法是强化学习中一种重要的算法,它通过直接优化策略函数来解决强化学习问题。策略梯度算法的原理是通过估计策略函数的梯度,然后利用梯度上升或梯度下降算法更新策略函数。

策略梯度算法的优点包括:

- 能够直接优化策略函数,从而提高算法的效率。

- 可以处理连续动作空间和离散动作空间的任务。

- 对于复杂的任务,策略梯度算法可以找到比值函数方法更好的策略。

# 2. PPO算法的原理和优势

### 2.1 PPO算法与其他策略梯度算法的对比

#### 2.1.1 算法原理

PPO(Proximal Policy Optimization)算法是一种策略梯度算法,它通过最大化目标策略与旧策略之间的代理损失函数来更新策略。代理损失函数旨在限制新策略与旧策略之间的差异,从而提高算法的稳定性。

具体来说,PPO算法使用以下目标函数:

```python

L_clip(\theta) = E_t[min(r_t(\theta), clip(r_t(\theta), 1 - \epsilon, 1 + \epsilon))]

```

其中:

* $\theta$:策略参数

* $r_t(\theta)$:新旧策略的优势比

* $\epsilon$:限制策略更新幅度的超参数

#### 2.1.2 算法效率

PPO算法通过使用代理损失函数来限制策略更新,从而提高了算法的稳定性。与其他策略梯度算法相比,PPO算法在保持稳定性的同时,还具有更快的训练速度。

### 2.2 PPO算法的优势

#### 2.2.1 稳定性强

PPO算法通过使用代理损失函数来限制策略更新,从而提高了算法的稳定性。与其他策略梯度算法相比,PPO算法在复杂环境中表现出更稳定的性能。

#### 2.2.2 训练速度快

PPO算法通过使用代理损失函数来限制策略更新,从而提高了算法的训练速度。与其他策略梯度算法相比,PPO算法可以在更少的训练步数内达到相同的性能水平。

### 表格:PPO算法与其他策略梯度算法的对比

| 算法 | 稳定性 | 训练速度 |

|---|---|---|

| PPO | 高 | 快 |

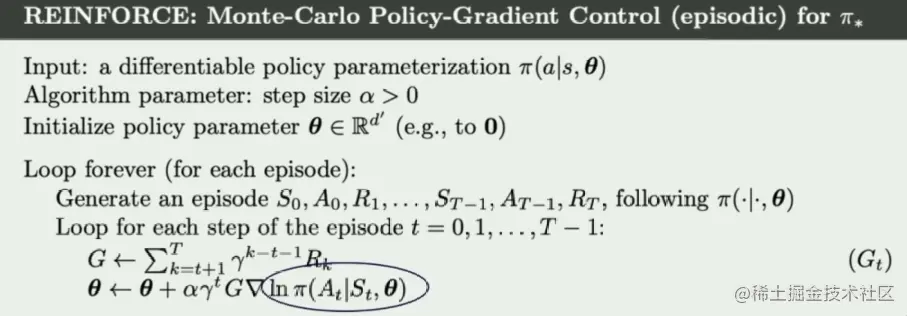

| REINFORCE | 低 | 慢 |

| A2C | 中等 | 中等 |

| TRPO | 高 | 慢 |

# 3. PPO算法的实践应用

### 3.1 PPO算法在强化学习中的应用

PPO算法在强化学习中得到了广泛的应用,尤其是在连续控制任务和离散动作空间任务中表现出色。

0

0