揭秘PPO算法:强化学习中的策略梯度算法

发布时间: 2024-08-22 00:42:31 阅读量: 34 订阅数: 22

# 1. PPO算法简介

PPO(Proximal Policy Optimization)算法是一种策略梯度方法,用于强化学习中策略的优化。它通过近似策略梯度并引入剪辑函数来稳定训练过程,从而克服了传统策略梯度方法收敛慢、不稳定的问题。PPO算法在解决复杂控制问题方面表现出色,例如机器人控制和游戏AI。

# 2. PPO算法理论基础

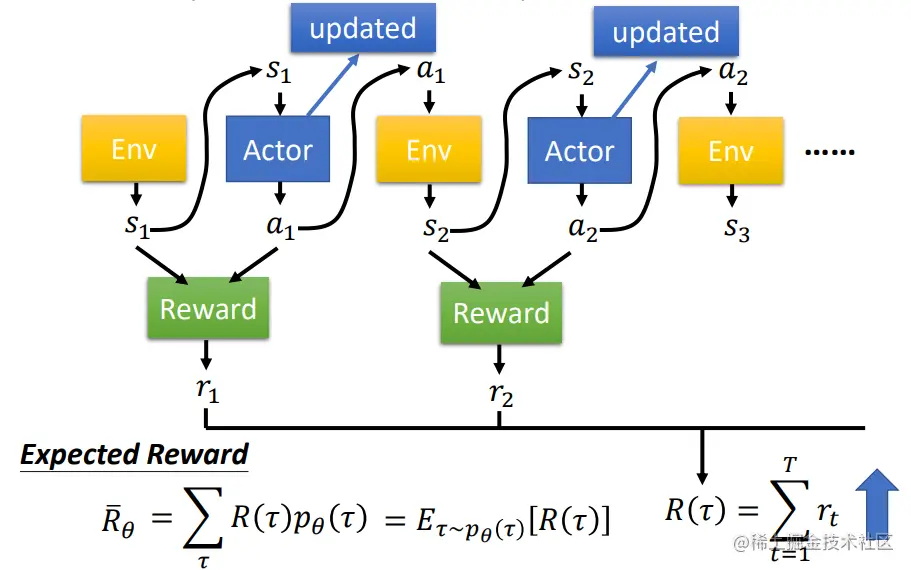

### 2.1 强化学习中的策略梯度方法

在强化学习中,策略梯度方法是一种训练策略(即行为函数)的算法。策略梯度方法利用梯度上升技术,在策略空间中搜索最优策略。

策略梯度定理给出了策略梯度的表达式:

```python

∇_θ J(θ) = E_π_θ[∇_θ log π_θ(a_t | s_t) Q_π_θ(s_t, a_t)]

```

其中:

* θ:策略参数

* J(θ):目标函数

* π_θ(a_t | s_t):在状态 s_t 下采取动作 a_t 的概率

* Q_π_θ(s_t, a_t):状态-动作对 (s_t, a_t) 的动作价值函数

策略梯度方法通过对策略梯度进行估计,更新策略参数,从而提升策略的性能。

### 2.2 PPO算法的原理和优势

PPO(Proximal Policy Optimization)算法是一种策略梯度算法,其原理如下:

* **目标函数:**PPO算法的目标函数是策略梯度定理的近似值:

```python

L(θ) = E_π_θ[min(r_t(θ), clip(r_t(θ), 1 - ε, 1 + ε)) * A_t]

```

其中:

* r_t(θ) = π_θ(a_t | s_t) / π_θ_old(a_t | s_t)

* clip(r_t(θ), 1 - ε, 1 + ε):截断函数,将 r_t(θ) 限制在 [1 - ε, 1 + ε] 范围内

* A_t:动作优势函数

* **策略更新:**PPO算法使用截断函数对策略梯度进行限制,从而避免策略更新过大,导致策略不稳定。截断函数的范围由超参数 ε 控制。

* **优势函数:**优势函数衡量了动作的价值相对于策略中其他动作的价值。PPO算法使用 GAE(Generalized Advantage Estimation)算法来估计优势函数。

PPO算法的优势包括:

* **稳定性:**截断函数限制了策略更新的幅度,提高了算法的稳定性。

* **效率:**PPO算法使用多步训练,提高了样本利用率。

* **并行化:**PPO算法可以并行化执行,提升训练速度。

# 3. PPO算法实践应用

### 3.1 PPO算法在游戏中的应用

PPO算法在游戏中得到了广泛的应用,特别是在复杂且具有挑战性的游戏中。例如,在围棋游戏中,PPO算法已被用于训练计算机程序,使其能够击败人类职业棋手。在视频游戏中,PPO算法已被用于训练人工智能代理,使其能够在各种游戏中取得超人的表现。

PPO算法在游戏中的应用主要得益于其以下优点:

- **策略梯度方法:** PPO算法是一种策略梯度方法,这意味着它直接优化策略函数,而不是价值函数。这使得PPO算法能够有效地学习复杂且非线性的策略,这些策略对于在游戏中取得成功至关重要。

- **信赖域更新:** PPO算法使用信赖域更新来更新策略函数。这有助于确保策略更新的稳定性和收敛性,即使在具有挑战性的游戏环境中也是如此。

- **剪辑损失函数:** PPO算法使用剪辑损失函数来限制策略更新的幅度。这有助于防止策略发生剧烈变化,从而提高算法的稳定性。

### 3.2 PPO算法在机器人控制中的应用

PPO算法还被广泛应用于机器人控制中。例如,PPO算法已被用于训练机器人执行复杂的运动任务,如行走、跑步和跳跃。PPO算法还被用于训练机器人执行操作任务,如抓取物体和操作工具。

PPO算法在机器人控制中的应用主要得益于其以下优点:

- **连续动作空间:** PPO算法能够处理连续动作空间,这对于机器人控制非常重要。

- **快速收敛:** PPO算法能够快速收敛到最佳策略,这对于实时机器人控制至关重要。

- **鲁棒性:** PPO算法对环境扰动具有鲁棒性,这对于在现实世界中操作机器人非常重要。

### 3.2.1 PPO算法在机器人抓取物体中的应用

下表总结了PPO算法在机器人抓取物体中的应用:

| **应用** | **优势** | **挑战** |

|---|---|---|

| **抓取未知物体** | PPO算法能够学习抓取各种形状和大小的物体,即使物体是未知的。 | PPO算法需要大量的训练数据才能学习有效的抓取策略。 |

| **抓取动态物体** | PPO算法能够学习抓取移动的物体,即使物体是不可预测的。 | PPO算法需要快速收敛才能有效地抓取动态物体。 |

| **抓取易碎物体** | PPO算法能够学习抓取易碎物体,而不损坏物体。 | PPO算法需要使用合适的损失函数来防止策略更新过度。 |

### 3.2.2 PPO算法在机器人行走中的应用

下表总结了PPO算法在机器人行走中的应用:

| **应用** | **优势** | **挑战** |

|---|---|---|

| **双足行走** | PPO算法能够学习双足机器人的稳定行走策略,即使机器人受到扰动。 | PPO算法需要大量的训练数据才能学习有效的行走策略。 |

| **四足行走** | PPO算法能够学习四足机器人的快速行走策略,即使机器人需要穿越复杂的地形。 | PPO算法需要快速收敛才能有效地控制四足机器人。 |

| **多足行走** | PPO算法能够学习多足机器人的鲁棒行走策略,即使机器人在不平坦的地形上行走。 | PPO算法需要使用合适的正则化技术来防止策略过度拟合。 |

# 4. PPO算法进阶优化

### 4.1 PPO算法的超参数调优

PPO算法的超参数对算法的性能有显著影响,因此超参数调优至关重要。常用的超参数包括:

- **步长(learning rate)**:控制策略网络更新的步幅,过大可能导致不稳定,过小可能导致收敛速度慢。

- **折扣因子(discount factor)**:控制未来奖励的权重,值越大,未来奖励的影响越大。

- **剪辑参数(clip parameter)**:限制策略网络更新的幅度,防止过度更新导致不稳定。

- **价值函数网络更新频率**:控制价值函数网络更新的频率,过高可能导致价值函数估计不准确,过低可能导致算法收敛速度慢。

- **熵正则化系数**:鼓励策略网络探索,防止过早收敛。

超参数调优可以通过网格搜索、贝叶斯优化等方法进行。具体步骤如下:

1. 选择超参数组合的范围。

2. 训练多个模型,每个模型使用不同的超参数组合。

3. 评估模型的性能(例如,奖励、收敛速度)。

4. 选择性能最佳的超参数组合。

### 4.2 PPO算法的并行化实现

PPO算法的训练过程可以并行化,以提高训练速度。并行化实现的主要方法有:

- **数据并行**:将训练数据分成多个子集,并在不同的进程或GPU上并行训练。

- **模型并行**:将策略网络或价值函数网络拆分成多个部分,并在不同的进程或GPU上并行训练。

并行化实现可以大幅提高训练速度,尤其是在处理大规模数据集或复杂模型时。

**代码块:**

```python

import torch

import torch.nn as nn

import torch.optim as optim

# 并行化策略网络

policy_net = nn.DataParallel(policy_net)

# 并行化价值函数网络

value_net = nn.DataParallel(value_net)

# 优化器

optimizer = optim.Adam(policy_net.parameters() + value_net.parameters())

# 训练循环

for epoch in range(num_epochs):

# 数据并行训练

for batch in train_loader:

optimizer.zero_grad()

policy_loss, value_loss = train_step(policy_net, value_net, batch)

loss = policy_loss + value_loss

loss.backward()

optimizer.step()

```

**逻辑分析:**

这段代码使用PyTorch实现了PPO算法的并行化训练。`policy_net`和`value_net`分别是策略网络和价值函数网络,它们被并行化处理。训练循环中,数据并行训练通过`train_loader`加载数据,并行计算策略损失和价值损失,然后进行反向传播和优化器更新。

# 5. PPO算法与其他算法的比较

### 5.1 PPO算法与传统强化学习算法的比较

PPO算法与传统强化学习算法(如Q学习、SARSA)相比,具有以下优势:

- **更稳定的收敛性:**PPO算法使用策略梯度方法,可以更稳定地收敛到最优策略。

- **更高的样本利用率:**PPO算法使用经验回放机制,可以更有效地利用样本数据。

- **更快的训练速度:**PPO算法可以并行化训练,从而加快训练速度。

### 5.2 PPO算法与其他策略梯度算法的比较

PPO算法与其他策略梯度算法(如REINFORCE、TRPO)相比,具有以下优势:

- **更稳定的训练过程:**PPO算法使用剪辑函数,可以防止策略更新幅度过大,从而提高训练稳定性。

- **更高的收敛速度:**PPO算法使用近端策略优化,可以更快速地收敛到最优策略。

- **更广泛的适用性:**PPO算法可以应用于各种强化学习任务,包括连续动作空间和离散动作空间。

| 算法 | 稳定性 | 样本利用率 | 训练速度 | 适用性 |

|---|---|---|---|---|

| PPO | 高 | 高 | 快 | 广 |

| REINFORCE | 低 | 低 | 慢 | 窄 |

| TRPO | 中 | 中 | 中 | 窄 |

0

0