堆排序算法的错误分析:揭示堆排序实现中的常见陷阱,避免算法故障

发布时间: 2024-07-21 01:50:12 阅读量: 41 订阅数: 25

# 1. 堆排序算法概述

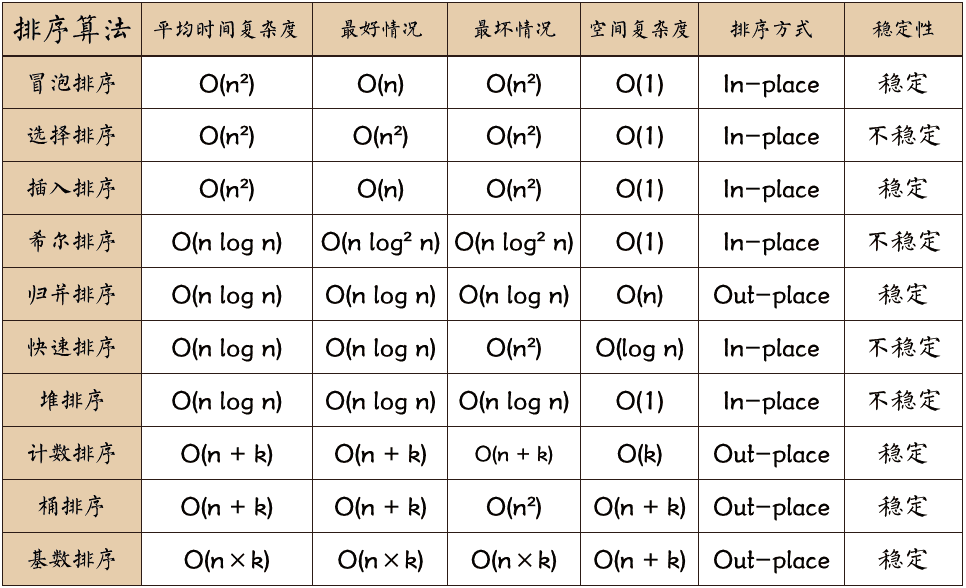

堆排序是一种基于堆数据结构的排序算法,它通过将待排序元素构建成一个最大堆或最小堆,然后通过不断调整堆顶元素来实现排序。堆排序的时间复杂度为 O(n log n),空间复杂度为 O(1),是一种高效稳定的排序算法。

# 2. 堆排序算法的理论基础

### 2.1 堆数据结构及其性质

**堆数据结构**

堆是一种完全二叉树,其中每个节点的值都大于或等于其子节点的值。

**堆的性质**

* **完全二叉树:**每个节点都有两个子节点,或者没有子节点。

* **最大堆:**每个节点的值都大于或等于其子节点的值。

* **最小堆:**每个节点的值都小于或等于其子节点的值。

### 2.2 堆排序算法的原理和步骤

**原理**

堆排序算法利用堆的数据结构,将待排序的数组构建为一个最大堆,然后依次从堆顶弹出最大元素,并重新构建堆,直到堆中只剩下一个元素。

**步骤**

1. **构建初始堆:**将待排序数组构建为一个最大堆。

2. **弹出堆顶元素:**弹出堆顶元素,即最大元素。

3. **调整堆结构:**将堆顶元素替换为堆中最后一个元素,并调整堆结构,使其仍然满足堆的性质。

4. **重复步骤 2-3:**重复步骤 2-3,直到堆中只剩下一个元素。

**代码块:**

```python

def heap_sort(arr):

# 构建初始堆

build_max_heap(arr)

for i in range(len(arr) - 1, 0, -1):

# 弹出堆顶元素

arr[i], arr[0] = arr[0], arr[i]

# 调整堆结构

max_heapify(arr, 0, i)

```

**逻辑分析:**

* `build_max_heap` 函数将数组构建为一个最大堆。

* 外层循环逐个弹出堆顶元素,并将其与堆中最后一个元素交换。

* `max_heapify` 函数调整堆结构,确保堆顶元素仍然是最大元素。

**参数说明:**

* `arr`:待排序数组。

* `i`:外层循环的索引,表示待弹出的元素在数组中的位置。

# 3.1 数组表示法和链表表示法

堆排序算法中,堆数据结构的实现方式主要有两种:数组表示法和链表表示法。

**数组表示法**

数组表示法是一种简单直接的实现方式,它将堆中的元素存储在一个连续的数组中。数组的索引与堆中的位置相对应,根节点位于数组的第一个元素,左子节点位于父节点索引的 2 倍处,右子节点位于父节点索引的 2 倍加 1 处。

```python

# 数组表示的堆

class Heap:

def __init__(self, arr):

self.arr = arr

self.size = len(arr)

# 获取左子节点的索引

def left(self, i):

return 2 * i + 1

# 获取右子节点的索引

def right(self, i):

return 2 * i + 2

# 获取父节点的索引

def parent(self, i):

return (i - 1) // 2

```

**链表表示法**

链表表示法是一种更灵活的实现方式,它将堆中的元素存储在链表中。每个节点包含一个数据元素和指向其左右子节点的指针。链表表示法可以更方便地处理堆中元素的插入和删除操作。

```python

# 链表表示的堆

class HeapNode:

def __init__(self, data):

self.data = data

self.left = None

self.right = None

class Heap:

def __init__(self):

self.root = None

# 插入元素

def insert(self, data):

new_

```

0

0