多元线性回归多重共线性诊断与处理:识别、处理和影响,提升模型稳定性

发布时间: 2024-06-09 06:16:30 阅读量: 369 订阅数: 84

多元线性回归分析

# 1. 多元线性回归概述

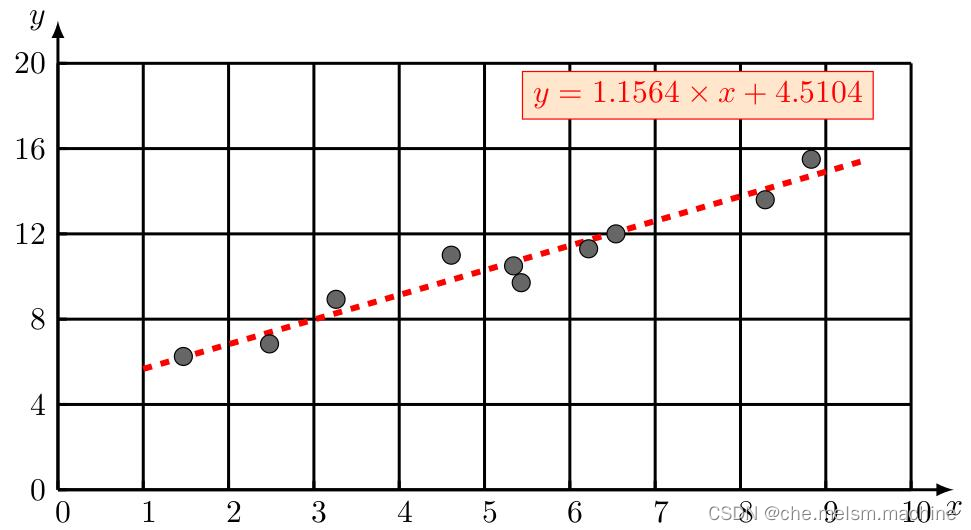

多元线性回归是一种统计模型,用于预测一个连续变量(因变量)与多个自变量(预测变量)之间的关系。它基于以下方程:

```

y = β0 + β1x1 + β2x2 + ... + βnxn + ε

```

其中:

* y 是因变量

* x1, x2, ..., xn 是自变量

* β0, β1, ..., βn 是回归系数

* ε 是误差项

多元线性回归假设自变量之间不存在多重共线性,即它们彼此不相关。当自变量之间存在多重共线性时,会对模型的稳定性和预测能力产生负面影响。

# 2. 多元线性回归中的多重共线性

### 2.1 多重共线性的概念和影响

#### 2.1.1 多重共线性的定义

多重共线性是指多元线性回归模型中两个或多个自变量之间存在高度相关性。当自变量之间存在多重共线性时,模型系数的估计将变得不稳定,预测能力也会受到影响。

#### 2.1.2 多重共线性的影响

多重共线性对多元线性回归模型的影响主要体现在以下几个方面:

- **系数估计不稳定:**当自变量之间存在多重共线性时,模型系数的估计将变得不稳定。即使是很小的数据变化,也会导致系数估计发生较大的变化。

- **预测能力下降:**多重共线性会降低模型的预测能力。这是因为当自变量之间存在高度相关性时,模型无法准确区分它们的独立影响。

- **模型解释困难:**多重共线性会使模型解释变得困难。当自变量之间存在高度相关性时,很难确定哪个自变量对因变量的影响更大。

### 2.2 多重共线性的诊断

#### 2.2.1 方差膨胀因子(VIF)

方差膨胀因子(VIF)是衡量自变量之间多重共线性的一个指标。VIF值越大,表明自变量之间的多重共线性越严重。VIF值大于 10 通常被认为是存在多重共线性的迹象。

#### 2.2.2 条件指数(CI)

条件指数(CI)是另一个衡量自变量之间多重共线性的指标。CI值越大,表明自变量之间的多重共线性越严重。CI值大于 30 通常被认为是存在多重共线性的迹象。

#### 2.2.3 特征相关矩阵

特征相关矩阵可以用来可视化自变量之间的相关性。如果相关矩阵中出现高相关性的自变量对,则表明存在多重共线性。

```

# 导入必要的库

import pandas as pd

import numpy as np

# 加载数据

data = pd.read_csv('data.csv')

# 计算特征相关矩阵

corr_matrix = data.corr()

# 可视化相关矩阵

import seaborn as sns

sns.heatmap(corr_matrix, annot=True)

plt.show()

```

**代码逻辑分析:**

1. 导入必要的库。

2. 加载数据。

3. 计算特征相关矩阵。

4. 可视化相关矩阵。

**参数说明:**

- `data.csv`:包含自变量和因变量的数据文件。

- `corr_matrix`:特征相关矩阵。

- `annot=True`:在热图中显示相关系数。

# 3. 多重共线性的处理

### 3.1 变量剔除法

#### 3.1.1 基于VIF或CI剔除变量

变量剔除法是最直接的处理多重共线性的方法。该方法通过剔除高度共线性的变量来降低模型中的多重共线性。

**步骤:**

1. 计算变量的VIF或CI值。

2. 剔除VIF或CI值大于阈值的变量。

**阈值选择:**

* VIF阈值:一般为5或10,表示变量与其他变量的共线性程度较高。

* CI阈值:一般为10或20,表示变量与其他变量的共线性程度非常高。

**代码示例:**

```python

import statsmodels.api as sm

# 计算VIF值

vif = [sm.stats.vif_lmg(X.values, i) for i in range(X.shape[1])]

# 剔除VIF值大于10的变量

X_new = X.drop(X.columns[np.array(vif) > 10], axis=1)

```

#### 3.1.2 基于相关矩阵剔除变量

基于相关矩阵剔除变量的方法通过检查变量之间的相关性来识别高度共线性的变量。

**步骤:**

1. 计算变量之间的相关矩阵。

2. 剔除相关系数大于阈值的变量对。

**阈值选择:**

* 相关系数阈值:一般为0.8或0.9,表示变量之间存在强相关性。

**代码示例:**

```python

import numpy as np

# 计算相关矩阵

corr_matrix = X.corr()

# 找出相关系数大于0.8的变量对

corr_pairs = np.where(np.abs(corr_matrix) > 0.8)

# 剔除高度共线性的变量

X_new = X.drop(X.columns[corr_pairs[0]], axis=1)

```

### 3.2 岭回归

岭回归是一种正则化回归方法,通过在损失函数中添加一个惩罚项来处理多重共线性。惩罚项的目的是减小模型系数的大小,从

0

0