【进阶】jieba库高级分词与自定义词典的结合应用

发布时间: 2024-06-25 07:54:16 阅读量: 91 订阅数: 145

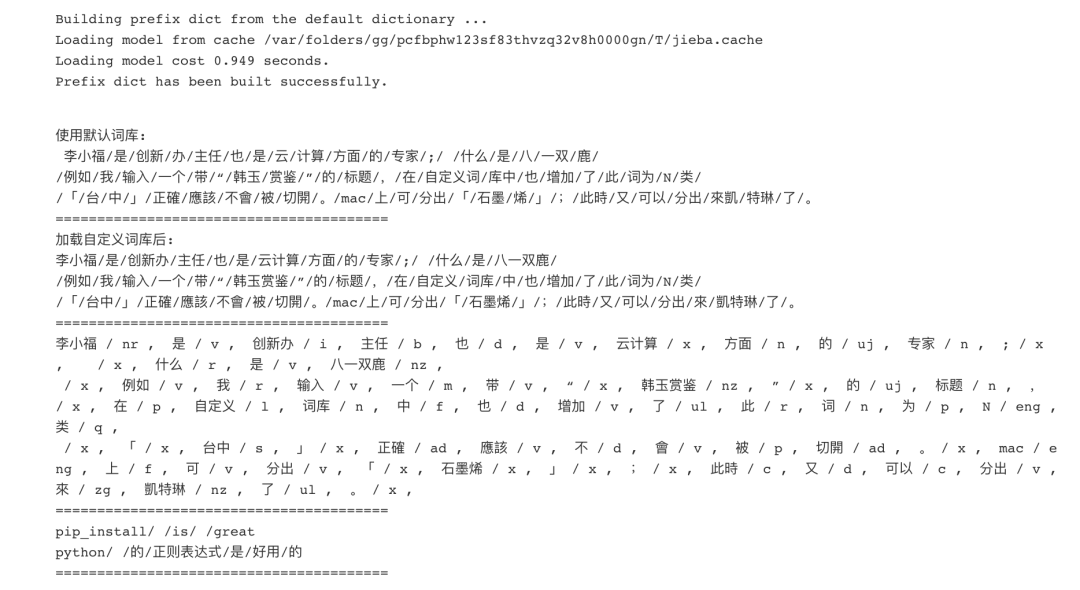

Jieba分词工具的使用

# 2.1 jieba.cut()方法的深入解析

### 2.1.1 cut()方法的基本用法

jieba.cut()方法是jieba库中进行中文分词的核心函数。其基本用法如下:

```python

import jieba

text = "自然语言处理是计算机科学领域与人工智能领域的一个交叉学科。"

result = jieba.cut(text)

```

执行上述代码后,result变量将是一个生成器对象,其中包含分词后的结果。可以通过遍历生成器对象获取分词结果:

```python

for word in result:

print(word)

```

输出结果:

```

自然

语言

处理

是

计算机

科学

领域

与

人工智能

领域

的一个

交叉

学科

。

```

### 2.1.2 cut()方法的进阶参数

cut()方法提供了丰富的参数选项,可以满足不同的分词需求。其中,常用的进阶参数包括:

- **HMM**:是否开启HMM模型。默认值为True,开启HMM模型可以提高分词准确率。

- **cut_all**:是否进行全模式分词。默认值为False,全模式分词会将文本中的所有可能分词结果都输出。

- **HMM**:是否开启HMM模型。默认值为True,开启HMM模型可以提高分词准确率。

- **cut_all**:是否进行全模式分词。默认值为False,全模式分词会将文本中的所有可能分词结果都输出。

- **use_paddle**:是否使用PaddlePaddle加速分词。默认值为False,使用PaddlePaddle可以大幅提高分词速度。

# 2. jieba库高级分词实战

### 2.1 jieba.cut()方法的深入解析

#### 2.1.1 cut()方法的基本用法

jieba.cut()方法是jieba库中用于分词的基本方法,其基本用法如下:

```python

def cut(sentence, HMM=True, cut_all=False, HMM_flag=True):

"""

Args:

sentence: 待分词的文本

HMM: 是否使用HMM模型

cut_all: 是否将文本中所有可能的切分组合都输出

HMM_flag: 是否使用HMM模型标记词性

Returns:

分词后的结果,是一个生成器对象

"""

```

**参数说明:**

* `sentence`: 待分词的文本,类型为str。

* `HMM`: 是否使用HMM模型,默认为True。HMM模型可以提高分词的准确率,但会降低分词的速度。

* `cut_all`: 是否将文本中所有可能的切分组合都输出,默认为False。如果为True,则会输出所有可能的切分结果,包括一些不合理的切分。

* `HMM_flag`: 是否使用HMM模型标记词性,默认为True。如果为True,则分词结果中每个词都会带有词性标记。

**代码逻辑:**

1. 初始化分词器,加载词典和HMM模型。

2. 将文本转换为Unicode编码。

3. 根据参数设置,进行分词。

4. 返回分词后的结果,是一个生成器对象。

**示例:**

```python

sentence = "自然语言处理"

result = jieba.cut(sentence)

print(" ".join(result))

```

输出:

```

自然 语言 处理

```

#### 2.1.2 cut()方法的进阶参数

除了基本参数外,jieba.cut()方法还提供了以下进阶参数:

* `tokenizer`: 分词器,默认为jieba.Tokenizer()。

* `user_dict`: 用户自定义词典,默认为None。

* `idf_path`: idf词频文件路径,默认为None。

* `stop_words`: 停用词列表,默认为None。

* `allow_POS`: 允许保留的词性,默认为None。

* `deny_POS`: 禁止保留的词性,默认为None。

**参数说明:**

* `tokenizer`: 分词器,可以自定义分词规则。

* `user_dict`: 用户自定义词典,可以加载用户自定义的词典。

* `idf_path`: idf词频文件路径,用于计算词语的重要性。

* `stop_words`: 停用词列表,用于过滤掉一些无意义的词语。

* `all

0

0