【进阶】GPT-3模型原理与高级应用案例解析

发布时间: 2024-06-25 07:25:43 阅读量: 103 订阅数: 145

GPT 模型背后的原理!!!

# 1. GPT-3模型的理论基础**

GPT-3(Generative Pre-trained Transformer 3)是一种由OpenAI开发的大型语言模型,它基于Transformer神经网络架构,并使用无监督学习技术在海量文本数据集上进行训练。GPT-3模型具有强大的文本生成、语言翻译、问答等能力,在自然语言处理领域取得了突破性的进展。

# 2. GPT-3 模型的编程技巧

### 2.1 GPT-3 模型的输入和输出

#### 2.1.1 文本输入和预处理

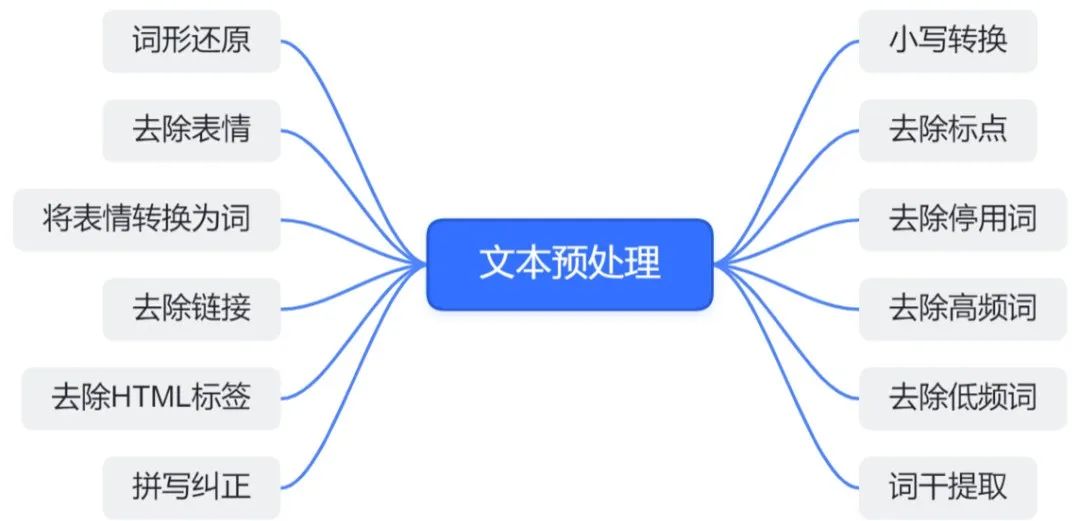

GPT-3 模型接受文本输入,因此理解输入文本的结构和内容至关重要。输入文本应清晰简洁,并遵循以下预处理步骤:

- **分词和词干化:**将句子分解为单词,并将其还原为词根。

- **去除停用词:**删除不重要的单词,如“the”、“and”、“of”。

- **词嵌入:**将单词转换为数字向量,以供模型理解。

#### 2.1.2 输出结果的解读和后处理

GPT-3 模型的输出是一个文本字符串,可以根据需要进行解读和后处理。常见的技术包括:

- **句法分析:**确定句子的结构和语法关系。

- **情感分析:**识别文本中表达的情感。

- **摘要:**生成文本的简短摘要。

### 2.2 GPT-3 模型的训练和微调

#### 2.2.1 训练数据集的准备和选择

训练 GPT-3 模型需要一个大型且高质量的文本数据集。数据集应包含与目标任务相关的文本,并应多样化以涵盖广泛的主题和风格。

#### 2.2.2 训练过程的优化和超参数调整

GPT-3 模型的训练是一个复杂的过程,涉及多个超参数的优化。常见技术包括:

- **梯度下降:**一种用于最小化损失函数的优化算法。

- **自适应学习率:**根据训练进度调整学习率。

- **正则化:**防止模型过拟合的技巧。

```python

import transformers

# 创建一个 GPT-3 模型

model = transformers.GPT2LMHeadModel.from_pretrained("gpt2")

# 准备训练数据集

train_dataset = transformers.TextDataset(

tokenizer=tokenizer,

file_path="train.txt",

block_size=128,

)

# 创建一个训练加载器

train_dataloader = transformers.DataLoader(train_dataset, batch_size=16)

# 优化器

optimizer = transformers.AdamW(model.parameters(), lr=5e-5)

# 训练模型

for epoch in range(10):

for batch in train_dataloader:

outputs = model(**batch)

loss = outputs[0]

loss.backward()

optimizer.step()

optimizer.zero_grad()

```

**代码逻辑分析:**

- `transformers.GPT2LMHeadModel.from_pretrained("gpt2")`:从预训练的 GPT-2 模型创建 GPT-3 模型。

- `transformers.TextDataset`:创建文本数据集,指定分词器、文件路径和块大小。

- `transformers.DataLoader`:创建训练加载器,指定数据集和批大小。

- `transformers.AdamW`:创建 AdamW 优化器,指定学习率。

- 训练循环:

- 对于每个 epoch 和批次:

- 计算模型输出和损失。

- 反向传播损失。

- 更新模型权重。

- 将梯度归零。

# 3. GPT-3模型的实践应用

GPT-3模型在自然语言处理领域拥有广泛的应用,其中最突出的包括文本生成和语言翻译。本章节将深入探讨GPT-3模型在这些方面的应用原理、技巧和实践。

### 3.1 GPT-3模型的文本生成

0

0