【实战演练】文本生成与对话系统实现:基于Seq2Seq、注意力机制与强化学习

发布时间: 2024-06-25 09:19:17 阅读量: 70 订阅数: 126

# 1. 文本生成与对话系统概述**

文本生成和对话系统是自然语言处理 (NLP) 领域中令人兴奋且快速发展的子领域。它们使计算机能够生成类似人类的文本并参与对话,这在各种应用中具有广泛的潜力。

文本生成系统可以创建摘要、翻译文本甚至生成创意内容。对话系统使计算机能够理解和响应人类语言,从而实现更自然和直观的交互。这些系统在客户服务、信息检索和教育等领域具有广泛的应用。

随着深度学习技术的进步,文本生成和对话系统取得了显著进展。Seq2Seq 模型、注意力机制和强化学习等技术为这些系统提供了强大的基础,使它们能够处理复杂的任务并生成高质量的输出。

# 2. Seq2Seq模型基础

### 2.1 编码器-解码器架构

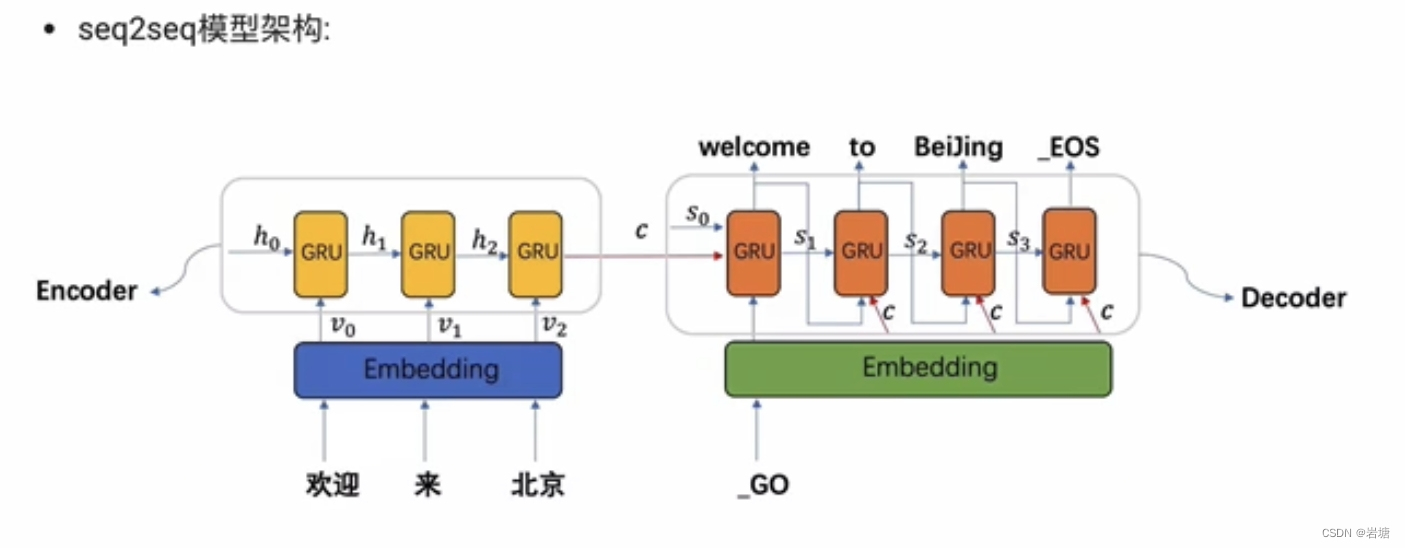

Seq2Seq模型采用编码器-解码器架构,该架构由两个神经网络组成:编码器和解码器。

**编码器**:编码器将输入序列(例如,文本句子)编码为固定长度的向量,称为上下文向量。上下文向量捕获输入序列中最重要的信息。

**解码器**:解码器使用上下文向量作为输入,生成输出序列(例如,翻译后的句子)。解码器逐个生成输出序列,每个时间步输出一个词或符号。

### 2.2 注意力机制

注意力机制是Seq2Seq模型中的一种重要机制,它允许解码器在生成输出时关注输入序列的不同部分。

#### 2.2.1 注意力机制的原理

注意力机制通过计算输入序列中每个元素与当前解码器状态之间的相似度来工作。相似度高的元素将获得更高的权重,这意味着解码器将更多地关注这些元素。

#### 2.2.2 注意力机制的应用

注意力机制在Seq2Seq模型中有多种应用,包括:

- **软对齐**:注意力机制可以学习输入和输出序列之间的对齐方式,这对于机器翻译等任务非常有用。

- **长序列建模**:注意力机制允许解码器访问输入序列的任意部分,这对于处理长序列非常重要。

- **解释性**:注意力机制可以提供对模型决策的解释,显示模型在生成输出时关注输入序列的哪些部分。

### 2.3 训练和评估

#### 2.3.1 损失函数

Seq2Seq模型通常使用交叉熵损失函数进行训练。交叉熵损失函数衡量预测输出分布与真实输出分布之间的差异。

#### 2.3.2 优化算法

用于训练Seq2Seq模型的常见优化算法包括:

- **梯度下降**:梯度下降算法通过迭代更新模型参数来最小化损失函数。

- **RMSProp**:RMSProp算法是一种自适应学习率优化算法,可以加速训练过程。

- **Adam**:Adam算法是一种结合了梯度下降和RMSProp优点的优化算法。

**代码块:**

```python

import torch

import torch.nn as nn

class Seq2Seq(nn.Module):

def __init__(self, encoder, decoder, vocab_size):

super(Seq2Seq, self).__init__()

self.enc

```

0

0