【基础】文本数据结构:Token、词袋与文档向量化

发布时间: 2024-06-25 05:44:06 阅读量: 81 订阅数: 129

# 2.1 Token与词袋模型

### 2.1.1 Token的生成和处理

文本数据结构的基础是Token,即文本中具有语义意义的最小单位。Token的生成过程通常包括分词、词性标注和归一化等步骤。

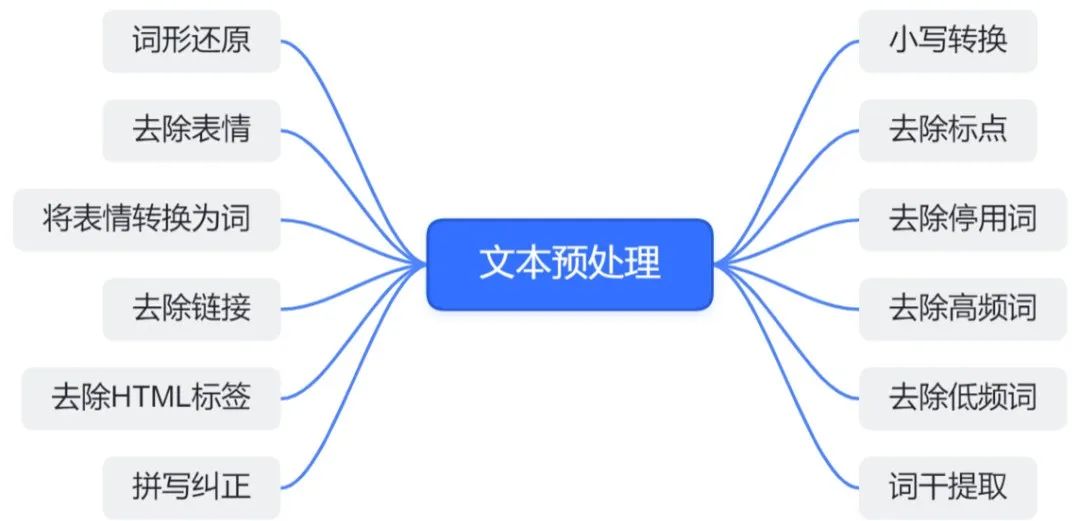

分词将文本分割成一个个独立的词语,词性标注为每个词语分配一个词性标签,归一化则将词语转换为规范形式,例如去除标点符号、转换为小写等。这些处理步骤有助于提取文本中的关键信息,为后续的分析和建模做好准备。

# 2. 文本数据结构的理论与实践

### 2.1 Token与词袋模型

#### 2.1.1 Token的生成和处理

Token是文本数据结构中最基本的单位,它表示文本中的一个单词或符号。Token的生成过程主要包括以下步骤:

- **分词:**将文本分割成一个个单词或符号。

- **归一化:**将单词或符号转换为小写、去除标点符号和特殊字符。

- **词形还原:**将单词还原为其词根形式。

#### 2.1.2 词袋模型的构建和应用

词袋模型是一种文本表示方法,它将文本表示为一个单词集合,其中每个单词的出现次数作为其权重。构建词袋模型的过程如下:

1. 生成文本的Token序列。

2. 统计每个Token的出现次数。

3. 将Token及其出现次数组成一个字典。

词袋模型广泛应用于文本分类、聚类和信息检索等任务中。

### 2.2 文档向量化

#### 2.2.1 TF-IDF算法原理

TF-IDF(Term Frequency-Inverse Document Frequency)算法是一种文本向量化方法,它考虑了单词在文档中的出现频率(TF)和在整个语料库中的出现频率(IDF)。TF-IDF算法的计算公式如下:

```python

TF-IDF(t, d, D) = TF(t, d) * IDF(t, D)

```

其中:

- `TF(t, d)`:单词`t`在文档`d`中的出现频率。

- `IDF(t, D)`:单词`t`在语料库`D`中的逆文档频率,计算公式为:`IDF(t, D) = log(N / df(t))`,其中`N`是语料库中的文档总数,`df(t)`是包含单词`t`的文档数。

#### 2.2.2 文档向量的计算和表示

基于TF-IDF算法,可以将文档表示为一个向量。文档向量的每个元素对应于语料库中的一个单词,其值表示该单词在文档中的TF-IDF权重。文档向量可以用于文本分类、相似性计算和聚类等任务。

# 3.1 文本分类

文本分类是指将文本数据分配到预定义类别中的任务。它广泛应用于垃圾邮件过滤、情感分析和主题检测等领域。文本分类算法通常基于统计学习方法,利用文本数据中的模式和特征进行分类。

### 3.1.1 朴素贝叶斯分类器

朴素贝叶斯分类器是一种简单有效的文本分类算法。它基于贝叶斯定理,假设文本中的特征相互独立。朴素贝叶斯分类器的训练过程如下:

1. **计算先验概率:**计算每个类别出现的概率。

2. **计算条件概率:**对于每个特征和每个类别,计算该特征在该类别中出现的概率。

3. **预测:**对于给定的文本,计算其属于每个类别的后验概率,并将其分配到具有最高后验概率的类别。

朴素贝叶斯分类器的优点包括:

- 训练速度快

- 对缺失数据鲁棒

- 适用于高维数据

然而,朴素贝叶斯分类器也存在一些局限性:

- 特征独立性假设可能不成立

- 对噪声数据敏感

### 3.1.2 支持向量机分类器

支持向量机(SVM)分类器是一种强大的文本分类算法,基于最大间隔原理。SVM分类器的训练过程如下:

1. **特征映射:**将文本数据映射到高维特征空间。

2. **寻找超平面:**在特征空间中找到一个超平面,将不同的类别分隔开来。

3. **选择支持向量:**选择位于超平面边缘的文本数据点作为支持向量。

4. **预测:**对于给定的文本,计算其到超平面的距离,并将其分配到距离最近的类别。

SVM分类器的优点包括:

- 非线性分类能力强

- 对噪声数据鲁棒

- 适用于高维数据

然而,SVM分类器也存在一些局限性:

- 训练速度慢

- 对参数设置敏感

- 难以解释分类结果

# 4. 文本数据结构的进阶应用

### 4.1 文本挖掘

文本挖掘是利用计算机技术从文本数据中提取有价值信息的的过程。它涉及到一系列技术,包括主题模型、情感分析和信息抽取。

#### 4.1.1 主题模型

主题模型是一种无监督学习算法,用于从文本数据中发现潜在的主题或模式。它将文档表示为主题分布,每个主题由一组相关单词组成。

**算法原理:**

主题模型使用概率生成模型,假设文档是由一组潜在主题生成的。每个主题由一组单词组成,单词在主题中出现的概率不同。文档的生成过程如下:

1. 从主题分布中随机选择一个主题。

2. 从该主题中随机选择一个单词。

3. 重复步骤 1 和 2,直到生成所需的文档长度。

**应用:**

主题模型广泛应用于文本聚类、文档分类和信息检索等领域。它可以帮助我们了解文本数据的结构和内容,并提取有价值的见解。

#### 4.1.2 情感分析

情感分析是一种自然语言处理技术,用于识别和提取文本中的情感信息。它可以确定文本的极性(正面、负面或中性),以及表达情感的强度。

**算法原理:**

情感分析算法通常使用机器学习或深度学习技术。它们将文本数据转换为特征向量,并使用分类器或回归模型对情感进行预测。

**应用:**

情感分析广泛应用于社交媒体监测、客户反馈分析和市场研究等领域。它可以帮助我们了解人们对产品、服务或事件的看法,并做出明智的决策。

### 4.2 自然语言处理

自然语言处理(NLP)是一门计算机科学领域,专注于使计算机理解和处理人类语言。它涉及到一系列技术,包括词性标注、句法分析和语义分析。

#### 4.2.1 词性标注

词性标注是一种 NLP 技术,用于识别文本中单词的词性。它将每个单词标记为名词、动词、形容词等。

**算法原理:**

词性标注算法通常使用隐马尔可夫模型(HMM)或条件随机场(CRF)。这些模型将单词序列表示为状态序列,并使用观察到的单词序列来预测每个单词的词性。

**应用:**

词性标注广泛应用于词法分析、句法分析和语义分析等领域。它可以帮助我们理解文本的结构和含义,并进行更高级的 NLP 任务。

#### 4.2.2 句法分析

句法分析是一种 NLP 技术,用于分析文本中单词之间的语法关系。它识别句子中的主语、谓语、宾语等成分,并构建句法树来表示句子的结构。

**算法原理:**

句法分析算法通常使用上下文无关文法(CFG)或转换生成文法(TGG)。这些文法定义了句子可以采取的合法结构,并使用解析器来识别句子的句法树。

**应用:**

句法分析广泛应用于机器翻译、信息抽取和问答系统等领域。它可以帮助我们理解文本的含义,并进行更复杂的任务,如文本摘要和文本生成。

# 5. 文本数据结构的优化与调优

### 5.1 文本预处理优化

#### 5.1.1 停用词处理

停用词是指在文本中出现频率较高但信息量较少的词语,如"的"、"是"、"了"等。去除停用词可以减少文本的冗余信息,提高文本处理效率。

**操作步骤:**

1. 构建停用词表:从预先定义的停用词列表或通过统计文本中出现频率较高的词语来构建停用词表。

2. 文本预处理:将文本中的词语与停用词表进行匹配,去除停用词。

**代码示例:**

```python

import nltk

# 构建停用词表

stopwords = nltk.corpus.stopwords.words('english')

# 文本预处理

text = "This is a sample text. The text contains stopwords like 'the', 'is', and 'a'."

processed_text = ' '.join([word for word in text.split() if word not in stopwords])

```

#### 5.1.2 词干提取

词干提取是指将词语还原为其基本形式,去除词语的后缀和前缀。词干提取可以减少同义词和变形的词语,提高文本处理的准确性。

**操作步骤:**

1. 选择词干提取算法:常用的词干提取算法包括 Porter 算法和 Lancaster 算法。

2. 文本预处理:将文本中的词语进行词干提取,得到词语的基本形式。

**代码示例:**

```python

from nltk.stem import PorterStemmer

# 选择词干提取算法

stemmer = PorterStemmer()

# 文本预处理

text = "This is a sample text. The text contains words like 'running', 'ran', and 'runs'."

processed_text = ' '.join([stemmer.stem(word) for word in text.split()])

```

### 5.2 模型调优与评估

#### 5.2.1 交叉验证

交叉验证是一种评估模型性能的方法,它将数据集划分为多个子集,依次使用每个子集作为测试集,其余子集作为训练集,重复多次训练和测试过程,得到模型的平均性能。

**操作步骤:**

1. 划分数据集:将数据集划分为 k 个子集。

2. 交叉验证:对于每个子集,使用该子集作为测试集,其余子集作为训练集,训练模型并计算模型性能。

3. 评估模型:计算 k 次交叉验证的平均性能,作为模型的最终性能。

**代码示例:**

```python

from sklearn.model_selection import cross_val_score

# 划分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2)

# 交叉验证

scores = cross_val_score(model, X_train, y_train, cv=5)

# 评估模型

print("平均准确率:", np.mean(scores))

```

#### 5.2.2 评价指标选择

选择合适的评价指标对于评估模型性能至关重要。不同的任务和数据集需要不同的评价指标。

**常见评价指标:**

* **分类任务:**准确率、召回率、F1 分数、ROC 曲线、AUC

* **回归任务:**均方误差、平均绝对误差、R 平方

* **聚类任务:**轮廓系数、Calinski-Harabasz 指数、Davies-Bouldin 指数

**操作步骤:**

1. 根据任务类型选择合适的评价指标。

2. 计算模型的评价指标值。

3. 分析评价指标值,评估模型性能。

**代码示例:**

```python

from sklearn.metrics import accuracy_score

# 计算准确率

accuracy = accuracy_score(y_true, y_pred)

# 分析准确率

print("准确率:", accuracy)

```

# 6.1 新兴技术与趋势

随着人工智能技术的不断发展,文本数据结构领域也涌现出了一些新兴技术和趋势,为文本数据的处理和分析带来了新的机遇和挑战。

### 6.1.1 Transformer模型

Transformer模型是一种基于注意力机制的神经网络架构,它在自然语言处理领域取得了突破性的进展。与传统的循环神经网络和卷积神经网络不同,Transformer模型能够并行处理输入序列中的所有元素,从而提高了处理效率和准确性。

在文本数据结构中,Transformer模型可以用于文本分类、文本聚类、文本生成等任务。例如,在文本分类任务中,Transformer模型可以利用其强大的注意力机制,准确地捕捉文本中的语义信息,从而提高分类的准确性。

### 6.1.2 预训练语言模型

预训练语言模型(PLM)是一种在海量文本数据集上预训练的大型神经网络模型。PLM能够学习文本的语言结构和语义信息,并将其应用到各种自然语言处理任务中。

在文本数据结构中,PLM可以用于文本分类、文本聚类、文本挖掘等任务。例如,在文本挖掘任务中,PLM可以利用其丰富的语言知识,准确地识别文本中的主题和情感,从而提高挖掘的效率和准确性。

## 6.2 应用场景与展望

文本数据结构在各行各业都有着广泛的应用场景,未来随着新兴技术的不断发展,其应用场景也将进一步拓展。

### 6.2.1 应用场景

- **文本分类:**对文本进行分类,例如新闻分类、邮件分类、垃圾邮件过滤等。

- **文本聚类:**将文本分组到不同的类别中,例如主题聚类、客户细分等。

- **文本挖掘:**从文本中提取有价值的信息,例如主题提取、情感分析、舆情分析等。

- **自然语言处理:**处理自然语言文本,例如词性标注、句法分析、机器翻译等。

### 6.2.2 展望

未来,文本数据结构将继续在以下方面发挥重要作用:

- **个性化推荐:**基于用户的历史行为和偏好,为用户推荐个性化的内容和服务。

- **智能客服:**通过自然语言处理技术,为用户提供智能化的客服服务。

- **医疗健康:**辅助医疗诊断、药物研发和疾病预防等。

- **金融科技:**风控、反欺诈、信贷评估等。

0

0